深度强化学习的挑战与机遇:探索技术发展之路,把握未来趋势

发布时间: 2024-08-21 12:34:04 阅读量: 64 订阅数: 39

# 1. 深度强化学习概述

深度强化学习是一种机器学习范式,它使代理能够通过与环境交互并从错误中学习来解决复杂决策问题。它将深度学习技术与强化学习相结合,从而能够处理高维感知输入和连续动作空间。深度强化学习算法利用神经网络来近似值函数和策略函数,从而使代理能够在不显式建模环境的情况下做出决策。

# 2. 深度强化学习的理论基础

深度强化学习的理论基础建立在马尔可夫决策过程 (MDP) 和贝尔曼方程之上,这些概念为理解强化学习算法提供了框架。

### 2.1 马尔可夫决策过程和贝尔曼方程

**马尔可夫决策过程 (MDP)** 是一个数学模型,用于描述一个代理在环境中采取行动并获得奖励的过程。MDP 由以下元素定义:

- **状态空间 (S)**:所有可能的环境状态的集合。

- **动作空间 (A)**:所有可能的代理动作的集合。

- **转移概率 (P)**:从一个状态转移到另一个状态的概率,给定一个动作。

- **奖励函数 (R)**:代理在每个状态下采取动作所获得的奖励。

**贝尔曼方程**是一组递归方程,用于计算一个状态的价值函数。价值函数表示代理在该状态采取最佳动作的长期期望奖励。

**状态价值函数 (V)**:

```

V(s) = max_a ∑_{s'} P(s' | s, a) [R(s, a, s') + γV(s')]

```

**动作价值函数 (Q)**:

```

Q(s, a) = ∑_{s'} P(s' | s, a) [R(s, a, s') + γmax_a' Q(s', a')]

```

其中:

- γ 是折扣因子,表示未来奖励的价值。

- max_a 表示在所有可能的动作中取最大值。

### 2.2 值函数和策略函数

**值函数**表示代理在给定状态下采取最佳动作的长期期望奖励。**策略函数**定义了代理在每个状态下采取的动作。

**贪婪策略**是选择具有最高价值函数的动作的策略:

```

π(s) = argmax_a Q(s, a)

```

**ε-贪婪策略**是一种探索性策略,它以一定概率 ε 随机选择动作,以 1 - ε 的概率选择贪婪动作。这有助于防止代理陷入局部最优。

### 2.3 强化学习算法

强化学习算法使用贝尔曼方程来更新值函数和策略函数。常用的算法包括:

**值迭代**:重复更新状态价值函数,直到收敛。

**策略迭代**:重复评估当前策略并更新策略,直到收敛。

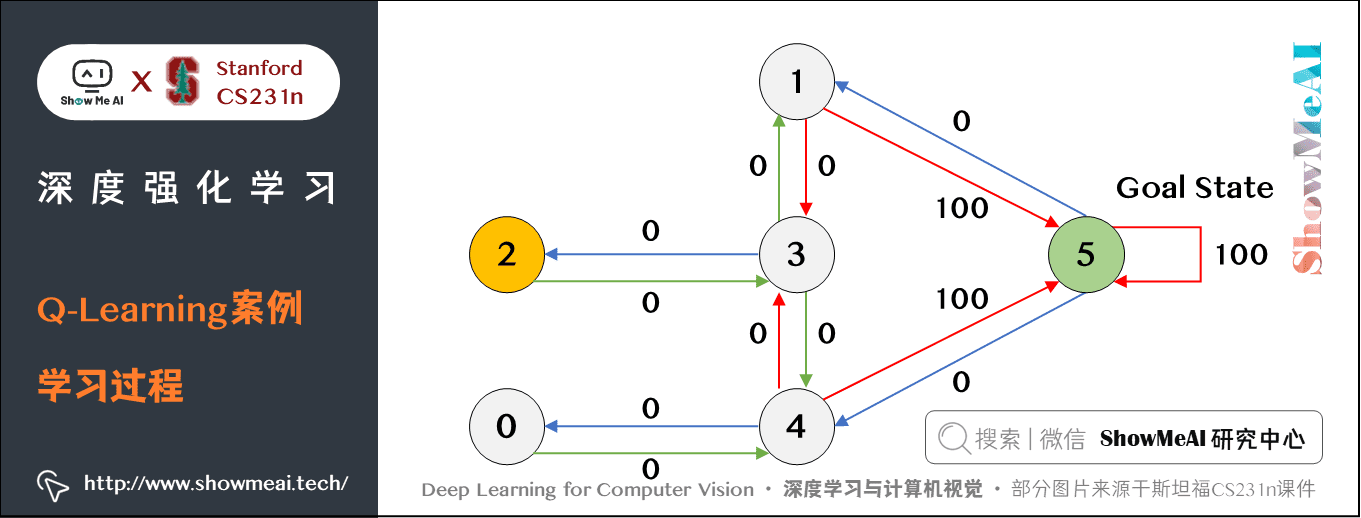

**Q 学习**:直接更新动作价值函数,无需显式计算状态价值函数。

**深度 Q 网络 (DQN)**:使用深度神经网络来近似动作价值函数,从而处理高维状态空间。

# 3. 深度强化学习实践应用

### 3.1 游戏和机器人控制

深度强化学习在游戏和机器人控制领域取得了显著成功。在游戏中,深度强化学习算法已被用于掌握复杂的游戏,如围棋、星际争霸和 Dota 2。这些算法能够学习复杂策略,击败人类玩家。

在机器人控制

0

0