揭秘算法优化:从理论到实践,提升算法性能的必备攻略

发布时间: 2024-08-25 04:39:55 阅读量: 58 订阅数: 36

# 1. 算法优化理论基础**

算法优化是计算机科学中至关重要的一门技术,旨在提高算法的性能和效率。算法的性能通常由时间复杂度和空间复杂度来衡量。

时间复杂度描述了算法执行所需的时间,通常以输入数据的大小作为函数来表示。常见的复杂度类别包括 O(1)、O(log n)、O(n)、O(n^2) 和 O(2^n)。

空间复杂度描述了算法执行所需的内存空间,也通常以输入数据的大小作为函数来表示。常见的复杂度类别包括 O(1)、O(log n)、O(n) 和 O(n^2)。

# 2. 算法优化实践技巧

在掌握了算法优化理论基础后,让我们深入探讨实际的优化技巧。本章将介绍算法复杂度分析、数据结构优化和算法设计模式,这些技巧将帮助你提升算法的性能和效率。

### 2.1 算法复杂度分析

算法复杂度分析是衡量算法性能的关键指标。它描述了算法在不同输入规模下的时间和空间消耗。

#### 2.1.1 时间复杂度

时间复杂度表示算法执行所需的时间,通常用大 O 符号表示。常见的时间复杂度包括:

| 时间复杂度 | 描述 |

|---|---|

| O(1) | 常数时间 |

| O(log n) | 对数时间 |

| O(n) | 线性时间 |

| O(n^2) | 平方时间 |

| O(2^n) | 指数时间 |

#### 2.1.2 空间复杂度

空间复杂度表示算法执行所需的空间,通常也用大 O 符号表示。常见的空间复杂度包括:

| 空间复杂度 | 描述 |

|---|---|

| O(1) | 常数空间 |

| O(n) | 线性空间 |

| O(n^2) | 平方空间 |

### 2.2 数据结构优化

数据结构的选择对算法性能有重大影响。不同的数据结构具有不同的时间和空间复杂度,选择合适的数据结构可以显著提高算法效率。

#### 2.2.1 数组与链表

数组是一种连续的内存块,可以快速访问元素。链表是一种动态数据结构,由节点组成,每个节点存储数据和指向下一个节点的指针。

| 数据结构 | 时间复杂度 | 空间复杂度 |

|---|---|---|

| 数组 | O(1) | O(n) |

| 链表 | O(n) | O(n) |

#### 2.2.2 树与图

树是一种层次结构,其中每个节点最多有一个父节点和多个子节点。图是一种更通用的数据结构,其中节点之间可以有多条边连接。

| 数据结构 | 时间复杂度 | 空间复杂度 |

|---|---|---|

| 二叉树 | O(log n) | O(n) |

| 图 | O(n + m) | O(n + m) |

#### 2.2.3 哈希表

哈希表是一种基于键值对的数据结构。它使用散列函数将键映射到存储位置,从而实现快速查找和插入。

| 数据结构 | 时间复杂度 | 空间复杂度 |

|---|---|---|

| 哈希表 | O(1) | O(n) |

### 2.3 算法设计模式

算法设计模式提供了一组通用的解决问题的方法,可以帮助你设计更有效率的算法。

#### 2.3.1 分治法

分治法将问题分解成较小的子问题,递归地解决这些子问题,然后合并结果。

#### 2.3.2 贪心算法

贪心算法在每个步骤中做出局部最优决策,以期获得全局最优解。

#### 2.3.3 动态规划

动态规划将问题分解成重叠的子问题,并存储子问题的解决方案,以避免重复计算。

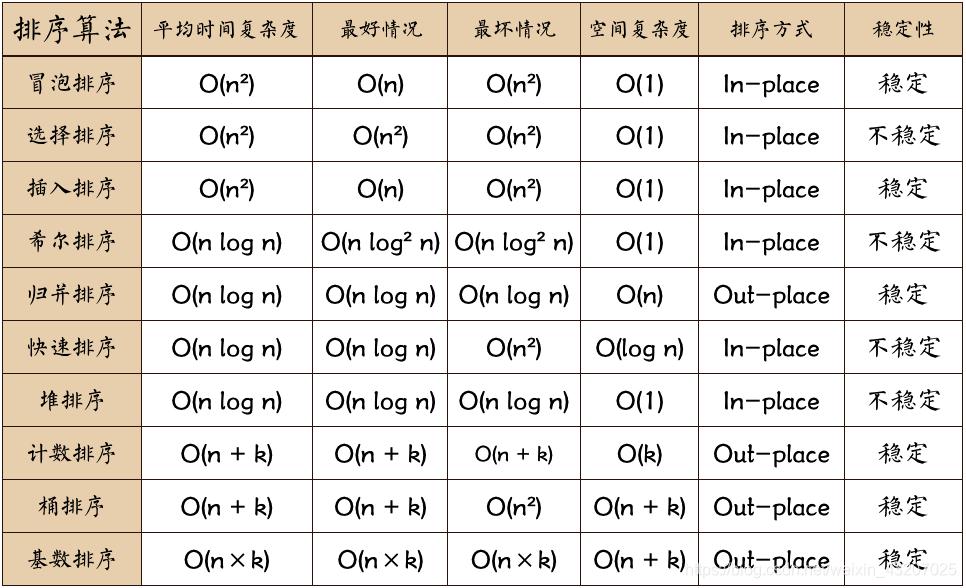

# 3.1 排序算法优化

排序算法是算法优化中至关重要的一个方面,它们用于对数据进行排序,以方便后续处理。在本章节中,我们将探讨三种经典的排序算法:冒泡排序、快速排序和归并排序,并分析它们的优化技巧。

#### 3.1.1 冒泡排序

冒泡排序是一种简单直观的排序算法,它通过不断比较相邻元素并交换顺序,将最大元素逐渐移动到数组末尾。其时间复杂度为 O(n^2),空间复杂度为 O(1)。

```python

def bubble_sort(arr):

"""

冒泡排序算法

参数:

arr:待排序数组

返回:

排序后的数组

"""

n = len(arr)

for i in range(n):

for j in range(0, n - i - 1):

if arr[j] > arr[j + 1]:

arr[j], arr[j + 1] = arr[j + 1], arr[j]

return arr

```

**优化技巧:**

* **提前退出优化:**如果在某次遍历中没有发生任何交换,说明数组已经有序,可以提前退出排序。

* **哨兵优化:**设置一个哨兵元素,将其置于数组末尾,当哨兵元素与相邻元素比较时,说明数组已经有序,可以提前退出排序。

#### 3.1.2 快速排序

快速排序是一种分治排序算法,它通过选取一个基准元素,将数组划分为两个子数组,然后递归地对子数组进行排序。其平均时间复杂度为 O(n log n),最坏时间复杂度为 O(n^2),空间复杂度为 O(log n)。

```python

def quick_sort(arr, low, high):

"""

快速排序算法

参数:

arr:待排序数组

low:子数组起始索引

high:子数组结束索引

返回:

排序后的数组

"""

if low < high:

pivot = partition(arr, low, high)

quick_sort(arr, low, pivot - 1)

quick_sort(arr, pivot + 1, high)

def partition(arr, low, high):

"""

快速排序分区函数

参数:

arr:待排序数组

low:子数组起始索引

high:子数组结束索引

返回:

基准元素索引

"""

pivot = arr[high]

i = low - 1

for j in range(low, high):

if arr[j] <= pivot:

i += 1

arr[i], arr[j] = arr[j], arr[i]

arr[i + 1], arr[high] = arr[high], arr[i + 1]

return i + 1

```

**优化技巧:**

* **随机化基准元素:**随机选择基准元素可以避免最坏情况下的时间复杂度。

* **插入排序优化:**当数组规模较小时,使用插入排序可以提高效率。

* **尾递归优化:**使用尾递归可以避免不必要的函数调用,提高性能。

#### 3.1.3 归并排序

归并排序是一种稳定排序算法,它通过将数组分成较小的子数组,然后递归地对子数组进行排序,最后合并子数组得到最终结果。其时间复杂度为 O(n log n),空间复杂度为 O(n)。

```python

def merge_sort(arr):

"""

归并排序算法

参数:

arr:待排序数组

返回:

排序后的数组

"""

n = len(arr)

if n <= 1:

return arr

mid = n // 2

left = merge_sort(arr[:mid])

right = merge_sort(arr[mid:])

return merge(left, right)

def merge(left, right):

"""

归并排序合并函数

参数:

left:左子数组

right:右子数组

返回:

合并后的数组

"""

i = 0

j = 0

merged = []

while i < len(left) and j < len(right):

if left[i] <= right[j]:

merged.append(left[i])

i += 1

else:

merged.append(right[j])

j += 1

while i < len(left):

merged.append(left[i])

i += 1

while j < len(right):

merged.append(right[j])

j += 1

return merged

```

**优化技巧:**

* **归并插入排序:**当数组规模较小时,使用归并插入排序可以提高效率。

* **哨兵优化:**在合并函数中使用哨兵元素可以简化代码和提高性能。

* **多线程优化:**使用多线程可以并行合并子数组,提高排序速度。

# 4. 算法优化进阶

### 4.1 并行算法

#### 4.1.1 多线程编程

多线程编程是一种并行编程技术,它允许在一个进程中同时执行多个任务。通过创建和管理多个线程,我们可以充分利用多核处理器的优势,提高算法性能。

**代码块:**

```python

import threading

def task(i):

# 执行任务 i

pass

# 创建 4 个线程

threads = []

for i in range(4):

thread = threading.Thread(target=task, args=(i,))

threads.append(thread)

# 启动所有线程

for thread in threads:

thread.start()

# 等待所有线程完成

for thread in threads:

thread.join()

```

**逻辑分析:**

该代码创建一个包含 4 个线程的线程池。每个线程执行 `task` 函数,该函数接收一个参数 `i`。主线程创建并启动所有线程,然后等待它们完成。

**参数说明:**

* `target`:要由线程执行的函数。

* `args`:传递给 `target` 函数的参数元组。

#### 4.1.2 分布式计算

分布式计算是一种并行编程技术,它允许在多台计算机上同时执行任务。通过将任务分解成较小的子任务并将其分配给不同的计算机,我们可以显著提高算法性能。

**代码块:**

```python

import dask

def task(i):

# 执行任务 i

pass

# 创建 Dask 集群

cluster = dask.distributed.Client()

# 创建一个包含 4 个任务的列表

tasks = [task(i) for i in range(4)]

# 提交任务到集群

results = cluster.compute(tasks)

```

**逻辑分析:**

该代码使用 Dask 分布式计算库创建一个 Dask 集群。然后,它创建一个包含 4 个任务的列表,并将它们提交到集群。集群将任务分配给不同的工作节点,并行执行它们。

**参数说明:**

* `client`:连接到 Dask 集群的客户端。

* `tasks`:要提交到集群的任务列表。

### 4.2 启发式算法

启发式算法是一类不保证找到最优解,但通常能找到近似最优解的算法。它们常用于解决复杂优化问题,如旅行商问题和车辆路径规划。

#### 4.2.1 遗传算法

遗传算法是一种启发式算法,它模拟生物进化过程来寻找最优解。它从一组候选解开始,然后通过选择、交叉和变异操作迭代地改进解。

**代码块:**

```python

import random

def fitness(individual):

# 计算个体的适应度

pass

def selection(population):

# 从种群中选择个体进行交叉

pass

def crossover(parent1, parent2):

# 交叉两个个体产生一个新个体

pass

def mutation(individual):

# 对个体进行变异

pass

# 初始化种群

population = [random.randint(0, 100) for i in range(100)]

# 迭代遗传算法

for i in range(100):

# 选择个体

parents = selection(population)

# 交叉个体

offspring = crossover(parents[0], parents[1])

# 变异个体

offspring = mutation(offspring)

# 评估个体

fitness_offspring = fitness(offspring)

# 替换种群中的个体

if fitness_offspring > fitness(population[i]):

population[i] = offspring

```

**逻辑分析:**

该代码实现了遗传算法。它从一个随机生成的种群开始,然后通过选择、交叉和变异操作迭代地改进种群。每次迭代,算法都会选择两个个体进行交叉,产生一个新的个体。然后,对新个体进行变异,并将其添加到种群中。如果新个体的适应度高于种群中现有个体的适应度,则会替换现有个体。

**参数说明:**

* `fitness`:计算个体适应度的函数。

* `selection`:从种群中选择个体的函数。

* `crossover`:交叉两个个体的函数。

* `mutation`:对个体进行变异的函数。

### 4.3 机器学习算法优化

机器学习算法优化涉及调整算法超参数和选择最佳模型,以提高算法性能。

#### 4.3.1 模型选择

模型选择是选择最适合给定数据集和任务的机器学习模型的过程。可以使用交叉验证或网格搜索等技术来评估不同模型的性能。

**代码块:**

```python

from sklearn.model_selection import cross_val_score

# 定义模型列表

models = [LinearRegression(), LogisticRegression(), DecisionTreeClassifier()]

# 定义交叉验证参数

cv = 5

# 评估每个模型

for model in models:

scores = cross_val_score(model, X, y, cv=cv)

print(f"{model.__class__.__name__}: {scores.mean()}")

```

**逻辑分析:**

该代码使用交叉验证评估不同机器学习模型的性能。它使用 `cross_val_score` 函数,该函数将数据集划分为多个折,并对每个折执行模型训练和评估。然后,它计算每个折的平均得分,并打印每个模型的平均得分。

**参数说明:**

* `model`:要评估的机器学习模型。

* `X`:特征数据。

* `y`:目标数据。

* `cv`:交叉验证折数。

#### 4.3.2 超参数调优

超参数调优是调整机器学习算法超参数的过程,以提高算法性能。可以使用网格搜索或贝叶斯优化等技术来找到最佳超参数。

**代码块:**

```python

from sklearn.model_selection import GridSearchCV

# 定义超参数网格

param_grid = {'C': [0.1, 1, 10], 'kernel': ['linear', 'rbf']}

# 创建网格搜索对象

grid_search = GridSearchCV(LogisticRegression(), param_grid, cv=5)

# 拟合网格搜索对象

grid_search.fit(X, y)

# 获取最佳超参数

best_params = grid_search.best_params_

```

**逻辑分析:**

该代码使用网格搜索执行超参数调优。它定义了一个超参数网格,其中包含要调整的超参数及其可能的值。然后,它创建一个网格搜索对象,该对象将使用交叉验证评估不同超参数组合的模型性能。最后,它拟合网格搜索对象,并获取最佳超参数。

**参数说明:**

* `model`:要调优的机器学习模型。

* `param_grid`:超参数网格,其中包含要调整的超参数及其可能的值。

* `cv`:交叉验证折数。

# 5. 算法优化工具与平台

### 5.1 性能分析工具

性能分析工具是算法优化过程中不可或缺的利器,它们可以帮助我们识别算法的瓶颈,并指导我们进行有针对性的优化。

#### 5.1.1 gprof

gprof 是一个 GNU 工具,用于分析程序的性能。它通过采样程序的执行来收集数据,并生成一个报告,其中包含每个函数的调用次数、执行时间和调用关系。

**代码块:**

```c

#include <gprof.h>

int main() {

// ...

gprof_start();

// ...

gprof_stop();

return 0;

}

```

**逻辑分析:**

* `gprof_start()` 开始性能采样。

* `gprof_stop()` 停止性能采样。

* gprof 会生成一个名为 `gmon.out` 的文件,其中包含性能数据。

#### 5.1.2 valgrind

valgrind 也是一个 GNU 工具,用于检测内存错误和性能问题。它通过模拟一个虚拟的 CPU 来执行程序,并监视其内存访问模式。

**代码块:**

```bash

valgrind --tool=memcheck ./my_program

```

**逻辑分析:**

* `--tool=memcheck` 指定使用内存检查工具。

* valgrind 会输出一个报告,其中包含内存错误和性能问题的详细信息。

#### 5.1.3 perf

perf 是一个 Linux 内核工具,用于分析系统性能。它可以收集有关 CPU 使用率、内存访问和 I/O 操作等各种指标的数据。

**代码块:**

```bash

perf record -g ./my_program

```

**逻辑分析:**

* `-g` 指定生成一个图形报告。

* perf 会生成一个名为 `perf.data` 的文件,其中包含性能数据。

### 5.2 并行编程平台

并行编程平台允许我们利用多核 CPU 或分布式系统来提高算法性能。

#### 5.2.1 OpenMP

OpenMP 是一个用于共享内存并行编程的 API。它提供了一组编译器指令,允许程序员指定并行区域和线程同步。

**代码块:**

```c

#include <omp.h>

int main() {

// ...

#pragma omp parallel

{

// ...

}

// ...

}

```

**逻辑分析:**

* `#pragma omp parallel` 指示编译器将代码块并行化。

* OpenMP 会自动创建和管理线程,并确保它们以并行方式执行代码块。

#### 5.2.2 MPI

MPI(消息传递接口)是一个用于分布式内存并行编程的标准。它提供了一组函数,允许程序员在不同的进程之间发送和接收消息。

**代码块:**

```c

#include <mpi.h>

int main(int argc, char** argv) {

// ...

MPI_Init(&argc, &argv);

// ...

MPI_Finalize();

return 0;

}

```

**逻辑分析:**

* `MPI_Init()` 初始化 MPI 环境。

* `MPI_Finalize()` 结束 MPI 环境。

* MPI 提供了一系列函数,用于发送和接收消息、同步进程等。

#### 5.2.3 Hadoop

Hadoop 是一个分布式计算框架,用于处理大数据。它提供了分布式文件系统(HDFS)和一个用于并行处理数据的框架(MapReduce)。

**代码块:**

```java

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.IntWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Job;

import org.apache.hadoop.mapreduce.Mapper;

import org.apache.hadoop.mapreduce.Reducer;

public class WordCount {

public static void main(String[] args) throws Exception {

// ...

Job job = Job.getInstance(new Configuration());

// ...

job.waitForCompletion(true);

}

public static class MyMapper extends Mapper<Object, Text, Text, IntWritable> {

// ...

}

public static class MyReducer extends Reducer<Text, IntWritable, Text, IntWritable> {

// ...

}

}

```

**逻辑分析:**

* Hadoop 使用 MapReduce 框架来并行处理数据。

* `Mapper` 类负责将输入数据映射到键值对。

* `Reducer` 类负责将键值对聚合并输出最终结果。

# 6.1 性能测试与基准测试

性能测试和基准测试是算法优化过程中的关键步骤,它们可以帮助我们评估算法的实际性能并指导进一步的优化。

### 性能测试

性能测试涉及在真实或模拟环境中运行算法,以测量其执行时间、内存使用情况和其他性能指标。常用的性能测试方法包括:

- **负载测试:**模拟不同负载下的算法性能,以确定其可扩展性。

- **压力测试:**将算法推向极限,以识别其瓶颈和故障点。

- **基准测试:**将算法与其他类似算法进行比较,以评估其相对性能。

### 基准测试

基准测试是一种特殊类型的性能测试,用于比较不同算法或算法的不同实现的性能。基准测试通常在受控环境中进行,以确保公平的比较。

基准测试结果可以帮助我们:

- 识别最适合特定任务的算法。

- 评估不同算法的性能差异。

- 跟踪算法性能随时间推移的变化。

### 实施性能测试和基准测试

实施性能测试和基准测试时,需要考虑以下因素:

- **测试环境:**选择一个代表实际使用环境的测试环境。

- **测试数据:**使用与实际数据类似的测试数据。

- **测试指标:**确定要测量的特定性能指标,例如执行时间、内存使用情况和吞吐量。

- **测试方法:**选择适当的性能测试和基准测试方法。

- **数据分析:**分析测试结果并确定算法性能的改进领域。

0

0