【Hadoop集群中XML文件的数据压缩】:显著减少存储与带宽消耗

发布时间: 2024-10-26 22:07:21 阅读量: 21 订阅数: 24

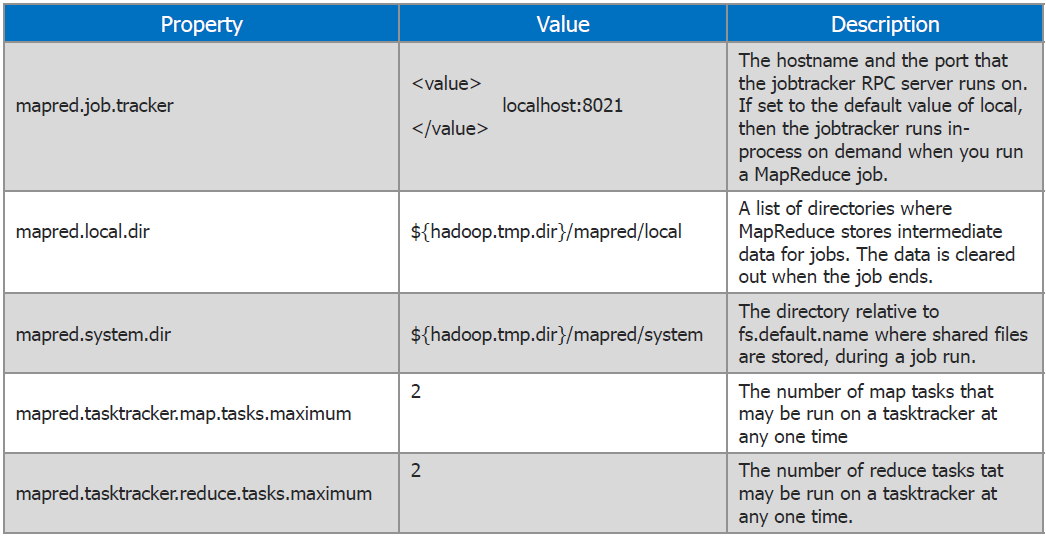

hadoop集群的配置文件

# 1. Hadoop集群与数据压缩的基本概念

在大数据时代,Hadoop作为开源框架的代表性产物,已成为处理海量数据的核心技术之一。它采用分布式存储和计算模式,能够对大量数据集进行有效的管理和分析。数据压缩技术是Hadoop高效处理数据的关键因素之一,它可以在存储和传输数据时减少资源消耗,提升系统的整体性能。

## 1.1 Hadoop集群的基本原理

Hadoop集群由一个主节点(NameNode)和多个工作节点(DataNode)构成。主节点负责管理文件系统的命名空间和客户端对文件的访问。工作节点负责存储数据,并在主节点的调度下完成具体的数据处理任务。Hadoop通过MapReduce编程模型,将数据处理任务分布到各个节点上,以并行处理的方式提高数据处理能力。

## 1.2 数据压缩的目的和作用

数据压缩技术旨在减少数据存储所需空间和传输时间,以降低存储成本和网络带宽使用。在Hadoop集群中,合理使用数据压缩技术可以减少磁盘I/O操作,提高数据读写速度,从而提升整个系统的性能和效率。在选择压缩技术时,需要根据数据类型和访问模式进行综合考虑,以达到最优的压缩效果。

通过本章的学习,我们将对Hadoop集群的结构和工作原理有一个初步的认识,并理解数据压缩在其中所扮演的角色。后续章节将深入探讨XML文件的结构特性以及在Hadoop集群中如何实现和优化数据压缩技术。

# 2. XML文件的结构与特性

### 2.1 XML文件概述

#### 2.1.1 XML文件的定义和应用场景

XML(Extensible Markup Language)即可扩展标记语言,是一种用于存储和传输数据的标记语言。它允许开发者定义自己的标签,以满足特定应用的需求,同时也可以用来表示结构化信息。与HTML类似,XML也是由标签和属性组成的,但它更专注于数据内容而非显示格式。

XML的应用场景非常广泛,包括但不限于配置文件、数据交换格式、网络服务请求和响应、文档标记等。例如,RSS和Atom都是基于XML的格式,用于提供网站的摘要信息;Web服务中使用SOAP协议,它的消息格式也是XML。

#### 2.1.2 XML文件的数据结构特点

XML文件的结构非常灵活,它支持嵌套的标签元素,这些元素可以拥有子元素和属性。这种结构让XML非常适合表示层次化或关系型的数据。以下是XML结构的一些关键特点:

- **层次性**:XML文件以嵌套的形式组织数据,这意味着每个元素(标签)可以有子元素,可以直观地表示信息的层次关系。

- **自描述性**:XML元素由标签来定义,标签可以直观地描述数据的内容和类型。

- **可扩展性**:开发者可以自由定义自己的标签,这使得XML能够适应不断变化的数据需求。

- **可验证性**:通过DTD(文档类型定义)或XML Schema,可以验证XML文档的有效性,确保数据的正确性和一致性。

### 2.2 XML文件的解析方法

#### 2.2.1 DOM解析技术

文档对象模型(DOM,Document Object Model)解析技术,将XML文档整个加载到内存中,并将其解析成一个树状结构的节点对象,方便进行遍历和操作。DOM解析器读取整个XML文档,并在内存中创建一个称为节点树的树状结构。每个节点代表文档中的一个元素。由于DOM将整个文档加载到内存中,因此对于大型文档,可能会导致性能问题。

下面是一个简单的DOM解析XML文件的例子:

```java

import javax.xml.parsers.DocumentBuilder;

import javax.xml.parsers.DocumentBuilderFactory;

import org.w3c.dom.Document;

import org.w3c.dom.Element;

import org.w3c.dom.NodeList;

import org.xml.sax.InputSource;

import java.io.StringReader;

public class DOMExample {

public static void main(String[] args) throws Exception {

String xml = "<books>" +

"<book>" +

"<title>Effective Java</title>" +

"<author>Joshua Bloch</author>" +

"</book>" +

"</books>";

DocumentBuilderFactory factory = DocumentBuilderFactory.newInstance();

DocumentBuilder builder = factory.newDocumentBuilder();

InputSource is = new InputSource(new StringReader(xml));

Document document = builder.parse(is);

NodeList bookNodes = document.getElementsByTagName("book");

for (int i = 0; i < bookNodes.getLength(); i++) {

Element bookElement = (Element) bookNodes.item(i);

String title = bookElement.getElementsByTagName("title").item(0).getTextContent();

String author = bookElement.getElementsByTagName("author").item(0).getTextContent();

System.out.println("Book title: " + title + ", Author: " + author);

}

}

}

```

#### 2.2.2 SAX解析技术

SAX(Simple API for XML)解析器采用事件驱动的方式读取XML文档。当解析器读取到XML文档中的元素时,会触发一系列事件,通过注册事件处理器来响应这些事件。SAX解析器不需要将整个文档加载到内存中,因此对于大型文件的解析,SAX比DOM更为高效。

下面是一个使用SAX解析XML文件的例子:

```java

import org.xml.sax.helpers.DefaultHandler;

import org.xml.sax.*;

public class SAXHandler extends DefaultHandler {

boolean title = false;

boolean author = false;

String currentTitle = "";

String currentAuthor = "";

public void startElement(String uri, String localName, String qName, Attributes attributes) throws SAXException {

if (qName.equalsIgnoreCase("title")) {

title = true;

}

if (qName.equalsIgnoreCase("author")) {

author = true;

}

}

public void endElement(String uri, String localName, String qName) throws SAXException {

if (qName.equalsIgnoreCase("title")) {

title = false;

System.out.println("Book title: " + currentTitle);

}

if (qName.equalsIgnoreCase("author")) {

author = false;

System.out.println("Book author: " + currentAuthor);

}

}

public void characters(char ch[], int start, int length) throws SAXException {

if (title) {

currentTitle = new String(ch, start, length);

}

if (author) {

currentAuthor = new String(ch, start, length);

}

}

}

```

#### 2.2.3 StAX解析技术

StAX(Streaming API for XML)解析技术是JAXP(Java API for XML Processing)中的一种,它提供了一种基于拉模式的解析方式。开发者可以控制解析过程,并在任何时候读取XML文档中的下一个数据项。与SAX类似,StAX也不需要加载整个文档到内存,而是通过流式处理,逐个元素读取文档。

下面是一个使用StAX解析XML文件的例子:

```java

import javax.xml.stream.XMLEventReader;

import j

```

0

0