机器学习伦理审核:建立可信赖AI的机制与实践

发布时间: 2024-09-01 23:01:36 阅读量: 66 订阅数: 43

# 1. 机器学习伦理审核的背景与挑战

## 1.1 人工智能的伦理困境

在当前信息技术飞速发展的背景下,人工智能(AI)和机器学习(ML)已经广泛应用于各个行业。尽管AI带来了便利和效率,但随着其应用深入,伦理问题也日益凸显。如何确保AI技术的公平性、透明度和责任归属,成为亟待解决的挑战。机器学习伦理审核便是在这样的背景下出现,旨在确保AI系统的开发和部署符合社会伦理标准。

## 1.2 伦理审核的需求与紧迫性

随着AI技术的普及,伦理审核的需求愈发凸显。例如,模型可能因为训练数据的偏差而产生歧视性结果;算法决策过程的不透明使得问责变得复杂。因此,如何通过伦理审核来预防和解决这些问题,成为AI行业不可回避的议题。

## 1.3 审核流程与方法论

实现有效的伦理审核需要一套科学的方法论。这包括但不限于明确审核的目标和原则、建立相应的审核标准和流程、采用先进的工具和技术。审核过程通常涉及利益相关者的多方协作,以及对AI系统从设计、开发到部署的全生命周期的持续监督和评估。

# 2. 可信赖AI的理论基础

### 2.1 人工智能伦理原则

#### 2.1.1 公平性与非歧视原则

公平性是构建可信赖AI的核心伦理原则之一。随着AI技术的不断进步,机器学习模型可能会不自觉地继承或放大人类数据中的偏见。为了确保公平性与非歧视,开发人员和数据科学家需要采取主动措施,识别和缓解数据中的潜在偏见。

**重要步骤包括**:

- **数据审查**:分析训练数据集,查找可能导致偏差的模式或群体,确保样本的多样性和代表性。

- **算法设计**:采用去偏算法或技术,确保模型输出对于不同群体都是公平的。

- **结果评估**:实施模型后,定期审查模型的决策过程,确保公平性始终得到维护。

#### 2.1.2 可解释性与透明度

可解释性是理解AI决策的基础,特别是在涉及高风险领域如医疗、金融和司法时。可解释的AI系统能够让利益相关者理解模型如何得出特定的结论,增加了对AI决策的信任度。

**关键要素包含**:

- **模型透明度**:提供模型工作原理的详细说明,包括所使用的数据、特征选择、模型结构等。

- **解释方法**:开发和应用模型解释技术,比如LIME(局部可解释模型-不透明模型)或SHAP(SHapley Additive exPlanations)值,以可视化模型的关键驱动因素。

- **用户界面**:创建直观的用户界面,让用户能够轻松理解模型的预测和决策依据。

#### 2.1.3 责任归属与问责机制

确保AI系统中的责任归属清晰是另一项核心伦理原则。它涉及到当AI系统的行为导致不利后果时,能够确定和追究责任。

**建立问责机制的步骤包括**:

- **明确责任主体**:确定在AI系统开发、部署和监管中各个阶段的责任主体。

- **规范操作流程**:制定标准操作流程,包括模型测试、监控和审计。

- **实施监管合规**:确保AI系统符合所有适用的行业标准和法律法规。

### 2.2 可信赖AI的技术要求

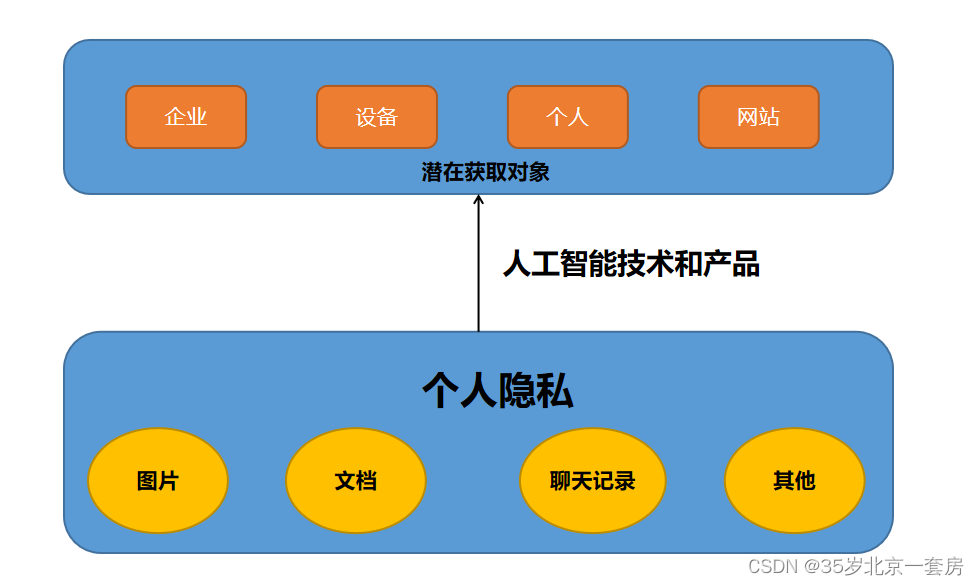

#### 2.2.1 安全性与隐私保护

安全性与隐私保护在可信赖AI中占据着举足轻重的地位。AI系统处理大量敏感数据时,确保用户隐私不被泄露是至关重要的。

**实现安全性和隐私保护的技术措施包括**:

- **加密技术**:使用端到端加密技术保护数据传输和存储过程中的隐私。

- **访问控制**:实施细粒度的访问控制机制,确保只有授权用户才能访问敏感信息。

- **数据匿名化**:在不损害AI性能的前提下,尽可能地匿名化处理训练和测试数据。

#### 2.2.2 数据治理与质量控制

数据治理涵盖了一系列管理数据的政策、过程和实践,以确保数据的可靠性和完整性。高质量的数据是确保AI系统信赖度的基础。

**数据治理的关键实践包括**:

- **数据质量管理**:建立机制对数据进行清洗、去重和标准化处理。

- **元数据管理**:记录和跟踪数据的来源、处理历史和质量指标。

- **数据生命周期管理**:制定策略和流程以管理数据从采集到删除的整个生命周期。

#### 2.2.3 长期监控与风险管理

长期监控和风险管理是确保AI系统长期保持信赖度的重要组成部分。这涉及到系统持续的性能监控、问题检测和风险缓解。

**监控和风险管理的步骤包括**:

- **性能监控**:定期检查模型的性能指标,确保其符合预期标准。

- **异常检测**:实施自动化的异常检测系统,以便在问题出现时及时发现。

- **风险评估**:定期进行风险评估,识别新的潜在风险,并制定相应的缓解措施。

通过实施上述各项措施,可以确保AI系统在设计、开发和部署过程中都符合可信赖AI的伦理和技术要求。下一章节将深入探讨伦理审核机制的构建与实施,这是一系列结构化流程和实践活动,旨在确保AI系统在其生命周期中的每一个环节都满足这些伦理和技术标准。

# 3. 伦理审核机制的构建与实施

构建和实施一个有效的伦理审核机制对于确保机器学习和人工智能(AI)系统的信赖性至关重要。本章将探讨如何标准化伦理审核流程,组织和管理审核过程,以及采用哪些工具和技术来支持这一过程。

## 伦理审核流程的标准化

伦理审核流程的标准化是确保AI系统开发和部署过程中遵循伦理原则的基础。这包括建立审核框架、定义审核准则和评价标准。

### 审核框架的建立

为了建立一个伦理审核框架,组织需要首先明确审核的目标和原则。这些目标可能包括确保系统公平、透明和可解释,同时遵守数据保护法规和行业标准。框架本身应包含以下几个关键组件:

- **审核范围**:明确审核将覆盖哪些项目,例如数据集、模型训练过程、部署后的监控等。

- **审核步骤**:制定详细的审核步骤和操作指南,确保审核人员能够遵循统一的标准。

- **角色和责任**:为审核过程中的各方角色(如审核员、项目负责人、最终用户等)定义明确的责任和期望。

- **结果记录**:建立记录审核结果的文档系统,便于追踪、分析和改进。

### 审核准则与评价标准

制定审核准则和评价标准是审核流程的核心部分。准则应基于已确定的伦理原则,并且反映当前的法规要求。评价标准则需要量化和具体化,以便于在审核过程中进行客观评估。例如,对于公平性的评价,可以设定特定的公平指标,并要求模型在这些指标上的表现达到

0

0