实体识别跨领域适应:如何提升模型泛化能力的4个技巧

发布时间: 2024-09-06 15:16:06 阅读量: 125 订阅数: 40

# 1. 实体识别的跨领域挑战

实体识别作为自然语言处理(NLP)的核心任务之一,其跨领域应用正面临巨大的挑战。由于不同领域具有特定的词汇、语言结构和语义表达,使得模型在从一个领域迁移到另一个领域的过程中,准确度往往大幅下降。实体识别不仅需要捕捉领域内的语言特征,还要具备足够的灵活性以适应不同领域的变化。此外,跨领域实体识别的挑战还包括如何处理领域内的歧义问题、如何利用有限的标注数据进行学习等。

本章将深入探讨实体识别在不同领域中遇到的难点,并分析其背后的原因。我们也将提出一些当前研究和实践中所采取的策略,以及这些策略对解决跨领域挑战的潜在影响。理解这些挑战对于设计能够跨领域工作的实体识别系统至关重要。

## 1.1 领域差异对实体识别的影响

领域差异是实体识别跨领域应用中遇到的第一个障碍。不同领域的文本在词汇使用、术语定义以及表达习惯上存在显著差异,使得在特定领域内训练得到的模型难以直接应用于其他领域。例如,医疗领域和金融领域的文本特征截然不同,模型如果在没有适当调整的情况下进行迁移,其识别效果会大大降低。

## 1.2 处理跨领域挑战的策略

针对领域差异带来的挑战,研究者们提出了多种处理策略,主要包括迁移学习、多任务学习和域自适应技术等。通过这些方法可以使得模型在一个领域学到的知识,能够更好地迁移到其他领域,从而提高模型的泛化能力和适应性。后续章节将详细探讨这些技术的具体应用和优化方法。

## 1.3 小结

实体识别在跨领域应用中面临诸多挑战,包括领域内差异、数据分布不一致等问题。理解这些挑战以及对应解决方案对于构建有效的跨领域实体识别系统具有重要意义。下一章我们将深入介绍跨领域适应的理论基础,为读者提供更多的技术细节和理论支撑。

# 2. 跨领域适应的理论基础

### 2.1 域适应理论概述

#### 2.1.1 域适应的基本概念

域适应(Domain Adaptation)是机器学习中的一个核心问题,它致力于解决源域和目标域之间存在的分布不一致问题。在很多实际应用中,尤其是在自然语言处理、计算机视觉等领域,通常面临着训练数据与实际应用场景之间存在偏差的情况。这种偏差可能会导致模型的泛化能力下降,进而影响模型在新领域的表现。

例如,在实体识别任务中,一个在新闻文本上训练的模型可能难以适应社交媒体文本。源域(新闻文本)和目标域(社交媒体文本)的统计分布存在差异,这些差异可能来源于词汇使用、语境、甚至是语法结构的不同。域适应旨在通过某种方法来缓解这种分布偏差,从而使得模型能够更好地适应新的领域。

#### 2.1.2 域适应的必要性和挑战

域适应的必要性主要体现在以下几个方面:

- **数据分布不一致**:由于实际应用中数据收集的困难,经常存在训练数据与实际应用场景数据分布不一致的情况。

- **适应新环境**:模型往往需要部署到与训练数据分布不同的环境,如跨语言、跨平台等。

- **降低标注成本**:对于新领域的数据重新进行大量标注成本高昂,域适应可以利用已有源域的标注信息。

挑战主要包括:

- **分布差异的衡量**:确定源域和目标域之间的分布差异的度量是一个关键问题。

- **迁移难度的评估**:如何评估从源域到目标域的迁移难度是一个挑战。

- **迁移方法的选择**:选择合适的迁移方法以最小化迁移误差。

### 2.2 跨领域适应的技术框架

#### 2.2.1 无监督域适应的技术路径

无监督域适应(Unsupervised Domain Adaptation, UDA)是指在目标域中没有标注数据的情况下进行的适应。技术路径一般包括以下步骤:

1. **特征对齐**:通过特征变换,使得源域和目标域的特征分布尽可能接近。

2. **伪标签生成**:利用源域训练好的模型在目标域数据上生成伪标签,实现隐式标注。

3. **模型更新**:结合源域的数据和伪标签在目标域上进行模型的再训练或微调。

这里是一个简单的伪代码来说明无监督域适应的基本流程:

```python

# 源域数据集

source_data = ...

# 目标域数据集

target_data = ...

# 源域预训练模型

pretrained_model = ...

# 特征对齐

aligned_features = feature_alignment(source_data, target_data)

# 生成伪标签

pseudo_labels = generate_pseudo_labels(pretrained_model, aligned_features)

# 模型更新

***d_model = fine_tune(pretrained_model, aligned_features, pseudo_labels)

# 在目标域数据上评估模型性能

performance = evaluate(updated_model, target_data)

```

特征对齐可以使用诸如对抗性训练、自编码器等方法来实现,伪标签生成则依赖于源域模型的置信度输出。

#### 2.2.2 自监督学习在域适应中的应用

自监督学习(Self-supervised Learning)是一种无需人工标注数据即可训练模型的方法,它通过设计一个预测任务来利用未标注数据。在域适应中,自监督学习通常用于目标域,通过构建与任务相关的辅助预测任务来学习有用的信息。

例如,在文本领域,可以设计一个预测下一个单词的任务,通过这种方式学习到的语言模型可以提取出文本的深层语义特征,并帮助完成实体识别等下游任务。

```python

# 自监督预训练模型

ssl_model = self_supervised_pretrain(target_data)

# 使用自监督预训练的模型进行下游任务微调

fine_tuned_model = fine_tune(ssl_model, target_data, task="NER")

```

#### 2.2.3 半监督学习的策略和效果

半监督学习(Semi-supervised Learning)介于有监督学习和无监督学习之间,利用少量的标注数据和大量的未标注数据共同训练模型。在域适应中,半监督学习策略通常涉及以下步骤:

1. **利用少量标注数据**:在有限的目标域标注数据上训练模型。

2. **扩展训练样本集**:使用模型对未标注数据进行标签预测,并选择高置信度的预测结果加入训练集。

3. **模型迭代更新**:基于扩展后的训练集不断迭代更新模型。

```python

# 初始少量标注的目标域数据

labeled_target_data = ...

# 大量未标注的目标域数据

unlabeled_target_data = ...

# 在少量标注数据上进行训练

initial_model = train(labeled_target_data)

# 对未标注数据进行预测,选取高置信度的样本加入训练集

additional_labeled_data = select_high_confidence_predictions(

unlabeled_target_data, initial_model)

# 在扩展后的训练集上继续训练模型

updated_model = train(set(labeled_target_data).union(additional_labeled_data))

# 进一步评估模型效果

final_performance = evaluate(updated_model, target_data)

```

这种方法的优势在于能够充分利用未标注数据中的信息,但缺点是需要精心设计选取高置信度样本的标准,并且需要确保样本选择过程不会引入错误的标签信息。

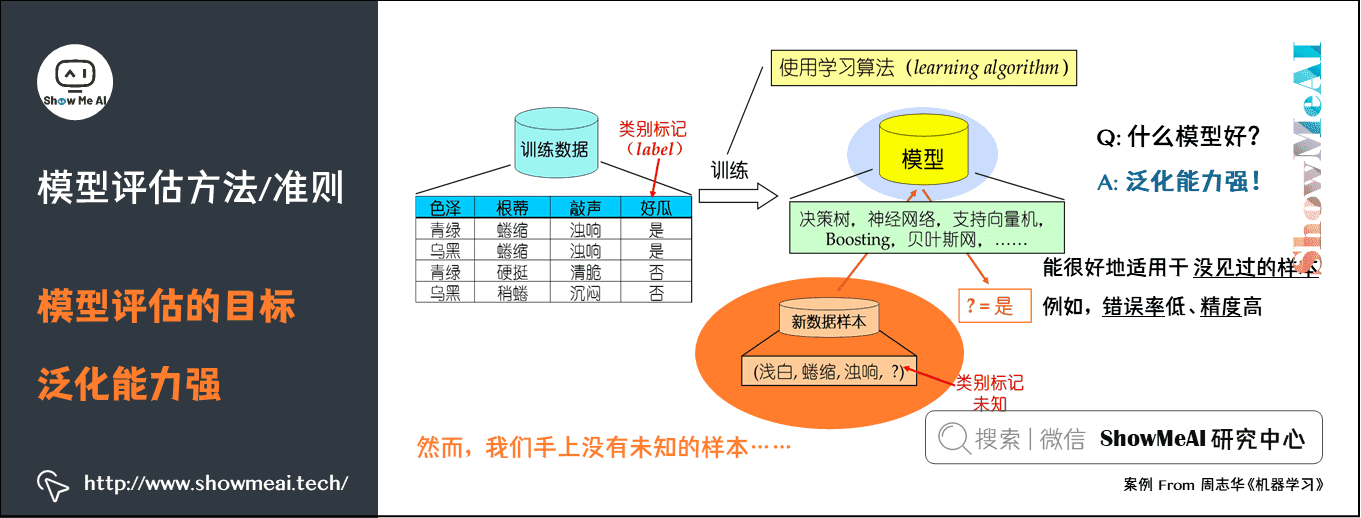

# 3. 泛化能力提升的关键技术

在深度学习模型中,泛化能力是指模型对未见过的数据的处理能力,这是衡量模型是否成功的关键指标之一。在本章中,我们将深入探讨提升模型泛化能力的几种关键技术,包括数据增强、迁移学习、模型微调与正则化,它们在改善模型对新领域数据适应性方面发挥着重要作用。

## 3.1 数据增强方法

数据增强是一种通过人为方式扩充数据集的技术,旨在通过产生变形或合成数据来减少模型过拟合的风险。在实体识别任务中,数据增强对于提高模型在不同领域间的泛化性能至关重要。

### 3.1.1 传统数据增强技术

传统数据增强技术主要包括随机裁剪、旋转、缩放、平移和颜色变化等。这些方法在图像处理中尤为常用,但在文本处理中也有一些应用。例如,在文本实体识别任务中,可以通过改变单词顺序、引入同义词替换、或改变语法结构等方式来增强数据集。

```python

import random

def traditional_text_augmentation(sentence):

# 随机裁剪

words = sentence.split()

augmented_sentence = ' '.join(random.sample(words, k=random.randint(1, len(words)-1)))

# 同义词替换

for word in augmented_sentence.split():

synonyms = get_synonyms(word) # 假设存在一个获取同义词的函数

if synonyms:

augmented_sentence = augmented_sentence.replace(word, random.choice(synonyms))

return augmented_sentence

def get_synonyms(word):

# 假设存在一个返回同义词的字典

synonyms_dict = {'fast': ['quick', 'swift', 'rapid'], 'good': ['great', 'excellent', 'fantastic']}

return synonyms_dict.get(word.lower(), [])

```

### 3.1.2 基于生成对抗网络的数据增强

近年来,基于生成对抗网络(GANs)的数据增强方法因其能够生成高度逼真的数据样本而受到关注。在实体识别任务中,GAN可以用来生成新的文本样本,这些样本能够保持原始数据的语义特征,同时引入足够的多样性,以提高模型的泛化能力。

```python

# 这里展示的是GAN的高层次伪代码,具体实现需依赖于深度学习库如TensorFlow或PyTorch

from GAN import Generato

```

0

0