实体识别实战手册:提升实体抽取准确性的8大优化技巧

发布时间: 2024-09-06 14:33:36 阅读量: 263 订阅数: 46

# 1. 实体识别的基础与重要性

实体识别(Named Entity Recognition,简称NER)是自然语言处理(Natural Language Processing,简称NLP)领域的一个核心任务,它旨在从文本中识别出具有特定意义的实体,如人名、地名、机构名、时间表达等。实体识别不仅是信息抽取、问答系统、机器翻译等NLP应用的基础,而且在知识图谱构建、大数据分析等领域也扮演着至关重要的角色。

实体识别的重要性首先体现在为机器理解和处理自然语言提供了一种有效的途径。通过准确识别文本中的实体,我们可以进一步分析实体间的语义关系,构建实体间的连接,形成知识图谱,从而在各种复杂的应用中提供智能决策支持。

此外,实体识别技术的进步也推动了自动化的新闻摘要、舆情监控、信息检索等应用的发展,这些应用在新闻媒体、市场分析、公共安全等多个领域具有广泛的应用前景。随着人工智能技术的不断演进,实体识别技术的重要性只会继续增长。

# 2. 实体抽取技术的理论基础

实体抽取技术是自然语言处理(NLP)的核心任务之一,它关注从文本中识别出具有特定意义的实体,如人名、地名、组织机构名等。在深入探讨实体抽取的实践技巧和优化策略之前,了解其理论基础是必不可少的。本章节将分别从实体识别的定义与任务、实体抽取的技术发展历程、主流算法以及评估指标等方面进行详细阐述。

### 2.1 自然语言处理中的实体识别

#### 2.1.1 实体识别的定义与任务

实体识别(Named Entity Recognition,NER),在自然语言处理领域被定义为从给定的文本中识别并分类文本内的实体的过程。实体通常指的是文本中的专有名词,如人名、地点、组织机构、时间表达式、数值表达式等具有特定意义的词汇。

任务上,实体识别通常可以分为几个步骤:首先是实体边界识别,确定实体在文本中的起止位置;其次是实体类型分类,确定实体属于预定义的类别之一,如“人名”、“地名”等;最后是在某些场景下对实体进行具体化,例如,将“苹果”区分为公司名称“苹果公司”或水果“苹果”。

#### 2.1.2 实体抽取的技术发展历程

实体抽取技术的发展大致可以划分为三个阶段:基于规则的方法、统计学习方法和深度学习方法。

- **基于规则的方法**:早期的实体抽取技术主要依靠手工编写的规则。这些规则通常依赖于语言学知识,例如句法模式和词典匹配。虽然这种方法在特定领域内能取得不错的效果,但其泛化能力较差,对规则制定者的要求较高。

- **统计学习方法**:随着机器学习技术的发展,基于统计的实体抽取方法开始兴起。这些方法通常使用大量标注好的训练数据来训练模型,通过分类算法如支持向量机(SVM)、隐马尔可夫模型(HMM)等来识别文本中的实体。

- **深度学习方法**:近年来,随着计算能力的提升和大规模数据集的出现,基于深度学习的实体抽取方法逐渐成为研究热点。利用神经网络的强大特征提取能力,深度学习模型能够在端到端的方式下直接从文本数据中学习到实体抽取的特征表示,显著提高了实体抽取的准确率。

### 2.2 实体抽取的主流算法

#### 2.2.1 基于规则的方法

基于规则的方法依靠人工设定的规则来识别文本中的实体。例如,规则可以指定人名通常包含大写字母开头的名词和形容词等。然而,这种方法在实际应用中存在显著的局限性。由于自然语言的多样性和复杂性,很难为每种实体类型设计出全面的规则。

```python

# 举例:基于规则的简单实体抽取

import re

def extract_entities_by_rules(text):

# 规则示例:提取文本中的所有大写开头的单词

entities = re.findall(r'\b[A-Z][a-z]*\b', text)

return entities

sample_text = "John Doe went to the Apple Store in Cupertino."

print(extract_entities_by_rules(sample_text))

```

上述代码展示了基于简单规则(提取所有以大写字母开头的单词)的实体抽取示例。这种方法简单易行,但其效果取决于规则设计的质量和语言材料的特异性。

#### 2.2.2 统计学习方法

统计学习方法主要依赖于大量的标注数据来训练模型。一个典型的统计学习方法是隐马尔可夫模型(HMM),该模型假设文本中的单词是通过隐状态(即实体类别)序列生成的,其核心任务是计算每个单词属于特定实体类别的概率。

```python

# 使用隐马尔可夫模型进行实体抽取的伪代码示例

# 假设实体识别模型已经通过大量数据训练得到

from hmmlearn.hmm import GaussianHMM

# 初始化HMM模型

model = GaussianHMM(n_components=4, covariance_type="diag", n_iter=100)

# 假设我们已经获得了训练数据

X_train = ... # 训练数据集

# 训练模型

model.fit(X_train)

# 对新文本进行实体抽取

X_new = ... # 新文本数据

new_entities = model.predict(X_new)

```

#### 2.2.3 深度学习方法

深度学习方法通过构建复杂的网络结构来自动学习和提取特征,大大减少了人工特征工程的需要。其中,循环神经网络(RNN)和其变体长短期记忆网络(LSTM)由于其在处理序列数据上的优势,被广泛应用于实体抽取任务中。近年来,随着Transformer架构的提出,基于自注意力机制的BERT(Bidirectional Encoder Representations from Transformers)等预训练模型在实体抽取任务中取得了突破性进展。

```python

# 使用预训练模型BERT进行实体抽取的伪代码示例

from transformers import BertTokenizer, BertForTokenClassification

import torch

# 初始化分词器和模型

tokenizer = BertTokenizer.from_pretrained('bert-base-uncased')

model = BertForTokenClassification.from_pretrained('bert-base-uncased')

# 对文本进行分词

inputs = tokenizer("Hugging Face", "Transformers", return_tensors="pt")

# 使用模型进行实体预测

outputs = model(**inputs)

predictions = torch.argmax(outputs.logits, dim=2)

# 输出预测结果

predicted_entities = [label.item() for label in predictions]

```

### 2.3 实体抽取模型的评估指标

#### 2.3.1 精确度、召回率与F1分数

在实体抽取任务中,我们通常使用精确度(Precision)、召回率(Recall)和F1分数来评估模型的性能。精确度是正确抽取的实体数量与抽取实体总数的比率;召回率是正确抽取的实体数量与实际应抽取的实体总数的比率;F1分数是精确度和召回率的调和平均,用于平衡二者。

- **精确度** (P) = True Positives / (True Positives + False Positives)

- **召回率** (R) = True Positives / (True Positives + False Negatives)

- **F1分数** = 2 * P * R / (P + R)

其中,真阳性(True Positives)表示正确抽取的实体,假阳性(False Positives)表示错误抽取的实体,假阴性(False Negatives)表示漏掉的实体。

#### 2.3.2 实体对齐与链接的准确性

在实体抽取的基础上,实体对齐(Entity Alignment)和实体链接(Entity Linking)是进一步提升实体抽取准确性的关键技术。实体对齐是指在不同数据源中识别相同实体的过程;实体链接则是将抽取的实体与知识库中已有的实体进行匹配,实现实体的规范化和知识的关联。

评估实体对齐和链接的准确性通常涉及到实体在不同文本或知识库中的覆盖度、匹配度和一致性度量。

在下一章节中,我们将探讨如何在实体抽取的实践中应用这些理论知识,以及如何通过具体的技术手段提升实体抽取的准确性。

# 3. 提升实体抽取准确性的实践技巧

## 3.1 数据预处理与特征工程

实体抽取技术的有效性很大程度上取决于数据的质量和特征工程的深度。在本章节中,我们将深入探讨数据预处理与特征工程的重要性以及实施方法。

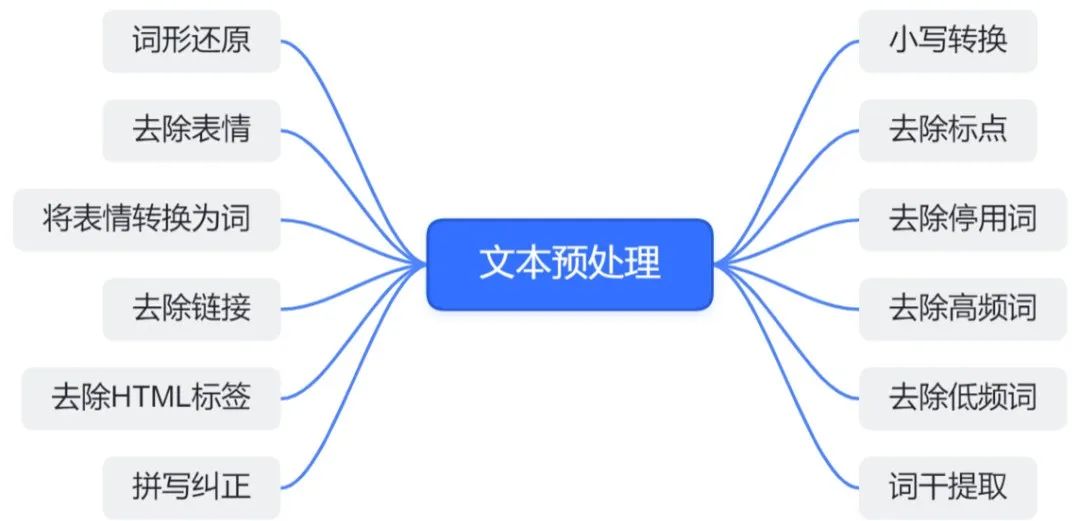

### 3.1.1 数据清洗与格式统一

数据清洗是实体抽取前的重要步骤。原始数据通常包含大量噪声,例如标点符号、非标准格式、重复数据等。通过清洗,可以显著提高数据质量,为后续的特征提取和模型训练奠定基础。

**数据清洗的关键步骤:**

1. **去除无关字符和标点**:通过正则表达式删除文本中的特殊符号,只保留对实体抽取有意义的信息。

2. **纠正拼写错误**:使用拼写检查算法或字典进行纠正。

3. **统一命名实体的格式**:对于专有名词和机构名等需要统一格式,如首字母大写或统一全小写等。

4. **去重**:确保数据集中不包含重复的记录。

**示例代码:**

```python

import re

import nltk

# 示例文本

text = "Dr. John Smith went to Harvard University, it's a great place!"

# 去除标点符号

text = re.sub(r'[^\w\s]', '', text)

# 将所有字母转换为小写

text = text.lower()

# 输出处理后的文本

print(text)

```

**逻辑分析:**

上述代码展示了如何使用正则表达式去除文本中的标点符号,并将所有字母转换为小写以统一格式。这只是数据清洗中的一个简单示例,实际应用中清洗工作可能需要更复杂的逻辑和算法。

### 3.1.2 特征提取与向量化方法

特征提取将文本数据转换为模型可以处理的数值形式。常见的向量化方法有词袋模型(BOW)、TF-IDF、Word2Vec等。

**词袋模型(Bag of Words,BOW

0

0