提升深度学习效率:PyTorch分布式训练技巧与案例分析

发布时间: 2024-12-12 05:49:07 阅读量: 11 订阅数: 15

【源代码】深度学习入门:基于Python的理论与实现.zip

# 1. PyTorch分布式训练概述

在当前的大数据时代,深度学习模型变得越来越复杂,单机计算资源已经难以满足大规模数据处理的需求。PyTorch分布式训练作为解决这一问题的重要手段,已经开始在IT行业和相关行业中受到广泛关注。

## 1.1 PyTorch分布式训练的含义与优势

PyTorch分布式训练是指利用多台计算机共同参与模型的训练过程,能够显著提高模型的训练速度和处理大规模数据的能力。通过分布式训练,我们可以在更短的时间内得到更准确的模型,这对于需要处理海量数据的AI应用,如图像识别、自然语言处理等场景,具有重要的意义。

## 1.2 PyTorch分布式训练的应用场景

分布式训练在多个领域都有广泛的应用,例如在自动驾驶、金融科技、智能医疗等领域。在这些领域,数据量大,模型复杂,单机训练不仅耗时长,而且很难达到理想的效果。而分布式训练则可以有效地解决这些问题,使得模型训练更加高效、精确。

## 1.3 PyTorch分布式训练的挑战与解决方案

尽管分布式训练具有许多优势,但其在实际应用中也存在一些挑战。例如,如何有效地进行通信、如何同步数据、如何处理硬件异构等问题。针对这些问题,PyTorch提供了许多解决方案,例如使用DataParallel或DistributedDataParallel进行数据并行处理,以及使用NCCL等库进行高效的通信。在后续章节中,我们将详细介绍这些解决方案。

# 2. 分布式训练的理论基础

在这一章中,我们将深入探讨分布式训练的理论基础,为后续章节中的实践操作提供坚实的理论支撑。分布式训练是机器学习模型训练的一种方式,它通过在多个计算设备之间分配任务来提高训练速度和处理大规模数据集的能力。本章将从分布式训练的基本概念开始,进而分析硬件与软件环境的配置,最后深入讲解分布式训练的通信机制。

## 2.1 分布式训练的基本概念

### 2.1.1 什么是分布式训练

分布式训练是一种将模型训练过程分散到多个计算设备上的方法。这种方法的优点在于可以利用并行计算来加速模型的训练过程,尤其适用于大规模数据集和复杂模型的训练。与传统的单机训练相比,分布式训练可以显著提高计算资源的使用效率和训练速度。

### 2.1.2 分布式训练与单机训练的对比

在单机训练模式中,所有的计算任务都在一个计算节点上完成,这在处理大型数据集或复杂模型时往往会造成单个节点资源的瓶颈。相比之下,分布式训练将任务分配到多个计算节点,通过并行处理数据和梯度更新,有效地扩展了计算能力。

## 2.2 分布式训练的硬件与软件环境

### 2.2.1 硬件架构与选择

分布式训练的硬件架构通常包括CPU和GPU两种主要类型。CPU适用于处理复杂逻辑和控制任务,而GPU则是高度优化的并行处理单元,特别适合执行大规模的数学运算和矩阵计算。在选择硬件时,需要考虑成本、可用性以及特定任务的需求。

### 2.2.2 分布式训练软件框架与工具

分布式训练需要依赖一系列的软件框架和工具来实现。目前主流的深度学习框架如PyTorch和TensorFlow都支持分布式训练,并提供了相应的API。此外,还有一些专用的工具如NCCL(NVIDIA Collective Communications Library)被用于优化GPU之间的通信效率。

## 2.3 分布式训练的通信机制

### 2.3.1 参数服务器模型

参数服务器模型是分布式训练中的一种常见通信机制。在这种模型下,存在一组专门用于存储模型参数的服务器(参数服务器),而训练过程则在多个工作节点上进行。每个工作节点会定期从参数服务器拉取最新的参数,并在本地执行计算任务后将更新的梯度推送回参数服务器。

### 2.3.2 全局梯度同步策略

全局梯度同步策略是另一种重要的通信机制,它保证了所有工作节点在进行参数更新前都同步了全局梯度。这通常通过诸如Ring-AllReduce等算法实现,该算法通过高效的数据交换策略确保梯度信息在所有节点间均匀同步。

接下来的章节,我们将以PyTorch为例,详细介绍如何在实际操作中应用分布式训练的基本原理,以及如何针对具体的训练任务进行分布式系统的搭建和优化。

# 3. PyTorch分布式训练实践操作

分布式训练不仅在理论上具有其独特的魅力,更在实际操作中显示出了强大的计算能力。接下来,我们将深入了解如何在PyTorch中实践分布式训练,包括安装配置、核心API的使用,以及调试技巧。在本章中,我们将逐一探讨PyTorch分布式训练的各个实践环节。

## 3.1 PyTorch分布式训练的安装与配置

分布式训练的安装和配置是启动一切训练活动的基础。对于初学者来说,这一步骤看似简单,却蕴含着许多潜在的问题和挑战。正确地安装和配置分布式训练环境,是保证后续步骤顺利进行的关键。

### 3.1.1 环境搭建步骤

安装PyTorch的分布式组件需要遵循一系列明确的步骤,这些步骤会根据不同的操作系统、硬件配置以及网络环境有所不同。以下是搭建环境的一般步骤:

1. **安装Python和PyTorch**

首先确保Python环境已经安装好,并且安装了对应版本的PyTorch。可以通过PyTorch官网提供的安装脚本进行安装,确保安装了与CUDA相对应的PyTorch版本。

```bash

pip install torch torchvision torchaudio

```

2. **安装分布式训练依赖**

根据是否使用GPU,安装NCCL库(NVIDIA Collective Communications Library),这是NVIDIA GPU间通信的基础库。

```bash

conda install -c conda-forge nccl

```

3. **设置环境变量**

如果在多个计算节点之间进行分布式训练,需要设置适当的环境变量,如MASTER_ADDR和MASTER_PORT,这些环境变量用于定义通信的主节点地址和端口。

```bash

export MASTER_ADDR="127.0.0.1" # 或者其他主节点的IP地址

export MASTER_PORT=29500

```

4. **分布式训练模式验证**

使用PyTorch提供的API检查分布式环境是否设置正确。

```python

import torch.distributed as dist

def run_rank(rank, size):

# 初始化分布式环境

dist.init_process_group("nccl", rank=rank, world_size=size)

# 打印当前进程的rank

print(f"Running on rank {rank}")

if __name__ == "__main__":

size = 2 # 假设使用两个进程

run_rank(0, size)

run_rank(1, size)

```

### 3.1.2 配置检查与验证

在安装与配置完成后,必须进行一系列的检查来确保分布式训练环境搭建成功。这个步骤包括但不限于:

- **检查通信是否正常**:通过运行简单的分布式程序来测试各个进程之间的通信是否正常工作。

- **验证分布式执行环境**:在多个GPU卡上分别运行程序,确保所有进程可以正常连接和数据同步。

## 3.2 PyTorch分布式训练的核心API使用

在安装配置无误之后,下一步是掌握PyTorch分布式训练的核心API,并学会构建分布式环境下的数据加载器、模型以及优化器。

### 3.2.1 初始化分布式环境

初始化分布式环境是实现分布式训练的首要步骤。这一过程涉及到分布式进程组的创建以及各个进程之间的通信初始化。

```python

import torch.distributed as dist

import os

def init_process(rank, size, fn, backend='nccl'):

os.environ['MASTER_ADDR'] = '127.0.0.1'

os.environ['MASTER_PORT'] = '29500'

dist.init_process_group(backend, rank=rank, world_size=size)

fn(rank, size)

```

### 3.2.2 分布式数据加载器的构建

分布式数据加载器的构建对于高效的分布式训练至关重要,它需要能够均匀地分配数据到各个计算节点上。

```python

import torch.utils.data

from torch.utils.data.distributed import DistributedSampler

def train(rank, size):

# 创建分布式采样器

sampler = DistributedSampler(dataset, num_replicas=size, rank=rank)

loader = torch.utils.data.DataLoader(dataset, batch_size=32, sampler=sampler)

# 训练循环

for epoch in range(num_epochs):

sampler.set_epoch(epoch)

for data, label in loader:

# 训练步骤...

pass

```

### 3.2.3 模型、数据和优化器的分布式应用

当数据加载器准备就绪,我们需要构建并分布模型、数据以及优化器。这个过程涉及到对模型和优化器进行包装,使其能够适应分布式训练的需要。

```python

def run(rank, size):

# 初始化分布式环境

init_process(rank, size, train)

```

## 3.3 PyTorch分布式训练的调试技巧

调试分布式训练是一个复杂的过程。有效的调试可以减少浪费在反复尝试和错误上的时间。在本节中,我们将讨论一些常用的调试技巧和工具。

### 3.3.1 日志记录与错误排查

日志记录是分布式系统中非常重要的调试工具。在PyTorch中,可以通过设置日志级别来跟踪程序运行的详细信息。

```python

import logging

def setup_logging(rank):

logging.basicConfig(

level=logging.DEBUG if rank == 0 else logging.ERROR,

format='%(asctime)s - %(name)s - %(levelname)s - %(message)s'

)

setup_logging(rank)

```

### 3.3.2 性能监控与瓶颈定位

性能监控和瓶颈定位对于优化分布式训练至关重要。PyTorch提供了一些工具来帮助开发者监控训练过程中的性能瓶颈。

```python

import torch.distributed as dist

from datetime import datetime

def monitor_performance(rank, size):

# 使用torch.distributed的一些API来进行性能监控

if rank == 0:

while True:

current_time = datetime.now().strftime("%Y-%m-%d %H:%M:%S")

dist.barrier()

if rank == 0:

print(f"[{current_time}] Performance monitoring...")

dist.barrier()

```

通过以上章节的实践操作介绍,你已经掌握了PyTorch分布式训练的基本搭建、核心API的使用以及调试技巧。这些内容将为你进一步深入学习分布式训练打下坚实的基础。在接下来的章节中,我们将通过案例分析进一步探索PyTorch分布式训练的应用,并探究优化策略以提高训练效率。

# 4. PyTorch分布式训练案例分析

## 4.1 单机多GPU训练案例

### 4.1.1 案例背景与需求

在深度学习任务中,单机多GPU训练是一种常见的训练方式,它通过充分利用单个计算节点上的多个GPU来加速模型训练过程。这种方式特别适合数据量和模型大小适中的场景,因为它可以显著减少训练时间,同时避免了分布式训练中通信开销的问题。

本案例将演示如何在单台服务器上使用PyTorch进行多GPU训练,并且详细解析实现过程。我们使用的模型是ResNet,这在图像识别任务中非常常见。我们将展示如何在PyTorch中设置多GPU环境,并将一个ResNet模型部署到多个GPU上。

### 4.1.2 实现过程与代码解析

首先,我们确保PyTorch可以检测到服务器上的所有GPU设备。

```python

import torch

# 获取可用的GPU数量

print("Available GPUs: ", torch.cuda.device_count())

# 将模型放入GPU中

device = torch.device("cuda:0" if torch.cuda.is_available() else "cpu")

```

接下来,我们需要定义一个可以跨多个GPU并行工作的模型。在PyTorch中,我们可以通过`torch.nn.DataParallel`类轻松实现这一点。以下是如何修改模型以支持多个GPU。

```python

# 假设我们有一个标准的ResNet模型

# ...

# 包装模型以支持多GPU

model = torch.nn.DataParallel(model).to(device)

```

在训练过程中,我们需要创建一个`torch.utils.data.DataLoader`来提供数据,同时确保它在多个进程中正确加载数据。

```python

# 创建数据加载器

train_loader = torch.utils.data.DataLoader(train_dataset, batch_size=batch_size, shuffle=True, num_workers=num_workers)

```

在训练循环中,我们要确保模型在训练时使用`.train()`模式,同时在每个epoch开始之前,调用`.to(device)`将数据转移到正确的设备上。

```python

for epoch in range(num_epochs):

# 设置模型为训练模式

model.train()

for data in train_loader:

inputs, labels = data[0].to(device), data[1].to(device)

# 梯度归零

optimizer.zero_grad()

# 前向传播

outputs = model(inputs)

# 计算损失

loss = criterion(outputs, labels)

# 反向传播

loss.backward()

# 更新参数

optimizer.step()

print(f'Epoch {epoch+1}/{num_epochs}, Loss: {loss.item()}')

```

执行上述代码后,ResNet模型将在多个GPU上并行训练,每个GPU处理输入数据的一部分,并计算损失和梯度。模型权重的更新会在所有GPU中同步进行,因此每个GPU上模型的状态都会保持一致。

## 4.2 多机多GPU训练案例

### 4.2.1 案例背景与需求

多机多GPU训练涉及在多台计算机上同时运行模型训练任务,这通常用于需要极大规模计算资源的情况。在多机训练中,节点间需要进行高效的参数同步和数据交换,这需要专门的通信协议和策略。

本案例将介绍如何设置一个简单的多机多GPU训练环境,并通过PyTorch的`torch.nn.parallel.DistributedDataParallel`类实现。我们将使用两个节点来展示整个过程。

### 4.2.2 实现过程与代码解析

在开始之前,必须配置好每个节点的环境,并确保它们之间可以通过SSH互相通信。在每个节点上,我们使用`torch.distributed.init_process_group`初始化进程组。

```python

import torch.distributed as dist

import torch.multiprocessing as mp

def setup(rank, world_size):

# 初始化进程组

dist.init_process_group("nccl", rank=rank, world_size=world_size)

def cleanup():

dist.destroy_process_group()

if __name__ == "__main__":

world_size = 2 # 假设有两个节点参与

mp.spawn(setup, args=(world_size,), nprocs=world_size, join=True)

```

在初始化了进程组后,我们可以像单机训练一样构建模型,但需要使用`DistributedDataParallel`来替代`DataParallel`。

```python

model = TheModelClass(*args, **kwargs).to(device)

ddp_model = torch.nn.parallel.DistributedDataParallel(model, device_ids=[device])

```

随后的训练过程类似于单机训练,但需要注意的是,由于涉及多进程,每个进程应该有自己的数据加载器和数据批处理。

```python

for epoch in range(num_epochs):

# 设置模型为训练模式

ddp_model.train()

# 分发数据

for data in train_loader:

inputs, labels = data[0].to(device), data[1].to(device)

# 梯度归零

optimizer.zero_grad()

# 前向传播

outputs = ddp_model(inputs)

# 计算损失

loss = criterion(outputs, labels)

# 反向传播和优化步骤

loss.backward()

optimizer.step()

print(f'Epoch {epoch+1}/{num_epochs}, Loss: {loss.item()}')

```

最后,清理进程组。

```python

cleanup()

```

在进行多机训练时,需要注意的是,多GPU之间的通信开销可能成为瓶颈。因此,合理地分配数据和负载,以及使用高效的通信协议(如NCCL)是至关重要的。

## 4.3 分布式训练中的优化策略

### 4.3.1 数据并行与模型并行的区别与应用

数据并行(Data Parallelism)和模型并行(Model Parallelism)是分布式训练中两种主要的并行策略。数据并行涉及在多个GPU上复制相同模型,然后将数据划分到这些GPU上进行训练。这种方法适用于模型大小适中,数据集较大的情况。

```python

# 数据并行示例

model = torch.nn.DataParallel(model).to(device)

```

模型并行则将不同的模型部分分配到不同的GPU上。这适用于模型非常庞大,单个GPU无法容纳的情况。需要注意的是,模型并行会引入额外的通信开销,因为不同部分的模型需要交换信息。

```python

# 模型并行示例(假设模型可以被分割)

model = torch.nn.Sequential(

model_part1.to(device),

model_part2.to(device)

)

```

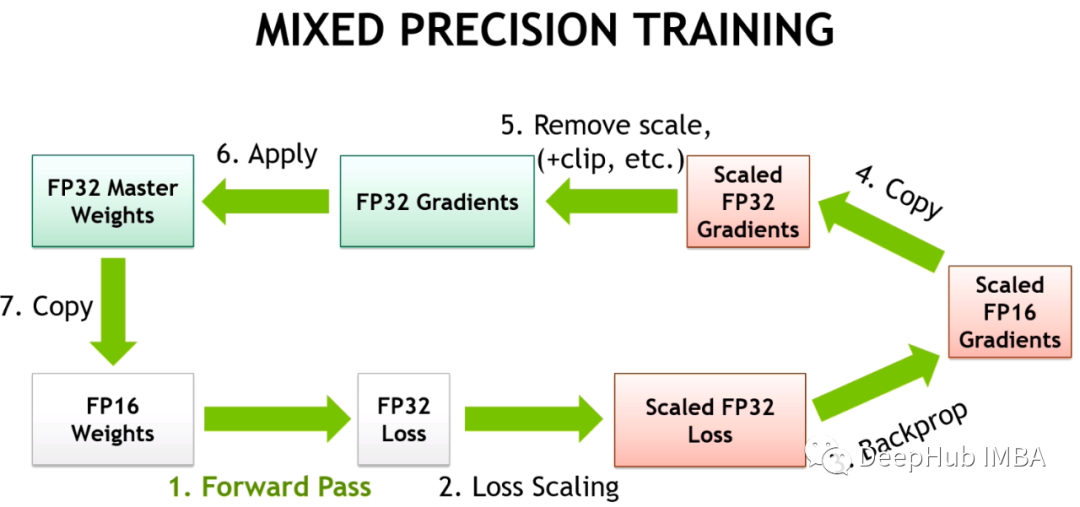

### 4.3.2 梯度累积与混合精度训练

梯度累积是处理内存限制的策略之一,它通过多次前向和反向传播,但只在一定次数后执行一次优化步骤。这样,模型可以在每个GPU上处理更大的批量大小,但总体上仅使用了有限的内存。

```python

# 梯度累积示例

accumulation_steps = 4

for i, data in enumerate(train_loader):

# 前向和反向传播

outputs = model(data)

loss = criterion(outputs, labels)

loss.backward()

# 每经过多个步骤后进行一次优化

if (i + 1) % accumulation_steps == 0:

optimizer.step()

optimizer.zero_grad()

```

混合精度训练则结合了单精度(32位)和半精度(16位)浮点数,以此来减少内存占用,加快计算速度。在PyTorch中,可以使用`torch.cuda.amp`模块来实现自动混合精度训练。

```python

from torch.cuda.amp import autocast

# 混合精度训练示例

scaler = torch.cuda.amp.GradScaler()

for data in train_loader:

with autocast():

outputs = model(data)

loss = criterion(outputs, labels)

# 梯度缩放

scaler.scale(loss).backward()

scaler.step(optimizer)

scaler.update()

```

通过这些优化策略,分布式训练不仅能够更有效地利用硬件资源,还能在有限的资源条件下提高模型训练的速度和质量。

# 5. PyTorch分布式训练的高级应用

分布式训练技术在深度学习领域已变得至关重要,特别是随着模型和数据集规模的不断扩大,单机训练已经无法满足训练效率的需求。PyTorch作为一个流行且具有高度灵活性的深度学习框架,不断推陈出新,提供了更多高级功能以支持复杂的分布式训练场景。本章节将深入探讨PyTorch分布式训练的高级应用,包括自定义分布式组件和异构计算资源的分布式训练。

## 5.1 自定义分布式组件

在一些高级的分布式训练场景中,可能需要自定义分布式组件以满足特定需求。例如,当标准的分布式操作不能满足特定算法或优化策略时,自定义的通信操作、优化器和调度策略可能成为必要。下面,我们将深入了解自定义这些组件的基本步骤与原理。

### 5.1.1 自定义通信操作

分布式训练中,不同的节点之间需要频繁地交换信息,如梯度更新、模型参数等。PyTorch通过`torch.distributed`模块提供了一系列的基础通信操作,但对于一些特定的算法,可能需要更复杂的通信模式。

```python

import torch

import torch.distributed as dist

def all_gather(tensor_list, tensor):

world_size = dist.get_world_size()

rank = dist.get_rank()

tensor_list[rank] = tensor

dist.all_gather(tensor_list)

# 使用示例

tensor_list = [None] * dist.get_world_size()

input_tensor = torch.tensor([rank], device='cuda')

all_gather(tensor_list, input_tensor)

print(tensor_list)

```

在上面的示例中,我们定义了一个`all_gather`函数,该函数将不同进程中的张量收集到一个列表中,每个进程都会获得这个列表的副本。这是通过`torch.distributed.all_gather`函数实现的,我们在此基础上增加了一些封装以便于使用。

### 5.1.2 自定义优化器和调度策略

在训练过程中,通常使用各种优化器来更新模型的权重。在分布式训练场景中,可能需要根据数据分布或硬件性能对优化器的行为进行定制化。

```python

class CustomOptimizer(torch.optim.Optimizer):

def __init__(self, params, lr=1e-3):

super(CustomOptimizer, self).__init__(params, dict())

self.lr = lr

def step(self, closure=None):

for group in self.param_groups:

for p in group['params']:

if p.grad is not None:

# Custom gradient update logic

p.data.add_(p.grad.data, alpha=-self.lr)

# 使用示例

optimizer = CustomOptimizer(model.parameters())

optimizer.step()

```

在这个例子中,我们创建了一个`CustomOptimizer`类,它实现了标准优化器的基本步骤,但是自定义了梯度更新的逻辑。通过继承`torch.optim.Optimizer`并重写`step`方法,可以实现这一高级功能。

## 5.2 异构计算资源的分布式训练

随着计算资源的多样性发展,使用不同类型的计算资源进行分布式训练成为了可能和需要。例如,GPU和CPU的混合使用、不同类型GPU(如NVIDIA GPU和AMD GPU)的结合使用,都属于异构计算资源的范畴。本节将探讨如何管理和利用异构计算资源进行有效的分布式训练。

### 5.2.1 利用异构计算资源的优势

异构计算资源意味着不同的计算节点可能具有不同的计算能力。合理利用这些资源可以显著提高训练效率和成本效益。

例如,在具有GPU和CPU的系统中,可以将数据加载和预处理任务分配给CPU,而将密集型计算任务交给GPU。通过合理分配工作负载,可以最大化每个计算资源的利用率。

```mermaid

graph TD

A[开始训练] --> B{资源类型检测}

B --> |检测到GPU| C[分配GPU任务]

B --> |检测到CPU| D[分配CPU任务]

C --> E[GPU任务执行]

D --> F[CPU任务执行]

E --> G[GPU资源等待]

F --> H[CPU资源等待]

G --> I[任务汇总]

H --> I

I --> J[训练进度更新]

J --> K[训练完成]

```

### 5.2.2 管理不同类型的计算设备

管理异构资源的难点在于如何有效地调度和同步不同类型的计算设备。例如,当一个作业在CPU上执行完毕,它可能需要通知GPU节点进行下一步的计算。在PyTorch中,可以使用`torch.distributed`模块来协调不同设备之间的通信。

```python

import torch.multiprocessing as mp

def worker(rank, world_size):

# 初始化分布式环境

dist.init_process_group('nccl', rank=rank, world_size=world_size)

# 假设每个进程都有自己的模型副本和数据副本

model = MyModel().cuda()

optimizer = CustomOptimizer(model.parameters())

# 进行训练

for epoch in range(num_epochs):

# 模型训练代码

# ...

# 同步不同节点的数据

dist.barrier()

# 清理分布式环境

dist.destroy_process_group()

# 使用多个进程运行

mp.spawn(worker, args=(world_size,), nprocs=world_size, join=True)

```

在上述代码中,我们使用了`torch.multiprocessing`模块启动了多个进程,每个进程在分布式环境下运行。通过`torch.distributed.barrier`函数确保所有进程在继续执行之前达到某一点,这有助于同步不同设备上的计算状态。

至此,我们已经探索了PyTorch分布式训练的高级应用,包括自定义分布式组件和异构计算资源的管理。这些高级技术的掌握对于深度学习的从业者来说是一个巨大的优势,它使得我们可以更加灵活高效地应对复杂的分布式训练挑战。接下来的第六章将展望分布式训练的未来趋势,并给出最佳实践建议。

# 6. PyTorch分布式训练的未来展望

分布式训练技术经过数年的发展,已在深度学习领域中占据了一席之地。随着硬件性能的提升、算法的创新以及软件生态的完善,分布式训练未来的发展将会更加多样化和专业化。

## 6.1 分布式训练技术的发展趋势

随着计算需求的日益增长,分布式训练技术正变得越来越重要。不仅是传统的大规模数据中心,中小企业也逐步开始应用分布式训练以提升模型训练效率。

### 6.1.1 新兴算法对分布式训练的影响

新兴的算法和训练策略正在不断推动分布式训练技术的发展。例如,大规模语言模型的出现要求更高效的分布式训练策略,以处理数亿、甚至数千亿级别的参数。神经架构搜索(NAS)等自动化算法也对分布式计算资源提出了更高要求。

### 6.1.2 分布式训练的软件生态进展

软件层面,分布式训练框架与工具也在持续进化。PyTorch、TensorFlow等主流框架不断更新,以支持更灵活的分布式训练模式。例如,PyTorch的`torch.distributed`模块持续增加新功能,并优化其性能,使其更适合大规模分布式训练任务。

## 6.2 分布式训练的最佳实践建议

分布式训练并不总是灵丹妙药,正确的实施策略是提升训练效率和模型效果的关键。

### 6.2.1 架构设计与性能考量

设计一个高效的分布式训练架构需要考虑多个因素,包括但不限于数据传输的效率、计算资源的优化利用以及容错机制的设计。性能考量不仅仅是计算速度,也包括内存使用、网络通信的开销以及能耗效率。

### 6.2.2 安全性与可扩展性建议

安全性是分布式训练不可忽视的一面。数据传输加密、访问控制以及设备认证等方面是保障训练安全的重要措施。同时,随着业务的扩展,分布式训练系统应当具备良好的可扩展性,能够无缝对接新硬件、支持更多种类的训练任务。

综上所述,随着深度学习领域日新月异的进步,分布式训练技术将继续快速发展,不仅对硬件设备和网络架构提出更高的要求,也对开发人员和数据科学家在设计和实施分布式训练时的能力提出了挑战。通过不断的研究和实践,我们将能够更高效地利用分布式训练,推动AI技术迈向更高的台阶。

0

0