小批量数据训练加速:PyTorch分布式训练策略与案例分析

发布时间: 2024-12-12 06:41:09 阅读量: 13 订阅数: 15

PyTorch Elastic :PyTorch分布式训练框架-python

# 1. 分布式训练的基本概念和原理

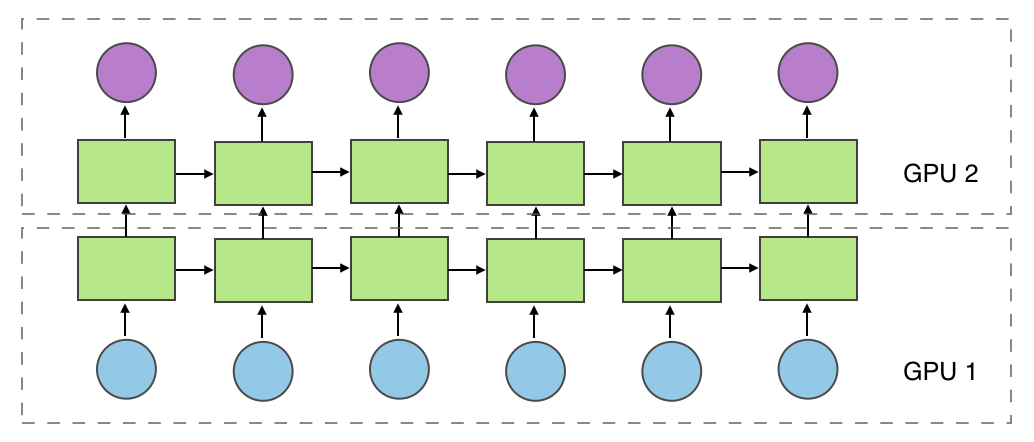

分布式训练是一种将单个模型训练任务分散到多个计算节点上执行的技术,旨在提升大规模数据集的处理效率和模型训练速度。分布式训练能够有效利用多节点的计算能力,突破单节点硬件性能的限制。本章将介绍分布式训练的基本原理,包括数据并行、模型并行、混合并行等主要策略及其核心概念。数据并行通过分割数据集到多个节点并同时处理,而模型并行则通过将模型的不同部分分配到不同的计算节点来实现。了解这些原理将为深入学习分布式训练的具体技术细节奠定坚实的基础。

# 2. PyTorch分布式训练技术细节

## 2.1 PyTorch中的进程组和通信基础

### 2.1.1 进程组的初始化和配置

PyTorch的分布式训练功能依赖于进程组的概念。进程组是跨多个计算节点分布模型计算的基本单位。初始化和配置进程组涉及设置环境以支持节点间的通信和同步。以下是一个基本的示例,展示了如何使用PyTorch中的`torch.distributed`模块初始化一个进程组。

```python

import torch.distributed as dist

# 初始化进程组

def initialize_process_group(backend, init_method):

world_size = int(os.environ['WORLD_SIZE'])

rank = int(os.environ['RANK'])

dist.init_process_group(backend, init_method=init_method, rank=rank, world_size=world_size)

# 使用NCCL后端

initialize_process_group(backend='nccl', init_method='env://')

```

在这个例子中,`backend`参数指定了进程组通信所使用的后端,`init_method`提供了节点间通信的初始化方法。这里使用的是环境变量初始化方法,`env://`是默认的初始化方式。

### 2.1.2 同步和异步通信机制

PyTorch提供了两种通信机制:同步通信和异步通信。同步通信会在发送和接收数据之后进行确认,确保数据传输的完整性和准确性。异步通信则允许在确认之前继续进行计算,提高了通信效率,但可能会牺牲一定的数据一致性。

```python

# 同步通信示例

dist.send(tensor, dst=rank)

# 异步通信示例

req = dist.isend(tensor, dst=rank)

```

在同步通信中,`dist.send`会阻塞直到数据被发送到目标进程。而在异步通信中,`dist.isend`会立即返回一个请求对象,之后可以使用该对象检查传输是否完成。

## 2.2 PyTorch的分布式数据加载和处理

### 2.2.1 分布式数据加载器的设计与实现

为了在分布式环境中高效地加载数据,PyTorch提供了`DataLoader`类,该类可以通过`torch.utils.data`模块与`torch.nn.parallel.DistributedDataParallel`配合使用,实现分布式数据加载。

```python

from torch.utils.data import DataLoader, Dataset

from torch.nn.parallel import DistributedDataParallel as DDP

class MyDataset(Dataset):

def __init__(self):

# 初始化数据集

pass

def __getitem__(self, index):

# 获取索引对应的样本

pass

def __len__(self):

# 返回数据集的大小

pass

# 实例化数据集

dataset = MyDataset()

# 使用DistributedSampler实现分布式数据加载

sampler = torch.utils.data.distributed.DistributedSampler(

dataset, num_replicas=world_size, rank=rank)

data_loader = DataLoader(dataset, batch_size=batch_size, sampler=sampler)

# 包装模型以便并行运行

model = DDP(model)

for data in data_loader:

output = model(data)

```

在这里,`DistributedSampler`根据当前进程的`rank`和总的`world_size`来分配每个进程的数据子集。每个进程只会看到自己的数据子集,保证了数据处理的分布式特性。

### 2.2.2 数据并行处理策略

在PyTorch中,数据并行处理是通过`torch.nn.parallel.DistributedDataParallel`(简称DDP)实现的。DDP能够在多个GPU上分布数据和模型训练,以加快训练速度。

```python

# 示例:包装模型以便并行运行

model = torch.nn.parallel.DistributedDataParallel(model, device_ids=[local_rank], output_device=local_rank)

```

这里,`local_rank`表示每个节点上的GPU ID。DDP会在每个GPU上复制模型,并在每个GPU上独立执行前向和后向传播。然后它会在所有GPU上平均梯度,并在每个GPU上更新模型参数。

## 2.3 PyTorch的分布式优化算法

### 2.3.1 同步和异步优化算法概述

PyTorch支持两种主要的分布式优化算法:同步SGD和异步SGD。同步SGD在所有进程中同步执行梯度更新,而异步SGD允许进程之间在计算和通信方面有一定的重叠。

同步SGD适用于确保数据一致性,而异步SGD则可能因为梯度更新的不一致性而加速训练,但同时也可能增加模型收敛的不稳定性。选择合适的优化算法需要在性能和稳定性的权衡中做出决策。

### 2.3.2 损失函数和梯度累积处理

在分布式训练中,处理损失函数和梯度累积是一个重要环节。通过梯度累积,可以在每个迭代中累积多个小批量数据的梯度,然后一次性更新模型参数。

```python

# 损失函数计算

loss = criterion(output, target)

# 梯度累积处理

loss = loss / accumulation_steps

loss.backward()

if (batch_idx + 1) % accumulation_steps == 0:

optimizer.step()

optimizer.zero_grad()

```

这段代码展示了如何通过`accumulation_steps`来实现梯度累积。在每个小批量数据处理完毕后,损失值会被除以累积步数来模拟单个小批量数据的损失,然后执行反向传播和参数更新。

以上内容展示了PyTorch在分布式训练中的具体实现细节,包括进程组的初始化、数据加载器的设计、数据并行处理策略以及优化算法的实现。在本章中,我们深入探讨了如何利用PyTorch框架来构建和优化分布式训练流程,从而提升模型的训练效率和扩展性。

# 3. 小批量数据训练的挑战与策略

## 3.1 数据并行中的批大小问题

在分布式训练中,批大小(batch size)是一个关键的超参数,它对模型训练的性能和结果有着深远的影响。批大小的选择往往需要在内存限制、硬件资源和训练效率之间进行权衡。

### 3.1.1 小批量数据对模型性能的影响

当批大小过小时,模型可能无法获得足够的统计信息,从而难以捕捉数据中的模式。小批量训练可能会导致训练过程中的噪声增加,进而影响模型的收敛速度和最终性能。此外,小批量训练使得每一轮更新的梯度方向变得更加随机,可能导致优化算法需要更多的迭代次数才能找到好的解。

然而,小批量训练也具有其优势。由于每次更新的梯度变化较小,这有助于模型在训练过程中更稳定地学习,从而减少过拟合的风险,特别适用于数据量较少的情况。当数据集较小时,较小的批大小可以增加模型泛化能力。

### 3.1.2 调整批大小的策略和技巧

调整批大小需要综合考虑硬件资源、模型复杂性以及数据集的大小。以下是一些调整批大小的策略和技巧:

1. **从较小的批大小开始**:在缺乏经验的情况下,开始时使用较小的批大小可以帮助监控训练过程中是否出现过拟合现象。

2. **根据硬件资源动态调整**:如果GPU内存足够,可以逐步增加批大小。同时,应观察训练过程中的GPU利用率,保持GPU高效工作。

3. **使用学习率预热**:开始训练时使用较小的学习率,然后随着训练的进行逐渐增加,有助于模型稳定地收敛。

4. **采用学习率衰减策略**:为了确保模型在不同批大小下都能收敛,可以结合使用学习率衰减技术。

5. **考虑使用批量归一化**:批量归一化(Batch Normalization)可以缓解小批量训练中的内部协变量偏移问题,对模型训练有正面影响。

6. **利用动态批大小**:动态调整每轮迭代的批大小,根据模型在训练过程中的表现,自适

0

0