NCCL通信库应用:PyTorch分布式训练中的性能提升技术

发布时间: 2024-12-12 06:44:24 阅读量: 12 订阅数: 15

bluefog:PyTorch over graph 的分布式和去中心化训练框架

# 1. NCCL通信库简介与分布式训练基础

## NCCL通信库简介

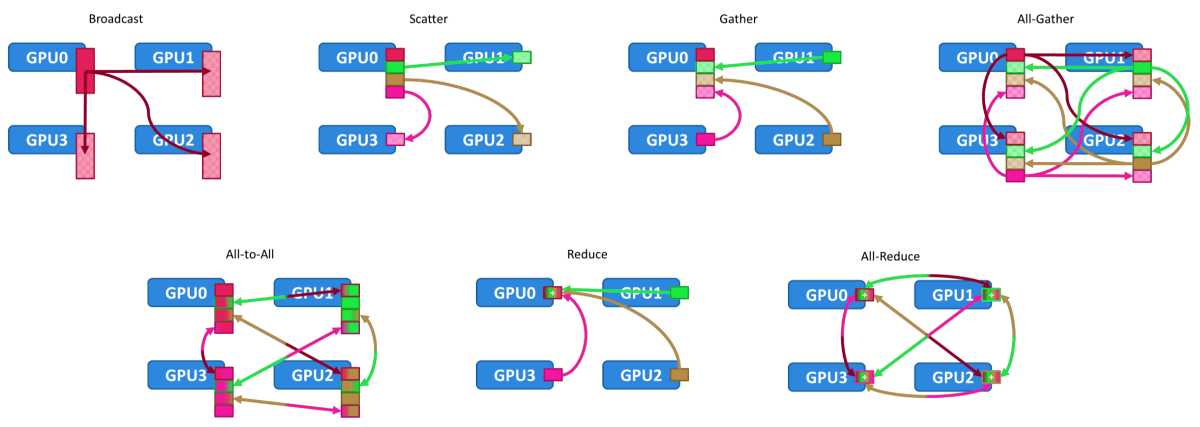

NCCL(NVIDIA Collective Communications Library)是专为NVIDIA GPU设计的高性能、可扩展、易于使用的多GPU集合通信库。它为深度学习框架提供了最优化的集合通信原语,支持点对点和集合通信操作,如归约、广播、All-Reduce、All-Gather等。借助于NVLink和GPU Direct RDMA技术,NCCL能够提供接近硬件极限的通信性能,是实现分布式GPU训练的关键组件。

## 分布式训练基础

分布式训练是一种使模型能够跨多个GPU或计算节点进行扩展的技术,它允许大规模并行处理,从而加快训练过程并处理更大的数据集。其基础依赖于数据的平行化、任务的分工以及模型参数的同步更新。在分布式训练中,NCCL作为一个底层通信库,能够有效地在各个GPU之间传输数据,确保所有节点能够高效协同工作,共同完成模型的训练任务。这一节将介绍分布式训练的基本概念、所需环境的搭建以及NCCL库在其中发挥的作用。

# 2. NCCL通信库核心机制解析

### 2.1 NCCL的基本操作和数据类型

#### 2.1.1 NCCL的数据类型和集合操作

NCCL(NVIDIA Collective Communications Library)是一个专注于GPU的库,它提供了一组高性能、易于使用的集合通信原语,使得多GPU上执行集合通信操作变得更加简单高效。这些集合操作包括但不限于点对点传输(allReduce, broadcast, reduce, allGather, gather, scatter等),支持的数据类型涵盖了基础数据类型(如float, double, int, long等)到自定义数据类型。

集合操作的原理基本上遵循以下步骤:

1. 初始化一个或多个通信操作,如`ncclAllReduce`。

2. 指定输入和输出缓冲区。

3. 指定操作数的数目和数据类型。

4. 执行集合操作。

5. 等待操作完成。

#### 2.1.2 NCCL初始化和组通信机制

NCCL在执行通信操作前,需要初始化,这是因为NCCL需要建立内部的通信上下文。初始化涉及到创建一个通信组(communicator),这是一个包含多个参与通信的GPU的逻辑单元。通信组一旦创建,就可以执行集合操作。

通信组的创建通常涉及到两个步骤:

1. 使用`ncclCommInitRank`初始化每个参与GPU的通信器,并分配一个唯一的rank ID。

2. 将所有参与GPU的通信器加入到一个组内。

下述是一个简单的代码示例,展示了如何初始化NCCL通信组:

```cpp

#include <nccl.h>

int main() {

int nranks = 8; // 假设有一个8卡的GPU环境

int myrank = 0; // 每个进程的rank ID

ncclComm_t comm;

ncclCommInitRank(&comm, nranks, nccl.collNet, myrank);

// ... 进行数据通信

ncclCommDestroy(comm); // 使用完毕后,销毁通信组

return 0;

}

```

### 2.2 NCCL与硬件加速的交互

#### 2.2.1 CUDA-Aware内存管理

CUDA-Aware内存管理允许直接在CUDA设备间传输数据,而不需要CPU的介入。这意味着,当数据已经在GPU内存中时,NCCL可以无需额外的复制操作即可执行传输。这大幅提高了通信效率,因为内存复制是GPU通信中的主要性能瓶颈之一。

CUDA-Aware内存管理的实现依赖于以下几个关键点:

- 使用`cudaMalloc`或类似操作直接分配在GPU上的内存。

- 在调用NCCL集合操作时,直接传递这些内存指针。

- 确保整个通信路径上的所有设备都启用CUDA-Aware特性。

```cpp

float* sendbuff, *recvbuff;

cudaMalloc(&sendbuff, size);

cudaMalloc(&recvbuff, size);

// 执行NCCL操作,传递GPU指针

ncclAllReduce(sendbuff, recvbuff, count, nccl::dtype::float32, nccl::op::Sum, comm, stream);

```

#### 2.2.2 GPU Direct RDMA和NVLink

GPU Direct RDMA和NVLink是两种针对GPU间通信的硬件加速技术。

GPU Direct RDMA能够允许直接从一个GPU的内存发送数据到另一台机器上的GPU内存,绕过CPU总线。这可以显著提升多节点GPU通信的效率。

NVLink是一种NVIDIA特有的高速GPU间互连技术,它可以提供比传统PCIe总线更高的带宽和更低的延迟,使单节点内GPU间通信更高效。

为了利用这些技术,NCCL在内部已经进行了优化,使得当它与支持这些技术的硬件配合时,可以自动获得性能提升。

### 2.3 NCCL在分布式训练中的性能优势

#### 2.3.1 同步与异步传输机制

NCCL支持同步和异步两种传输机制,使得用户可以根据具体的应用场景选择最合适的传输方式。

同步传输机制意味着在返回到调用线程之前,操作必须完成。这提供了直观的流程控制,但是可能会在通信时间较长时阻塞线程。

异步传输机制允许操作在后台执行,这样在执行通信的同时,可以继续进行计算或其他工作,从而更好地利用资源。

```cpp

// 同步操作

ncclAllReduce(sendbuff, recvbuff, count, nccl::dtype::float32, nccl::op::Sum, comm, nullptr);

// 异步操作

ncclAllReduce(sendbuff, recvbuff, count, nccl::dtype::float32, nccl::op::Sum, comm, stream);

```

在异步操作中,我们传递了一个CUDA流(stream),以便与其它CUDA操作进行时间上的协调。

#### 2.3.2 性能基准测试与案例分析

为了评估NCCL的性能,开发者们通常会执行基准测试,这包括对不同大小的数据,不同数量的GPU进行集合操作,并且测量操作的总时间。通过基准测试,可以明确NCCL在特定硬件上的性能表现,并与其他通信库进行比较。

在实际应用案例中,NCCL被广泛应用于深度学习模型的分布式训练。这些案例显示了NCCL如何通过减少通信时间来提升整体的训练速度,特别是在大规模模型和大数据集上。

为了提供实际的性能评估,下面是一个简单的基准测试代码示例,它可以用来测试不同大小的数据在不同数量GPU上的allReduce操作性能:

```cpp

// 假设有一个测试函数test_nccl_performance

void

```

0

0