Kafka消息队列实战:构建分布式系统

发布时间: 2024-07-12 23:15:27 阅读量: 49 订阅数: 21

分布式系统工程实战

# 1. Kafka消息队列概述**

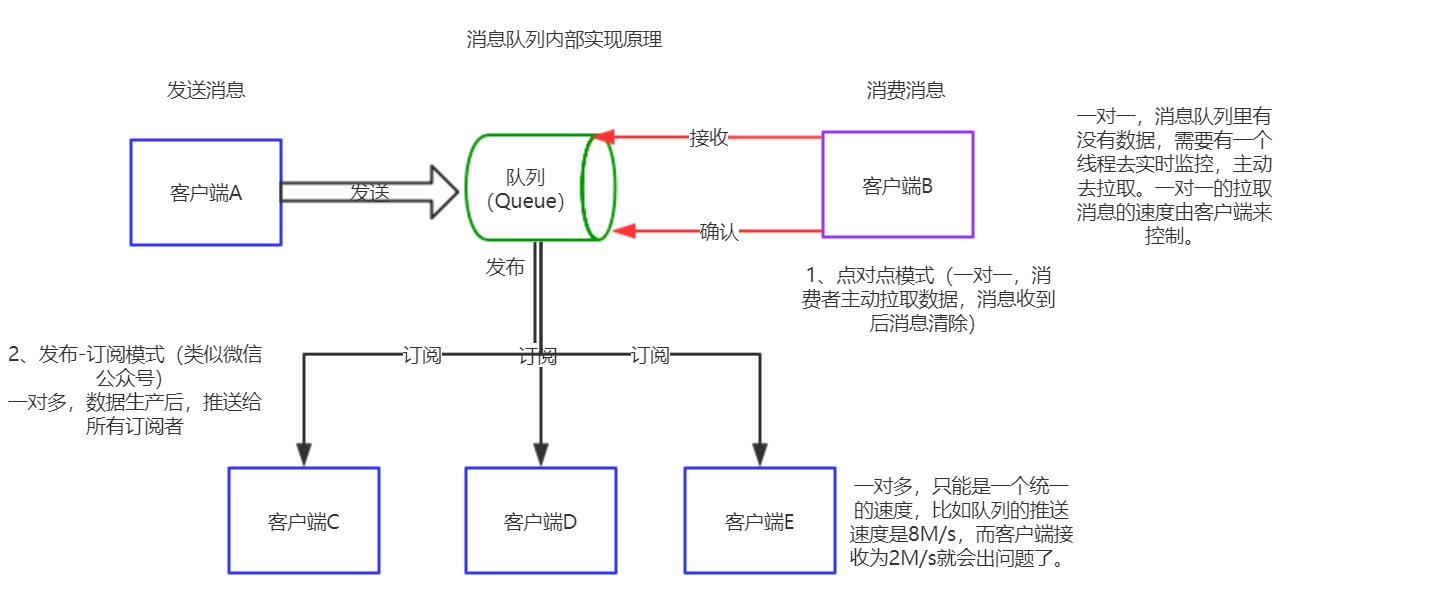

Apache Kafka是一种分布式、可扩展的消息队列系统,用于处理大规模数据流。它以其高吞吐量、低延迟和容错性而闻名,使其成为构建实时数据处理和流式应用程序的理想选择。

Kafka采用发布-订阅模式,其中消息生产者将消息发布到主题,而消息消费者订阅这些主题并接收消息。主题可以被分区,以提高吞吐量和可用性,并且消息以持久方式存储,确保数据不会丢失。

# 2. Kafka消息队列实践

### 2.1 Kafka集群的搭建和配置

#### 2.1.1 ZooKeeper的安装和配置

ZooKeeper是一个分布式协调服务,用于管理Kafka集群中的元数据和配置信息。要安装ZooKeeper,请执行以下步骤:

1. 下载ZooKeeper安装包并解压。

2. 创建一个名为`zookeeper`的用户和组。

3. 修改`conf/zoo.cfg`配置文件,设置`dataDir`和`clientPort`。

4. 启动ZooKeeper:`bin/zkServer.sh start`。

#### 2.1.2 Kafka Broker的安装和配置

Kafka Broker是负责存储和处理消息的服务器。要安装Kafka Broker,请执行以下步骤:

1. 下载Kafka安装包并解压。

2. 创建一个名为`kafka`的用户和组。

3. 修改`config/server.properties`配置文件,设置`broker.id`、`zookeeper.connect`和`log.dirs`。

4. 启动Kafka Broker:`bin/kafka-server-start.sh config/server.properties`。

#### 2.1.3 Kafka Topic的创建和管理

Topic是Kafka中存储消息的逻辑容器。要创建Topic,请使用以下命令:

```bash

bin/kafka-topics.sh --create --topic my-topic --partitions 3 --replication-factor 2

```

参数说明:

- `--create`:创建Topic。

- `--topic`:Topic名称。

- `--partitions`:分区数量。

- `--replication-factor`:副本数量。

要管理Topic,可以使用以下命令:

```bash

bin/kafka-topics.sh --list

bin/kafka-topics.sh --describe --topic my-topic

bin/kafka-topics.sh --delete --topic my-topic

```

### 2.2 消息生产者和消费者

#### 2.2.1 消息生产者的配置和使用

消息生产者用于向Kafka Topic发送消息。要配置消息生产者,请使用以下代码:

```java

Properties props = new Properties();

props.put("bootstrap.servers", "localhost:9092");

props.put("key.serializer", "org.apache.kafka.common.serialization.StringSerializer");

props.put("value.serializer", "org.apache.kafka.common.serialization.StringSerializer");

Producer<String, String> producer = new KafkaProducer<>(props);

// 发送消息

producer.send(new ProducerRecord<>("my-topic", "hello, world"));

// 关闭生产者

producer.close();

```

参数说明:

- `bootstrap.servers`:Kafka Broker的地址。

- `key.serializer`:键序列化器。

- `value.serializer`:值序列化器。

#### 2.2.2 消息消费者的配置和使用

消息消费者用于从Kafka Topic接收消息。要配置消息消费者,请使用以下代码:

```java

Properties props = new Properties();

props.put("bootstrap.servers", "localhost:9092");

props.put("group.id", "my-group");

props.put("key.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

props.put("value.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

Consumer<String, String> consumer = new KafkaConsumer<>(props);

// 订阅Topic

consumer.subscribe(Arrays.asList("my-topic"));

// 接收消息

while (true) {

ConsumerRecords<String, String> records = consumer.poll(100);

for (ConsumerRecord<String, String> record : records) {

System.out.println(record.key() + ": " + record.value());

}

}

// 关闭消费者

consumer.close();

```

参数说明:

- `bootstrap.servers`:Kafka Broker的地址。

- `group.id`:消费者组ID。

- `key.deserializer`:键反序列化器。

- `value.deserializer`:值反序列化器。

#### 2.2.3 消费者组和分区分配

消费者组是一个消费者集合,它们共同订阅一个或多个Topic。每个分区只能由一个消费者组中的一个消费者处理。Kafka使用轮询算法将分区分配给消费者。

为了确保负载均衡,Kafka会定期重新平衡消费者组。重新平衡过程涉及将分区从一个消费者转移到另一个消费者。

### 2.3 消息处理和持久化

#### 2.3.1 消息格式和编码

Kafka消息由键、值和元数据组成。键和值可以是任意二进制数据,但通常序列化为字符串或JSON。

Kafka支持多种编码格式,包括:

- **无编码**:消息不进行编码。

- **GZIP**:消息使用GZIP压缩。

- **Snappy**:消息使用Snappy压缩。

- **LZ4**:消息使用LZ4压缩。

#### 2.3.2 消息存储和持久化机制

Kafka将消息存储在称为分区的文件中。每个分区是一个顺序写入、只追加的日志。

为了确保数据持久性,Kafka将消息复制到多个Broker上。副本数量由`replication-factor`配置参数指定。

当消息被写入Kafka时,它会首先被写入领导分区。领导分区会将消息复制到所有副本分区。一旦所有副本分区都收到消息,消息就被认为已提交。

# 3. Kafka消息队列高级特性

### 3.1 流处理和数据管道

#### 3.1.1 Kafka Streams介绍和架构

Kafka Streams是一个用于构建流处理应用程序的库。它允许开发人员以简单、可扩展的方式处理和转换Kafka中的数据流。Kafka Streams基于以下架构:

- **流拓扑:**流处理应用程序的逻辑表示,由源、处理器和汇组成。

- **源:**从Kafka主题读取数据的组件。

- **处理器:**对数据流进行处理和转换的组件。

- **汇:**将处理后的数据写入Kafka主题的组件。

#### 3.1.2 流处理管道的设计和实现

设计Kafka Streams管道时,需要考虑以下步骤:

1. **定义源:**指定要读取数据的Kafka主题。

2. **创建处理器:**定义要对数据流执行的处理逻辑。

3. **设置汇:**指定要写入处理后数据的Kafka主题。

4. **启动管道:**启动流处理应用程序,开始处理数据流。

### 3.2 分区和复制

#### 3.2.1 Kafka分区策略和副本机制

分区是将数据分布到多个物理服务器的过程。Kafka使用以下分区策略:

- **哈希分区:**根据消息键对数据进行哈希,并将其分配到特定分区。

- **范围分区:**根据消息键的范围对数据进行分区。

复制是创建数据副本以提高可用性和容错性的过程。Kafka使用以下复制机制:

- **同步复制:**将数据副本同步写入所有副本。

- **异步复制:**将数据副本异步写入副本。

#### 3.2.2 分区和复制对性能和可用性的影响

分区和复制对Kafka的性能和可用性有以下影响:

- **性能:**分区可以提高性能,因为数据分布在多个服务器上。

- **可用性:**复制可以提高可用性,因为如果一个副本失败,其他副本仍然可用。

### 3.3 监控和管理

#### 3.3.1 Kafka监控指标和工具

Kafka提供了各种监控指标,用于监视集群的健康状况和性能。这些指标包括:

- **生产者和消费者指标:**测量消息生产和消费速率。

- **主题指标:**测量主题的大小和活动。

- **Broker指标:**测量Broker的健康状况和性能。

Kafka还提供了以下工具用于监控:

- **Kafka Manager:**一个Web界面,用于查看集群指标和管理主题。

- **JMX:**一种用于监视和管理Java应用程序的工具。

#### 3.3.2 Kafka集群的管理和维护

管理Kafka集群涉及以下任务:

- **创建和管理主题:**创建、删除和配置Kafka主题。

- **管理Broker:**添加和删除Broker,并管理其配置。

- **监控和故障排除:**使用监控工具监视集群,并解决任何问题。

- **备份和恢复:**备份Kafka数据并将其恢复到新集群。

# 4. Kafka消息队列在分布式系统中的应用

### 4.1 事件驱动架构和微服务

#### 4.1.1 事件驱动的系统设计

事件驱动的架构是一种软件设计模式,其中组件通过发布和订阅事件进行通信。事件是表示系统中发生的事情的轻量级消息。事件驱动架构具有以下优点:

- **松耦合:**组件之间通过事件进行通信,无需了解彼此的内部实现。这提高了系统的可维护性和可扩展性。

- **可扩展性:**事件驱动的系统可以轻松地通过添加或删除事件处理程序来扩展。

- **弹性:**事件驱动的系统通常具有内置的容错机制,可以处理事件丢失或处理程序故障。

#### 4.1.2 Kafka在微服务架构中的应用

Kafka是微服务架构中事件驱动的通信的理想选择。它提供了以下优势:

- **高吞吐量:**Kafka可以处理大量的事件,使其成为微服务之间通信的可靠平台。

- **低延迟:**Kafka提供低延迟消息传递,确保事件可以快速可靠地传递给处理程序。

- **可扩展性:**Kafka可以轻松地扩展以处理不断增长的事件负载。

- **容错性:**Kafka具有内置的容错机制,可以处理事件丢失或处理程序故障。

### 4.2 日志收集和分析

#### 4.2.1 Kafka作为日志收集平台

Kafka可以作为一个集中式日志收集平台,用于收集和存储来自不同应用程序和系统的日志消息。它提供了以下优势:

- **统一的日志存储:**Kafka将所有日志消息存储在一个集中式位置,便于搜索和分析。

- **可扩展性:**Kafka可以轻松地扩展以处理不断增长的日志负载。

- **持久性:**Kafka持久化所有日志消息,确保数据不会丢失。

#### 4.2.2 日志分析和数据挖掘

Kafka存储的日志消息可以用于各种分析和数据挖掘目的,包括:

- **故障排除:**日志消息可以帮助识别和诊断系统中的问题。

- **性能监控:**日志消息可以用于监控系统性能并识别瓶颈。

- **安全审计:**日志消息可以用于审计系统活动并检测安全威胁。

### 4.3 流式数据处理

#### 4.3.1 Kafka在流式数据处理中的作用

Kafka是流式数据处理的理想平台。它提供了以下优势:

- **实时数据处理:**Kafka可以实时处理流式数据,使应用程序能够对实时事件做出响应。

- **可扩展性:**Kafka可以轻松地扩展以处理不断增长的数据流。

- **容错性:**Kafka具有内置的容错机制,可以处理数据丢失或处理程序故障。

#### 4.3.2 实时数据分析和预测

Kafka存储的流式数据可以用于各种实时数据分析和预测目的,包括:

- **欺诈检测:**流式数据可以用于检测欺诈性交易或活动。

- **推荐引擎:**流式数据可以用于为用户提供个性化的推荐。

- **预测分析:**流式数据可以用于预测未来事件或趋势。

# 5.1 性能优化和故障处理

### 5.1.1 Kafka性能优化技巧

**优化生产者**

- 批量发送消息:通过将多个消息打包成一个批量发送,可以减少网络开销和提高吞吐量。

- 启用压缩:压缩消息可以减少网络带宽使用和存储空间占用。

- 使用异步生产者:异步生产者允许应用程序在不等待消息确认的情况下继续执行,从而提高吞吐量。

**优化消费者**

- 调优消费者组分配:确保每个消费者组均匀分配分区,以平衡负载。

- 启用批处理:批量处理消息可以减少网络开销和提高吞吐量。

- 使用多线程消费者:使用多线程消费者可以并行处理消息,提高吞吐量。

**优化Broker**

- 调优Broker配置:优化Broker配置,例如消息日志大小、清理策略和内存设置,可以提高性能。

- 使用SSD存储:使用SSD存储可以减少消息存储和检索的延迟。

- 优化网络配置:优化网络配置,例如TCP缓冲区大小和连接超时,可以提高网络吞吐量。

### 5.1.2 Kafka故障处理和容灾措施

**故障处理**

- 启用重试机制:配置生产者和消费者自动重试失败的消息,以提高可靠性。

- 使用幂等生产者:幂等生产者确保消息只被处理一次,即使发生故障。

- 监控和告警:监控Kafka集群并设置告警,以便在发生故障时及时采取措施。

**容灾措施**

- 启用副本:为每个分区创建多个副本,以确保数据冗余。

- 使用镜像Broker:在不同的物理位置部署镜像Broker,以实现高可用性。

- 使用灾难恢复计划:制定灾难恢复计划,以在发生灾难时恢复Kafka集群。

0

0