【Python data库与其他库的集成】:掌握data库与其他流行数据分析库的协同工作,让你的数据处理更强大

发布时间: 2024-10-15 18:37:43 阅读量: 30 订阅数: 40

# 1. Python data库概述

在Python的世界里,`data`库作为一个相对较新的成员,正逐渐被开发者所认识和使用。它是一个强大的数据处理库,旨在简化数据操作和分析的过程。本章节我们将概述`data`库的基本概念、设计理念以及它在现代数据分析中的重要性。

## Python data库基本概念

`data`库是为了解决传统数据处理工具在Python中的局限性而设计的。它提供了一种更直观、更高效的方式来处理和分析数据。与Pandas等库相比,`data`库在某些方面提供了更为简洁的API和更好的性能。

## 设计理念

该库的设计理念是将数据处理的核心操作抽象为简单易用的接口,同时保持高效的数据操作性能。它通过利用Python的高级特性,如装饰器和上下文管理器,使得代码既清晰又易于维护。

## 在数据分析中的重要性

在数据分析过程中,`data`库能够帮助用户快速导入、清洗、转换、分析数据,并且生成直观的报告。它的这些特性使得它在金融、生物信息学、机器学习等多个领域都有广泛的应用前景。

# 2. data库与Pandas的集成

在本章节中,我们将深入探讨如何将Python中的`data`库与`Pandas`集成,以及这种集成如何能够为数据分析和数据处理带来强大的功能。我们将首先从基本集成开始,逐步过渡到高级应用和性能优化。

## 2.1 data库与Pandas的基本集成

### 2.1.1 data库与Pandas的数据类型转换

在集成`data`库与`Pandas`时,首先需要了解两者之间的数据类型转换。`data`库提供了一种快速读取和处理数据的方式,而`Pandas`则是数据分析的利器。两者之间的数据类型转换,使得我们可以利用`data`库快速加载数据,然后使用`Pandas`进行高级分析。

```python

import data

import pandas as pd

# 假设data库中有一个数据集dataframe

dataframe = data.load('some_data')

# 将data库的数据集转换为Pandas的DataFrame

pandas_dataframe = pd.DataFrame(dataframe)

# 转换后的Pandas DataFrame可以进行进一步的分析和处理

```

在上述代码中,我们首先导入了`data`和`Pandas`库。通过`data.load`函数加载了一个数据集,并将其转换为`Pandas`的`DataFrame`对象。这种转换允许我们使用`Pandas`提供的丰富功能来进行数据清洗、转换和分析。

### 2.1.2 data库与Pandas的数据结构对接

`data`库与`Pandas`的数据结构对接,涉及到如何在两个库之间无缝地传递数据。这不仅仅是类型转换的问题,还包括如何在两个库之间共享数据结构,以提高数据处理的效率。

```python

# 使用data库读取数据

dataframe = data.load('another_data')

# 将数据传递给Pandas进行处理

pandas_series = pd.Series(dataframe['column_name'])

```

在这个例子中,我们展示了如何将`data`库中的数据集中的某一列直接传递给`Pandas`的`Series`对象。这样的操作非常高效,因为它避免了不必要的数据复制,同时也保持了数据结构的完整性。

## 2.2 data库与Pandas的高级应用

### 2.2.1 data库与Pandas的数据操作协同

`data`库与`Pandas`的协同工作不仅限于数据的读取和类型转换,还包括在数据操作方面的集成。例如,我们可以结合使用`data`库的高速读取能力和`Pandas`的复杂数据操作能力,来实现更加复杂的数据处理流程。

```python

import data

import pandas as pd

# 使用data库高速读取大型数据集

dataframe = data.load('large_data')

# 使用Pandas进行复杂的数据处理

processed_dataframe = dataframe[dataframe['value'] > 10].groupby('category').sum()

```

在这个例子中,我们首先使用`data`库读取了一个大型数据集。然后,我们利用`Pandas`的功能进行数据过滤和分组求和。这种协同操作可以大大提高数据处理的速度和效率。

### 2.2.2 data库与Pandas的数据分析功能扩展

`data`库与`Pandas`的集成还意味着可以扩展数据分析的功能。例如,我们可以将`data`库的某些特性与`Pandas`的数据分析工具结合起来,以实现更加深入的数据洞察。

```python

import data

import pandas as pd

from statsmodels.api import stats

# 使用data库读取数据

dataframe = data.load('statistical_data')

# 使用Pandas进行数据分组

grouped = dataframe.groupby('group')

# 使用statsmodels进行统计分析

results = grouped.apply(lambda x: stats.ols('value ~ category', x).fit())

# 输出统计分析结果

print(results)

```

在这个例子中,我们使用`data`库读取了数据,并利用`Pandas`进行分组。然后,我们使用`statsmodels`库进行统计建模,分析不同组之间的关系。这种集成允许我们利用`data`库的高速读取和`Pandas`的强大数据处理能力,以及`statsmodels`的统计分析功能,来实现更加深入的数据分析。

## 2.3 data库与Pandas的性能优化

### 2.3.1 数据处理的性能瓶颈分析

在进行数据处理时,了解性能瓶颈是至关重要的。`data`库与`Pandas`的集成可以帮助我们识别和优化这些瓶颈,从而提高数据处理的效率。

```python

import data

import pandas as pd

import numpy as np

# 使用data库读取数据

dataframe = data.load('large_dataset')

# 分析数据处理的时间

start_time = time.time()

processed_dataframe = dataframe[dataframe['value'] > 10].groupby('category').sum()

end_time = time.time()

# 输出处理时间

print(f"Data processing took {end_time - start_time} seconds")

```

在这个例子中,我们使用`time`模块来测量数据处理的时间。通过比较处理前后的计时,我们可以了解数据处理的速度。如果处理速度较慢,我们可能需要进一步分析并优化代码。

### 2.3.2 data库与Pandas的性能优化策略

针对`data`库与`Pandas`的数据处理性能瓶颈,我们可以采取多种优化策略。例如,我们可以优化`Pandas`的操作,或者利用`data`库的特性来提高数据处理的速度。

```python

# 使用data库和Pandas进行优化后的数据处理

start_time = time.time()

# 使用Pandas的Categorical数据类型来提高性能

categorical_series = pd.Categorical(dataframe['category'])

processed_dataframe = dataframe[dataframe['value'] > 10].groupby(categorical_series).sum()

end_time = time.time()

# 输出处理时间

print(f"Optimized data processing took {end_time - start_time} seconds")

```

在这个例子中,我们通过将分类列转换为`Pandas`的`Categorical`数据类型来优化数据处理性能。这种转换可以显著减少内存使用,并提高处理速度。

通过本章节的介绍,我们了解了如何将`data`库与`Pandas`集成,以及这种集成如何为数据分析和处理带来强大的功能。从基本的数据类型转换到高级的数据操作协同,再到性能优化策略,`data`库与`Pandas`的集成展现了巨大的潜力。在下一章中,我们将探讨`data`库与`NumPy`的集成,以及它如何进一步扩展数据分析的能力。

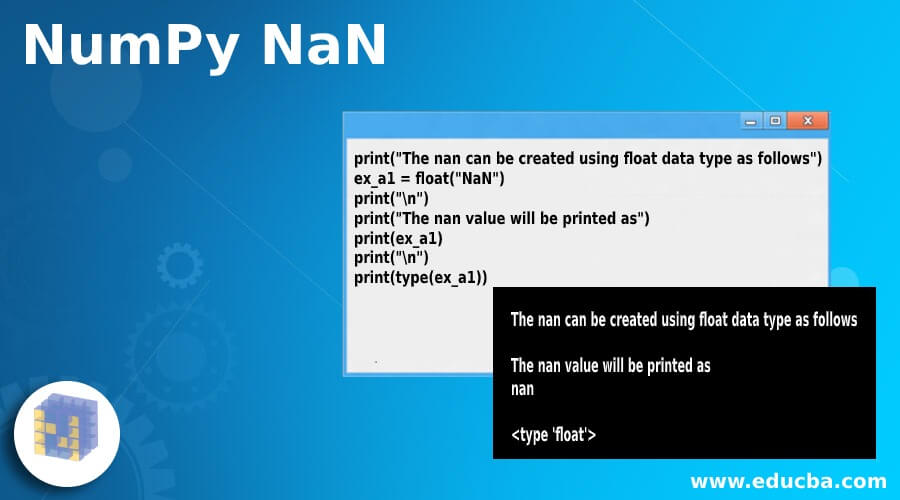

# 3. data库与NumPy的集成

在本章节中,我们将深入探讨data库与NumPy库的集成,这将为Python用户提供更为强大的数据处理和科学计算能力。NumPy是Python中用于科学计算的核心库,它提供了高性能的多维数组对象以及这些数组的操作工具。通过与data库的集成,

0

0