【data库的性能优化】:提升Python数据处理效率的技巧,让你的代码快如闪电

发布时间: 2024-10-15 17:57:30 阅读量: 53 订阅数: 38

# 1. 理解data库的基本概念和性能挑战

## 数据库的基本概念

在IT行业中,数据库(database)是用来存储、检索、管理和操作数据的系统。它允许我们以结构化的方式组织数据,使得数据可以被快速访问和高效管理。数据库管理系统(DBMS)是软件工具,它允许用户和程序创建、维护和处理数据库。

## data库的类型

数据库通常分为关系型数据库和非关系型数据库。关系型数据库(如MySQL, PostgreSQL)使用结构化的表格方式来组织数据,而非关系型数据库(如MongoDB, Redis)则支持更灵活的数据模型,如文档、键值对、宽列存储或图形数据库。

## 性能挑战

随着数据量的增加和访问频率的提升,数据库面临的主要性能挑战包括:

- **查询延迟**:复杂或不良设计的查询可能导致响应时间缓慢。

- **数据吞吐量**:高并发访问可能导致数据库处理能力不足。

- **存储扩展性**:如何高效地扩展数据库以存储更多数据,同时保持性能不下降。

- **并发控制**:确保在多用户访问时,数据的一致性和完整性。

理解这些基本概念和性能挑战是进行数据库优化和处理的第一步。在接下来的章节中,我们将深入探讨如何使用Python进行高效的数据处理,并对data库进行性能优化。

# 2. Python数据处理的基础理论

Python作为一门高级编程语言,其在数据处理领域的应用非常广泛。本章节我们将深入探讨Python数据处理的基础理论,包括数据结构和算法的效率、数据处理流程的设计原则、内存管理和数据持久化等方面。通过本章节的介绍,读者将能够理解如何高效地使用Python进行数据处理,以及如何优化数据处理流程以提升性能。

## 2.1 数据结构和算法的效率

在Python数据处理中,选择合适的数据结构和算法至关重要。数据结构直接影响到数据处理的效率,而算法复杂度分析则为我们提供了一个衡量和比较不同算法性能的标准。

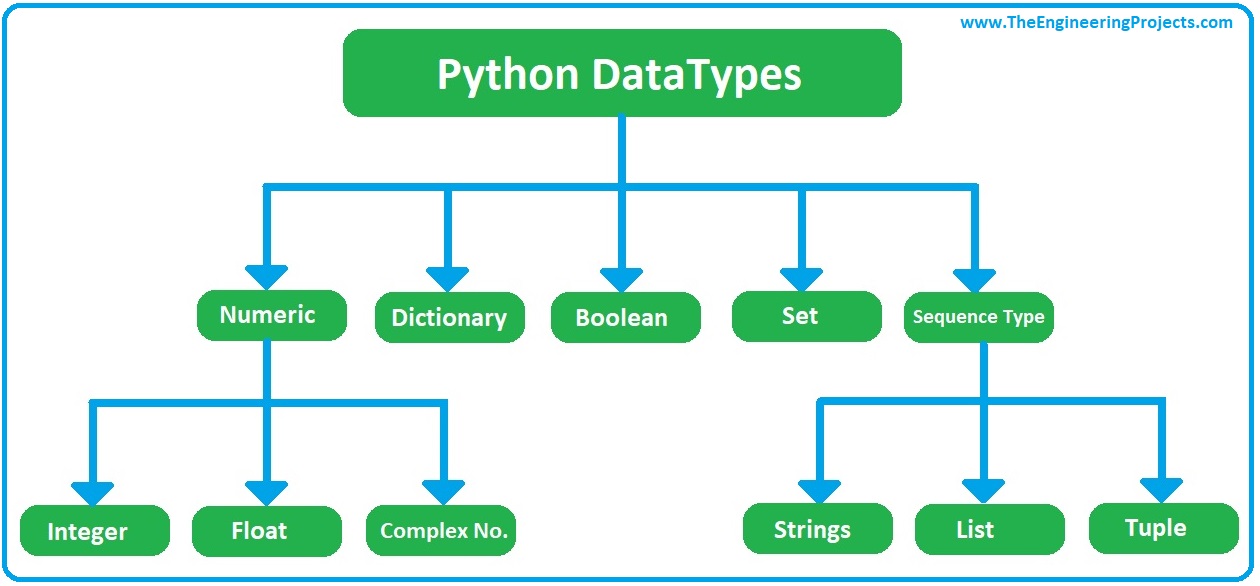

### 2.1.1 Python内置数据类型的选择

Python提供了多种内置数据类型,包括列表(list)、元组(tuple)、字典(dict)和集合(set)等。每种数据类型都有其适用的场景和性能特点。

```python

# 示例代码:使用Python内置数据类型

data_list = [1, 2, 3, 4, 5] # 列表

data_tuple = (1, 2, 3, 4, 5) # 元组

data_dict = {'a': 1, 'b': 2, 'c': 3} # 字典

data_set = {1, 2, 3, 4, 5} # 集合

```

列表(list)是一种可变序列,适用于存储元素数量不定且经常变动的数据集。元组(tuple)是一种不可变序列,适用于存储不变的数据集,由于其不可变性,它通常比列表占用更少的内存。字典(dict)是一种可变容器模型,存储的是键值对,适用于需要快速查找数据的场景。集合(set)是一种无序且不重复的元素集合,适用于去除重复元素和进行快速成员检查。

在选择数据结构时,应考虑数据操作的类型(例如,是否需要频繁添加或删除元素)、数据的大小和预期的操作数量。例如,如果需要频繁地添加和删除元素,则列表可能是最佳选择;而如果需要快速查找元素,则字典可能是更合适的选择。

### 2.1.2 算法复杂度分析

算法复杂度分析是评估算法性能的重要手段。它包括时间复杂度和空间复杂度两部分。

时间复杂度表示算法执行时间与输入数据规模之间的关系。常见的复杂度等级从低到高排序为:O(1) < O(log n) < O(n) < O(n log n) < O(n^2) < O(2^n)。

空间复杂度表示算法执行过程中占用存储空间与输入数据规模之间的关系。它的分析方法与时间复杂度类似。

```python

# 示例代码:计算列表元素平方的简单函数

def square_elements(lst):

result = []

for element in lst:

result.append(element ** 2)

return result

```

在上述代码中,我们计算列表中每个元素的平方。这个函数的时间复杂度为O(n),因为它需要遍历列表中的每个元素一次。空间复杂度也为O(n),因为我们需要存储结果列表,其大小与输入列表的大小成正比。

理解算法复杂度可以帮助我们选择或设计更高效的算法,从而在处理大规模数据集时保持良好的性能。

## 2.2 数据处理流程的设计原则

在设计数据处理流程时,我们需要遵循一些基本原则,以确保流程的高效和可维护。

### 2.2.1 数据流的优化

数据流是指数据在处理过程中的流动路径。优化数据流可以减少不必要的数据传输和转换,提高处理效率。

```mermaid

graph LR

A[数据采集] --> B[数据清洗]

B --> C[数据转换]

C --> D[数据分析]

D --> E[数据可视化]

```

在上述Mermaid流程图中,我们展示了数据处理的一般流程。在这个流程中,每个步骤都可能涉及数据的读取、处理和写入。优化数据流的关键在于减少这些步骤中的数据冗余和不必要的转换。

例如,如果我们可以直接在数据源进行数据清洗和转换,那么就不需要将原始数据先加载到内存中,然后再进行处理。这样可以节省内存资源,并减少数据在不同处理阶段之间传输的时间。

### 2.2.2 代码重构的方法论

代码重构是指在不改变软件外部行为的前提下,改善其内部结构的过程。重构可以帮助我们提高代码的可读性、可维护性和性能。

```python

# 示例代码:重构前的代码

def calculate_square(numbers):

result = []

for num in numbers:

result.append(num ** 2)

return result

# 重构后的代码

def calculate_square(numbers):

return [num ** 2 for num in numbers]

```

在上述代码中,我们展示了如何重构一个计算平方的函数。重构前的版本使用了传统的for循环来构建结果列表,而重构后的版本使用了列表推导式,不仅代码更加简洁,而且执行效率也有所提高。

重构的步骤通常包括:识别代码的坏味道、提出重构计划、实施重构以及运行测试以确保代码的正确性。重构是一个持续的过程,应该定期进行,以保持代码库的健康状态。

## 2.3 内存管理和数据持久化

Python程序运行过程中,内存管理是一个重要的议题。同时,为了长期保存数据,数据持久化的策略也是必不可少的。

### 2.3.1 内存优化技术

Python使用自动内存管理机制,这意味着程序员不需要手动释放内存。然而,如果不注意内存使用,还是会出现内存泄漏和效率低下的问题。

```python

# 示例代码:使用生成器表达式优化内存使用

def get_squares(numbers):

for num in numbers:

yield num ** 2

# 使用生成器

squares = get_squares([1, 2, 3, 4, 5])

for square in squares:

print(square)

```

在上述代码中,我们使用了生成器表达式来代替列表推导式。生成器表达式不会一次性生成所有数据,而是按需生成,这样可以节省内存,特别是处理大规模数据集时。

其他内存优化技术包括使用内置函数和库函数(例如`map`和`filter`)、避免使用全局变量、使用局部变量和及时释放不再使用的资源。

### 2.3.2 数据持久化工具和策略

数据持久化是指将数据保存在磁盘或其他存储设备上,以便长期保存和使用。Python提供了多种数据持久化工具,包括文件操作、数据库和专门的数据序列化模块。

```python

# 示例代码:使用JSON模块进行数据序列化

import json

data = {'name': 'John', 'age': 30, 'city': 'New York'}

json_data = json.dumps(data)

# 将JSON数据写入文件

with open('data.json', 'w') as f:

f.write(json_data)

# 从文件读取JSON数据

with open('data.json', 'r') as f:

data_loaded = json.load(f)

```

在上述代码中,我们使用了JSON模块将一个字典序列化为JSON格式,并将其保存到文件中。这样可以将数据持久化存储,并在需要时从文件中加载数据。

数据持久化的策略包括:选择合适的数据格式、使用数据库管理系统(DBMS)进行结构化存储、定期备份数据以及使用缓存机制提高数据访问效率。

在本章节中,我们探讨了Python数据处理的基础理论,包括数据结构和算法的效率、数据处理流程的设计原则以及内存管理和数据持久化策略。通过理解这些基础知识,我们为下一章节中将要介绍的实践技巧和性能优化打下了坚实的基础。

# 3. Python数据处理实践技巧

## 3.1 高效数据处理库的使用

在数据处理的世界中,Python凭借其强大的库生态系统,成为了数据科学家的首选语言之一。本章节我们将深入探讨如何使用NumPy和Pandas这两个库来实现高效的数据处理,并通过案例分析展示如何优化数据处理流程。

### 3.1.1 NumPy和Pandas的应用

NumPy和Pandas是Python中用于数据处理的两大利器。NumPy提供了高性能的多维数组对象和这些数组的操作工具,而Pandas则构建在NumPy之上,提供了更高级的数据结构和数据分析工具。

#### NumPy的应用

NumPy的核心是ndarray对象,它是一个快速、灵活且占用空间小的多维数组。这个数组的数据类型是统一的,可以进行高效的数学运算。例如,当你需要进行大规模的数值计算时,可以利用NumPy的向量化操作,避免使用Python原生的循环,从而大幅提升计算速度。

```python

import numpy as np

# 创建一个10000x10000的随机浮点数矩阵

matrix = np.random.rand(10000, 10000)

# 计算矩阵的乘法

result = np.dot(matrix, matrix.T)

```

在上述代码中,我们创建了一个大型的随机浮点数矩阵,并计算了它的自乘积。如果使用Python原生的循环来完成这一

0

0