Python邮件解析实战案例:如何高效解析HTML邮件内容

发布时间: 2024-10-14 01:32:22 阅读量: 28 订阅数: 23

# 1. 邮件解析的基本概念和工具介绍

## 1.1 邮件解析的定义和重要性

邮件解析是电子邮件技术中的一个重要环节,它指的是通过分析电子邮件的原始数据,提取出邮件内容、附件、头信息等有用信息的过程。邮件解析对于邮箱服务提供商、邮件安全监测系统以及电子邮件营销等领域至关重要。它不仅帮助服务提供商维护邮件系统的稳定性,还能够为用户提供更加丰富的邮件内容处理功能。

## 1.2 邮件解析的常用工具和技术

邮件解析可以通过多种工具和技术实现,包括但不限于正则表达式、字符串处理函数以及专业的HTML解析库。其中,正则表达式和字符串处理函数适用于简单的文本邮件解析,而HTML解析库则更适合于解析富文本格式的邮件,如HTML格式的邮件正文。专业的HTML解析库如BeautifulSoup、lxml等,能够提供强大的解析功能,帮助开发者高效地处理邮件内容。

## 1.3 HTML邮件的解析难点和解决方案

HTML邮件的解析难点主要在于其复杂性。HTML邮件可能包含多种格式的内容,如文本、图片、表格、链接等,而且可能嵌入了JavaScript或其他脚本,这使得解析过程变得复杂。解决方案通常包括使用专门的HTML解析库来处理HTML内容,以及对于嵌入脚本的特殊处理策略,如忽略或转义脚本内容,以确保邮件解析的安全性和准确性。

# 2. Python基础语法和库

## 2.1 Python的基本语法和数据结构

Python作为一种高级编程语言,以其简洁明了的语法和强大的功能库而广受欢迎。在邮件解析领域,Python同样表现出色,其丰富的库使得解析邮件变得简单高效。本章节将详细介绍Python的基本语法和数据结构,为后续的邮件解析工作打下坚实的基础。

### 2.1.1 变量、数据类型和操作符

在Python中,变量是存储数据的基本单位,不需要显式声明类型,Python解释器会自动推断。常见的数据类型包括整型(int)、浮点型(float)、字符串(str)、列表(list)、元组(tuple)、字典(dict)和集合(set)等。

#### 代码块示例:

```python

# 定义整数变量

x = 10

# 定义浮点数变量

y = 20.5

# 定义字符串变量

z = "Hello, Python!"

# 打印变量类型

print(type(x)) # <class 'int'>

print(type(y)) # <class 'float'>

print(type(z)) # <class 'str'>

# 简单的算术操作

result = x + y # 加法

print(result) # 30.5

# 字符串拼接

greeting = "Hello, " + z # Hello, Hello, Python!

print(greeting)

```

### 2.1.2 控制流程和函数定义

Python中的控制流程包括条件语句(if-elif-else)、循环语句(for和while),以及它们的组合使用。函数是组织好的,可重复使用的代码块,它能够提高代码的复用性和可读性。

#### 代码块示例:

```python

# 定义函数

def greet(name):

return "Hello, " + name + "!"

# 调用函数

print(greet("Python")) # Hello, Python!

# 条件语句示例

if x > 10:

print("x is greater than 10")

elif x == 10:

print("x is equal to 10")

else:

print("x is less than 10")

# for循环示例

for i in range(5):

print(i) # 0, 1, 2, 3, 4

# while循环示例

count = 0

while count < 5:

print(count) # 0, 1, 2, 3, 4

count += 1

```

### 2.2 Python的HTML解析库

HTML解析是邮件解析中的一个重要环节,Python提供了多种库来处理HTML,其中最著名的包括BeautifulSoup和lxml。

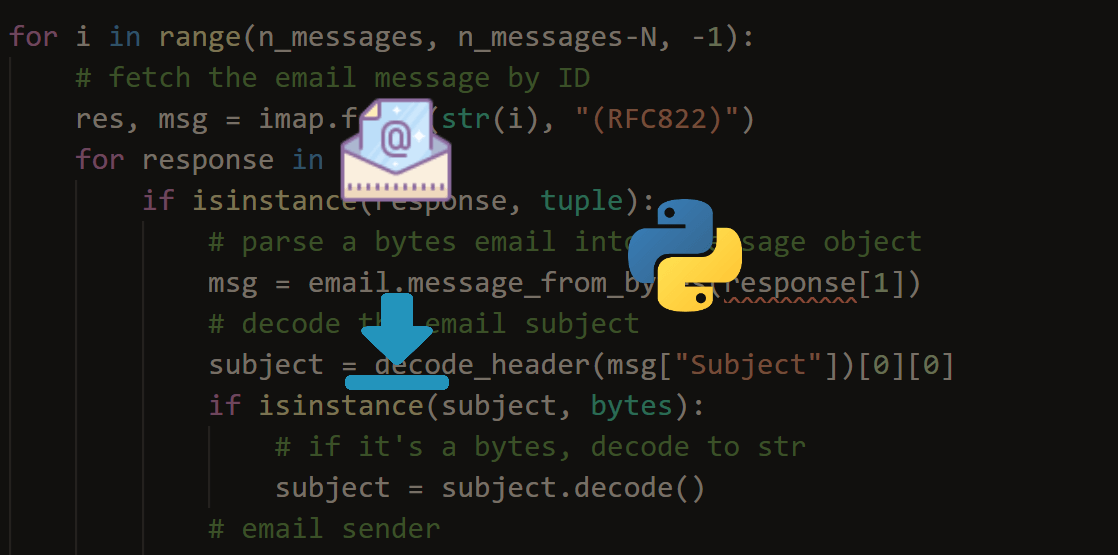

### 2.3 Python的邮件解析库

邮件解析涉及处理邮件的不同组成部分,如头部信息、正文内容等。Python的IMAPlib库和email库是处理邮件的利器。

### 2.4 总结

通过本章节的介绍,我们了解了Python的基本语法和数据结构,以及如何使用控制流程和函数定义来构建更复杂的逻辑。此外,我们还初步认识了Python在HTML和邮件解析方面的强大库。这些基础知识为后续章节的深入学习和实战应用提供了坚实的基础。

# 3. HTML邮件内容解析实践

在本章节中,我们将深入探讨如何使用Python中的不同库来解析HTML邮件的内容。我们将介绍两种主要的HTML解析库:BeautifulSoup和lxml,以及Python内置的email库来解析邮件头信息。通过本章节的介绍,你将学会如何提取邮件中的有用信息,如表格数据、图片信息和链接信息等。

## 3.1 使用BeautifulSoup解析HTML邮件

### 3.1.1 BeautifulSoup库的选择和安装

BeautifulSoup是一个Python库,用于解析HTML和XML文档。它创建了一个解析树,可以很容易地访问文档中的各个节点。BeautifulSoup库的选择基于其简单易用的API和强大的解析功能,非常适合于解析结构复杂的HTML邮件。

为了使用BeautifulSoup,你需要先安装它。如果你还没有安装BeautifulSoup,可以通过以下命令来安装:

```bash

pip install beautifulsoup4

```

安装完成后,你可以开始使用它来解析HTML邮件了。

### 3.1.2 解析邮件的HTML内容

假设我们收到了一封包含HTML内容的邮件,我们想要解析它。首先,我们需要从邮件中提取出HTML部分。这里,我们将使用一个示例HTML字符串来模拟邮件的HTML内容:

```python

from bs4 import BeautifulSoup

# 示例HTML邮件内容

html_content = """

<html>

<head></head>

<body>

<div style="font-family: Arial, sans-serif;">

<h2>邮件主题:会议通知</h2>

<p>会议时间:2023年4月1日</p>

<table border="1">

<tr>

<th>时间</th>

<th>地点</th>

</tr>

<tr>

<td>上午9:00</td>

<td>会议室A</td>

</tr>

</table>

</div>

</body>

</html>

# 使用BeautifulSoup解析HTML内容

soup = BeautifulSoup(html_content, 'html.parser')

```

### 3.1.3 提取邮件中的有用信息

现在我们已经将HTML内容解析为一个BeautifulSoup对象,我们可以轻松地提取邮件中的有用信息了。例如,提取会议时间和地点:

```python

# 提取会议时间

meeting_time = soup.find('h2').text

print("会议时间:", meeting_time)

# 提取会议地点

meeting_location = soup.find_all('table')[0].find_all('td')[1].text

print("会议地点:", meeting_location)

```

通过上述代码,我们可以得到会议的时间和地点信息。

## 3.2 使用lxml解析HTML邮件

### 3.2.1 lxml库的选择和安装

lxml是一个高性能的XML和HTML解析库,它比BeautifulSoup更快,但需要更复杂的XPath或XSLT查询。对于处理大量邮件或者需要高性能的场景,lxml是一个很好的选择。

安装lxml库的命令如下:

```bash

pip install lxml

```

安装完成后,你可以开始使用它来解析HTML邮件了。

### 3.2.2 解析邮件的HTML内容

使用lxml解析HTML邮件的步骤与BeautifulSoup类似,但查询方式不同。以下是使用lxml解析相同HTML内容的示例:

```python

from lxml import etree

# 使用lxml解析HTML内容

html_content = """

<html>

<head></head>

<body>

<div style="font-family: Arial, sans-serif;">

<h2>邮件主题:会议通知</h2>

<p>会议时间:2023年4月1日</p>

<table border="1">

<tr>

<th>时间</th>

<th>地点</th>

</tr>

<tr>

<td>上午9:00</td>

<td>会议室A</td>

</tr>

</table>

</div>

</body>

</html>

# 解析HTML内容

tree = etree.HTML(html_content)

# 提取会议时间

meeting_time = tree.xpath('//h2/text()')[0]

print("会议时间:", meeting_time)

# 提取会议地点

meeting_location = tree.xpath('//table/tr[2]/td[2]/text()')[0]

print("会议地点:", meeting_location)

```

### 3.2.3 提取邮件中的有用信息

通过XPath查询,我们可以提取会议时间、地点等有用信息。

## 3.3 使用email库解析邮件头信息

### 3.3.1 email库的基本使用

email是Python的内置库,用于解析邮件内容,包括邮件头和邮件体。email库可以解析多部分(multipart)邮件,并能够处理编码的文本。

### 3.3.2 解析邮件的头部信息

邮件头部信息包含了发件人、收件人、主题等重要信息。使用email库解析邮件头信息的示例代码如下:

```python

import email

from email import policy

from email.parser import BytesParser

# 假设我们有一个邮件的原始字节流

raw_email = b"""\

MIME-Version: 1.0

Content-Type: text/plain; charset="utf-8"

Content-Transfer-Encoding: 8bit

From: Sender <***>

To: Receiver <***>

Subject: 会议通知

这是一封会议通知邮件,请查收。

# 解析邮件头部信息

msg = BytesParser(policy=policy.default).parsebytes(raw_email)

# 打印邮件头部信息

for key, value in msg.items():

print(f"{key}: {value}")

```

### 3.3.3 从邮件头信息中提取有用信息

通过解析邮件头信息,我们可以提取发件人、收件人和主题等信息。

在本章节中,我们介绍了如何使用BeautifulSoup和lxml库来解析HTML邮件内容,以及如何使用email库解析邮件头信息。通过这些技术,我们可以从邮件中提取有用的信息,如会议通知的细节、图片和链接等。在下一章中,我们将通过实战案例来演示如何应用这些技术来解决具体问题。

# 4. Python邮件解析实战案例

## 实战案例1:解析HTML邮件中的表格数据

### 邮件内容和需求分析

在处理电子邮件时,经常需要从HTML格式的邮件中提取表格数据。这些数据可能包含了重要的业务信息,如销售报表、库存清单等。我们的目标是从HTML邮件中提取表格数据,并将其转换为更易于分析和处理的格式,例如CSV或Excel文件。

假设我们收到了一份HTML格式的销售报表邮件,需要从中提取销售数据。这份邮件包含了一个HTML表格,每行代表一笔交易记录,列则包含交易日期、客户名称、产品类型、数量和销售额等信息。

### 使用BeautifulSoup解析表格数据

#### BeautifulSoup库的选择和安装

BeautifulSoup是一个可以从HTML或XML文件中提取数据的Python库。它创建了一个解析树,允许你遍历树、搜索和修改解析树等功能。

首先,你需要安装BeautifulSoup库和它的依赖库lxml:

```bash

pip install beautifulsoup4 lxml

```

#### 解析邮件的HTML内容

接下来,我们编写代码来解析邮件内容。我们将使用BeautifulSoup来解析HTML表格,并提取表格中的所有行和列。

```python

from bs4 import BeautifulSoup

# 假设email_content是邮件的HTML内容

email_content = """

<html>

<head><title>销售报表</title></head>

<body>

<table>

<tr><th>日期</th><th>客户</th><th>产品</th><th>数量</th><th>销售额</th></tr>

<tr><td>2023-01-01</td><td>客户A</td><td>产品X</td><td>10</td><td>1000</td></tr>

<tr><td>2023-01-02</td><td>客户B</td><td>产品Y</td><td>20</td><td>2000</td></tr>

<!-- 更多行数据 -->

</table>

</body>

</html>

soup = BeautifulSoup(email_content, 'lxml')

# 找到所有的<tr>标签

table_rows = soup.find_all('tr')

# 解析表格数据

table_data = []

for row in table_rows:

cells = row.find_all(['td', 'th'])

cells = [cell.text.strip() for cell in cells]

table_data.append(cells)

# 打印表格数据

for row in table_data:

print(row)

```

#### 使用lxml解析表格数据

除了BeautifulSoup,我们也可以使用lxml库来解析HTML表格。lxml是一个高性能的XML和HTML解析库。

```python

from lxml import html

# 使用lxml解析HTML内容

tree = html.fromstring(email_content.encode('utf-8'))

# 找到所有的<tr>标签

table_rows = tree.xpath('//tr')

# 解析表格数据

table_data = []

for row in table_rows:

cells = row.xpath('.//td | .//th')

cells = [cell.text_content().strip() for cell in cells]

table_data.append(cells)

# 打印表格数据

for row in table_data:

print(row)

```

### 从邮件头信息中提取有用信息

在很多情况下,邮件头信息包含了邮件发送者、接收者、发送时间等关键信息。我们可以使用Python的`email`库来解析邮件头信息。

```python

import email

from email.policy import default

# 假设raw_email是原始邮件内容

raw_email = '原始邮件内容字符串'

# 解析邮件

parsed_email = email.message_from_bytes(raw_email, policy=default)

# 提取邮件头信息

headers = parsed_email.items()

for header, value in headers:

print(f"{header}: {value}")

```

### 总结

在本章节中,我们介绍了如何使用Python进行邮件解析实战案例。通过使用BeautifulSoup和lxml库,我们可以轻松地从HTML邮件中提取表格数据。同时,我们也展示了如何使用`email`库解析邮件头信息。这些技术对于处理电子邮件中的数据提取和分析非常有用。

通过本章节的介绍,我们了解了邮件解析的基本流程,包括邮件内容的解析、表格数据的提取以及邮件头信息的解析。这些技能对于IT从业者来说非常实用,特别是在处理自动化邮件处理任务时。在下一节中,我们将进一步探讨如何解析HTML邮件中的图片信息。

# 5. 邮件解析的性能优化

邮件解析是一个复杂的过程,尤其是在处理大量邮件或者需要从邮件中提取大量信息时。为了提高邮件解析的效率和准确性,我们需要了解一些优化技巧。

## 优化解析速度的方法

### 使用合适的解析库

不同的邮件解析库在性能上有所差异。例如,`lxml`通常比`BeautifulSoup`更快,因为它在内部使用了C语言编写的libxml2和libxslt库。选择正确的库可以显著提高解析速度。

```python

# lxml 示例代码

from lxml import etree

import requests

response = requests.get('***')

tree = etree.HTML(response.content)

```

### 并行处理

当需要处理多个邮件时,可以使用多线程或多进程来并行处理。Python中的`concurrent.futures`模块可以轻松实现这一点。

```python

from concurrent.futures import ThreadPoolExecutor

def parse_email(email_content):

# 解析邮件的逻辑

pass

email_contents = ['email1.html', 'email2.html', 'email3.html']

with ThreadPoolExecutor(max_workers=5) as executor:

executor.map(parse_email, email_contents)

```

### 缓存

对于经常需要解析的邮件内容,可以使用缓存来存储解析结果,避免重复解析相同内容。

```python

import functools

@functools.lru_cache(maxsize=None)

def parse_email_cached(email_content):

# 解析邮件的逻辑

return parsed_email

parsed_email = parse_email_cached(email_content)

```

## 优化解析准确度的方法

### 使用专门的邮件解析库

使用专门为邮件解析设计的库(如Python的`email`库)可以更准确地解析邮件结构和内容。

```python

import email

# 解析邮件头信息

message = email.message_from_string(some_email_raw_string)

subject = message['Subject']

```

### 错误处理和日志记录

在解析过程中加入错误处理和日志记录,可以帮助我们发现并修正解析过程中出现的问题。

```python

import logging

logging.basicConfig(level=***)

def safe_parse_email(email_content):

try:

# 解析邮件的逻辑

pass

except Exception as e:

logging.error(f"Error parsing email: {e}")

return None

```

### 定期更新解析库

邮件格式和规范会随着时间变化,因此定期更新解析库可以确保它们能够处理最新的邮件格式。

## 邮件解析的安全性考虑

### 防止邮件解析过程中的安全风险

邮件解析可能涉及到处理外部数据,这可能引入安全风险,如HTML注入或跨站脚本攻击(XSS)。确保解析库能够安全地处理这些内容。

### 处理解析过程中的异常和错误

正确处理解析过程中的异常和错误,可以避免程序崩溃,并确保邮件解析任务的顺利完成。

```python

try:

# 尝试解析邮件

except Exception as e:

# 处理异常

logging.error(f"Failed to parse email: {e}")

```

## 邮件解析的未来发展趋势

### 新技术的应用

随着人工智能和机器学习技术的发展,未来的邮件解析可能会融入这些技术,例如使用自然语言处理(NLP)技术来理解邮件内容的语义。

### 新需求的满足

随着业务需求的变化,邮件解析可能会需要支持更多的邮件格式和协议,如支持加密邮件的解析。

通过本章节的介绍,我们了解了如何优化邮件解析的性能和安全性,并探讨了邮件解析的未来发展趋势。在实际应用中,结合具体情况选择合适的方法和技术至关重要。

0

0