去噪自编码器在自然语言处理中的应用:提升文本质量,增强语义理解

发布时间: 2024-08-21 14:15:15 阅读量: 53 订阅数: 39

算法源码-数据处理:34种数据降维方法代码.zip

# 1. 去噪自编码器基础**

**1.1 去噪自编码器的原理和结构**

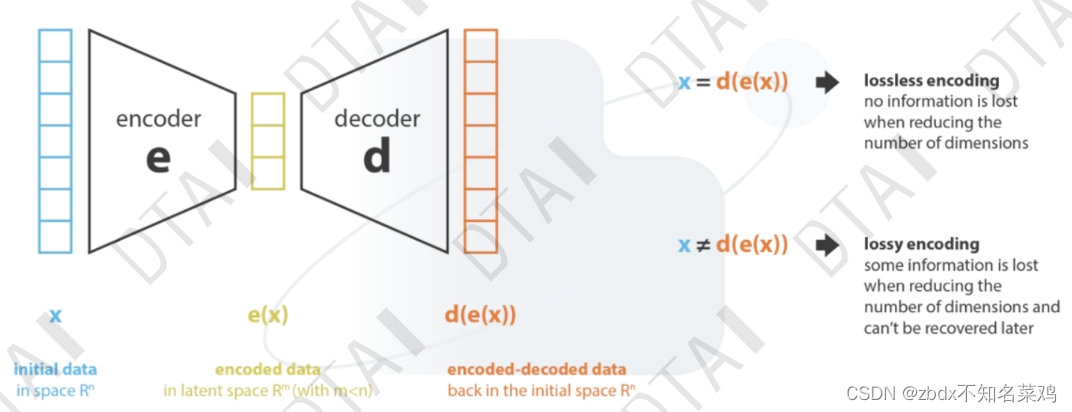

去噪自编码器(DAE)是一种神经网络模型,旨在从包含噪声的数据中学习有意义的表示。它由两个主要部分组成:编码器和解码器。编码器将输入数据映射到一个低维潜在空间,而解码器则将潜在表示重建为无噪声的输出。DAE 的关键思想是,通过迫使模型从噪声输入中重建原始数据,它可以学习数据的鲁棒表示。

**1.2 去噪自编码器的训练方法**

DAE 的训练过程涉及两个阶段:

- **噪声生成:**在训练期间,输入数据被注入随机噪声,以模拟现实世界中的数据噪声。

- **重建训练:**DAE 通过最小化输入数据和重建输出之间的重建误差来训练。通过这种方式,模型学习忽略噪声并专注于数据的底层表示。

# 2. 去噪自编码器在文本去噪中的应用

### 2.1 文本噪声的类型和影响

文本噪声是指文本数据中存在的不必要或错误的信息,它会影响文本处理任务的准确性和效率。文本噪声的类型包括:

- **拼写错误:**单词拼写不正确,例如将"the"拼写为"teh"。

- **语法错误:**句子结构不正确,例如缺少标点符号或使用不正确的时态。

- **重复:**文本中包含重复的单词或短语,例如"我,我,我爱你"。

- **无关信息:**文本中包含与主题无关的信息,例如网页中的广告或电子邮件中的签名。

文本噪声会对自然语言处理任务产生负面影响,例如:

- **文本分类:**噪声会混淆文本的类别,导致分类错误。

- **文本生成:**噪声会影响生成的文本质量,使其难以理解或有意义。

- **文本检索:**噪声会干扰文本相似性度量,导致检索结果不准确。

### 2.2 去噪自编码器在文本去噪中的原理和效果

#### 2.2.1 噪声模型和去噪目标

去噪自编码器是一种神经网络模型,它通过学习文本数据的潜在表示来实现文本去噪。在文本去噪中,噪声模型通常是一个随机过程,它将噪声添加到原始文本中。去噪自编码器的目标是学习一个去噪函数,该函数可以从有噪声的文本中恢复原始文本。

#### 2.2.2 去噪自编码器的训练和评估

去噪自编码器的训练过程包括以下步骤:

1. **数据准备:**将原始文本数据分成训练集和测试集。

2. **噪声添加:**使用噪声模型将噪声添加到训练集中的文本。

3. **模型训练:**使用有噪声的文本训练去噪自编码器,使其学习去噪函数。

4. **模型评估:**使用测试集评估去噪自编码器的性能,度量其恢复原始文本的能力。

去噪自编码器的评估指标包括:

- **BLEU(双语评估):**衡量去噪文本和原始文本之间的相似性。

- **ROUGE(召回率导向的统一评估):**衡量去噪文本和原始文本之间的重叠程度。

- **CIDEr(余弦相似度和信息密度):**衡量去噪文本和原始文本之间的语义相似性和信息丰富度。

**代码块:**

```python

import numpy as np

import tensorflow as tf

# 定义噪声模型

noise_model = tf.keras.layers.GaussianNoise(stddev=0.1)

# 定义去噪自编码器

denoising_autoencoder = tf.keras.models.Sequential([

tf.keras.layers.Dense(128, activation='relu'),

noise_model,

tf.keras.layers.Dense(128, activation='relu'),

tf.keras.layers.Dense(len(vocabulary))

])

# 编译模型

denoising_autoencoder.compile(optimizer='adam', loss='sparse_categorical_crossentropy')

# 训练模型

denoising_autoencoder.fit(noisy_text, original_text, epochs=10)

# 评估模型

denoised_text = denoising_autoencoder.predict(noisy_text)

bleu_score = tf.keras.metrics.bleu(original_text, denoised_text)

```

**代码逻辑分析:**

* `noise_model`:将高斯噪声添加到文本数据中,模拟文本噪声。

* `denoising_autoencoder`:一个简单的去噪自编码器模型,具有两个隐藏层和一个输出层。

* `compile`:编译模型,指定优化器和损失函数。

* `fit`:使用有噪声的文本训练去噪自编码器。

* `predict`:使用去噪自编码器从有噪声的文本中恢复原始文本。

* `bleu_score`:计算去噪文本和原始文本之间的BLEU分数。

**参数说明:**

* `stddev`:高斯噪声的标准差,控制噪声的强度。

* `epochs`:训练模型的轮数。

* `vocabulary`:文本数据中单词的词汇表。

* `optimizer`:优化算法,用于更新模型权重。

* `loss`:损失函数,用于衡量模型的性能。

# 3. 去噪自编码器在文本生成中的应用**

### 3.1 文本生成的挑战和方法

文本生成是一项具有挑战性的自然语言处理任务,其目的是从给定的输入文本或数据中生成新的、连贯的文本。文本生成在许多应用中至关重要,例如机器翻译、对话式人工智能和文本摘要。

文本生成面临的主要挑战包括:

- **语言模型的复杂性:**自然语言具有高度的复杂性和多样性,使得构建能够生成流畅、连贯文本的语言模型变得困难。

- **数据稀疏性:**自然语言中

0

0