图像降噪神器:去噪自编码器,让图像重现清晰

发布时间: 2024-08-21 13:47:06 阅读量: 50 订阅数: 44

实用代码 05 自编码器图像去噪

# 1. 图像降噪概述

图像降噪是计算机视觉领域中的重要任务,旨在从图像中去除不必要的噪声,恢复图像的清晰度。噪声通常由图像采集过程中的各种因素引起,例如传感器噪声、光线不足或运动模糊。图像降噪算法通过分析图像像素之间的关系,识别并去除噪声,同时尽可能保留图像中的重要信息。

近年来,深度学习技术在图像降噪领域取得了显著进展。去噪自编码器(Denoising Autoencoder)是一种深度神经网络,专门用于图像降噪任务。与传统图像降噪算法相比,去噪自编码器具有强大的特征学习能力,能够从图像中提取复杂的噪声模式,并将其与图像中的真实信息区分开来。

# 2. 去噪自编码器的理论基础**

**2.1 自编码器原理**

自编码器(Autoencoder)是一种无监督神经网络,其目标是学习输入数据的压缩表示。它由编码器和解码器组成,编码器将输入数据映射到低维潜在空间,而解码器则将潜在空间映射回输入数据的重建。

**编码器**:编码器是一个神经网络,将输入数据 `x` 映射到潜在空间 `z`,其中 `z` 的维度通常小于 `x` 的维度。编码器由多个隐藏层组成,每个隐藏层学习输入数据的不同特征。

```python

import tensorflow as tf

# 定义输入数据

input_data = tf.keras.Input(shape=(28, 28, 1))

# 定义编码器

encoder = tf.keras.Sequential([

tf.keras.layers.Conv2D(32, (3, 3), activation='relu', padding='same'),

tf.keras.layers.MaxPooling2D((2, 2), padding='same'),

tf.keras.layers.Conv2D(64, (3, 3), activation='relu', padding='same'),

tf.keras.layers.MaxPooling2D((2, 2), padding='same'),

tf.keras.layers.Flatten()

])

# 编码器输出潜在空间

latent_space = encoder(input_data)

```

**解码器**:解码器是一个神经网络,将潜在空间 `z` 映射回输入数据的重建 `x_reconstructed`。解码器由多个隐藏层组成,每个隐藏层学习潜在空间的不同特征。

```python

# 定义解码器

decoder = tf.keras.Sequential([

tf.keras.layers.Dense(7 * 7 * 64, activation='relu'),

tf.keras.layers.Reshape((7, 7, 64)),

tf.keras.layers.Conv2DTranspose(64, (3, 3), strides=2, activation='relu', padding='same'),

tf.keras.layers.Conv2DTranspose(32, (3, 3), strides=2, activation='relu', padding='same'),

tf.keras.layers.Conv2D(1, (3, 3), activation='sigmoid', padding='same')

])

# 解码器输出重建数据

reconstructed_data = decoder(latent_space)

```

**2.2 去噪自编码器的改进**

为了提高去噪能力,去噪自编码器(Denoising Autoencoder)在自编码器的基础上进行了改进:

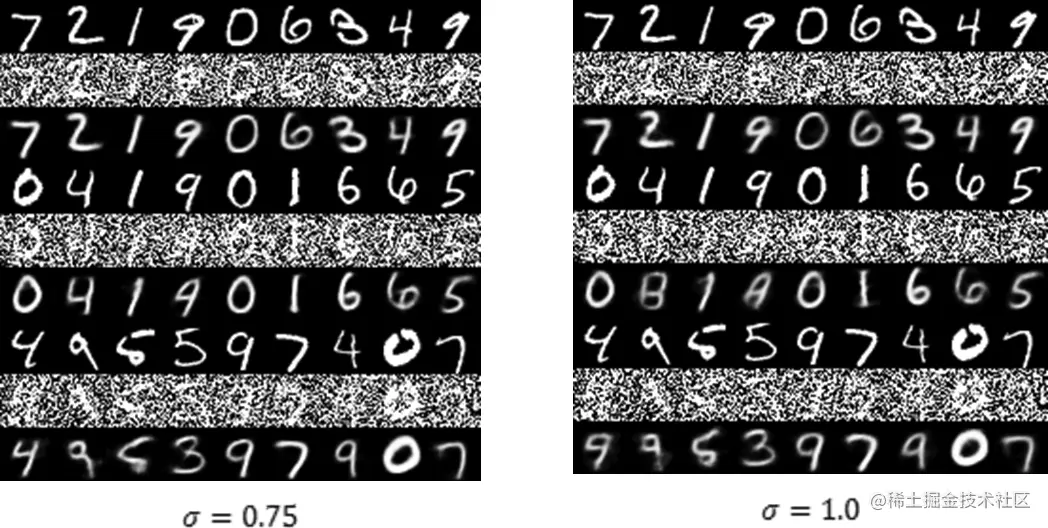

**噪声注入**:在训练过程中,向输入数据中注入噪声,迫使自编码器学习鲁棒的特征表示。

**稀疏编码**:通过添加稀疏性约束到潜在空间,鼓励自编码器学习更紧凑的特征表示。

**正则化**:使用正则化技术,如 L1 正则化或 L2 正则化,防止自编码器过拟合。

**参数说明**:

* `input_data`:输入数据,形状为 `(batch_size, height, width, channels)`。

* `latent_space`:潜在空间,形状为 `(batch_size, latent_dim)`。

* `reconstructed_data`:重建数据,形状与 `input_data` 相同。

* `latent_dim`:潜在空间的维度。

# 3. 去噪自编码器的实践应用

### 3.1 数据预处理和模型训练

**数据预处理**

在训练去噪自编码器之前,需要对图像数据进行预处理,包括:

- **图像归一化:**将图像像素值归一化到 [0, 1] 范围内,以消除不同图像之间的亮度差异。

- **图像裁剪:**将图像裁剪成统一的尺寸,以适应模型的输入大小。

- **数据增强:**通过旋转、翻转、裁剪等操作增强数据集,提高模型的泛化能力。

**模型训练**

去噪自编码器的训练过程如下:

1. **初始化模型:**初始化编码器和解码器的权重和偏置。

2. **正向传播:**将输入图像通过编码器编码成潜在表示。

3. **反向传播:**将潜在表示通过解码器解码成重建图像。

4. **计算损失:**计算重建图像与输入图像之间的损失函数,如均方误差 (MSE) 或结构相似性 (SSIM)。

5. **更新权重:**使用反向传播算法更新编码器和解码器的权重,以最小化损失函数。

6. **重复步骤 2-5:**重复正向传播、反向传播和权重更新的过程,直到达到收敛条件。

**代码块:**

```python

import tensorflow as tf

# 定义编码器

encoder = tf.keras.mode

```

0

0