多标签学习的评估挑战:指标与方法详解

发布时间: 2024-09-02 10:01:31 阅读量: 79 订阅数: 69

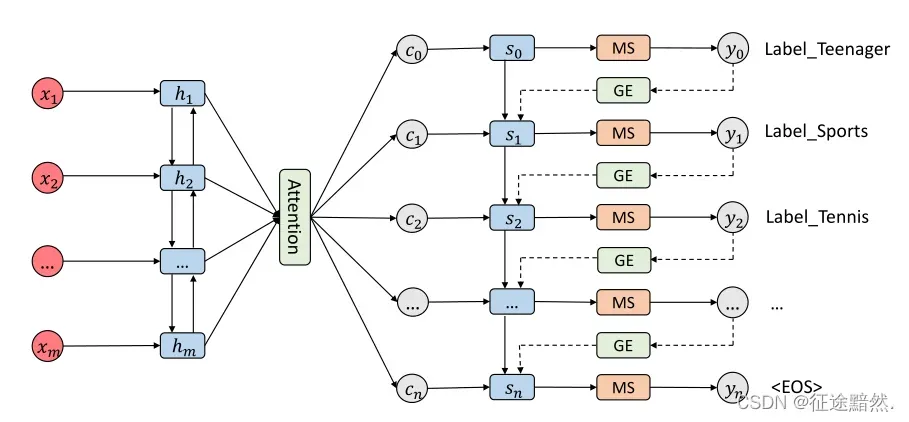

# 1. 多标签学习概述

多标签学习是机器学习领域的一个分支,它与传统的单标签学习不同,关注于每个实例可以被赋予多个标签的情况。与单标签学习相比,多标签学习能够更好地处理现实世界中复杂的问题,其中单个样本往往与多个类相关联。多标签学习广泛应用于图像标注、文本分类、基因功能预测等众多领域。

在多标签学习问题中,给定一个实例,算法需要预测该实例对应的标签集合,这比传统的单标签分类任务更加复杂。算法需要同时考虑标签之间的相关性,以及如何有效地结合这些信息来做出准确预测。因此,对于多标签学习的研究不仅具有理论价值,而且具有显著的实际应用意义。

本章旨在为读者提供一个多标签学习的基本概念框架,涵盖其定义、重要性以及应用,为后续章节深入探讨多标签学习的评价指标、评估方法以及实践应用打下坚实的基础。

# 2. 多标签学习的评价指标

## 2.1 基础评估指标

### 2.1.1 准确率、召回率和F1分数

在多标签学习领域,准确率(Precision)、召回率(Recall)和F1分数是评价模型性能的基础指标,尤其适用于处理包含多个标签的样本集。准确率是指在所有被模型判定为正类的样本中,真正属于正类的比例;召回率则是指在所有真正的正类样本中,被模型正确判定为正类的比例。

```python

# 计算准确率、召回率和F1分数的示例代码

from sklearn.metrics import precision_score, recall_score, f1_score

# 假定y_true为真实标签向量,y_pred为模型预测标签向量

y_true = [1, 0, 1, 1, 0, 1]

y_pred = [1, 0, 0, 1, 0, 1]

precision = precision_score(y_true, y_pred)

recall = recall_score(y_true, y_pred)

f1 = f1_score(y_true, y_pred)

print(f"Precision: {precision}")

print(f"Recall: {recall}")

print(f"F1 Score: {f1}")

```

这段代码使用了`sklearn.metrics`模块中的函数来计算精确率、召回率和F1分数。其中,`precision_score`、`recall_score`和`f1_score`分别用于计算这些指标。

- 准确率和召回率通常需要进行权衡,因为提高一个可能会导致另一个降低。F1分数作为两者的调和平均值,提供了一个平衡的单一指标。

- 在多标签学习中,可以针对每个标签单独计算这些指标,或者使用多标签版本的指标函数,如`sklearn`提供的`precision_score`、`recall_score`和`f1_score`函数支持多标签情况。

### 2.1.2 一分类指标

一分类指标(One-vs-All Metrics)在多标签学习场景中也常被使用,主要用于评估模型在处理各个单独标签上的表现。这些指标通常基于二分类指标进行计算,但在多标签环境中,每个标签被视为一个独立的二分类问题。

```python

# 计算一分类指标的示例代码

from sklearn.metrics import f1_score, precision_recall_curve

# 假设y_true和y_pred是针对单个标签的二分类问题的真实标签和预测概率

y_true = [1, 0, 1, 1, 0]

y_pred = [0.9, 0.1, 0.8, 0.65, 0.2]

# 计算每个阈值的精确率和召回率

precision, recall, thresholds = precision_recall_curve(y_true, y_pred)

# 计算F1分数

f1 = f1_score(y_true, y_pred)

print(f"F1 Score: {f1}")

```

上述代码通过`precision_recall_curve`函数计算了不同阈值下的精确率和召回率,并使用`f1_score`函数计算了F1分数。在多标签学习中,这样的计算需要对每一个标签分别进行。

- 一分类指标的重要之处在于,它们允许研究者和从业者评估模型在单个标签预测上的表现,而不用过分关注其他标签的影响。

- 可以通过调整阈值来控制模型预测每个标签的正负类结果,从而优化模型性能。

## 2.2 高级评估指标

### 2.2.1 标签排序指标

标签排序指标在多标签学习中用来衡量模型对于标签重要性的排序能力。这类指标关心的是,模型是否能够将相关的标签排在不相关标签之前。常见的标签排序指标包括标签排名平均准确率(Label Ranking Average Precision, LRAP)和排名损失(Ranking Loss)。

```python

# 计算标签排名平均准确率(LRAP)的示例代码

from sklearn.metrics import label_ranking_average_precision_score

# 假定y_true是真实标签的二进制指示矩阵,y_score是模型对标签排名的分数矩阵

y_true = [[1, 0, 0],

[0, 1, 1],

[1, 0, 1]]

y_score = [[0.75, 0.5, 0.25],

[0.5, 0.25, 0.75],

[0.25, 0.5, 0.75]]

lrap = label_ranking_average_precision_score(y_true, y_score)

print(f"Label Ranking Average Precision: {lrap}")

```

- LRAP是一种以标签排名为基础的评估指标,它通过考虑每个标签在所有样本中的排名位置来计算平均精确率。

- LRAP的值越接近1,表示模型对标签的预测排名越准确;0表示完全不准确。由于LRAP考虑了标签的相对重要性,它比传统的精确率、召回率更适用于多标签学习。

- 排名损失(Ranking Loss)也是常用的标签排序指标之一,它度量的是被错误排序的标签对的比例。较低的排名损失表示模型的排序性能较好。

### 2.2.2 包含指标

包含指标(Subset-based metrics)关注的是模型预测的标签集合与真实标签集合的重叠程度。常见的包含指标包括精确匹配率(Exact Match Ratio, EMR)、哈明距离(Hamming Loss)和汉明得分(Hamming Score)。

```python

# 计算汉明得分的示例代码

from sklearn.metrics import hamming_loss

# 假定y_true和y_pred为二进制指示矩阵形式的真实标签和预测标签

y_true = [[1, 0, 1],

[1, 1, 0],

[1, 0, 0]]

y_pred = [[1, 0, 0],

[1, 0, 1],

[0, 1, 0]]

hamming_loss_val = hamming_loss(y_true, y_pred)

print(f"Hamming Loss: {hamming_loss_val}")

```

汉明得分是通过计算错误预测标签的比例来评估模型性能,但它不同于汉明损失。汉明损失值越低,表示模型性能越好,而汉明得分则相反。

- 精确匹配率关注的是标签集合的完全匹配程度,如

0

0