模型泛化能力评估:交叉验证的正确打开方式

发布时间: 2024-09-02 10:08:44 阅读量: 51 订阅数: 44

# 1. 模型泛化能力的重要性与挑战

在构建机器学习模型的过程中,一个模型是否能在未知数据上表现良好是判断其成功与否的关键标准。这种在未见过的数据上进行正确预测的能力,被称为模型的泛化能力。然而,随着模型复杂度的增加,一个普遍的问题—过拟合(overfitting)也随之浮现,给模型的泛化能力带来了挑战。

过拟合是指模型在训练数据上拟合得太好,以至于它捕捉到了数据中的噪声和细节,而这些是无法推广到新的数据集的。这会导致模型在实际应用中性能下降,因为模型无法正确地识别出数据的新特征。

为了提高模型的泛化能力并解决过拟合问题,交叉验证成为了一个行之有效的策略。通过将数据集分成训练集和验证集,交叉验证能够帮助我们在有限的数据条件下更准确地评估模型的性能。本章将探讨泛化能力的重要性、过拟合问题以及交叉验证的相关理论,为后续章节的实践操作和高级应用打下坚实的基础。

# 2. 交叉验证理论基础

## 2.1 泛化能力与过拟合概念

### 2.1.1 泛化能力的定义

泛化能力是衡量机器学习模型性能的一个重要指标,它指的是模型对于未见示例的预测性能。一个具有强泛化能力的模型能够在训练数据上学习到本质的规律,并且能够很好地推广到新的、未知的数据上。理想的模型应该在训练集和测试集上都表现良好,但实际中往往难以达到完美平衡。

在机器学习中,我们追求的是一种状态,即模型在训练集上不过度拟合,又能保持足够的复杂度以捕获数据的真实规律,这样的模型才具有良好的泛化能力。

### 2.1.2 过拟合的产生原因及其影响

过拟合(Overfitting)是指模型在训练集上表现很好,但在新的、独立的测试集上表现不佳的现象。其产生的原因多种多样,包括但不限于以下几点:

1. 模型复杂度过高:模型可能包含了太多的参数,超过了实际数据所能提供的信息量,导致模型记忆了训练数据中的噪声和细节。

2. 训练数据不足:当训练数据相对模型参数过少时,模型无法泛化到新的数据。

3. 特征选择不当:包含无关的特征或者漏掉重要的特征都可能导致模型过拟合。

4. 训练时间过长:长时间的训练可能导致模型在训练数据上过度调整,而不是去学习泛化的规律。

过拟合会导致模型在实际应用中准确率低,泛化性能差,对于未见过的数据表现不佳,这是我们在使用交叉验证时需要特别关注并尽量避免的问题。

## 2.2 交叉验证的原理

### 2.2.1 训练集与测试集的划分

在机器学习中,数据集通常被分为训练集、验证集和测试集。训练集用于模型的训练过程,验证集用于调整模型的超参数和防止过拟合,测试集用于评估模型的最终性能。

交叉验证的原理正是基于将数据集划分为多个小的训练集和测试集,以增加模型训练和验证的次数,使模型在不同子集上的表现能更全面地评估模型的泛化能力。

### 2.2.2 交叉验证的目标与好处

交叉验证的主要目标是:

1. 减少模型评估的方差,提供更准确的模型性能估计。

2. 充分利用有限的数据进行有效训练和评估。

交叉验证的好处包括:

1. 提高模型评估的准确性:通过多次划分数据集,可以减少由于数据划分不同而导致的评估结果波动。

2. 合理利用数据资源:在数据量有限的情况下,交叉验证可以确保所有数据都用于模型训练和评估。

3. 减少模型选择的偏差:有助于更公平地比较不同的模型或算法。

## 2.3 常见交叉验证方法概览

### 2.3.1 留一法(LOO)

留一法(Leave-One-Out Cross-Validation,简称LOO)是一种极端的交叉验证方法,其中模型每次用除当前样本外的所有数据进行训练,然后对当前样本进行预测。这个过程重复n次,其中n为样本总数,因此会得到n个模型的预测结果。

LOO的优缺点如下:

**优点:**

- 对于数据量较小的数据集来说,LOO能够最大程度地利用数据。

- 每个样本都是在几乎整个数据集上训练得到的模型下进行预测,因此评估结果更可靠。

**缺点:**

- 计算成本非常高。因为需要训练n次模型,当数据量n很大时,计算开销巨大。

- 可能会受到离群点的影响。

### 2.3.2 K折交叉验证

K折交叉验证将数据集分成K个大小相似的互斥子集,每个子集尽可能保持数据分布的一致性。然后进行K次模型训练和评估,每次选择一个子集作为测试集,其余作为训练集。最终,模型的性能评价是通过这K次测试结果的平均值来确定。

K折交叉验证的主要参数是折数K,常见的选择有3、5、10等。选择合适的K值是关键,需要在计算成本和评估准确性之间寻找平衡点。

### 2.3.3 分层K折交叉验证

分层K折交叉验证在K折交叉验证的基础上考虑了数据集中的类别分布。在数据集被分成K个子集后,保证每个子集中各类别的比例大致相同。这对于类别不平衡的问题特别有效。

分层K折交叉验证适用于数据集中的标签类别分布不均匀的情况,可以确保每个类别在不同折中都能得到合理的评估,从而提高模型的泛化能力。

在本章节中,我们了解了交叉验证的理论基础,包括泛化能力的定义、过拟合的产生原因及其影响、交叉验证的原理、目标和好处,以及常见的交叉验证方法。这些理论知识是进行交叉验证操作的基础,也是进一步理解和实践交叉验证的关键。

下节将继续深入探讨交叉验证的实践操作,包括具体的实现步骤和评估指标的选择与应用,并通过代码实现展示如何在实践中应用交叉验证方法。

# 3. 交叉验证实践操作

## 3.1 交叉验证的实现步骤

### 3.1.1 数据预处理

数据预处理是交叉验证的第一步,也是决定模型性能的关键步骤。在实际应用中,数据预处理包括清洗数据,处理缺失值,数据标准化或归一化,特征选择与提取,以及数据集的拆分。

具体操作步骤包括:

- 清洗数据:移除或填补异常值,处理重复记录等。

- 缺失值处理:通过均值、中位数填充,或者更复杂的算法预测缺失值。

- 特征转换:数据标准化或归一化,如使用最小-最大归一化或Z-score标准化,以减少不同量纲特征对模型的影响。

- 特征选择:使用诸如主成分分析(PCA)等方法进行特征降维。

数据集的拆分需要在交叉验证过程中进行多次,以确保每次都能使用不同的数据子集作为训练集和验证集。这样可以在不同的训练集上训练模型,以获得对模型泛化能力更为可靠的估计。

### 3.1.2 模型选择与训练

模型选择依赖于问题的类型以及数据的特性。选择合适的模型是达到良好泛化能力的关键一步。在确定了模型之后,通过交叉验证来训练和评估模型是至关重要的。

交叉验证训练模型的一般步骤如下:

1. 拆分数据集:将数据集拆分为训练集和测试集,确保训练集用于模型的训练,而测试集用于评估模型的最终性能。

2. 交叉验证过程:在训练集上执行交叉验证,重复多次,每次保留一部分数据作为验证集,其余作为训练数据。

3. 模型参数调整:在每次交叉验证的迭代中,调整模型参数以获取最佳性能。

4. 最终模型训练:使用交叉验证结果,选择最优的参数配置,在全部训练数据上重新训练模型。

## 3.2 评估指标选择与应用

### 3.2.1 准确率、精确率与召回率

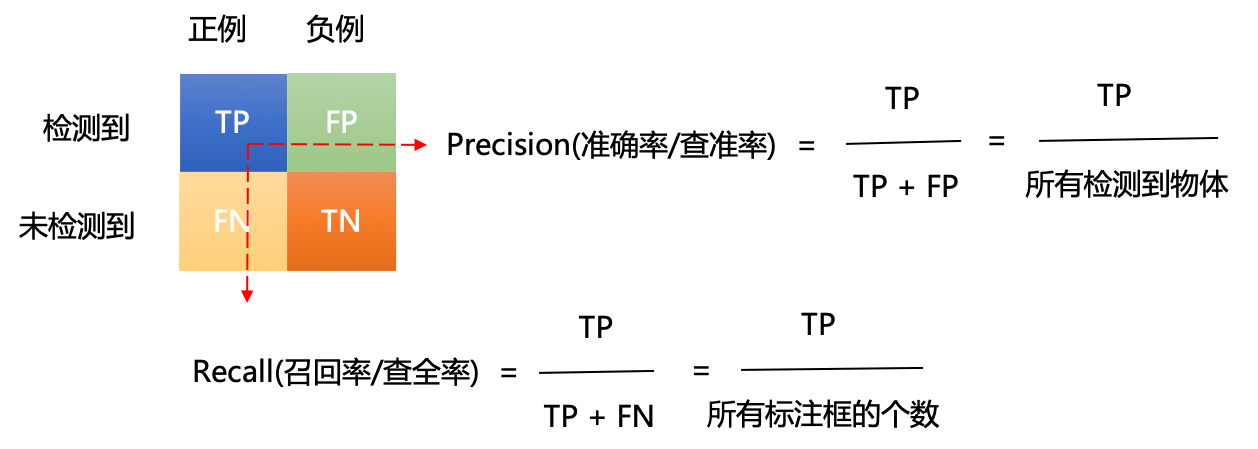

在分类问题中,准确率(Accuracy),精确率(Precision),和召回率(Recall)是三个常用的评估指标。它们从不同的角度描述了分类器的性能。

- **准确率**是被正确预测的样本数占总样本数的比例。

$$ Accuracy = \frac{TP + TN}{TP + TN + FP + FN} $$

- **精确率**是正确预测为正的样本数占所有预测为正的样本数的比例。

$$ Precision = \frac{TP}{TP + FP} $$

- **召回率**也叫真正率,是正确预测为正的样本数占所有实际为正的样本数的比例。

$$ Recall = \frac{TP}{TP + FN} $$

在实际应用中,通常会根据业务需求选择适当的指标。例如,在欺诈检测中,召回率可能更为重要,因为避免漏掉真正的欺诈案件至关重要。

### 3.2.2 ROC曲线与AUC值

**ROC曲线**(接收者操作特征曲线)是一个非常直观的工具,用于评估分类器性能。它通过绘制真正率(TPR)和假正率(FPR)来展示模型在不同阈值下的分类表现。

**AUC值**(Area Under Curve)表示ROC曲线下的面积。AUC值越接近于1,表示分类器的性能越好。

## 3.3 交叉验证的代码实现

### 3.3.1 使用Python的Scikit-learn库

0

0