大数据安全策略:Bloom Filter如何在保护数据隐私中发挥作用

发布时间: 2024-10-31 16:42:33 阅读量: 23 订阅数: 16

一种基于BloomFilter的改进型加密文本模糊搜索机制研究

# 1. 大数据安全策略概述

随着信息技术的飞速发展,大数据安全成为全球关注的焦点。大数据安全策略是保障个人隐私、企业秘密和国家安全的重要保障。有效的安全策略不仅需要防范外部的恶意攻击,还需要在数据处理、存储、传输等各个环节进行严密防护。大数据安全策略包括但不限于数据加密、访问控制、安全审计和数据脱敏等方面。

在大数据环境下,数据隐私保护尤为重要。一方面,个人用户担心其隐私数据被滥用;另一方面,企业在处理敏感信息时必须符合相关法规要求,如欧盟的GDPR规定。大数据安全策略应能平衡业务需求和隐私保护之间的关系,确保数据在采集、处理和分享过程中的安全性。

因此,本章将概述大数据安全策略的重要性、基本要求和应对措施,为后续深入探讨特定技术在数据隐私保护中的应用打下坚实的基础。

# 2. Bloom Filter基础理论

### 2.1 Bloom Filter的定义和原理

#### 2.1.1 Bloom Filter的数学原理

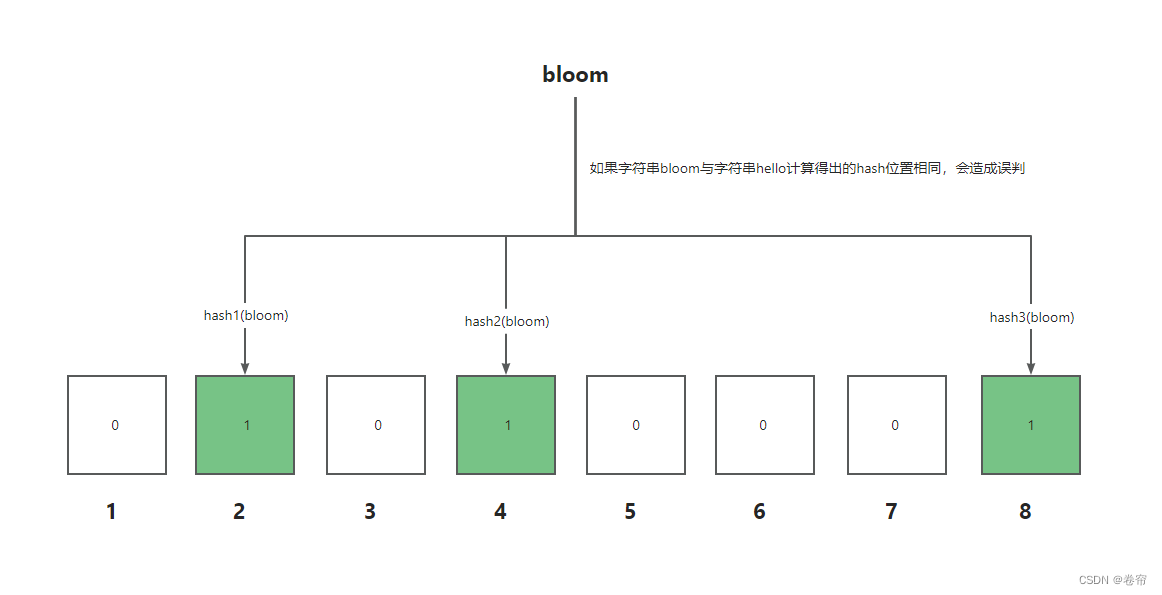

Bloom Filter是一种空间效率极高的概率型数据结构,用于判断一个元素是否在一个集合中。它的核心思想是利用多个哈希函数将元素映射到位数组中的多个位置,通过这些位置的标记状态来判断元素是否存在。

数学上,一个Bloom Filter包含一个长度为m的位数组和k个独立的哈希函数,每个哈希函数将元素映射到位数组的一个位置。当添加元素时,通过k个哈希函数计算得到k个位置,并将这些位置标记为1。查询元素是否存在时,同样利用k个哈希函数计算k个位置,如果所有位置都是1,则认为元素可能存在于集合中,否则元素一定不在集合中。需要注意的是,这种判断有可能出现假阳性(false positive),即认为元素在集合中,而实际上它不在。

#### 2.1.2 过滤器的工作机制

Bloom Filter的工作机制可以分为以下几个步骤:

1. 初始化:创建一个长度为m的位数组,并选择k个哈希函数。

2. 添加元素:对于每个要添加的元素,计算k个哈希值,将对应位数组位置标记为1。

3. 查询元素:对于每个待查询元素,同样计算k个哈希值,检查对应位数组位置。如果所有位置都是1,返回可能存在;如果任何一个位置是0,则返回元素一定不在集合中。

### 2.2 Bloom Filter的概率模型

#### 2.2.1 错误正率的概念

错误正率(false positive probability),即误判率,是Bloom Filter中最重要的指标之一。它表示当查询一个元素不在集合中时,位数组返回元素存在的概率。在理想情况下,一个Bloom Filter的错误正率可以通过以下公式计算:

\[ P_{FP} = \left(1 - e^{-kn/m}\right)^k \]

其中,\( k \)是哈希函数的数量,\( n \)是插入元素的数量,\( m \)是位数组的长度。随着元素数量的增加,错误正率会逐渐增大。

#### 2.2.2 比特向量长度与哈希函数数量的选择

为了保持一个较低的错误正率,选择合适的位数组长度\( m \)和哈希函数数量\( k \)是至关重要的。一般而言,\( k \)和\( m \)的选择应遵循以下原则:

- \( m \)和\( n \)应足够大,以容纳预期的元素数量。

- \( k \)应选择为\( m/n \)的对数,这样可以最小化错误正率。

下面的表格展示了几种不同\( m \)和\( n \)组合下的\( k \)值选择,以实现最低的错误正率。

| n (元素数量) | m (位数组长度) | k (哈希函数数量) | 预期错误正率 |

|--------------|-----------------|-------------------|--------------|

| 10 | 100 | 6 | 2.4% |

| 100 | 1,000 | 10 | 2.9% |

| 1,000 | 10,000 | 14 | 2.8% |

### 2.3 Bloom Filter的变种与优化

#### 2.3.1 Counting Bloom Filter

Counting Bloom Filter是Bloom Filter的一种扩展,通过使用计数器来替换位数组中的位,可以支持删除操作。每个计数器可以增加或减少,这样就可以在插入和删除时更新计数器的值。Counting Bloom Filter解决了传统Bloom Filter无法删除元素的问题,同时也降低了错误正率,但增加了空间开销。

#### 2.3.2 Scalable Bloom Filter

Scalable Bloom Filter是一种自适应的Bloom Filter,它在初始的Bloom Filter达到其最大容量后,会自动增加新的Bloom Filter来扩展。这种方法不需要预先知道集合的大小,同时通过控制新旧Bloom Filter的插入速度和过滤器的紧凑度来保持一个稳定的错误正率。

#### 2.3.3 分布式Bloom Filter

分布式Bloom Filter将Bloom Filter的概念扩展到分布式环境中,允许多个节点共享Bloom Filter。在分布式系统中,各个节点可以通过网络查询和更新Bloom Filter,实现了数据的分布式过滤。这种结构适用于需要在多个机器上进行高速查询和过滤的场景。

```mermaid

graph LR

A[客户端请求] -->|发送查询| B(分布式Bloom Filter)

B -->|查询结果| A[客户端]

C[新数据项] -->|更新| B(分布式Bloom Filter)

```

### 2.1.3 示例代码

下面是一个简单的Bloom Filter的Python实现:

```python

import mmh3

from bitarray import bitarray

class BloomFilter:

def __init__(self, items_count, fp_prob):

self.fp_prob = fp_prob

self.size = self.get_size(items_count, fp_prob)

self.hash_count = self.get_hash_count(self.size, items_count)

self.bit_array = bitarray(self.size)

self.bit_array.setall(0)

def add(self, item):

digests = []

for i in range(self.hash_count):

digest = mmh3.hash(item, i) % self.size

digests.append(digest)

self.bit_array[digest] = True

def check(self, item):

for i in range(self.hash_count):

digest = mmh3.hash(item, i) % self.size

if self.bit_array[digest] == False:

return False

return True

@classme

```

0

0