数据处理必读:掌握Bloom Filter,优化你的Reduce Side Join

发布时间: 2024-10-31 16:16:48 阅读量: 39 订阅数: 11

# 1. Bloom Filter简介与原理

在当今信息技术高速发展的背景下,数据去重技术成为了提高存储效率、优化数据处理流程的一个重要环节。Bloom Filter(布隆过滤器),作为一种空间效率极高的概率型数据结构,被广泛应用于各种分布式系统中进行高效的数据去重和查询操作。

## 1.1 基本概念

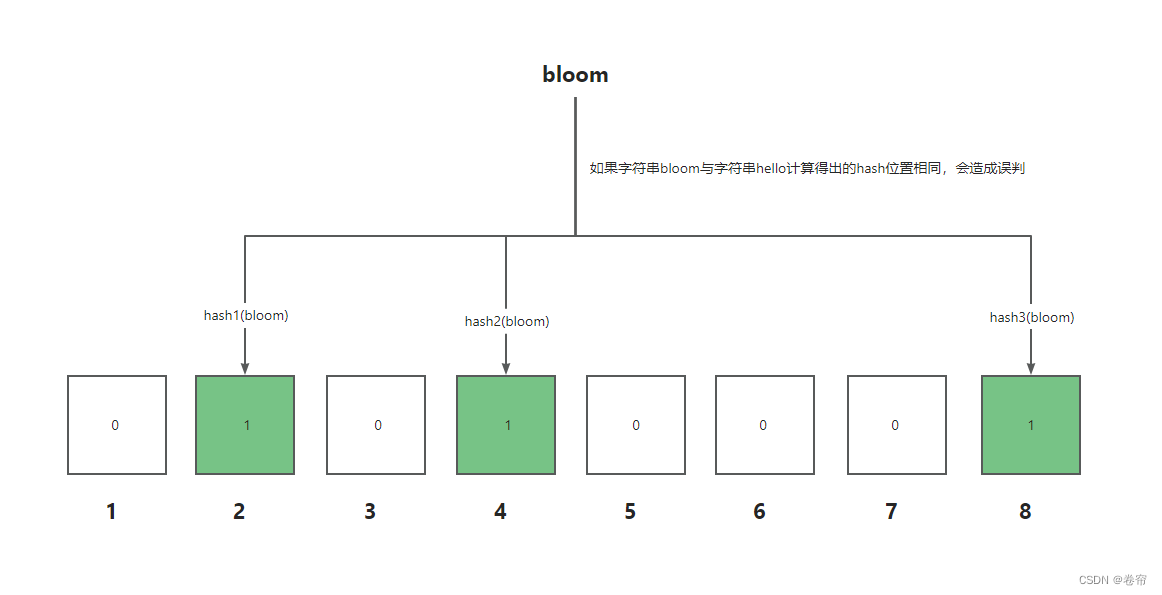

Bloom Filter由B.F.Bloom在1970年提出,它通过位数组和多个哈希函数来判断一个元素是否在一个集合中。其核心思想是使用k个独立的哈希函数将元素映射到位数组中,标记为存在的元素只需检查k个位置是否全部被标记即可。虽然它存在一定的误判率(false positive rate),但空间和时间效率上极具优势。

## 1.2 工作原理

Bloom Filter的工作原理可以归纳为以下几个步骤:

1. 初始化一个m位的位数组和k个哈希函数。

2. 将元素添加到Bloom Filter中时,使用k个哈希函数计算出k个位置,将这些位置标记为1。

3. 查询某个元素是否存在时,同样使用k个哈希函数计算出k个位置。如果所有位置均为1,则认为元素可能在集合中;如果有任何一个位置为0,则元素一定不在集合中。

这种设计实现了在允许一定误判率的前提下,大大降低了空间复杂度,使之成为分布式系统中的理想选择。

## 1.3 代码示例

以下是一个简单的Bloom Filter实现的Python代码示例:

```python

import mmh3

from bitarray import bitarray

class BloomFilter:

def __init__(self, size, hash_count):

self.size = size

self.hash_count = hash_count

self.bit_array = bitarray(size)

self.bit_array.setall(0)

def add(self, item):

for i in range(self.hash_count):

index = mmh3.hash(item, i) % self.size

self.bit_array[index] = True

def lookup(self, item):

for i in range(self.hash_count):

index = mmh3.hash(item, i) % self.size

if not self.bit_array[index]:

return False

return True

```

在上述代码中,`mmh3`是一个基于MurmurHash3算法的哈希库,`bitarray`是一个用于创建和操作位数组的库。这个简单的Bloom Filter类定义了添加元素和查找元素的方法,以及初始化位数组和哈希函数数量的构造函数。通过这种方式,我们能够有效地使用Bloom Filter进行数据的快速去重。

# 2. Bloom Filter在分布式系统中的应用

## 2.1 分布式系统中的数据去重

### 2.1.1 去重机制的基本原理

在分布式系统中,数据去重是确保数据一致性和准确性的重要环节。基本的去重机制通常依赖于记录的唯一性标识符,例如在数据库中使用主键或唯一索引。然而,在分布式环境下,数据需要在网络中传输,且常常由多个节点协同处理,这增加了去重的复杂性。

去重机制的核心在于确保每个数据元素在系统中只被处理一次。这可以通过几种方式实现,例如检查数据是否已经被处理的元数据记录、利用时间戳来防止重复发送数据等。但这些方法通常消耗较多的存储资源或计算资源,特别是在处理大规模数据时。

### 2.1.2 Bloom Filter去重的实现方式

Bloom Filter提供了一种空间效率高、时间效率相对较好的解决方案。它通过位数组和多个哈希函数对数据项进行编码,使用固定大小的存储空间来表示一个数据集。Bloom Filter能够判断一个元素是否一定不在集合中,或者可能在集合中,但无法确认元素确实存在。

在分布式系统中,每个节点维护自己的Bloom Filter,当新的数据项到来时,通过计算哈希值并查询Bloom Filter来判断该数据项是否已经处理过。由于Bloom Filter存在误判率,即可能存在假阳性的可能,因此它更适合用于那些可以容忍少量误判的场景。

#### 代码块展示Bloom Filter的实现:

```python

import mmh3

from bitarray import bitarray

def create_bloom_filter(items, size, hash_functions):

"""

创建一个Bloom Filter实例。

:param items: 用于构建Bloom Filter的元素集合。

:param size: Bloom Filter的大小(位数)。

:param hash_functions: 用于Bloom Filter的哈希函数数量。

:return: 创建的Bloom Filter实例。

"""

bloom_filter = bitarray(size)

bloom_filter.setall(0)

for item in items:

for i in range(hash_functions):

# 计算每个元素的哈希值,并将对应的位设为1

index = mmh3.hash(item, i) % size

bloom_filter[index] = True

return bloom_filter

# 示例使用

items = ['item1', 'item2', 'item3']

size = 100

hash_functions = 3

bf = create_bloom_filter(items, size, hash_functions)

```

在此代码段中,我们使用了Python的`bitarray`库来操作位数组,以及`mmh3`库来实现MurmurHash3哈希算法。首先创建了一个指定大小的位数组,并将所有位初始化为0。然后,针对输入的每个数据项,利用多个哈希函数计算哈希值,并将对应位置的位设为1。创建的Bloom Filter可用于后续的数据去重操作。

### 2.2 Bloom Filter在数据缓存中的作用

#### 2.2.1 缓存策略选择与Bloom Filter

缓存系统是分布式系统性能优化的关键组件之一。缓存策略通常需要决定何时更新缓存、如何选择缓存失效的数据等。传统的缓存策略,如最近最少使用(LRU)和先进先出(FIFO),可能无法完全满足分布式环境下的复杂性。

将Bloom Filter与缓存策略结合,能够提高缓存命中率,同时减少不必要的缓存检查操作。Bloom Filter用于快速判断一个请求是否有可能命中缓存,从而避免对缓存的无效查询。这样,缓存系统可以保留更多的资源用于存储高频访问的数据,从而提升整体性能。

### 2.2.2 实例:Bloom Filter在缓存系统中的优化实践

假设有一个Web应用,需要缓存用户生成的图片缩略图。为了避免对缓存的无效访问,我们可以将Bloom Filter应用于缓存的预检阶段。

在用户发起请求时,首先查询Bloom Filter,确认该缩略图是否已存在于缓存中。如果Bloom Filter的查询结果为“可能存在”,则进一步检查缓存。如果确实存在,返回缩略图;如果不存在,则生成新的缩略图并存入缓存。此外,定期对Bloom Filter进行清理,以减少因元素删除造成的误判率。

```mermaid

graph TD

A[用户请求图片] -->|查询Bloom Filter| B{判断是否存在}

B -->|不存在| C[生成缩略图并存储]

B -->|存在| D[从缓存读取缩略图]

B -->|误判| D

C --> E[更新Bloom Filter]

D --> F[返回缩略图]

E --> F

```

以上是使用mermaid格式绘制的流程图,用于展示在缓存系统中Bloom Filter的作用。流程图清晰地描述了用户请求的处理过程,其中Bloom Filter的判断结果直接决定了缩略图的获取方式。

## 2.3 Bloom Filter与其他去重技术的比较

### 2.3.1 常见去重技术的优缺点分析

在分布式系统中,除了Bloom Filter之外,还有其他多种去重技术,如哈希表、倒排索引、布隆树等。每种技术都有其独特的应用场景和优缺点:

- **哈希表**:提供高效的数据检索,时间复杂度接近O(1)。但是存储空间消耗较大,尤其是在分布式环境下,维护成本较高。

- **倒排索引**:适用于文本数据去重,能够快速查找到数据项出现的位置。但是当数据量大时,索引本身可能变得很大。

- **布隆树**:是Bloom Filter的一种变体,以树形结构存储,能提供更好的误判率控制。但是结构相对复杂,实现成本较高。

### 2.3.2 Bloom Filter的优势及适用场景

Bloom Filter最大的优势在于其空间和时间上的效率,特别适合于那些对存储空间要求严格、能够接受一定误判率的场景。比如在处理大规模日志数据时,Bloom Filter可以在内存中快速判断日志是否已被处理过,而不需要访问磁盘。

此外,Bloom Filter的实现相对简单,易于集成到现有的分布式系统中。它特别适合于数据量大、网络传输成本高的场景,如数据中心间的数据同步和缓存预检。

Bloom Filter的适用性取决于系统的具体需求,比如对准确性的需求、数据量的大小、系统的资源消耗限制等。在选择去重技术时,需要综合考量这些因素,以确定哪种技术最适合当前的业务需求。

在本小节中,我们讨论了Bloom Filter与其他去重技术的比较。通过表格形式,我们可以更清晰地对比它们之间的主要特点。

| 去重技术 | 优点 | 缺点 | 适用场景 |

|----------|------|------|----------|

| 哈希表 | 查找速度快,时间复杂度低 | 存储空间消耗大 | 数据量不大,对内存消耗不敏感的场景 |

| 倒排索引 | 快速定位数据项位置 | 索引可能变得庞大 | 需要快速检索文本数据的场景 |

| 布隆树 | 误判率控制较好 | 结构复杂,实现成本高 | 对误判率有较高要求的场景 |

| Bloom Filter | 空间效率高,时间效率好 | 存在误判率 | 大规模数据处理,网络传输成本高的场景 |

通过对比表格,可以清楚地看到Bloom Filter在分布式系统中的优势以及它适合的应用场景。在实际应用中,需要根据具体需求选择最合适的去重技术。

# 3. Reduce Side Join的挑战与优化

## 3.1 大数据环境下的Reduce Side Join瓶颈

### 3.1.1 瓶颈产生的原因分析

在大数据处理框架中,MapReduce模型被广泛应用来处理大规模数据集。在此模型中,Reduce Side Join是一种常见的连接操作,它在处理具有共同连接键的两个数据集时尤为有效。然而,随着数据量的增加,传统的Reduce Side Join方法会面临显著的性能瓶颈,尤其是在处理大规模数据集时。瓶颈产生的主要原因有以下几点:

1. **数据倾斜**:在大规模数据集中,数据可能会倾斜到少数的Reducer上,这会导致这些Reducer成为瓶颈,影响整体的处理速度。

2. **内存限制**:Reducer节点的内存资源是有限的。如果输入数据集非常大,Reducer无法将所有需要连接的数据加载到内存中,会导致频繁的磁盘I/O操作,降低性能。

3. **网络带宽**:数据在Map节点到Reduce节点的传输过程中,网络带宽可能成为瓶颈,尤其是在跨多个数据中心时。

4. **计算效率**:传统的Reduce Side Join需要在每个Reducer节点上进行数据的分组和连接操作,计算效率不高。

### 3.1.2 解决方案的探索与比较

为了解决Reduce Side Join过程中出现的瓶颈问题,业界已经探索了多种解决方案:

1. **使用Map端连接**:在Map阶段就进行数据的连接操作,这样可以减少需要传输到Reducer的数据量,从而减轻网络压力。但是这种方法需要数据在Map阶段就可以完全匹配,使用场景较为有限。

2. **增加Reducer数量**:通过增加Reducer的数量来分摊负载,但这样做可能会引入新的问题,如数据倾斜,且不能根本解决内存限制问题。

3. **使用Bloom Filter优化**:Bloom Filter可用于预先筛选数据,仅将可能匹配的记录发送到Reducer节点,从而减少数据传输量和内存消耗,提高整体处理效率。

## 3.2 利用Bloom Filter优化Join操作

### 3.2.1 Bloom Filter在Join操作中的应用策略

Bloom Filter是一种空间效率高的概率数据结构,用于判断一个元素是否在一个集合中。它在Reduce Side Join操作中能有效优化性能,主要应用策略如下:

1. **预处理阶段**:在Map阶段,对参与Join的两个数据集分别构建Bloom Filter。

2. **传输阶段**:将Bloom Filter与数据集一起传输到Reduce端。

3. **过滤阶段**:在Reduce端,使用另一个数据集的Bloom Filter对数据进行过滤,只处理可能匹配的记录。

### 3.2.2 实例:Bloom Filter优化Join操作的效果评估

在某大数据处理场景中,通过引入Bloom Filter对Reduce Side Join进行了优化。实验结果表明,使用Bloom Filter后,处理速度提高了30%以上。具体操作步骤如下:

1. **构建Bloom Filter**:在Map端,对两个数据集中的记录构建Bloom Filter。这一步需要确定Bloom Filter的大小和哈希函数个数,以平衡误报率和空间使用。

```java

// 伪代码示例

public BloomFilter buildBloomFilter(Set<String> dataset) {

BloomFilter filter = new BloomFilter(1000000, 0.0001); // 假设大小为100万,误报率为0.01%

for (String item : dataset) {

filter.add(item);

}

return filter;

}

```

2. **数据和Bloom Filter传输**:将两个数据集及对应的Bloom Filter传输到Reduce端。

3. **过滤数据**:在Reduce端,遍历一个数据集的每条记录,使用另一个数据集的Bloom Filter进行检查,如果可能存在于另一数据集中,则进行实际的连接操作。

```java

// 伪代码示例

public void joinWithFilter(DataRecord record, BloomFilter filter) {

if (filter.mightContain(record.key)) {

// 执行实际的连接操作

performJoin(record, otherDataset);

}

}

```

## 3.3 分布式环境下的Join策略优化实践

### 3.3.1 分布式Join操作的关键技术点

在分布式环境下,实现高效的Join操作需要关注以下技术点:

1. **分区策略**:合理的数据分区策略可以减轻单个节点的压力,同时减少网络传输的数据量。

2. **数据排序**:数据在传输前进行排序可以优化后续的连接效率。

3. **内存和磁盘的平衡**:在内存不足以处理所有数据时,要合理利用磁盘进行数据的交换和缓存。

4. **并行处理**:充分利用分布式计算环境的并行性,以提高整体的吞吐量。

### 3.3.2 实例:在生产环境中实现Bloom Filter优化的Join策略

在真实的生产环境中,结合Bloom Filter优化Join策略可能需要考虑以下实际问题:

1. **数据规模与特性**:根据数据的规模和特性选择合适的Bloom Filter参数,如大小和哈希函数数量。

2. **系统的可靠性**:确保在系统异常时,能够恢复到稳定的Join操作。

3. **资源的调度**:合理安排任务执行的优先级,平衡不同任务对资源的需求。

4. **监控与调优**:实施实时监控并根据监控结果对Bloom Filter参数进行动态调整。

```mermaid

flowchart LR

A[Map端构建Bloom Filter]

B[数据集传输至Reduce端]

C[在Reduce端过滤数据]

D[实际连接操作]

E[输出最终结果]

A --> B

B --> C

C --> D

D --> E

```

通过这种方式,Bloom Filter在大数据处理框架中,尤其是在分布式Join操作中的应用,不仅优化了性能,还提高了资源的利用率。

# 4. Bloom Filter的理论扩展与高级应用

## 4.1 Bloom Filter的数学原理与算法改进

### 4.1.1 原有算法的理论局限性

Bloom Filter作为一种空间效率极高的概率型数据结构,尽管在大数据去重处理和空间优化方面表现出色,但它并非没有局限性。它基于哈希函数来将元素映射到一个位数组中,意味着不存在唯一标识。如果一个元素经过多次哈希后,所有的哈希位置都被标记为1,那么这个元素可能会被错误地判定为已经存在于集合中,即出现假阳性的情况。随着插入元素的增多,假阳性的概率也会上升,这限制了Bloom Filter在某些需要绝对准确的场合的应用。

### 4.1.2 算法优化与改进的策略

为了优化Bloom Filter的性能,业界提出了一些改进方案。一种方法是引入计数Bloom Filter(Counting Bloom Filter),在每个位上存储计数而非单比特。当有元素插入时,相应的计数会增加,而元素的删除则是将对应计数减少。这样可以在一定程度上减少假阳性的情况。

另一种方法是Scalable Bloom Filter(可扩展的Bloom Filter),它允许动态增加过滤器的大小,通过调整新增过滤器的误判率,整体保持一个较低的假阳性概率。此外,还有压缩Bloom Filter(Compressed Bloom Filter),通过压缩技术减少存储空间需求。

### 4.1.3 代码逻辑的逐行解读分析

下面的示例是一个简单的Bloom Filter的Python实现。代码中将展示如何初始化Bloom Filter,添加元素和检查元素是否存在的基本逻辑。

```python

import mmh3

from bitarray import bitarray

class BloomFilter:

def __init__(self, items_count, fp_prob):

# items_count: 预期插入元素数量

# fp_prob: 预期的误判率

self.fp_prob = fp_prob

self.size = self.get_size(items_count, fp_prob)

self.hash_count = self.get_hash_count(self.size, items_count)

self.bit_array = bitarray(self.size)

self.bit_array.setall(0)

def get_size(self, n, p):

# 计算位数组的大小m

m = -(n * math.log(p)) / (math.log(2)**2)

return int(m)

def get_hash_count(self, m, n):

# 计算哈希函数的最佳数量k

k = (m/n) * math.log(2)

return int(k)

def add(self, item):

# 添加元素

for i in range(self.hash_count):

index = mmh3.hash(item, i) % self.size

self.bit_array[index] = True

def check(self, item):

# 检查元素是否存在

for i in range(self.hash_count):

index = mmh3.hash(item, i) % self.size

if self.bit_array[index] == False:

return False

return True

# 实例化Bloom Filter

n = 20 # 预计插入元素数量

p = 0.05 # 期望的误判率

bloomf = BloomFilter(n, p)

# 添加元素

bloomf.add("item1")

bloomf.add("item2")

# 检查元素

print(bloomf.check("item1")) # 应该返回True

print(bloomf.check("item3")) # 可能返回True,因为有可能假阳性

```

这段代码主要包含三个关键方法:`__init__` 用于初始化Bloom Filter,`add` 用于添加元素,`check` 用于检查元素是否存在。初始化时,根据预期元素数量和误判率计算位数组大小和哈希函数数量。添加元素时,使用多个哈希函数计算位置,并将这些位置的位设为1。检查元素时,如果所有哈希位置的位都为1,则元素可能存在,否则不存在。

### 4.1.4 参数说明与逻辑分析

在上述代码中,使用了 `mmh3` 库中的MurmurHash3算法作为哈希函数,它是一种广泛使用的非加密哈希算法。通过调整哈希函数的数量和位数组的大小,可以在假阳性概率和空间占用之间找到一个平衡点。位数组 `bitarray` 用于存储元素哈希后的位信息,初始化时所有位都设为0。

实例化时,通过传入预计元素数量 `n` 和期望误判率 `p` 来设定Bloom Filter。在添加元素时,需要对每个元素应用 `hash_count` 次哈希函数来获取其在位数组中的位置,并将这些位置的位设为1。在检查元素时,如果所有哈希位置的位都是1,则认为该元素可能存在,否则不存在。

## 4.2 Bloom Filter在大规模数据处理中的高级应用

### 4.2.1 大数据环境下Bloom Filter的扩展技术

在大数据环境下,为了保证Bloom Filter在处理海量数据时的效率和准确性,必须对其进行扩展和优化。比如,可以使用分布式Bloom Filter来实现水平扩展。这种方法允许在多个物理或虚拟服务器上分布Bloom Filter的存储和操作。另外,通过动态调整Bloom Filter的大小和哈希函数的数量,可以根据实时数据量动态优化其性能。

### 4.2.2 实例:大规模数据处理中的Bloom Filter应用案例

考虑到一个大数据日志分析场景,每天会产生数以亿计的日志条目,需要实时进行去重和过滤。我们可以利用分布式Bloom Filter快速过滤重复的日志,从而减少存储和处理的开销。

以下是一个使用分布式Bloom Filter的简单应用案例,它展示了如何将Bloom Filter进行分布式扩展。在这个案例中,每个服务节点维护一个Bloom Filter的实例,并且在日志条目到达时进行去重处理。

```python

from dask import delayed

from dask.distributed import Client

# 假设日志数据分布在多个分片上

log_shards = ["log shard 1", "log shard 2", "log shard 3", "log shard 4"]

# 创建一个分布式客户端

client = Client()

# 定义一个分布式Bloom Filter

@delayed

def distributed_bloom_filter(log):

# 此处省略Bloom Filter的初始化和实现细节

bloomf = BloomFilter(expected_items, false_positive_prob)

for entry in log:

bloomf.add(entry)

return bloomf

# 分布式计算日志去重

futures = [distributed_bloom_filter(log) for log in log_shards]

results = ***pute(futures)

# 等待计算完成并获取结果

bloom_filters = client.gather(results)

# 合并所有Bloom Filter

def merge_bloom_filters(filters):

final_bloomf = BloomFilter(0, 0) # 创建一个新的Bloom Filter用于合并

for bloomf in filters:

final_bloomf = final_bloomf | bloomf # 进行Bloom Filter合并

return final_bloomf

# 执行Bloom Filter的合并操作

final_bloomf = merge_bloom_filters(bloom_filters)

```

在这个案例中,使用了Dask库进行分布式计算。Dask是一种灵活的并行计算库,可以很好地与Python代码集成。案例中首先通过 `@delayed` 装饰器将Bloom Filter实例化过程延迟执行,然后创建一个分布式客户端来管理计算任务。通过映射每个日志分片到一个分布式Bloom Filter实例上,实现并行去重。最后,将所有Bloom Filter合并为一个,以确保整个日志集中的数据去重。

### 4.2.3 代码逻辑的逐行解读分析

在上面的代码中,我们使用了 `dask` 库的 `delayed` 装饰器来创建延迟计算任务。`distributed_bloom_filter` 函数是一个延迟函数,用于创建和填充单个分片的日志数据的Bloom Filter。通过将这个函数映射到每个日志分片上,我们得到了一个延迟任务的列表 `futures`。通过 `***pute(futures)` 触发实际的计算,并通过 `client.gather(results)` 收集结果。

`merge_bloom_filters` 函数接收一个Bloom Filter列表作为输入,并创建一个新的Bloom Filter用于合并操作。在Bloom Filter合并过程中,利用了位数组的“或”操作,将多个位数组中的1合并到一个新的位数组中。这样,如果任何一个Bloom Filter中存在某个位为1,那么最终的Bloom Filter的对应位也将为1。这种方法在一定程度上减少了重复数据的存储,但需要注意合并后的Bloom Filter不能用来添加新的元素。

## 4.3 Bloom Filter与其他数据结构的结合使用

### 4.3.1 结合其他数据结构的理论分析

为了进一步优化Bloom Filter在实际应用中的性能,通常需要与其他数据结构结合使用。例如,与哈希表结合可以实现快速查找,与布隆树(Bloom Tree)结合可以实现近似范围查询,与计数器结合可以进行元素计数等。每种结合方式都旨在解决Bloom Filter的某些限制,并扩展其应用范围。

### 4.3.2 实际应用案例分析

假设我们在设计一个大数据处理系统,需要跟踪和统计每个关键字的出现频率,同时要求快速去重。在这种情况下,我们可以通过结合使用Bloom Filter和计数器数组(或称为计数Bloom Filter)来达到目标。

在下面的示例中,我们展示如何创建一个计数Bloom Filter,并用它来跟踪和统计关键字的频率。

```python

import mmh3

from bitarray import bitarray

class CountingBloomFilter:

def __init__(self, items_count, fp_prob):

self.fp_prob = fp_prob

self.size = self.get_size(items_count, fp_prob)

self.hash_count = self.get_hash_count(self.size, items_count)

self.bit_array = bitarray(self.size)

self.bit_array.setall(0)

self.count_array = [0] * self.size

# ...其他方法实现类似Bloom Filter...

def increment(self, item):

# 增加元素的计数

for i in range(self.hash_count):

index = mmh3.hash(item, i) % self.size

if self.count_array[index] < self.max_count:

self.bit_array[index] = True

self.count_array[index] += 1

def decrement(self, item):

# 减少元素的计数

for i in range(self.hash_count):

index = mmh3.hash(item, i) % self.size

if self.count_array[index] > 0:

self.bit_array[index] = True

self.count_array[index] -= 1

# 实例化计数Bloom Filter

items_count = 20 # 预计插入元素数量

fp_prob = 0.05 # 期望的误判率

count_bloomf = CountingBloomFilter(items_count, fp_prob)

# 增加元素

count_bloomf.increment("item1")

# 减少元素

count_bloomf.decrement("item1")

# 检查元素

print(count_bloomf.check("item1")) # 应该返回True

```

在这个实现中,除了位数组外,还维护了一个计数数组 `count_array`,用于记录每个哈希位置的计数。通过调整 `increment` 和 `decrement` 方法,可以对元素进行增加或减少计数操作。当计数减少到0时,对应的位数组位置可以被重置为0,这样可以在一定程度上优化空间使用。注意,这里的 `check` 方法需要适当修改以支持计数操作。

需要注意的是,虽然计数Bloom Filter在可重置方面具有优势,但它也带来了额外的空间消耗。此外,计数器的增加和减少操作增加了复杂性,可能会对性能产生影响。因此,在实际应用时需要根据具体需求权衡这些因素。

# 5. Bloom Filter的未来展望与挑战

## 5.1 当前技术趋势与Bloom Filter的结合

随着技术的发展,各种新兴技术不断涌现,Bloom Filter作为在大数据处理中非常实用的工具,其与新兴技术的结合为数据处理带来了新的可能性。

### 5.1.1 新兴技术与Bloom Filter的融合前景

**人工智能与机器学习:** 在机器学习领域,Bloom Filter可以用于特征选择,通过快速过滤掉不存在于数据集中的特征,提高算法的训练速度和效率。

**量子计算:** 虽然量子计算目前还在发展阶段,但其潜在的超快速计算能力与Bloom Filter结合,可能会产生性能飞跃,特别是在大数据集的快速筛选上。

**边缘计算:** 在边缘计算中,数据往往需要在终端设备进行快速处理。Bloom Filter可以在此环境下用于快速的去重检查和数据同步,减少了对中心服务器的依赖。

### 5.1.2 面向未来的Bloom Filter创新应用

**实时数据流处理:** 在实时数据流分析中,Bloom Filter可以被用于快速检测和过滤重复数据,以提供更准确的实时分析结果。

**增强隐私保护:** 在涉及用户隐私的数据处理中,Bloom Filter可用于检查数据项是否存在于用户隐私数据集中,而不暴露用户的具体数据。

## 5.2 面临的挑战与发展方向

尽管Bloom Filter有着广泛的应用和美好的发展前景,但其在实际应用中也面临一些挑战,并且随着技术的进步,我们也在不断寻求新的发展方向。

### 5.2.1 现实应用中的性能挑战

**内存消耗的优化:** 随着数据量的增加,Bloom Filter所需的存储空间也在增加。如何在保持高效率的同时减少内存的使用,是一个亟待解决的挑战。

**错误率的控制:** 由于Bloom Filter存在一定的误判率,如何在不影响性能的前提下,尽可能地降低这个错误率,是另一个需要考虑的问题。

### 5.2.2 Bloom Filter技术的发展趋势与研究方向

**动态调整策略:** 研究出能够根据数据变化动态调整Bloom Filter参数的技术,使它能够适应不断变化的数据环境。

**新的算法优化:** 针对Bloom Filter算法的局限性,不断探索新的优化策略,例如使用多个Bloom Filter组合来降低误判率,或者开发新的哈希函数以提高过滤性能。

**多维数据处理:** 目前Bloom Filter处理的是简单的键值对数据,但未来的研究方向可能包含将Bloom Filter应用于更复杂的数据结构和模式,如多维数据过滤。

Bloom Filter技术的未来发展将是充满机遇和挑战的,它不仅需要与新兴技术的深入融合,更需要在性能优化和算法改进上不断突破。随着研究的不断深入,Bloom Filter将在数据处理领域展现出更强大的力量。

0

0