异常检测在目标识别与跟踪中的应用与技术

发布时间: 2024-09-06 22:35:16 阅读量: 33 订阅数: 25

# 1. 异常检测基础概述

## 1.1 异常检测的定义与重要性

异常检测是指识别出数据集中与预期模式不符的数据点的过程。在一个系统中,识别异常行为或事件至关重要,因为它可以帮助及时发现潜在的安全威胁、系统故障或数据错误。

## 1.2 异常检测的类型与应用场景

异常检测通常可以分为点异常、上下文异常和集合异常。这些类型在网络安全、信用卡欺诈检测、医疗诊断以及IT基础设施监控等多个领域中有着广泛的应用。

## 1.3 异常检测的关键挑战

在异常检测过程中,常见的挑战包括高维数据的处理、模型的选择、误报和漏报率的平衡。这些挑战要求研究者和工程师开发出更加高效、准确的算法和技术来应对不断变化的应用需求。

异常检测是数据分析中的一个关键环节,它涉及到机器学习、统计学和计算机视觉等多个领域的知识。在后续章节中,我们将深入探讨目标识别技术和目标跟踪技术,以及它们如何与异常检测结合,共同推动智能监控系统的发展。

# 2. 目标识别技术的理论与实践

目标识别技术是计算机视觉和模式识别领域的一项重要研究方向,它的核心任务是通过算法对图像或视频中的目标进行检测和识别。随着技术的不断进步,目标识别技术已被广泛应用于安全监控、自动驾驶、医疗影像分析等多个领域。

## 2.1 目标识别技术的理论基础

### 2.1.1 目标识别中的机器学习算法

在目标识别领域,机器学习算法的应用由来已久。这些算法包括但不限于支持向量机(SVM)、决策树、随机森林以及集成学习等。这些算法通常依赖于手工设计的特征来完成分类任务。

在实际应用中,如需使用SVM进行目标识别,首先需要从训练数据中提取特征。例如,在行人检测中,可以提取Haar-like特征。然后,使用这些特征训练SVM分类器。一个关键步骤是在特征空间中寻找最优超平面,即最大化两个类别之间的边界。

```python

from sklearn.svm import SVC

from sklearn import datasets

from sklearn.model_selection import train_test_split

from sklearn.metrics import classification_report

# 加载数据集并预处理

iris = datasets.load_iris()

X = iris.data

y = iris.target

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3)

# 创建SVM分类器实例

svm = SVC(kernel='linear')

# 训练模型

svm.fit(X_train, y_train)

# 进行预测

predictions = svm.predict(X_test)

# 打印分类报告

print(classification_report(y_test, predictions))

```

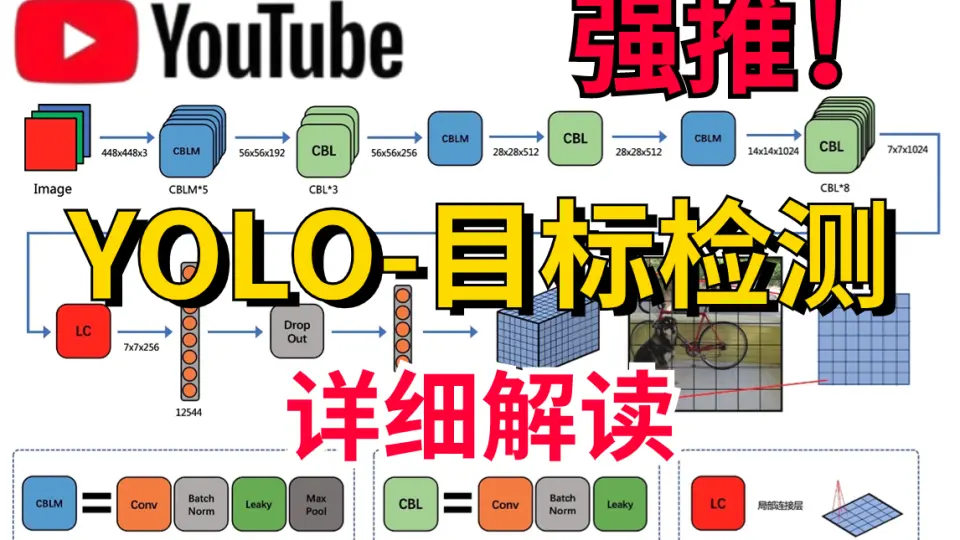

### 2.1.2 深度学习在目标识别中的应用

深度学习,尤其是卷积神经网络(CNN),已经成为目标识别领域的主流技术。深度神经网络能自动提取和学习数据的层次化特征,减少了对人工特征设计的依赖。

在卷积神经网络中,最基本的层是卷积层和池化层。卷积层能够提取局部特征,而池化层有助于减少数据的空间大小并提取主要特征。接下来的全连接层整合所有特征,并用于分类。

```python

import tensorflow as tf

from tensorflow.keras.layers import Conv2D, MaxPooling2D, Flatten, Dense

from tensorflow.keras.models import Sequential

# 创建一个简单的CNN模型

model = Sequential([

Conv2D(32, (3, 3), activation='relu', input_shape=(28, 28, 1)),

MaxPooling2D((2, 2)),

Conv2D(64, (3, 3), activation='relu'),

MaxPooling2D((2, 2)),

Conv2D(64, (3, 3), activation='relu'),

Flatten(),

Dense(64, activation='relu'),

Dense(10, activation='softmax')

])

# 编译模型

***pile(optimizer='adam', loss='sparse_categorical_crossentropy', metrics=['accuracy'])

# 模型摘要

model.summary()

```

## 2.2 目标识别技术的实践案例分析

### 2.2.1 实时视频流中的目标识别实践

实时视频流目标识别是一种常见应用,如安全监控系统。为了实现实时目标识别,需要高效的算法来保证在有限的计算资源下,依然可以快速准确地识别出视频中的目标。

一个关键的优化方法是模型压缩。模型压缩包括权重量化、剪枝、网络结构搜索等技术,目的是在不显著降低识别准确率的情况下,减少模型的大小和计算需求。

### 2.2.2 复杂场景下的目标识别挑战

复杂场景下的目标识别是目标识别技术面临的一个重要挑战。比如,在户外环境中的目标识别,需要应对光照变化、遮挡、背景复杂等多方面的问题。

多任务学习是处理这类问题的一种方法。通过同时学习多种相关任务(如目标检测、场景分类、行为识别),模型可以更好地理解复杂的场景,并提升识别性能。

## 2.3 目标识别技术的评估与优化

### 2.3.1 常见评估指标及其意义

目标识别技术的评估指标主要包括精确度(Precision)、召回率(Recall)、F1分数、平均精度均值(mAP)等。精确度反映了识别结果中正确目标的比例,召回率衡量了所有目标中被正确识别的比例,而F1分数是精确度和召回率的调和平均值,提供了单个指标的综合性能评价。mAP通常用于评估目标检测模型的性能。

### 2.3.2 优化策略与技术难点

优化策略包括改进网络结构、数据增强、正则化方法等。技术难点在于如何平衡准确率和速度,以及如何设计适应性强、泛化能力好的模型。例如,在设计轻量级网络结构时,必须确保模型在减少计算量的同时,仍能保持较高的识别精度。

```mermaid

graph TD;

A[目标识别技术评估] --> B[精确度]

A --> C[召回率]

A --> D[F1分数]

A --> E[mAP]

```

通过上述内容的介绍,我们可以看到目标识别技术的理论基础、实践案例、评估指标以及优化策略都各具特色,并且紧密联系。在了解了这些核心概念和方法之后,我们可以更深入地探讨目标跟踪技术,它是目标识别技术进一步的应用和发展。

# 3. 目标跟踪技术的理论与实践

## 3.1 目标跟踪技术的理论基础

### 3.1.1 单目标与多目标跟踪算法概述

目标跟踪是计算机视觉领域的核心技术之一,旨在从连续的视频帧中准确地跟踪一个或多个目标物体的位置和运动状态。单目标跟踪和多目标跟踪是其中的两个主要问题。

单目标跟踪(SOT)侧重于对视频序列中的单一目标进行连续跟踪。为了实现这一目标,单目标跟踪算法通常依赖于目标在视频序列中的初始位置和外观特征。这些算法可以进一步划分为基于判别和基于生成的方法。基于判别的方法通过学习一个目标检测器来区分目标和背景,而基于生成的方法则尝试构建一个目标的精确外观模型。

多目标跟踪(MOT)的挑战在于同时处理多个目标,并保持它们之间的身份一致性。为了解决身份混淆问题,多目标跟踪算法通常采用数据关联的方法,将检测到的目标与跟踪轨迹进行匹配。MOT算法可以分为联合检测与跟踪(JDE)和跟踪即检测(TAD)等不同的策略。JDE将检测和跟踪任务合并为一个统一的框架,而TAD侧重于先进行目标检测,再进行跟踪。

### 3.1.2 跟踪算法的评价标准

评价跟踪算法性能的主要指标包括准确度、成功率和速度等。这些指标能反映算法在不同跟踪场景下的适应能力和实用性。

- **精确度(Precision)**:衡量算法在所有预测中正确跟踪目标的比例。

- **成功率(Success rate)**:反映在不同重叠率阈值条件下,目标跟踪区域与真实标签区域的重叠程度。

- **速度(Speed)**:指的是算法处理每帧图像所需的时间,反映了算法的实时性。

这些评价标准不仅衡量了算法的准确性,也衡量了跟踪速度,这对于实现实时跟踪系统至关重要。例如,Fast-Dense Trajectory(TLD)系统在设计时就考虑了跟踪的实时性和准确性,通过调整算法中的参数来平衡这两方面。

### 代码块示例

```python

# 示例:使用OpenCV和Python实现一个简单的单目标跟踪算法

import cv2

# 初始化摄像头

cap = cv2.VideoCapture(0)

# 读取第一帧

ret, frame = cap.read()

# 选择跟踪目标

bbox = cv2.selectROI(frame, False)

# 设置tracker参数

tracker_type = 'BOOSTING'

# 创建tracker对象

tracker = cv2.Tracker_create(tracker_type)

# 初始化tracker

ok = tracker.init(frame, bbox)

while True:

# 读取新的一帧

ret, frame = cap.read()

```

0

0