实时决策制定:目标跟踪中的算法与实践策略

发布时间: 2024-09-06 22:54:56 阅读量: 42 订阅数: 25

# 1. 目标跟踪技术概述

随着计算机视觉技术的飞速发展,目标跟踪技术在安防监控、自动驾驶、机器人导航等多个领域得到了广泛的应用。目标跟踪,是指在视频序列中,基于初始帧提供的目标信息,自动识别和跟踪视频中目标在随后帧中的位置和状态的过程。为了实现精准的跟踪,算法需要能够应对目标的遮挡、快速运动、光照变化和摄像头移动等复杂情况。

在这一章中,我们将首先概述目标跟踪技术的基本概念和应用场景,并分析其在实际应用中所面临的挑战。随后,将对目标跟踪技术的整体发展趋势和未来的研究方向进行前瞻性讨论。通过这一章节,读者将获得对目标跟踪技术全貌的初步了解,并为其后的深入章节奠定基础。

# 2. 目标跟踪算法基础

## 2.1 目标检测技术

### 2.1.1 目标检测算法的演进

在计算机视觉领域,目标检测技术是识别图像中特定对象位置和类别的基础过程。早期的目标检测方法主要依赖于手工设计的特征和传统的机器学习方法。随着时间推移,目标检测算法经历了一系列演进。

- **手工特征时代**:使用如HOG、SIFT等特征提取器,结合SVM等分类器进行目标检测。此类方法依赖于特定场景和对象的特征设计,泛化能力有限。

- **深度学习时代**:以卷积神经网络(CNN)为基础的深度学习模型成为主流,如R-CNN、YOLO、SSD等,极大提升了检测精度和速度。其中,YOLO系列以其速度优势,在实时应用中尤为突出。

深度学习方法中,两阶段检测器(如R-CNN及其变种)首先在图像中生成候选区域,然后对每个区域进行分类。而单阶段检测器(如YOLO和SSD)则直接在图像上进行分类和定位,显著减少了处理时间。

### 2.1.2 现代目标检测框架简介

现代目标检测框架采用了多种技术来提高检测速度和准确性,同时保证了在不同设备上的部署可行性。

- **YOLO(You Only Look Once)**: 通过将检测任务视为回归问题,YOLO能在单一网络中直接预测边界框和类概率。YOLOv5和YOLOv7不断优化速度和精度,适应了更广泛的应用场景。

- **SSD(Single Shot MultiBox Detector)**: 通过在多个尺度上检测对象,SSD能够平衡速度和准确性,且具有较好的小对象检测能力。

- **Faster R-CNN**: 结合了区域建议网络(RPN)来生成候选区域,然后用CNN进一步提取特征并分类,尽管速度不如单阶段检测器,但在复杂场景下表现更优。

下面是一个简单的代码示例,使用YOLOv5来检测图像中的对象:

```python

import torch

from PIL import Image

import numpy as np

# 加载模型

model = torch.hub.load('ultralytics/yolov5', 'yolov5s', pretrained=True)

# 加载图片

img = Image.open('path/to/image.jpg')

# 进行预测

results = model(img)

# 结果可视化

results.show()

# 打印预测结果

results.print()

# 保存检测后的图片

results.save('path/to/save/image.jpg')

```

这段代码首先使用PyTorch的hub模块加载预训练的YOLOv5模型,并指定使用较小的模型版本('yolov5s')以保持较好的实时性。随后,它加载一张图片,并使用模型对图片中的对象进行检测。最后,代码展示了检测结果,并将图片保存到指定路径。

YOLOv5的检测过程非常迅速,适合实时系统的需求。通过调整模型大小和精度的权衡,开发者可以根据具体需求进行选择。

## 2.2 目标跟踪算法原理

### 2.2.1 传统跟踪算法的分类与特点

目标跟踪是指在视频序列中跟踪一个或多个目标的运动。传统的目标跟踪算法主要可以分为以下几类:

- **基于特征的跟踪方法**:此类方法通过提取目标的特征来实现跟踪,如SIFT、HOG等。它们通常对尺度和光照变化较为鲁棒,但对于快速运动或遮挡效果较差。

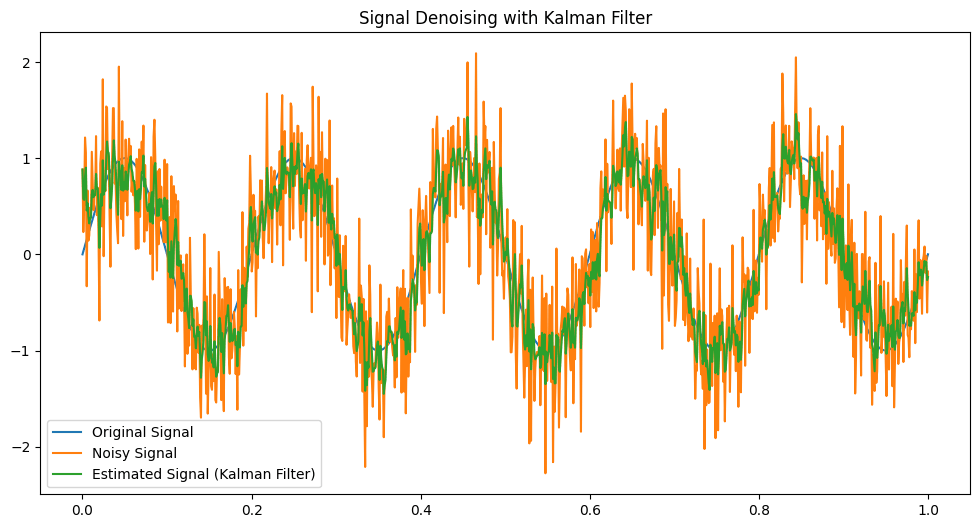

- **基于卡尔曼滤波的跟踪方法**:通过预测和更新目标位置的方法来实现跟踪,适用于动态场景。

- **基于均值漂移的跟踪方法**:利用颜色直方图信息,适合于跟踪颜色分布明确的目标。

- **基于光流法的跟踪方法**:通过分析连续帧之间像素点的运动来估计目标位置,适合于跟踪运动平滑的目标。

每种方法都有其特点和适用场景,但都无法在所有条件下保证最佳性能。随着深度学习的引入,目标跟踪方法得到了进一步的发展。

### 2.2.2 深度学习在目标跟踪中的应用

深度学习方法在目标跟踪领域取得了显著的进展,表现在以下几个方面:

- **端到端的训练**:深度学习模型能够直接从视频帧中学习目标的表达,并实现端到端的跟踪。

- **特征提取的自动化**:卷积神经网络能够自动提取用于跟踪的高级特征,减少了人工干预。

- **鲁棒性和准确性**:深度学习模型能够学习目标的复杂变化规律,包括形状、外观和运动模式,提高了跟踪的鲁棒性和准确性。

- **适应性**:一些深度学习跟踪算法可以实时适应环境变化,如光照、遮挡等。

一个流行的深度学习跟踪算法是Siamese网络。它通过比较目标和候选区域的特征来确定跟踪目标的位置。以下是一个简化的Siamese网络示例:

```python

import torch.nn as nn

import torch.nn.functional as F

class SiameseNetwork(nn.Module):

def __init__(self):

super(SiameseNetwork, self).__init__()

self.convnet = nn.Sequential(

nn.Conv2d(3, 64, 10), # 输入层

nn.ReLU(inplace=True),

nn.MaxPool2d(2, 2),

nn.Conv2d(64, 128, 7),

nn.ReLU(inplace=True),

nn.MaxPool2d(2, 2),

nn.Conv2d(128, 128, 4),

nn.ReLU(inplace=True),

nn.Conv2d(128, 256, 4)

)

self.fc = nn.Sequential(

nn.Linear(256 * 3 * 3, 4096),

nn.ReLU(inplace=True),

nn.Linear(4096, 1024),

nn.ReLU(inplace=True),

nn.Linear(1024, 256),

nn.ReLU(inplace=True),

nn.Linear(256, 2) # 输出特征向量

)

def forward_once(self, x):

output = self.convnet(x)

output = output.view(output.size()[0], -1)

output = self.fc(output)

return output

def forward(self, input1, input2):

output1 = self.forward_once(input1)

output2 = self.forward_once(input2)

return output1, output2

# 初始化网络

model = SiameseNetwork()

# 假设input1和input2分别代表视频中的第一帧目标和后续帧的候选区域

# 进行前向计算

feature1,

```

0

0