【大数据异常挖掘】:在海量数据中发现异常的策略与工具

发布时间: 2024-09-07 17:08:23 阅读量: 78 订阅数: 49

混合四策略改进SSA优化算法:MISSA的实证研究与应用展望 经过融合spm映射、自适应-正余弦算法、levy机制、步长因子动态调整四种策略的改进,MISSA算法测试结果惊艳,麻雀飞天变凤凰 目前相

# 1. 大数据异常挖掘概述

大数据异常挖掘是数据分析领域的一个关键分支,它关注于识别数据集中的不规则或异常模式。这种技术对于检测欺诈行为、系统故障、网络安全威胁等方面至关重要。随着数据量的急剧增长,异常挖掘技术也迅速发展,逐渐成为IT和数据分析专家的核心技能之一。

异常挖掘不仅是简单地找到数据中的异常点,而是通过深层次的数据分析,揭示潜在的问题和风险。其应用范围广泛,不仅限于IT行业,还涉及金融、医疗、制造等多个领域。本章旨在为读者提供异常挖掘的基本概念和重要性,为后续深入探讨异常挖掘的理论、工具和实践案例奠定基础。

# 2. 异常挖掘的理论基础

## 2.1 异常值的定义和特征

### 2.1.1 统计学中的异常值概念

在统计学中,异常值(Outlier)是指一个数据点在给定数据集中与其它数据相比显得异常,它可能表明了测量错误、数据污染或自然变异的一种不寻常形式。异常值的存在可以显著影响数据的统计特性,如均值和方差,因此在数据分析和挖掘过程中,正确识别并处理异常值是非常重要的。

例如,在一组正态分布的体重数据中,一个体重远高于或远低于平均值的个体可能是一个异常值,这可能是个别测量错误,也可能是由于特殊的生活习惯或生理条件造成的。

### 2.1.2 异常值的分类及识别方法

异常值可以根据其发生的原因进行分类,大致可以分为三类:

1. **全局异常(Global Outliers)**:在一个数据集中全局地表现出异常的点。例如,一个国家的平均收入数据中异常高的个人收入。

2. **上下文异常(Contextual Outliers)**:在特定上下文或条件中表现为异常的点。例如,在特定季节或地区内的异常气候条件。

3. **集体异常(Collective Outliers)**:一组数据点共同表现出异常,但单独每个数据点看起来并不异常。例如,一组传感器数据可能在特定时间点集体报告异常,表明某种未预料的系统状态。

识别异常值的方法多种多样,常见的有:

- **标准差法**:基于数据的均值和标准差,设定一个阈值(如均值±3倍标准差),数据点若超出此范围,则认为是异常值。

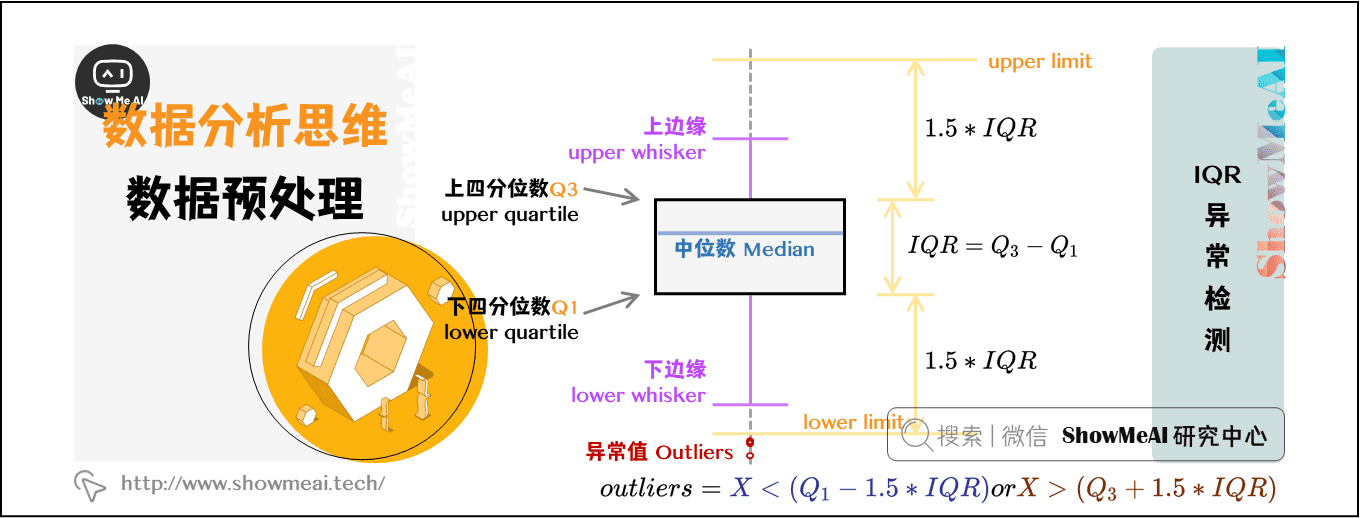

- **四分位距法(IQR)**:利用四分位数来定义异常值。超出1.5倍IQR(第一四分位数到第三四分位数的距离)范围的数据点被认为是异常的。

### 2.1.3 识别过程中的注意事项

识别异常值时,还需要注意以下几点:

- **数据的分布特性**:在非正态分布数据中,使用标准差法可能会导致错误的异常值判断。

- **数据的领域知识**:在某些情况下,需要结合领域知识来判断数据点是否为异常值。

- **异常值的处理**:在发现异常值后,应考虑是否需要进行处理。处理方法包括删除异常值、用中位数替代等。

## 2.2 异常检测的算法原理

### 2.2.1 统计学方法

统计学方法是异常检测中最早使用的方法之一。这类方法通常基于数据的统计特性,如均值、方差等来识别异常值。常见的统计学方法包括:

- **箱型图(Boxplot)**:利用四分位数和四分位距来识别异常值。

- **Grubbs' Test**:一种用于检测单变量数据集中是否含有单一全局异常值的假设检验方法。

### 2.2.2 机器学习方法

随着机器学习技术的发展,越来越多的异常检测算法基于机器学习方法。这些方法通常需要一个训练数据集来学习数据的正常行为模式,并根据这些模式来检测异常。常见的机器学习方法包括:

- **One-Class SVM**:适合于未标记数据的异常检测,通过学习数据的主要分布,对偏离这一分布的数据点进行标记。

- **Isolation Forest**:一种集成学习方法,通过随机选择特征和随机切分值来“孤立”观察值,异常点由于特征少且值偏离典型特征值而更容易被孤立出来。

### 2.2.3 深度学习方法

深度学习在异常检测领域表现出色,特别是对高维数据和复杂数据模式的异常检测。基于深度学习的异常检测方法包括:

- **自编码器(Autoencoders)**:一种用于无监督学习的神经网络,通过训练一个神经网络学习输入数据的有效表示(编码),再通过网络重建输入数据,使得网络能够重建正常数据,而对异常数据重建效果不佳。

- **生成对抗网络(GANs)**:利用两个网络,一个生成网络(Generator)生成数据,一个判别网络(Discriminator)判断数据的真伪。通过训练,可以使得生成网络生成正常数据分布,异常数据将被两个网络识别为假。

## 2.3 异常检测的评估指标

### 2.3.1 精确度、召回率和F1分数

在机器学习模型中,精确度(Precision)、召回率(Recall)和F1分数是常用的评估指标。

- **精确度**:在所有被模型判定为异常的数据点中,真正是异常的所占的比例。

- **召回率**:在所有实际异常的数据点中,被模型正确识别出的比例。

- **F1分数**:精确度和召回率的调和平均,是二者的综合指标。高F1分数意味着模型的性能均衡。

### 2.3.2 ROC曲线和AUC值

受试者工作特征曲线(ROC)和曲线下面积(AUC)是评估分类器性能的另一种方法。

- **ROC曲线**:在不同的分类阈值下绘制出的真正例率(True Positive Rate, TPR)与假正例率(False Positive Rate, FPR)的关系图。

- **AUC值**:ROC曲线下的面积,值范围从0到1。AUC值越接近1,表示模型的分类效果越好。

### 2.3.3 进一步的评估指标

除了上述指标外,还有其他的指标来评估异常检测模型的性能:

- **检测率**:异常点被检测出的概率。

- **误报率**:正常数据被错误地识别为异常的比例。

- **正常数据检测率**:正常数据未被错误识别为异常的比例。

这些指标可以帮助我们从不同角度评估异常检测模型的有效性,并选择最适合特定应用场景的模型。

通过对异常挖掘理论基础的学习,我们能更好地理解异常值的概念、分类和识别方法,以及异常检测的各种算法原理和评估指标。这些基础知识是开展异常挖掘实践和深入研究的重要基础。在下一章中,我们将深入探讨大数据异常挖掘实践工具的使用和构建实时异常检测系统的方法。

# 3. 大数据异常挖掘实践工具

## 3.1 开源数据分析平台

### 3.1.1 Apache Hadoop与HDFS

Apache Hadoop是一个开源框架,用于存储和处理大规模数据集的软件平台。Hadoop的核心是HDFS(Hadoop Distributed File System)和MapReduce编程模型。HDFS是一个高度容错的系统,设计用于部署在廉价的硬件上。它提供高吞吐量的数据访问,非常适合大规模数据集的应用。

HDFS使用主从架构,由一个NameNode和多个DataNodes组成。NameNode负责管理文件系统的命名空间和客户端对文件的访问。DataNodes负责存储实际的数据。在处理大数据时,HDFS能够将数据分割成多个块(block),并分布式存储在集群的多

0

0