随机化算法在人工智能中的前沿应用:深度学习与强化学习的创新

发布时间: 2024-08-24 18:58:34 阅读量: 50 订阅数: 50

# 1. 随机化算法在人工智能中的概述**

随机化算法是人工智能中不可或缺的工具,它们引入随机性以解决复杂问题。这些算法通过探索搜索空间的随机子集,克服了传统确定性算法的局限性。随机化算法在人工智能的各个领域都有广泛的应用,包括深度学习、强化学习和自然语言处理。

在深度学习中,随机化算法用于初始化神经网络权重,从而防止过拟合。在强化学习中,它们用于探索环境,平衡探索和利用。在自然语言处理中,它们用于生成词嵌入和训练语言模型。

随机化算法的优势在于它们能够处理高维和复杂的数据,并找到传统算法可能错过的潜在解决方案。然而,它们也可能引入不确定性,因此必须仔细选择和调整以确保算法的鲁棒性和效率。

# 2. 随机化算法在深度学习中的应用

深度学习是人工智能的一个子领域,它使用多层神经网络来学习复杂模式和做出预测。随机化算法在深度学习中扮演着至关重要的角色,它们有助于提高模型的性能、稳定性和泛化能力。

### 2.1 深度神经网络的随机初始化

深度神经网络通常包含数百万甚至数十亿个参数。这些参数的初始值对于模型的性能至关重要。随机初始化可以打破对称性,防止网络陷入局部最优解。

#### 2.1.1 Xavier初始化和He初始化

Xavier初始化和He初始化是两种常用的随机初始化方法。Xavier初始化适用于具有ReLU激活函数的网络,而He初始化适用于具有tanh或sigmoid激活函数的网络。

**Xavier初始化**

```python

def xavier_init(shape):

"""Xavier初始化。

Args:

shape (tuple): 权重张量的形状。

Returns:

Tensor: 初始化后的权重张量。

"""

fan_in, fan_out = shape[0], shape[1]

std = np.sqrt(2.0 / (fan_in + fan_out))

return np.random.normal(0, std, shape).astype(np.float32)

```

**逻辑分析:**

* `fan_in`和`fan_out`分别表示输入和输出特征图的个数。

* `std`是权重张量标准差的计算结果。

* `np.random.normal`函数生成一个正态分布的随机张量。

**He初始化**

```python

def he_init(shape):

"""He初始化。

Args:

shape (tuple): 权重张量的形状。

Returns:

Tensor: 初始化后的权重张量。

"""

fan_in = shape[0]

std = np.sqrt(2.0 / fan_in)

return np.random.normal(0, std, shape).astype(np.float32)

```

**逻辑分析:**

* `fan_in`表示输入特征图的个数。

* `std`是权重张量标准差的计算结果。

* `np.random.normal`函数生成一个正态分布的随机张量。

#### 2.1.2 正则化和Dropout

正则化和Dropout是防止深度神经网络过拟合的两种常用技术。

**正则化**

正则化通过向损失函数添加一个惩罚项来约束模型的复杂度。常见的正则化方法包括L1正则化和L2正则化。

**Dropout**

Dropout是一种随机失活技术,它在训练过程中随机丢弃一部分神经元。这有助于防止神经元之间过度拟合。

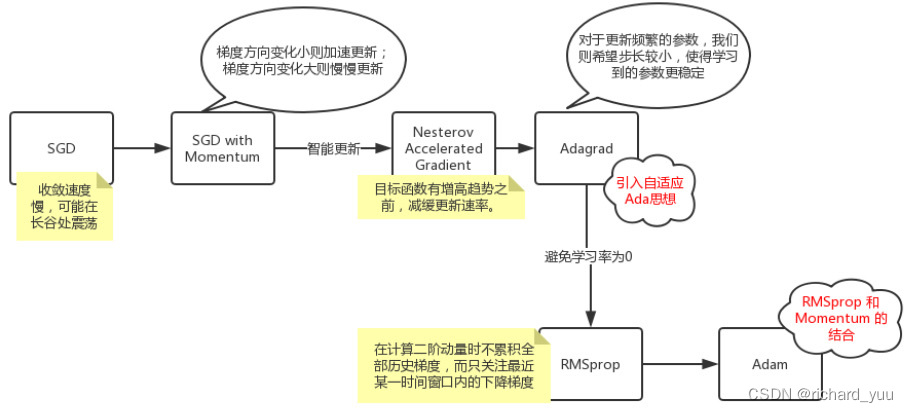

### 2.2 随机梯度下降

随机梯度下降(SGD)是深度学习中常用的优化算法。SGD通过迭代更新模型参数来最小化损失函数。

#### 2.2.1 梯度下降算法

梯度下降算法根据损失函数的梯度更新模型参数。

```python

def gradient_descent(loss_fn, params, learning_rate):

"""梯度下降算法。

Args:

loss_fn (Callable): 损失函数。

params (list): 模型参数列表。

learning_rate (float): 学习率。

Returns:

list: 更新后的模型参数列表。

"""

grads = tf.gradients(loss_fn, params)

new_params = [param - learning_rate * grad for param, grad in zip(params, grads)]

return new_params

```

**逻辑分析:**

* `loss_fn`是损失函数。

* `params`是模型参数列表。

* `learning_rate`是学习率。

* `tf.gradients`函数计算损失函数对模型参数的梯度。

* `new_params`是更新后的模型参数列表。

#### 2.2.2 动量和RMSprop优化器

动量和RMSprop是两种常用的优化器,它们可以加速梯度下降的收敛速度。

**动量**

动量优化器通过引入动量项来平滑梯度更新。

```python

def momentum(loss_fn, params, learning_rate, momentum):

"""动量优化器。

Args:

loss_fn (Callable): 损失函数。

params (list): 模型参数列表。

learning_rate (float): 学习率。

momentum (float): 动量系数。

Returns:

list: 更新后的模型参数列表。

"""

grads = tf.gradients(loss_fn, params)

velocities = [tf.zeros_like(param) for param in params]

new_params = []

for param, grad, velocity in zip(params, grads, velocities

```

0

0