【scikit-learn集成学习宝典】:学会Bagging与Boosting,让模型性能飞跃

发布时间: 2024-09-30 07:16:45 阅读量: 34 订阅数: 37

机器学习实战:Scikit-learn算法应用 描述: 这个资源专注于使用Scikit-learn库进行机器学习模型的训练和评

# 1. 集成学习与scikit-learn简介

集成学习是机器学习中的一种强大的方法论,通过构建并结合多个学习器来完成学习任务。它在提高预测准确性、防止过拟合等方面表现出色。集成学习的核心思想是通过多样性的模型获得更稳健的预测性能。

在本章中,我们将介绍集成学习的基本概念和应用广泛的scikit-learn库。scikit-learn作为一个流行的Python机器学习库,提供了许多集成学习算法的实现,以及数据预处理和模型评估工具,是集成学习实践中的必备工具。

我们将首先介绍集成学习的基本原理,然后探讨scikit-learn的基本使用方法。通过本章的学习,读者将对集成学习有一个初步的理解,并能够利用scikit-learn开始自己的集成学习实践。接下来的章节将进一步深入探讨集成学习的具体算法和高级用法。

# 2. Bagging算法的理论与实现

### 2.1 Bagging算法的理论基础

#### 2.1.1 集成学习概念

集成学习是一种机器学习范式,它旨在通过构建并结合多个学习器来完成学习任务。这些学习器可以是同质的(例如,都是决策树),也可以是异质的。集成学习的核心思想是"众人拾柴火焰高",即多个模型的预测结果通常会比单个模型更加稳定和准确。

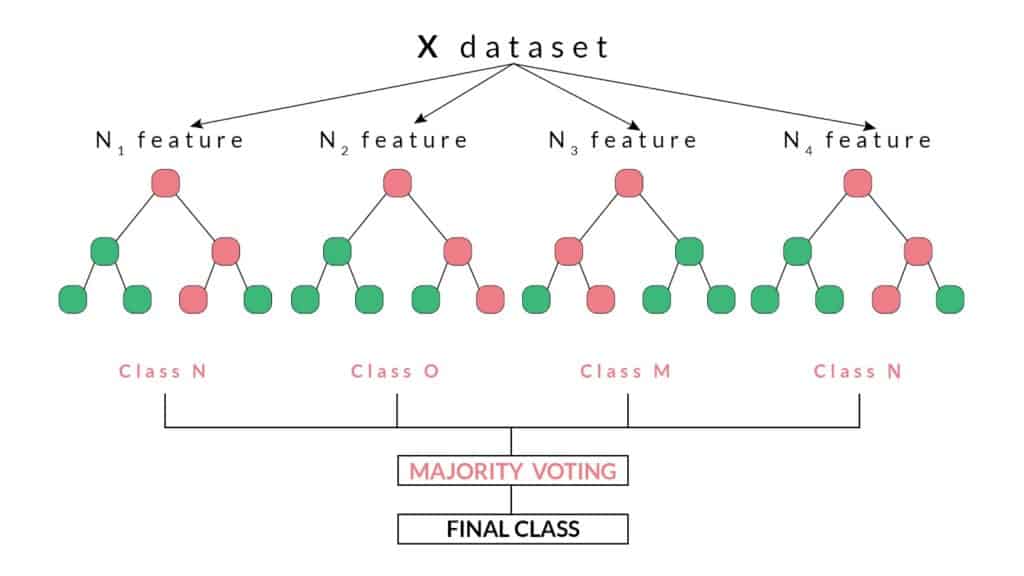

Bagging(Bootstrap Aggregating)是集成学习的一种常用技术,它通过自助采样(bootstrap sampling)来构建多个独立的模型,并对这些模型的预测结果进行平均或投票,以得到最终的预测。

#### 2.1.2 Bagging算法原理

Bagging算法的核心思想是通过降低方差来提高模型的泛化能力。自助采样是一种有放回的抽样方法,这意味着同一数据点在每次抽样中都有可能被重复选取。对于一个有N个样本的数据集,每次抽取一个样本加入训练集,可以产生N个不同的训练集,每个训练集包含大约63.2%的原始数据。

在Bagging算法中,多个基学习器(通常是决策树)在这些自助采样产生的数据集上训练,然后通过投票(分类问题)或者平均(回归问题)的方式汇总每个基学习器的预测结果。由于基学习器是独立构建的,它们会捕捉到数据的不同方面,从而降低了整个集成模型的方差。

### 2.2 Bagging算法的实践应用

#### 2.2.1 scikit-learn中的Bagging分类器

在scikit-learn库中,Bagging算法的实现包括`BaggingClassifier`和`BaggingRegressor`两个类,分别用于分类问题和回归问题。这些类可以通过传入基学习器进行配置。

```python

from sklearn.ensemble import BaggingClassifier

# 以决策树作为基学习器创建Bagging分类器

bagging_classifier = BaggingClassifier(

base_estimator=DecisionTreeClassifier(),

n_estimators=10, # 基学习器数量

bootstrap=True, # 是否使用自助采样

bootstrap_features=False, # 不对特征进行自助采样

n_jobs=-1, # 使用全部CPU核心

random_state=42 # 随机数种子

)

```

`BaggingClassifier`类的`fit`方法用于训练模型,`predict`方法用于模型预测。在构建集成模型时,可以使用`GridSearchCV`进行超参数优化。

#### 2.2.2 使用Bagging进行数据集抽样

在使用Bagging算法之前,需要对数据集进行自助采样以创建多个子集。scikit-learn提供了`Bootstrap`类来手动进行数据集的抽样。

```python

from sklearn.utils import resample

# 创建一个新的数据集

bootstrap_sample = resample(X, y, replace=True, n_samples=n_samples)

```

在上述代码中,`X`是特征集,`y`是标签集,`replace=True`表示进行有放回抽样,`n_samples`为新数据集的大小。

#### 2.2.3 Bagging模型的构建与评估

构建Bagging模型时,需要指定基学习器、集成数量、自助采样参数等。模型构建完成后,使用交叉验证等方式对模型的性能进行评估。

```python

from sklearn.model_selection import cross_val_score

# 使用交叉验证评估Bagging模型

scores = cross_val_score(bagging_classifier, X, y, cv=5)

print("Accuracy scores:", scores)

```

在实际应用中,我们通常会比较不同参数配置下模型的表现,并使用验证集或者交叉验证来选择最优模型配置。

### 2.3 Bagging算法的高级特性

#### 2.3.1 特征子集与模型多样性

Bagging算法的一个重要特性是增加模型多样性。在scikit-learn中,可以通过在`BaggingClassifier`或`BaggingRegressor`中设置`bootstrap_features=True`来对特征进行自助采样,进一步提升模型多样性。

```python

# 使用特征自助采样的Bagging分类器

feature_bagging_classifier = BaggingClassifier(

base_estimator=DecisionTreeClassifier(),

bootstrap_features=True, # 对特征进行自助采样

n_estimators=10,

bootstrap=True,

n_jobs=-1,

random_state=42

)

```

#### 2.3.2 超参数调优与模型优化

超参数的调优是提高模型性能的关键步骤。可以使用`GridSearchCV`或`RandomizedSearchCV`对Bagging集成的超参数进行搜索。

```python

from sklearn.model_selection import GridSearchCV

# 设置要搜索的超参数范围

param_grid = {

'n_estimators': [10, 50, 100, 200],

'max_samples': [0.5, 0.7, 1.0],

'max_features': [0.5, 0.7, 1.0],

}

# 使用GridSearchCV进行超参数搜索

grid_search = GridSearchCV(bagging_classifier, param_grid, cv=5)

grid_search.fit(X, y)

print("Best parameters:", grid_search.best_params_)

```

在调优过程中,可能需要结合实际问题和计算资源来选择合适的参数范围和搜索方法。

通过以上内容的介绍,我们已经完成了对Bagging算法理论基础、实践应用以及高级特性的详细阐述。接下来的章节中,我们将转向另一个强大的集成学习技术——Boosting,并详细介绍其理论和实践应用。

# 3. Boosting算法的理论与实现

## 3.1 Boosting算法的理论基础

### 3.1.1 Boosting的工作机制

Boosting算法的核心思想是将多个弱学习器组合起来,通过顺序地训练和调整,强化那些被前一个模型误分的样本点的权重,以期每个后续的模型能在前一个模型出错的地方做得更好。这种连续的改进过程使得Boosting最终构建出一个强大的集成模型。Boosting关注的是如何逐步修正错误,以及如何调整样本权重来关注那些难以分类的数据点。

### 3.1.2 Boosting算法的主要变体

Boosting家族中有许多算法,包括但不限于AdaBoost、Gradient Boosting和XGBoost等。AdaBoost是最原始的Boosting算法,侧重于错误分类样本的权重提升。而Gradient Boosting通过梯度下降的方式来最小化损失函数,XGBoost则在Gradient Boosting的基础上加入了正则化项,以防止过拟合,并且引入了近似算法来加快计算速度。

## 3.2 Boosting算法的实践应用

### 3.2.1 scikit-learn中的Boosting分类器

在scikit-learn中,我们可以使用`GradientBoostingClassifier`来构建Boosting模型。以下是一个简单的例子,展示了如何使用Gradient Boosting对分类问题进行建模。

```python

from sklearn.datasets import make_classification

from sklearn.model_selection import train_test_split

from sklearn.ensemble import GradientBoostingClassifier

from sklearn.metrics import accuracy_score

# 创建一个模拟的分类数据集

X, y = make_classification(n_samples=1000, n_features=10, random_state=42)

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# 初始化Gradient Boosting分类器

gb_clf = GradientBoostingClassifier(n_estimators=100, learning_rate=0.1, max_depth=3, random_

```

0

0