【scikit-learn数据处理简化】:掌握Pipelines,优化你的机器学习流程

发布时间: 2024-09-30 08:04:54 阅读量: 25 订阅数: 38

# 1. scikit-learn入门及数据预处理基础

## 简介

在数据分析和机器学习的世界中,scikit-learn是一个功能强大的Python工具包,它提供了许多简单而高效的工具,用于数据挖掘和数据分析。该库建立在NumPy、SciPy和matplotlib等其他开源软件之上,是构建机器学习模型的基石。本章将引领你入门scikit-learn,并重点介绍数据预处理的基础知识。

## scikit-learn概述

scikit-learn支持各种分类、回归、聚类算法,以及数据预处理工具。它的API设计简洁一致,使得初学者能够快速上手,并且对于经验丰富的数据科学家,它也提供了足够的灵活性来构建复杂的模型。

```python

from sklearn import datasets

from sklearn.model_selection import train_test_split

# 加载数据集

iris = datasets.load_iris()

X, y = iris.data, iris.target

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

```

## 数据预处理基础

数据预处理是任何机器学习工作流程中不可或缺的一步。它包括数据清洗、特征缩放(归一化和标准化)、特征选择和特征提取等步骤。数据预处理可以显著提高模型的准确性和效率。

```python

from sklearn.preprocessing import StandardScaler

# 标准化特征数据

scaler = StandardScaler()

X_train_scaled = scaler.fit_transform(X_train)

X_test_scaled = scaler.transform(X_test)

```

scikit-learn库中的`StandardScaler`类用于标准化特征,使得数据的均值为0,标准差为1。这对于许多算法(尤其是基于距离的算法如K-近邻)来说是很有必要的。

在本章的后续部分,我们将深入探讨数据预处理的各个方面,以及如何将预处理步骤整合到scikit-learn的Pipelines中。

# 2. ```

# 第二章:Pipelines的基本概念和优势

## 2.1 数据预处理的重要性

### 2.1.1 数据集的清洗

数据预处理是机器学习流程中不可或缺的一环。良好的预处理工作能够提升模型的准确度和效率。在数据集的清洗过程中,我们首先需要处理缺失值。缺失值可以是由于数据收集过程中的错误、遗漏,或者某些数据确实不存在。处理缺失值的方法包括删除含有缺失值的行或列、填充缺失值(例如使用均值、中位数、众数等)。除了缺失值,数据清洗还涉及去除重复数据、纠正错误、格式化非标准数据等。

在使用scikit-learn进行数据清洗时,可以借助`SimpleImputer`类来处理缺失值,它提供多种填充策略。例如:

```python

from sklearn.impute import SimpleImputer

# 假设data是我们的数据集,其中存在缺失值

imputer = SimpleImputer(missing_values=np.nan, strategy='mean')

data_imputed = imputer.fit_transform(data)

```

上述代码中,`SimpleImputer`类通过`mean`策略将缺失值填充为所在列的均值。

### 2.1.2 数据的归一化与标准化

归一化(Normalization)和标准化(Standardization)是数据预处理中常见的技术,旨在将特征缩放到一个标准的范围内。归一化通常是指将数据缩放到[0,1]区间内,而标准化则是将数据的均值变为0,标准差变为1。

使用`MinMaxScaler`和`StandardScaler`类可以轻松实现归一化和标准化:

```python

from sklearn.preprocessing import MinMaxScaler, StandardScaler

# 归一化

scaler = MinMaxScaler()

data_normalized = scaler.fit_transform(data)

# 标准化

scaler = StandardScaler()

data_standardized = scaler.fit_transform(data)

```

在归一化和标准化的处理中,保证数据的分布性质被保持,便于后续的模型训练和性能评估。

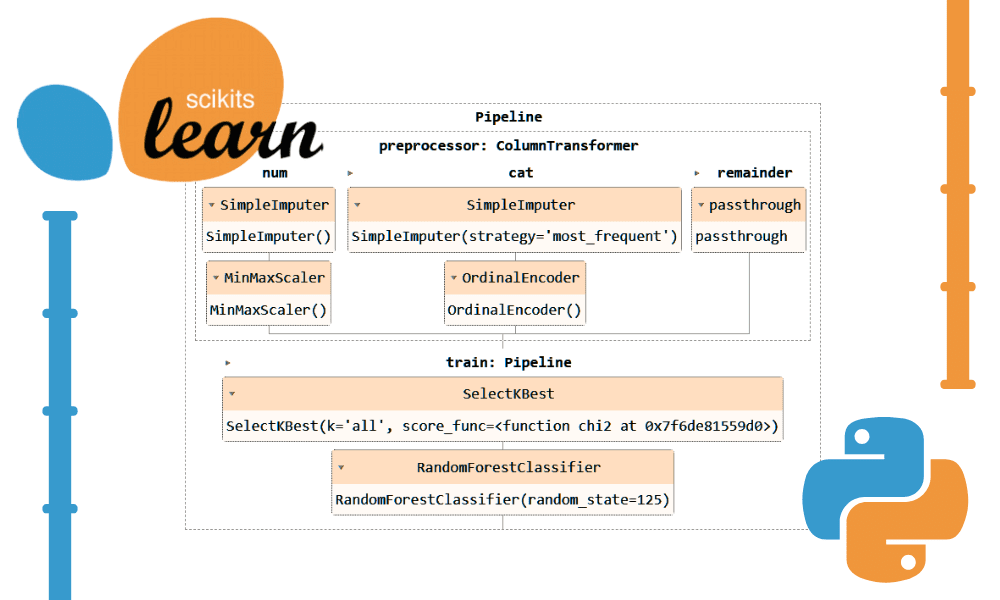

## 2.2 Pipelines的结构与工作原理

### 2.2.1 了解Pipelines的工作流程

Pipelines在scikit-learn中是一个用于搭建和使用预处理步骤和评估器的工具。它使得数据预处理和模型训练的流程可以被包装在一个步骤中,从而简化了代码,并确保了处理步骤的一致性。

```python

from sklearn.pipeline import Pipeline

from sklearn.preprocessing import StandardScaler

from sklearn.svm import SVC

# 创建一个管道,包含缩放器和SVM分类器

pipeline = Pipeline([

('scaler', StandardScaler()),

('classifier', SVC())

])

```

在上述代码中,`Pipeline`类把数据缩放和分类器串连在了一起。在训练模型时,它会自动地对每个组件的`fit`和`transform`方法进行调用,而预测时则仅调用`predict`方法。

### 2.2.2 设计模块化数据处理步骤

Pipelines允许我们在一个步骤中串联多个预处理步骤。每个步骤可以是一个预处理方法,也可以是一个分类器。这促进了代码的模块化,使得我们能够清晰地分离每个数据处理步骤。

```python

# 一个包含多个预处理步骤的管道

pipeline = Pipeline([

('imputer', SimpleImputer(strategy='mean')),

('scaler', StandardScaler()),

('classifier', SVC())

])

```

在构建管道时,每个步骤都有一个唯一的名称(如`imputer`、`scaler`和`classifier`),这样在需要的时候可以单独引用或替换。

## 2.3 Pipelines的优势和最佳实践

### 2.3.1 代码简洁与可维护性

使用Pipelines的优势之一是代码更加简洁和易于维护。通过管道,我们可以在一个结构中组织数据预处理和模型训练的所有步骤,这意味着当需要更改数据预处理方法时,我们只需简单地修改管道中的相应步骤即可。

### 2.3.2 避免数据泄露与模型评估

在进行交叉验证等模型评估时,保持数据在不同评估之间的独立性是至关重要的。Pipelines确保了在交叉验证的每次迭代中,预处理步骤都是在每个训练集的内部独立进行的,从而有效避免了数据泄露的问题。

```python

from sklearn.model_selection import cross_val_score

# 使用管道进行交叉验证

scores = cross_val_score(pipeline, X, y, cv=5)

```

在上述代码中,`cross_val_score`函数自动处理了管道中每个训练集的数据预处理,并对最终的模型进行评分。

在接下来的章节中,我们将深入探讨如何构建基本的机器学习Pipelines,并介绍一些高级Pipelines的使用技巧。

```mermaid

graph TD;

A[开始] --> B[数据预处理]

B --> C[特征选择]

C --> D[缺失值处理]

D --> E[数据归一化]

E --> F[集成机器学习算法]

F --> G[调整模型参数]

G --> H[模型训练与预测]

H --> I[管道持久化]

I --> J[结束]

```

上述流程图清晰地展示了构建基本机器学习Pipelines的步骤。

在下一节中,我们将深入探讨如何选择合适的预处理技术,以及如何将机器学习算法集成到Pipelines中,以便我们能够构建更高效、可靠的机器学习工作流程。

```

# 3. 构建基本的机器学习Pipelines

构建机器学习模型是一个复杂的过程,它涉及多个步骤,包括数据预处理、特征提取、模型选择、训练、验证、参数调整和模型评估。对于初学者来说,这个过程可能显得相当复杂和容易出错。幸运的是,scikit-learn提供了一种简便的方式来简化和自动化这些步骤,这个工具就是Pipelines。

在前一章中,我们了解了Pipelines的工作原理和它的优势。现在,让我们深入探讨如何构建基本的机器学习Pipelines,以及如何将它们应用于实际问题。

## 3.1 选择合适的预处理技术

### 3.1.1 特征选择方法

在构建Pipelines之前,选择合适的预处理技术和特征选择方法至关重要。特征选择的目的是找到最能够代表数据特征的变量,以便机器学习算法能够更高效地学习。在scikit-learn中,有多种特征选择方法可供选择:

- `SelectKBest`:根据特定的统计测试选择特征。

- `SelectFromModel`:基于模型的重要性选择特征。

- `VarianceThreshold`:根据特征的方差过滤特征。

- `RFE`:递归特征消除,使用模型的权重来递归地移除特征。

例如,使用`SelectKBest`和`f_classif`(用于分类任务的ANOVA F-value)选择K个最高评分的特征:

```python

from sklearn.feature_selection import SelectKBest, f_classif

from sklearn.pipeline import Pipeline

# 定义特征选择步骤

select_k_best = SelectKBest(f_classif, k='all') # 'all'表示保留所有特征

# 创建Pipelines

pipeline = Pipeline([

('select_features', select_k_best),

('classifier', LogisticRegression())

])

```

在这个例子中,`SelectKBest`对象作为管道中的一个步骤,它的`k`参数决定了保留的特征数量。之后,我们可以训练这个管道,并在交叉验证中评估其性能。

### 3.1.2 缺失值处理策略

数据集中可能会存在缺失值,我们需要一个策略来处理它们。一些常见的策略包括删除含有缺失值的行或列、用统计值(如均值、中位数)填充缺失值、或者使用更复杂的模型进行预测。

`SimpleImputer`类提供了上述策略的实现:

```python

from sklearn.impute import SimpleImputer

# 创建一个用列中值填充的imputer

imputer = SimpleImputer(strategy='mean')

```

结合到Pipelines中,可以如下使用:

```python

from sklearn.pipeline import Pipeline

# 创建一个包含imputer和分类器的Pipelines

pipeline = Pipeline([

('impute', SimpleImputer(strategy='mean')),

('classifier', LogisticRegression())

])

```

在这个管道中,`SimpleImputer`会首先填充数据集中的缺失值,然后数据会传递给`LogisticRegression`进行分类。

## 3.2 集成机器学习算法到Pipelines

### 3.2.1 选择适合的机器学习模型

一旦我们处理了数据的预处理和特征选择,下一步就是集成机器学习算法到Pipelines中。scikit-learn提供了多种机器学习算法,适用于不同的问题。这些算法包括分类器、回归器、聚类器等等。

选择机器学习模型时,应考虑以下因素:

- 数据的类型(分类、回归、聚类等)

- 数据集的大小和复杂性

- 需要多少调参工作

- 是否需要可解释性

### 3.2.2 调整模型参数与交叉验证

机器学习模型通常有多个超参数需要调整。手动寻找最佳超参数组合既耗时又容易出错。scikit-learn提供了一些有用的工具,如`GridSearchCV`,它可以自动化超参数的搜索过程。

例如,使用`GridSearchCV`来寻找最佳的`C`和`gamma`值对支持向量机(SVM)进行调参:

```python

from sklearn.model_selection import GridSearchCV

# 创建SVM分类器

svc = SVC()

# 定义要搜索的参数范围

param_grid = {

'C': [0.1, 1, 10, 100],

'gamma': [1, 0.1, 0.01, 0.001]

}

# 实例化GridSearchCV对象

grid_search = GridSearchCV(svc, param_grid, cv=5

```

0

0