【scikit-learn模型持久化】:保存和加载训练好的模型的终极指南

发布时间: 2024-09-30 08:08:40 阅读量: 56 订阅数: 37

# 1. scikit-learn模型持久化概述

在构建机器学习模型时,从数据预处理到模型训练再到模型评估,最终得到一个表现良好的模型是一个复杂而漫长的过程。模型持久化是将训练好的模型保存到磁盘,并在需要时重新加载该模型,无需重新训练即可进行预测和评估。这一过程对于模型的部署和后续的维护工作至关重要。持久化机制不仅可以节省计算资源,还可以提高业务响应速度,保障模型的可靠性和可用性。在scikit-learn中,模型持久化主要通过序列化和反序列化的方法实现,而`pickle`模块和`joblib`库是常用的方式。本章将对scikit-learn的模型持久化进行一个概括性的介绍,并为后续章节的深入讨论奠定基础。

# 2. scikit-learn中的模型保存与加载机制

在机器学习的生命周期中,模型的保存与加载是一项基础而重要的任务。它允许数据科学家保存训练好的模型,并在需要时轻松地重新加载它们,以便进行预测或进一步的分析。scikit-learn库为模型持久化提供了多种工具,本章将详细探讨这些机制,并提供实战演练。

## 2.1 模型持久化的理论基础

### 2.1.1 什么是模型持久化

模型持久化是指将机器学习模型的状态保存到一个持久的存储介质中,以便模型可以被保存下来供以后重新使用。这不仅包括模型的参数和权重,还包括模型的配置和结构信息。持久化使得模型的保存、迁移和部署变得更加容易,是实现模型服务化和产品化的关键步骤。

### 2.1.2 持久化的重要性与应用场景

持久化的重要性不言而喻,它对于模型的长期保存和重复使用至关重要。在实际应用中,持久化可以用于:

- **快速部署:** 模型保存后,可以轻松地部署到不同的生产环境中。

- **版本控制:** 保存不同时间点的模型版本,方便进行版本比较和回滚。

- **节省资源:** 重新训练一个复杂的模型可能消耗大量的计算资源,持久化允许省去重复训练的需要。

- **多平台使用:** 将模型部署到不同的平台或设备上,如服务器、移动应用或云服务。

## 2.2 使用pickle序列化模型

### 2.2.1 pickle的基本使用方法

Python的`pickle`模块是实现对象序列化的标准工具。序列化是将对象状态转换为可以存储或传输的格式的过程,而反序列化则是在需要时将格式恢复为对象的过程。在scikit-learn中,可以使用pickle来序列化和反序列化模型。

下面是一个使用pickle保存和加载模型的基本示例:

```python

import pickle

from sklearn.linear_model import LogisticRegression

# 创建并训练模型

model = LogisticRegression()

model.fit(X_train, y_train)

# 保存模型到文件

with open('model.pkl', 'wb') as ***

***

* 加载模型

with open('model.pkl', 'rb') as ***

***

* 使用加载的模型进行预测

predictions = model_loaded.predict(X_test)

```

在上述代码中,我们首先导入了`pickle`模块和`LogisticRegression`模型。通过`fit`方法训练模型后,我们使用`pickle.dump`将训练好的模型保存到磁盘文件`model.pkl`中。加载模型时,我们使用`pickle.load`读取文件内容,并得到一个可使用的模型实例。

### 2.2.2 模型的保存与加载实战演练

为了更深入地理解pickle的使用,让我们通过一个实战演练来演示如何保存和加载一个随机森林模型。我们将使用scikit-learn内置的鸢尾花数据集:

```python

from sklearn.ensemble import RandomForestClassifier

from sklearn.datasets import load_iris

import joblib

# 加载数据集

iris = load_iris()

X, y = iris.data, iris.target

# 分割数据集

from sklearn.model_selection import train_test_split

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# 创建模型

rf = RandomForestClassifier(n_estimators=100)

# 训练模型

rf.fit(X_train, y_train)

# 使用joblib保存模型

joblib.dump(rf, 'random_forest_model.pkl')

# 使用joblib加载模型

rf_loaded = joblib.load('random_forest_model.pkl')

# 验证加载的模型

predictions = rf_loaded.predict(X_test)

```

在这个例子中,我们使用`joblib`进行了模型的保存和加载,这是因为`joblib`是scikit-learn官方推荐的方式,特别是在保存大型数组或模型时,它比pickle更高效。

### 2.2.3 pickle安全性考量

虽然pickle在模型持久化中非常有用,但需要注意的是,它并不是一个安全的序列化工具。使用pickle时,加载的代码可能执行任意的Python代码,这使得它容易受到反序列化攻击,即通过精心构造的pickle数据来执行恶意代码。

为了减小安全风险,可以采取以下措施:

- **限制可信任的pickle数据来源:** 只对已知和可信任的数据源使用pickle。

- **使用`pickle`的安全性选项:** 可以使用`pickle`的安全性设置来限制可反序列化的对象类型。

- **考虑使用其他序列化工具:** 对于安全性要求更高的场合,考虑使用如`joblib`或其他序列化工具。

## 2.3 使用joblib进行大型数据持久化

### 2.3.1 joblib与内存管理

`joblib`是专为Python中的大数据持久化设计的库,它通过使用内存映射文件和文件锁定来提高性能。`joblib`非常适合处理大型数据集或需要频繁保存和加载的模型,因为它可以显著减少I/O开销。

### 2.3.2 实现大型模型的保存和加载

对于大型数据和模型,使用`joblib`可以带来性能上的优势。以下是一个例子:

```python

from sklearn.datasets import make_classification

from sklearn.ensemble import GradientBoostingClassifier

import joblib

# 生成一个大型数据集

X, y = make_classification(n_samples=10000, n_features=100, random_state=42)

# 创建一个 GradientBoosting 分类器

clf = GradientBoostingClassifier(n_estimators=100, random_state=42)

# 训练模型

clf.fit(X, y)

# 使用 joblib 保存模型到文件

joblib.dump(clf, 'gradient_boosting_model.pkl')

# 加载模型进行预测

clf_loaded = joblib.load('gradient_boosting_model.pkl')

predictions = clf_loaded.predict(X)

```

在这个例子中,我们首先生成了一个大型的数据集,并使用`GradientBoostingClassifier`训练了一个模型。然后,我们使用`joblib.dump`将模型保存到磁盘,使用`joblib.load`加载模型,并用加载的模型进行预测。

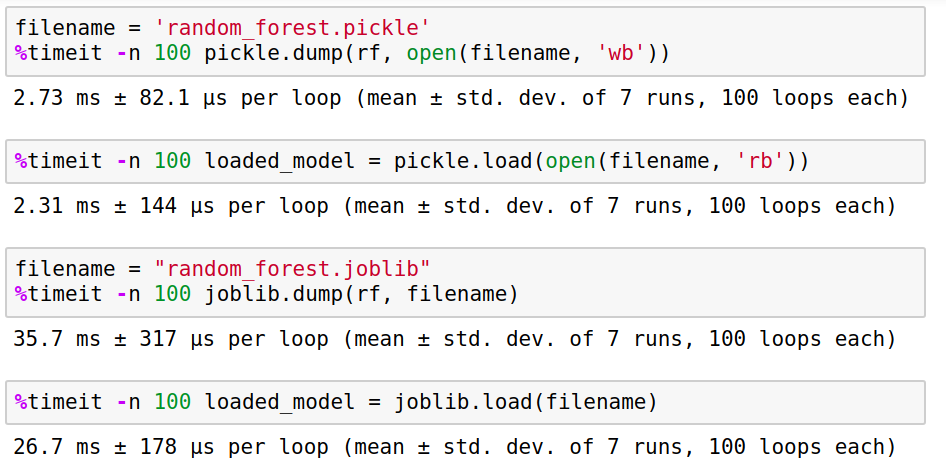

### 2.3.3 joblib的性能优势分析

`joblib`相比于标准的`pickle`库在处理大规模数据和模型时具有显著的优势。这种性能优势主要来自于以下几个方面:

- **内存映射文件:** `joblib`使用内存映射文件(memory-mapped files),这样可以将数据存储在磁盘上,并像访问内存一样访问这些数据。这对于大型数组尤其有用,因为这样就不需要一次性将所有数据加载到内存中。

- **文件锁定:** 当多个进程需要访问同一个文件时,`joblib`可以对文件进行锁定,避免数据损坏或资源竞争。

- **高效的并行处理:** `joblib`支持高效的并行处理,这对于处理大型数据集非常有用。

## 2.4 模型持久化在scikit-learn中的高级应用

### 2.4.1 模型持久化与交叉验证

在模型选择和超参数调优中,我们经常使用交叉验证。为了优化这一流程,scikit-learn提供了`GridSearchCV`和`RandomizedSearchCV`等工具,它们能够在内部处理模型的持久化。

### 2.4.2 使用Pipeline进行持久化

`Pipeline`是scikit-learn中的一个强大工具,它允许将数据预处理和模型训练的步骤串联起来。当使用Pipeline时,整个模型工作流都可以被保存和加载,这意味着可以轻松地保存整个工作流,并在其他地方或时间点重新使用它。

以上是第二章的核心内容,详细介绍了模型持久化的基础和scikit-learn

0

0