【模型与数据量】:深入分析欠拟合与过拟合的定量关系

发布时间: 2024-09-02 17:23:17 阅读量: 43 订阅数: 34

驭龙之术:驾驭过拟合与欠拟合

# 1. 模型拟合的基本概念

在机器学习和统计学中,模型拟合是核心概念之一,旨在通过算法找出能够最佳代表数据关系的函数或者模型。拟合过程涉及理解模型参数与实际数据之间的关系,以及如何通过调整这些参数,使模型输出与观测数据吻合。

## 模型与数据的关系

模型通常通过特定的数学公式表达,将输入数据(特征)映射到输出(目标变量)。理想情况下,模型应捕捉输入和输出之间的内在规律,进而对新的、未见过的数据进行准确预测。

## 拟合优度的衡量

衡量模型拟合优度的常用方法包括均方误差(MSE)、决定系数(R²)等。这些指标有助于判断模型在给定数据集上的表现是否理想,以及是否存在过拟合或欠拟合现象。

## 模型泛化的含义

模型泛化是指模型对未知数据的预测能力。一个泛化能力强的模型,即便在新的数据集上,也能够保持良好的预测性能。泛化能力是模型评估的重要标准。

在此章,我们将介绍这些基本概念,并为后续章节中深入探讨模型的欠拟合与过拟合问题打下基础。

# 2. 欠拟合与过拟合的理论基础

### 2.1 欠拟合的定义与表现

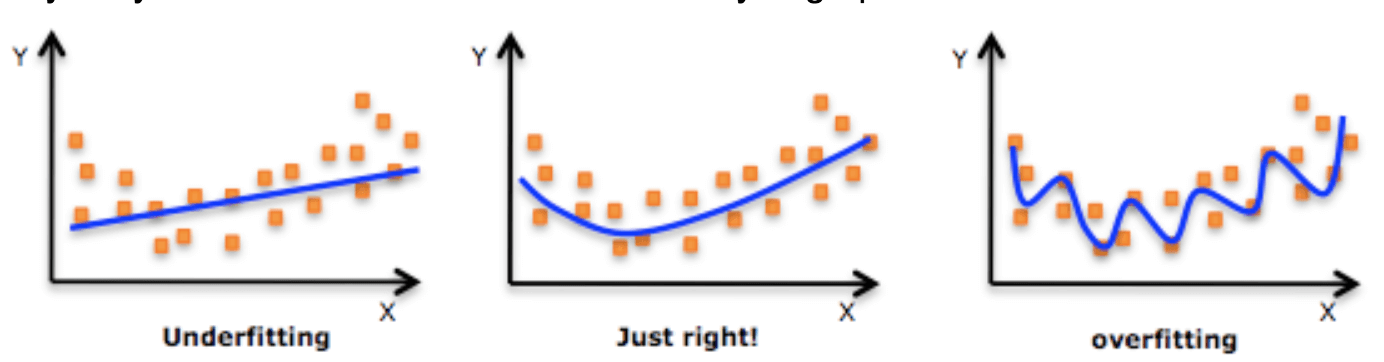

在机器学习中,模型与数据之间的匹配程度直接影响着模型的性能。当模型过于简单,无法捕捉数据的潜在结构时,就会出现欠拟合现象。这通常意味着模型无法在训练数据上表现良好,更不用说泛化到未见过的数据上。

#### 模型复杂度与数据复杂度的关系

模型复杂度和数据复杂度之间的关系是机器学习中的一个重要方面。一个过于简单的模型可能无法充分学习数据的特征,导致欠拟合。反之,一个过于复杂的模型可能会学习到数据中的噪声,导致过拟合。理想的模型复杂度应该能够匹配数据的复杂度,即足够捕捉数据中的主要特征,同时避免学习到无关的噪声。

#### 欠拟合对模型性能的影响

欠拟合的模型不仅在训练集上的性能表现不佳,而且在测试集上也无法达到满意的准确率。这主要因为模型没有充分学习到特征和标签之间的关联。因此,识别并解决欠拟合问题对提高模型性能至关重要。

### 2.2 过拟合的定义与表现

过拟合是指模型对训练数据的拟合过于紧密,以至于捕捉到了数据中的噪声和异常值,而不是底层的数据分布。这会导致模型在训练数据上表现很好,但在新的、未见过的数据上表现较差。

#### 过拟合的识别与特征

识别过拟合的一个常见方法是监控训练过程中的损失函数值和准确率指标。如果在训练集上的准确率持续提高,而在验证集或测试集上准确率提高缓慢或开始下降,这往往是过拟合的信号。此外,过拟合的模型通常具有较高的方差,即在不同的训练集上训练出来的模型性能会大不相同。

#### 过拟合对模型性能的影响

过拟合严重阻碍了模型的泛化能力,即从训练数据到新数据的性能转移。过拟合的模型在训练集上的表现会给人一种假象,仿佛模型具有很高的预测能力,但一旦面对真实世界的数据,这种能力就会大打折扣。

### 2.3 欠拟合与过拟合的定量关系

模型的泛化能力是机器学习中非常关键的一个概念,它是指模型在未见过的数据上的性能。理想情况下,我们希望模型能够在保持训练集上良好性能的同时,也能够泛化到新的数据上。

#### 模型容量与泛化能力的平衡

模型容量是指模型能够表示的数据结构的复杂度。一个模型容量适中的模型应该能够捕捉到数据的特征,同时忽略掉数据中的噪声。确定模型容量时需要在欠拟合和过拟合之间寻找平衡点。

#### 训练数据量与模型性能的关系

数据量对于模型性能的影响也是至关重要的。在其他条件相同的情况下,更多的训练数据可以提供更全面的数据视角,从而减少过拟合的风险。然而,增加数据量并不总能解决问题,特别是在数据质量不佳的情况下,可能还会增加过拟合的风险。因此,寻找训练数据量与模型容量之间的平衡同样重要。

为了更细致地理解欠拟合与过拟合之间的关系,可以采用以下代码示例,它展示了在不同训练数据量和模型复杂度下模型性能的变化:

```python

import numpy as np

from sklearn.model_selection import train_test_split

from sklearn.metrics import accuracy_score

from sklearn.linear_model import LogisticRegression

from sklearn.datasets import make_classification

# 生成一个简单的二分类数据集

X, y = make_classification(n_samples=1000, n_features=20, n_informative=2, n_redundant=10, random_state=42)

# 将数据集分为训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# 定义模型复杂度从低到高的逻辑回归模型

model_complexities = [LogisticRegression(C=1000, solver='liblinear'),

LogisticRegression(C=1, solver='liblinear'),

LogisticRegression(C=0.01, solver='liblinear')]

# 记录每个复杂度模型的性能

performance = {f"model_{i+1}": [] for i in range(len(model_complexities))}

for i, model in enumerate(model_complexities):

for j in range(10): # 假定我们有10个不同的数据集大小

n_samples = j * 100 + 100 # 从100到1000样本

X_train_sub, _, y_train_sub, _ = train_test_split(X_train, y_train, train_size=n_samples, random_state=42)

model.fit(X_train_sub, y_train_sub)

y_pred = model.predict(X_test)

performance[f"model_{i+1}"].append(accuracy_score(y_test, y_pred))

# 将性能结果绘制出来

import matplotlib.pyplot as plt

for i, perf in enumerate(performance.values()):

plt.plot(range(100, 1001, 100), perf, label=f"Model {i+1}")

plt.title("Model Performance vs. Training Sample Size")

plt.xlabel("Training Sample Size")

plt.ylabel("Test Accuracy")

plt.legend()

plt.show()

```

通过这个示例,我们可以看到模型复杂度和数据量如何影响最终的模型性能。随着数据量的增加,性能通常会提高,但只有当模型复杂度和数据量适配时,才能达到最优性能。在实际应用中,找到这种平衡点,就需要对模型进行细致的调整和多次的实验验证。

# 3. 定量分析方法与工具

在模型训练和机器学习领域,定量分析方法和工具对于理解和改善模型性能至关重要。它们帮助我们通过数值指标来衡量模型的表现,并指导我们在模型复杂度、数据量和模型容量之间找到最佳平衡点。本章节将详细探讨这些方法和工具,并通过实际操作向读者展示如何应用它们来评估和优化机器学习模型。

## 3.1 交叉验证的方法论

交叉验证是一种强大的技术,用于评估模型对未知数据的泛化能力,并减少模型评估中的方差。最常用的交叉验证方法是k折交叉验证,它将数据集分成k个大小相等的子集。训练过程分为k个阶段,每个阶段中模型使用k-1个子集作为训练集,剩下的一个子集作为验证集。

### 3.1.1 k折交叉验证的原理与实践

k折交叉验证的核心思想是利用有限的数据获得更加稳健和可靠的模型性能评估。在实践中,k通常选择为5或10,这是因为这些数值既能保证每个训练集和验证集大小适中,又能在有限的计算资源下进行多次迭代评估。

在Python中使用k折交叉验证的代码示例如下:

```python

f

```

0

0