【NLP中的过拟合与欠拟合】:影响分析与处理策略

发布时间: 2024-09-02 17:35:31 阅读量: 41 订阅数: 33

深度学习源码神经网络过拟合与欠拟合ipynb源码带数据集

# 1. 过拟合与欠拟合的基本概念

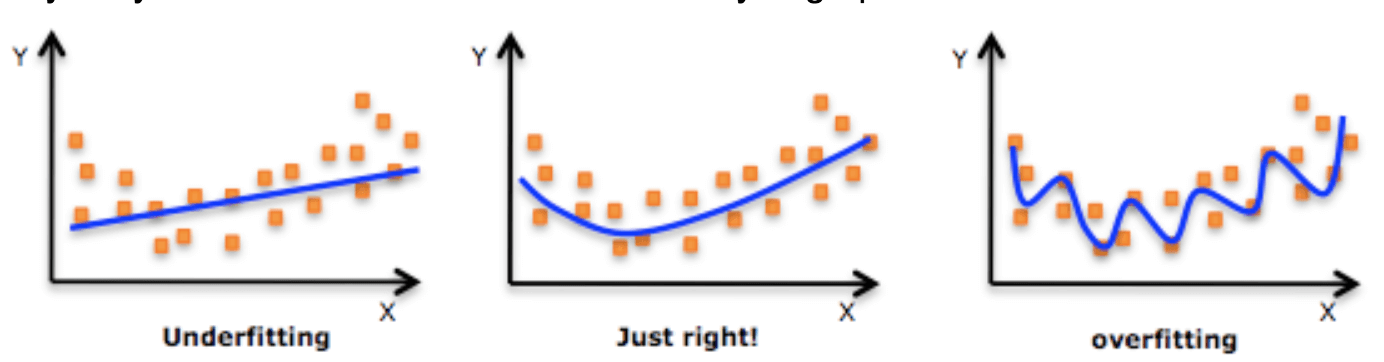

在机器学习领域,模型的性能受到多种因素的影响,其中最核心的问题之一就是过拟合与欠拟合现象。理解过拟合与欠拟合是构建高效、稳定模型的关键步骤。

## 1.1 过拟合与欠拟合的含义简述

**过拟合**通常发生在模型过于复杂时,它能够精确地模拟训练数据中的随机波动和噪声,却无法在新的、未见过的数据上保持同样的性能。这就像是我们的模型在训练过程中过于“勤奋”,以至于它记忆了训练数据,而不是学会了数据中的规律。

**欠拟合**则发生在模型过于简单或训练不充分的情况下,此时模型无法捕捉到数据的真实关系,即便在训练集上表现也通常较差。欠拟合的模型就像是太过“懒惰”,以至于它没有能力去学习数据中的复杂结构。

在下一章节,我们将深入探讨过拟合与欠拟合的理论基础,并分析它们是如何对模型泛化能力和预测性能产生影响的。

# 2. 过拟合与欠拟合的理论基础

## 2.1 过拟合与欠拟合的定义及产生原因

### 2.1.1 过拟合的概念和典型场景

在机器学习和统计建模中,过拟合(Overfitting)是一个常见问题,它指的是模型对训练数据的拟合程度过高,以至于模型学习到了训练数据中的噪声和不具普遍性的特征,从而失去了泛化能力。过拟合导致模型在训练集上的表现非常出色,但在新的、未见过的数据上表现差强人意。

典型的过拟合场景出现在复杂的模型中,如深度神经网络,当模型拥有过多的参数时,如果没有足够的数据来支持这些参数的学习,模型就有可能过拟合。此外,在分类问题中,如果类别间的界限非常复杂,使用过于简单的模型也会导致过拟合。

```python

# 示例代码:使用scikit-learn库创建过拟合模型

from sklearn.datasets import make_classification

from sklearn.linear_model import LogisticRegression

from sklearn.model_selection import train_test_split

from sklearn.metrics import accuracy_score

# 生成模拟数据

X, y = make_classification(n_samples=100, n_features=20, n_informative=2, n_redundant=10, random_state=42)

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# 创建逻辑回归模型

model = LogisticRegression()

# 拟合模型

model.fit(X_train, y_train)

# 预测测试集

predictions = model.predict(X_test)

# 计算准确率

print("Model accuracy:", accuracy_score(y_test, predictions))

```

在上面的代码中,我们使用scikit-learn库生成了一个模拟分类数据集,并用逻辑回归模型进行训练。由于数据集较小且维度较高,逻辑回归模型可能会过度拟合数据,从而在测试集上的准确率并不会很好。

### 2.1.2 欠拟合的概念和典型场景

与过拟合相对的是欠拟合(Underfitting),它发生在模型过于简单,无法捕捉数据的真实结构,无法对数据进行有效的拟合。当一个模型不能适应训练数据的结构时,这个模型就显得“懒惰”,它没有学会数据中的关键特征,其在训练集和测试集上的性能都较差。

欠拟合通常发生在模型复杂度低于问题复杂度的情况。例如,在非线性问题中,如果使用线性模型去拟合,就可能会发生欠拟合。或者,当模型没有足够的时间学习,或者特征工程没有做好时,也会导致欠拟合。

```python

# 示例代码:使用线性模型处理非线性问题,导致欠拟合

from sklearn.datasets import make_moons

from sklearn.model_selection import train_test_split

from sklearn.linear_model import LogisticRegression

from sklearn.metrics import accuracy_score

# 生成模拟的非线性数据

X, y = make_moons(n_samples=100, noise=0.2, random_state=42)

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# 创建逻辑回归模型

model = LogisticRegression()

# 拟合模型

model.fit(X_train, y_train)

# 预测测试集

predictions = model.predict(X_test)

# 计算准确率

print("Model accuracy:", accuracy_score(y_test, predictions))

```

在这段代码中,我们使用`make_moons`函数生成了一个非线性分布的二分类数据集。尽管我们尝试使用线性模型(逻辑回归)来处理这个非线性问题,预测结果仍不太理想,显示出模型无法捕捉数据的真实结构,即发生了欠拟合。

## 2.2 过拟合与欠拟合的影响分析

### 2.2.1 对模型泛化能力的影响

泛化能力是指模型对未见过数据的预测能力。过拟合和欠拟合都会影响模型的泛化能力。

在过拟合的情况下,模型对于训练数据过于敏感,导致它无法将学到的知识泛化到新的数据上。这意味着模型在处理新的数据时,可能会得出完全不同的结果,从而使得模型的预测变得不可靠。

而欠拟合则意味着模型过于简单,缺乏足够的容量来捕获数据的潜在分布,即使模型在训练集上表现不佳,它在新数据上的表现也不会有显著的提升,因为模型本身不能够捕捉数据的真实规律。

### 2.2.2 对模型预测性能的影响

过拟合导致模型在训练集上过度敏感,而在未见数据上的表现往往很差,这导致模型的预测性能不稳定,甚至可能完全失效。在极端情况下,过拟合的模型可能会将训练数据中的噪声视为信号,从而在预测时出现错误。

欠拟合的模型则由于过于简单,不能捕捉数据的复杂性,因此在训练和测试集上的性能都会很低。这种模型不能提供足够的预测精度,即使是在训练数据上也是如此。

## 2.3 理论模型与实际应用的关系

### 2.3.1 理论模型的简化与实际应用的复杂性

理论模型通常是基于特定的假设和简化的条件。在实际应用中,数据和环境的复杂性往往远远超出理论模型的考虑。因此,理论模型提供的解决方案可能无法直接应用于复杂的真实世界场景。

例如,理论统计模型在研究时往往假设数据满足正态分布等条件,而实际中的数据可能包含异常值、偏态分布等,使得理论模型无法直接应用,或者即使应用也会导致过拟合或欠拟合。

### 2.3.2 理论与实践中的过拟合与欠拟合对比分析

在理论与实践的对比中,过拟合和欠拟合现象很常见。在理论研究中,通过精心设

0

0