【图像识别中的欠拟合】:表现分析与解决之道

发布时间: 2024-09-02 17:31:03 阅读量: 50 订阅数: 41

# 1. 图像识别中的欠拟合现象

## 1.1 欠拟合的概念及其影响

欠拟合是图像识别领域中常见的一个问题,指的是机器学习模型无法捕捉到数据中的复杂模式和关系,导致其在训练集和测试集上都有较差的表现。这通常发生在模型过于简单,无法表达数据的真实分布时。欠拟合不仅降低了模型的预测准确性,还可能导致模型无法泛化到新的数据集,严重影响其实际应用效果。

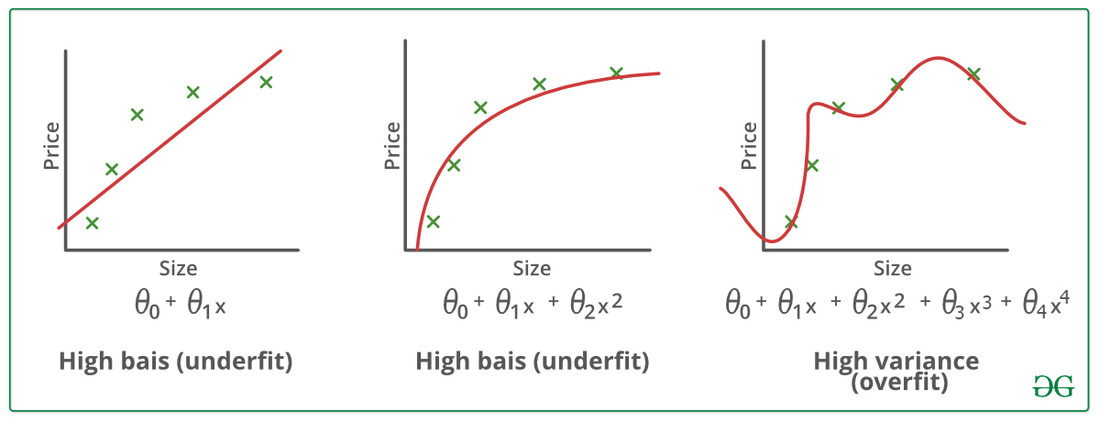

## 1.2 欠拟合与过拟合的区别

在图像识别中,欠拟合和过拟合是两个相对的概念。过拟合通常发生在模型过于复杂时,模型捕捉到了训练数据中的噪声和细节,但在未见过的数据上表现不佳。而欠拟合则是在模型过于简单或者没有足够的训练情况下发生的。识别这两者的区别对于正确诊断和解决模型性能问题是至关重要的。通过监控模型在训练和验证集上的表现,可以有效区分这两种情况,并采取相应的优化措施。

## 1.3 欠拟合的成因与表现

图像识别中的欠拟合可能是由于数据不足、特征不充分或者模型选择不当造成的。模型的性能不彰可能是欠拟合的表现之一,例如,当模型在训练集和测试集上的性能都非常低时,这往往意味着模型无法学习到数据中的特征。为了避免欠拟合,我们需要对数据进行充分的预处理,选择合适的模型架构,并确保有足够的训练数据支撑模型学习。在后续章节中,我们将深入探讨如何评估和解决欠拟合问题。

# 2. 欠拟合的理论基础与评估

### 2.1 欠拟合的概念与特征

#### 2.1.1 欠拟合定义与原因

欠拟合是机器学习领域中常见的一种现象,尤其在图像识别任务中,当模型在训练数据和新的数据上都表现不佳时,我们称之为欠拟合。欠拟合通常发生在模型过于简单或训练时间不足,无法捕捉数据中的复杂模式和关系时。简单模型可能没有足够的能力来表示数据中的关键特征,这导致模型无法学习到足够的信息来做出准确的预测。

#### 2.1.2 欠拟合与过拟合的区别

与欠拟合相对的是过拟合,过拟合是指模型在训练数据上表现很好,但是在未见过的数据上表现较差。过拟合通常发生在模型过于复杂,例如模型的参数过多,导致它记住了训练数据中的噪声和具体样本特性,而不是学习到更通用的规律。而欠拟合则是模型连训练集都学不好。理想的状态是模型能够达到良好的泛化能力,即在训练集和测试集上都能有良好的表现。

### 2.2 欠拟合的度量方法

#### 2.2.1 训练集和测试集表现分析

衡量一个模型是否欠拟合,一个简单直接的方法是分别观察它在训练集和测试集上的表现。如果模型在训练集上的表现和在测试集上的表现都很差,并且两者差距不大,那么模型可能就是欠拟合的。通常,我们可以使用准确率、召回率、F1分数、混淆矩阵等指标来衡量模型性能。

#### 2.2.2 正则化与模型复杂度

模型的复杂度和训练时使用的正则化方法也会影响欠拟合的程度。正则化技术如L1和L2正则化可以防止模型过拟合,但如果正则化太强,模型可能会变得过于简单,从而导致欠拟合。通过调整正则化参数,可以找到防止过拟合并避免欠拟合的平衡点。

### 2.3 评价模型欠拟合的工具和实践

#### 2.3.1 使用交叉验证评估模型

交叉验证是一种强大的技术,用于评估模型在未知数据上的表现,进而判断是否存在欠拟合。它通过将数据集分成k个大小相同的部分,然后使用k-1部分作为训练集,剩下的1部分作为测试集,进行k次训练和验证,最后取平均结果作为模型的性能评估。交叉验证可以帮助我们更准确地估计模型在独立数据集上的泛化能力。

#### 2.3.2 模型可视化技巧

可视化是诊断模型性能问题的重要工具。通过绘制学习曲线,我们可以直观地看到随着训练过程的进行,模型在训练集和验证集上的性能如何变化。如果两条曲线都已经收敛,并且都处于较低的性能水平,这表明模型可能遭受欠拟合。以下是一个示例代码块,展示如何使用matplotlib绘制学习曲线:

```python

import matplotlib.pyplot as plt

from sklearn.metrics import accuracy_score

# 假设我们已经有了一些训练过程中的准确率数据

train_accs = [0.7, 0.71, 0.73, 0.72, 0.74]

val_accs = [0.6, 0.61, 0.61, 0.63, 0.62]

epochs = range(len(train_accs))

plt.plot(epochs, train_accs, 'g', label='Training accuracy')

plt.plot(epochs, val_accs, 'b', label='Validation accuracy')

plt.title('Training and Validation Accuracy')

plt.legend()

plt.show()

```

通过绘制学习曲线,我们可以直观地看到模型在训练和验证集上的性能,以及是否存在欠拟合或过拟合的情况。

在本节中,我们介绍了欠拟合的基本概念和特征,探讨了如何度量和评估模型的欠拟合情况,以及通过可视化技巧来诊断欠拟合问题。通过这些理论和实践方法,数据科学家和机器学习工程师可以更有效地识别和解决欠拟合问题,从而提升模型的性能和泛化能力。

# 3. 解决欠拟合的理论与策略

欠拟合是模型训练中常遇到的问题之一,它指的是模型无法捕捉到训练数据中的基本关系,导致模型在训练集和测试集上都表现不佳。解决欠拟合的关键在于增强模型的表达能力和捕捉数据复杂性的能力。本章节将深入探讨解决欠拟合的策略,包括数据增强技术、特征工程的重要性和模型选择与调整。

## 3.1 数据增强技术

### 3.1.1 扩展数据集的方法

在图像识别任务中,数据集的规模直接影响模型的泛化能力。当训练数据量不足时,模型容易出现欠拟合。数据增强技术通过扩展数据集来提高模型的泛化能力,具体包括如下方法:

- **旋转(Rotation)**:通过对图像进行旋转,可以在不改变类别的前提下,生成新的图像样本。

- **缩放(Scaling)**:对图像进行缩小和放大操作,增加模型对不同尺度的物体的识别能力。

- **平移(Translation)**:将图像沿水平和垂直方向移动,以此来模拟物体在图像中位置的变化。

- **翻转(Flipping)**:水平或垂直翻转图像,提供对称性变化的样本。

- **剪裁(Cropping)**:从原始图像中随机剪裁出一部分作为新的样本,提高模型对图像局部特征的识别能力。

这些方法通过增加数据的变化性,使模型在训练过程中能够学习到更多样的特征表示,从而提高对原始数据集的拟合能力。

### 3.1.2 数据增强对欠拟合的影响

数据增强技术能够间接增加模型的容量,通过提供更为丰富的训练样本,提高模型对复杂数据分布的拟合能力。举一个简单的例子,假设有一个简单的模型用于手写数字识别,原始数据集中数字的大小和位置都是一致的。如果直接训练,模型将只能识别具有特定大小和位置的数字。通过数据增强技术,如旋转、缩放和平移,模型就可以学习到不同大小和位置的数字表示,从而解决欠拟合问题。

数据增强不仅增加了数据的多样性,还能够模拟数据在现实世界中的变化,如光照变化、遮挡等,因此,它是解决欠拟合的有效策略之一。

## 3.2 特征工程的重要性

### 3.2.1 特征选择与特征构建

特征工程是机器学习中的重要步骤,对于图像识别任务尤其关键。特征选择和构建是特征工程中的两个重要方面,它们直接关系到模型的性能。

- **特征选择**:是指从原始特征中选择最有信息量的特征,剔除噪声和不相关特征,提高模型的准确性和效率。

- **特征构建**:是根据业务需求和数据特点,构造出更有助于学习的特征。例如,在图像识别任务中,可以构造边缘特征、纹理特征等。

特征选择与构建的核心目标是增强模型的特征表达能力,简化模型结构,从而减少过拟合的风险并提升模型对未知数据的泛化能力。

### 3.2.2 特征转换技术

特征转换技术包括主成分分析(PCA)、线性判别分析(LDA)、t分布随机邻域嵌入(t-SNE)等,它们能够将原始特征转换到一个新的特征空间,从而实现特征的降维或增强。

- **主成分分析(PCA)**:通过正交变换将一组可能相关的变量转换为一组线性不相关的变量,这些新变量称为主成分。PCA常用于减少特征空间的维数,去除噪声和冗余特征。

- **线性判别分析(LDA)**:是一种监督学习的特征提取技术,它尝试找到一个线性变换,使得变换后的数据在类别之间具有最大的可分性。

通过特征转换技术,可以提炼出更有用的特征信息,同时降低模型的复杂度,这有助于解决欠拟合的问题。

## 3.3 模型选择与调整

### 3.3.1 理解不同模型的容量

模型容量是指模型表示复杂函数的能力。一个模型的容量是由其结构的复杂度决定的,例如,神经网络的层数和每层的神经元数量。在解决欠拟合的问题时,需要选择容量合适的模型:

- **小模型**:容易欠拟合,因为其容量有限,不能捕捉数据中的复杂关系。

- **大模型**:虽然能捕捉复杂关系,但如果没有足够数据支持,可能会过拟合。

- **适当模型**:需要根据任务和数据规模来选择,以达到在欠拟合和过拟合之间取得平衡。

### 3.3.2 参数优化与模型微调

在确定了模型结构后,参数优化是提升模型性能的关键步骤。参数优化通常包括学习率的选择、权重初始化、批量大小等。

- **学习率调整**:学习率决定了在优化过程中参数更新的步长大小。学习率太小会导致训练过程缓慢,而学习率太大则可能导致训练不收敛。

- **权重初始化**:合理的权重初始化有助于模型快速收敛,常用的初始化方法有Xavier初始化和He初始化。

- **批量大小调整**:批量大小对模型的训练过程和泛化能力都有影响。较大的批量大小可以加快训练速度,但可能会降低模型的泛化能力。

模型微调是指在预训练模型的基础上进一步训练模型,以适应特定任务。在深度学习中,迁移学习经常使用微调策略来解决欠拟合问题,特别是在数据量有限时。

### 代码块及逻辑分析

```python

import tensorflow as tf

from tensorflow.keras.preprocessing.image import ImageDataGenerator

# 创建图像生成器实例,应用数据增强技术

datagen = ImageDataGenerator(

rotation_range=20, # 旋转角度范围

width_shift_range=0.2, # 水平位移范围

height_shift_range=0.2, # 垂直位移范围

shear_range=0.2, # 剪切变换的程度

zoom_range=0.2, # 随机缩放的程度

horizontal_flip=True, # 水平翻转

fill_mode='nearest' # 填充新创建像素的方法

)

# 训练生成器

datagen.fit(train_dataset) # train_dataset是包含训练图像的numpy数组

# 编译模型

model = tf.keras.models.Sequential([

tf.keras.layers.Conv2D(32, (3,3), activation='relu', input_shape=(150,150,3)),

tf.keras.layers.MaxPooling2D(2,2),

tf.keras.layers.Conv2D(64, (3,3), activation='relu'),

tf.keras.layers.MaxPooling2D(2,2),

tf.keras.layers.Conv2D(128, (3,3), activation='relu'),

tf.keras.layers.MaxPooling2D(2,2),

tf.keras.layers.Flatten(),

tf.keras.l

```

0

0