最大公约数算法在信息论中的应用:哈夫曼编码的原理,高效数据压缩

发布时间: 2024-08-28 00:57:36 阅读量: 33 订阅数: 31

# 1. 信息论基础

信息论是研究信息的度量、传输和处理的一门学科。它为哈夫曼编码等数据压缩技术提供了理论基础。

### 信息熵

信息熵是衡量信息不确定性的度量。给定一个随机变量 X,其信息熵 H(X) 定义为:

```

H(X) = -Σ p(x) * log2(p(x))

```

其中,p(x) 是 X 取值为 x 的概率。信息熵越高,信息的不确定性越大。

### 数据压缩

数据压缩的目标是减少数据表示所需的比特数,同时保持其信息内容。哈夫曼编码是一种无损数据压缩算法,它利用信息的频率分布来分配可变长的编码,从而实现压缩。

# 2. 哈夫曼编码原理

哈夫曼编码是一种无损数据压缩算法,由大卫·哈夫曼于 1952 年提出。其核心思想是将出现频率较高的符号分配较短的编码,而出现频率较低的符号分配较长的编码,从而实现数据的压缩。

### 2.1 频率分析与哈夫曼树构建

**频率分析**

在进行哈夫曼编码之前,需要对待压缩数据进行频率分析,统计每个符号出现的次数。频率分析的结果通常以哈夫曼树的形式表示。

**哈夫曼树构建**

哈夫曼树是一种二叉树,其中每个叶子节点代表一个符号,而每个内部节点代表两个子节点的组合。哈夫曼树的构建过程如下:

1. 将所有符号按频率升序排列。

2. 从频率最小的两个符号开始,创建两个子树,并将它们连接到一个父节点。

3. 将父节点的频率设置为其子节点频率之和。

4. 重复步骤 2 和 3,直到所有符号都形成一个单一的根节点。

### 2.2 哈夫曼编码的生成与解码

**哈夫曼编码的生成**

哈夫曼编码是通过哈夫曼树生成的。从根节点开始,沿着左分支分配 0,沿着右分支分配 1。每个符号的编码就是从根节点到该符号叶子节点的路径上的所有比特的串联。

**哈夫曼编码的解码**

哈夫曼编码的解码过程与生成过程相反。从根节点开始,依次读取编码中的比特。如果读取的比特为 0,则向左移动;如果读取的比特为 1,则向右移动。移动到叶子节点时,即得到解码后的符号。

### 2.3 哈夫曼编码的优越性

哈夫曼编码具有以下优点:

- **无损压缩:** 哈夫曼编码是一种无损压缩算法,不会丢失任何原始数据。

- **最优压缩率:** 在所有可变长编码中,哈夫曼编码可以达到最优的压缩率。

- **易于实现:** 哈夫曼编码的算法简单易懂,易于实现。

- **广泛应用:** 哈夫曼编码广泛应用于文件压缩、图像压缩和数据传输等领域。

**代码示例:**

```python

def build_huffman_tree(frequencies):

"""

构建哈夫曼树

参数:

frequencies: 符号频率字典

返回:

哈夫曼树的根节点

"""

# 将符号按频率升序排列

symbols = sorted(frequencies.keys(), key=lambda x: frequencies[x])

# 初始化哈夫曼树

tree = []

# 循环构建哈夫曼树

while len(symbols) > 1:

# 获取频率最小的两个符号

symbol1, symbol2 = symbols[0], symbols[1]

# 创建两个子树

left_subtree = (symbol1, frequencies[symbol1])

right_subtree = (symbol2, frequencies[symbol2])

# 创建父节点

parent_node = (None, frequencies[symbol1] + frequencies[symbol2])

# 将子树连接到父节点

parent_node[1] = [left_subtree, right_subtree]

# 更新符号列表

symbols = symbols[2:] + [parent_node]

# 返回哈夫曼树的根节点

return symbols[0]

```

**代码逻辑分析:**

该代码实现了哈夫曼树的构建。首先,它将符号按频率升序排列。然后,它循环构建哈夫曼树,每次从频率最小的两个符号开始,创建两个子树并连接到一个父节点。最后,它返回哈夫曼树的根节点。

# 3.1 文件压缩与解压缩

哈夫曼编码在文件压缩中扮演着至关重要的角色,它通过减少文件大小来提高传输和存储效率。文件压缩过程如下:

1. **频率分析:**对文件中的字符进行频率统计,生成字符及其出现频率的字典。

2. **哈夫曼树构建:**根据频率字典,构建哈夫曼树。哈夫曼树是一种二叉树,其中每个叶节点代表一个字符,其权重等于字符的频率。

3. **哈夫曼编码生成:**从哈夫曼树的根节点开始,为每个分支分配一个二进制位(0 或 1)。沿着从根节点到叶节点的路径,将分配的二进制位连接起来,得到每个字符的哈夫曼编码。

4. **文件压缩:**使用哈夫曼编码替换文件中的原始字符,生成压缩文件。

文件解压缩过程与压缩过程相反:

1. **哈夫曼编码解析:**读取压缩文件中的哈夫曼编码。

2. **哈夫曼树重建:**根据哈夫曼编码,重建哈夫曼树。

3. **字符还原:**从压缩文件中读取二进制位,沿着哈夫曼树从根节点到叶节点进行遍历,还原原始字符。

**代码块:**

```python

def compress(file_path):

# 频率分析

char_freq = get_char_freq(file_path)

# 哈夫曼树构建

huff_tree = build_huff_tree(char_freq)

# 哈夫曼编码生成

huff_codes = generate_huff_codes(huff_tree)

# 文件压缩

compressed_data = compress_data(file_path, huff_codes)

return compressed_data

def decompress(compressed_data):

# 哈夫曼编码解析

huff_codes = parse_huff_codes(compressed_data)

# 哈夫曼树重建

huff_tree = rebuild_huff_tree(huff_codes)

# 字符还原

decompressed_data = decompress_data(compressed_data, huff_tree)

return decompressed_data

```

**逻辑分析:**

* `compress()` 函数接收文件路径,返回压缩后的数据。

* `decompress()` 函数接收压缩后的数据,返回解压缩后的数据。

* `get_char_freq()` 函数对文件中的字符进行频率统计。

* `build_huff_tree()` 函数根据频率字典构建哈夫曼树。

* `generate_huff_codes()` 函数根据哈夫曼树生成哈夫曼编码。

* `compress_data()` 函数使用哈夫曼编码压缩文件。

* `parse_huff_codes()` 函数解析压缩后的数据中的哈夫曼编码。

* `rebuild_huff_tree()` 函数根据哈夫曼编码重建哈夫曼树。

* `decompress_data()` 函数使用哈夫曼树解压缩数据。

**参数说明:**

* `file_path`:要压缩或解压缩的文件路径。

* `compressed_data`:要解压缩的压缩数据。

* `char_freq`:字符及其频率的字典。

* `huff_tree`:哈夫曼树。

* `huff_codes`:哈夫曼编码。

# 4. 哈夫曼编码的算法优化

### 4.1 贪心算法的局限性

哈夫曼编码算法是一种贪心算法,其基本思想是每次选择两个频率最小的符号进行合并,直到只剩下一个符号。然而,这种贪心策略存在一定的局限性:

* **次优解问题:**贪心算法不能保证找到全局最优解。在某些情况下,哈夫曼算法可能会产生次优的编码方案,导致编码长度更长。

* **时间复杂度:**哈夫曼算法的时间复杂度为 O(n log n),其中 n 为符号的数量。对于大型数据集,这种复杂度可能会成为性能瓶颈。

### 4.2 改进的哈夫曼编码算法

为了克服贪心算法的局限性,提出了多种改进的哈夫曼编码算法:

**哈夫曼-卡尔彭特算法:**

该算法采用了一种分治策略,将符号集递归地划分为两个子集,并分别为每个子集构建哈夫曼树。最后,将两个子树合并为一棵完整的哈夫曼树。哈夫曼-卡尔彭特算法可以有效减少次优解的可能性,并降低时间复杂度。

**哈夫曼-布鲁克算法:**

该算法使用了一种动态规划的方法,从最小的符号开始,逐步构建哈夫曼树。在每个步骤中,算法都会选择两个最小的符号进行合并,并更新剩余符号的频率。哈夫曼-布鲁克算法的时间复杂度为 O(n),可以有效地找到最优解。

### 4.3 哈夫曼编码的并行化实现

随着计算技术的不断发展,并行计算成为提高算法效率的一种重要手段。哈夫曼编码算法也可以通过并行化来提升性能:

**并行哈夫曼树构建:**

哈夫曼树的构建过程可以并行化,通过将符号集划分为多个子集,并分别在不同的处理器上构建子树。最后,将子树合并为一棵完整的哈夫曼树。

**并行哈夫曼编码生成:**

哈夫曼编码的生成过程也可以并行化,通过将符号集划分为多个子集,并分别在不同的处理器上生成子编码。最后,将子编码合并为完整的哈夫曼编码。

通过并行化,哈夫曼编码算法可以显著提高性能,尤其是在处理大型数据集时。

# 5. 哈夫曼编码在信息论中的拓展

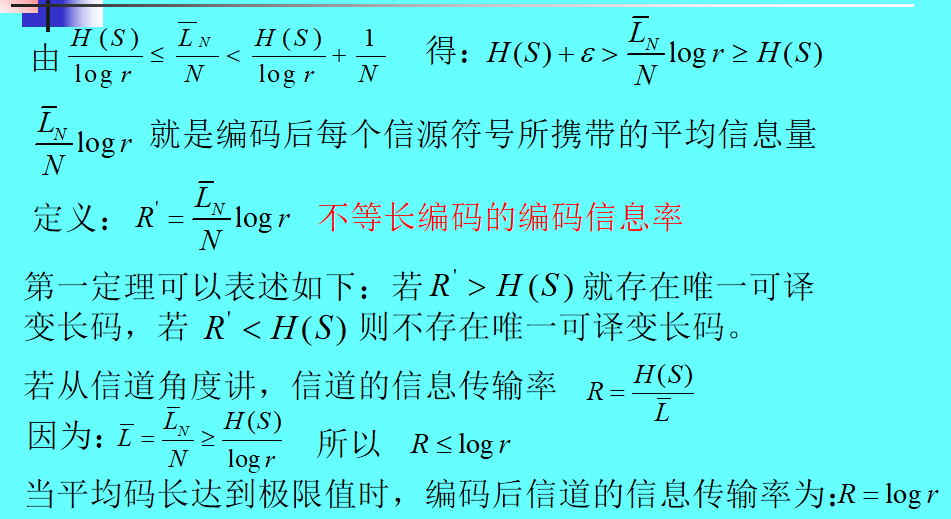

### 5.1 信源熵与编码效率

哈夫曼编码的编码效率与信源熵密切相关。信源熵衡量信源符号出现的不确定性,它决定了编码的最小平均码长。

**信源熵的计算公式:**

```

H(X) = -Σp(x) * log2(p(x))

```

其中:

* H(X) 表示信源熵

* p(x) 表示符号 x 出现的概率

哈夫曼编码的平均码长与信源熵之间存在以下关系:

```

L ≤ H(X) + 1

```

其中:

* L 表示哈夫曼编码的平均码长

### 5.2 哈夫曼编码的变体与应用

哈夫曼编码有多种变体,包括:

* **香农-法诺编码:**一种基于信源熵的编码方法,可达到与哈夫曼编码相同的效率。

* **算术编码:**一种无损数据压缩算法,可实现更高的压缩率。

* **LZW 编码:**一种基于字典的无损数据压缩算法,适用于重复性高的数据。

这些变体在不同的应用场景中具有不同的优势。例如,算术编码用于图像和音频压缩,而 LZW 编码用于文本压缩。

### 5.3 哈夫曼编码在信息安全中的应用

哈夫曼编码在信息安全中也有应用,例如:

* **数字签名:**哈夫曼编码可用于压缩数字签名,减少签名长度。

* **加密:**哈夫曼编码可用于构建基于概率的加密算法。

* **信息隐藏:**哈夫曼编码可用于将秘密信息隐藏在看似随机的数据中。

0

0