【Hadoop MapReduce性能提升】:序列化技巧全攻略

发布时间: 2024-10-27 11:44:27 阅读量: 26 订阅数: 15

# 1. MapReduce框架简介与性能问题

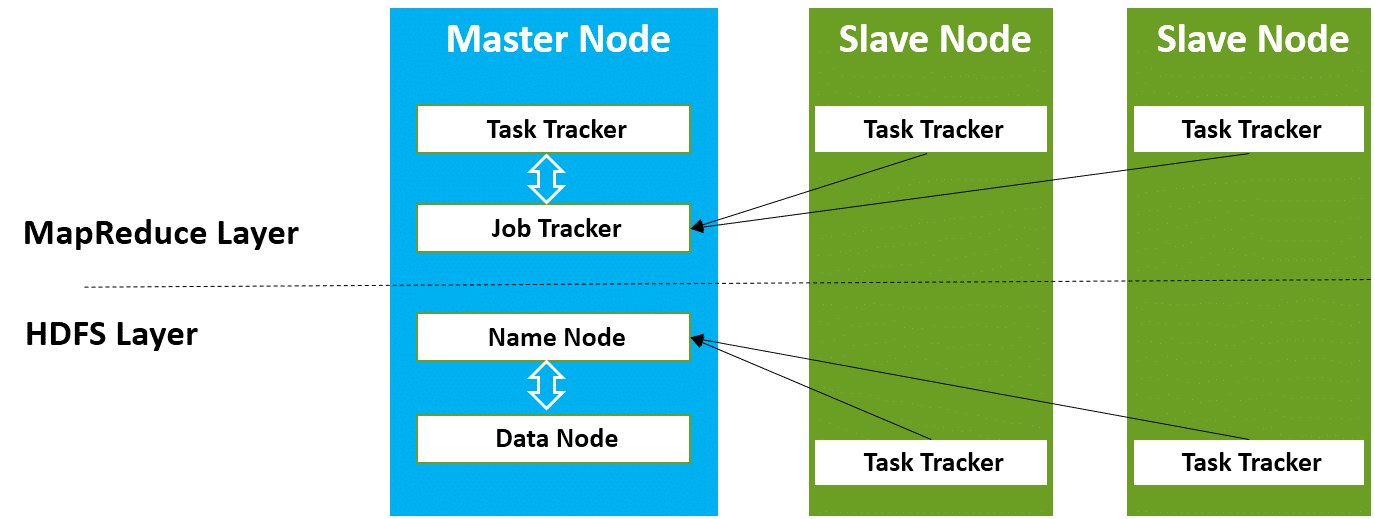

MapReduce是一种分布式计算框架,用于处理大量数据的并行运算。尽管它在大数据处理领域广受欢迎,但性能问题一直是其核心挑战之一。本章将介绍MapReduce的基本工作原理,并探讨其性能优化的必要性。

## 1.1 MapReduce的工作原理

MapReduce分为两个主要阶段:Map阶段和Reduce阶段。在Map阶段,框架将输入数据分割成独立的块,然后并行处理这些数据块。在Reduce阶段,处理结果被合并,形成最终的输出。

## 1.2 性能问题的来源

性能问题通常源自于数据的序列化与反序列化过程,以及任务的调度和执行。数据在网络中的传输,以及在节点间处理过程中的序列化和反序列化步骤,都会导致显著的性能开销。

## 1.3 MapReduce性能优化的方向

针对性能问题,优化的方向可以分为几个层面:优化数据序列化机制以减少数据大小;调整MapReduce作业的配置,以更有效地利用系统资源;以及改进编程模型和任务调度策略,来提高数据处理效率。这些方向上的改进能显著提升整体处理速度和系统吞吐量。

在后续章节中,我们将深入探讨每个方向的优化策略,并提供具体的实现案例和分析。

# 2. 深入理解序列化机制

### 2.1 序列化基础概念

#### 2.1.1 序列化与反序列化的定义

在分布式计算环境中,数据需要在网络中传输或存储在磁盘上时,原始数据对象需要被转换成一种格式,这种转换过程被称为序列化(Serialization)。相对的,将序列化后的数据转换回原始对象的过程被称为反序列化(Deserialization)。序列化和反序列化是分布式系统中不可或缺的两个过程。

序列化的作用主要体现在以下几个方面:

- 数据交换:在不同的系统或者系统组件之间传递数据时,序列化提供了统一的数据交换格式。

- 数据存储:将内存中的对象持久化存储到外部存储介质时,需要通过序列化将对象转换成存储介质可以理解的形式。

- 远程过程调用(RPC):在分布式系统中,远程对象调用其他对象的方法时,需要序列化请求和响应对象。

#### 2.1.2 序列化在MapReduce中的作用

在MapReduce框架中,序列化机制尤其关键,因为它涉及到中间数据在Map和Reduce任务之间的传输。良好的序列化机制能够减少网络传输的数据量,提高任务处理速度,从而提升整个MapReduce作业的性能。

MapReduce框架中,序列化不仅发生在Map和Reduce任务之间,还发生在Shuffle阶段,这一阶段的数据传输量极大。因此,一个高效的序列化机制能够在很大程度上减少网络带宽的使用,加快Shuffle速度,最终缩短作业的执行时间。

### 2.2 常见的序列化框架对比

#### 2.2.1 Java原生序列化机制

Java原生序列化通过实现了`java.io.Serializable`接口的对象可以使用Java序列化机制。Java序列化有以下几个特点:

- **自描述**:序列化对象包含类的元数据信息,如类名、字段名等。

- **语言特定**:由于序列化的格式是Java特定的,因此序列化的数据只能被Java虚拟机读取。

- **效率问题**:Java原生序列化的效率并不高,生成的数据量通常比较大。

```java

import java.io.Serializable;

public class Person implements Serializable {

private String name;

private int age;

// 构造函数、getter和setter省略

}

```

使用Java原生序列化时,可以通过`ObjectOutputStream`进行序列化,并通过`ObjectInputStream`进行反序列化。

#### 2.2.2 Hadoop序列化机制(Writables)

Hadoop的序列化机制是为性能优化而设计的,它不是Java原生序列化的简单替代品,而是在保持可读性的同时,提高了序列化的效率。Writables是Hadoop内部序列化的一个例子,提供了紧凑的数据表示方式。

- **紧凑数据格式**:Writables类通常比Java原生序列化的类更紧凑。

- **二进制格式**:Hadoop的序列化数据是二进制的,而不是文本格式,从而减少了数据量。

- **自定义**:可以通过实现`Writable`接口来创建自定义序列化类。

```java

import org.apache.hadoop.io.Writable;

import java.io.DataInput;

import java.io.DataOutput;

import java.io.IOException;

public class CustomWritable implements Writable {

private String name;

private int age;

@Override

public void write(DataOutput out) throws IOException {

out.writeUTF(name);

out.writeInt(age);

}

@Override

public void readFields(DataInput in) throws IOException {

name = in.readUTF();

age = in.readInt();

}

// 构造函数、getter和setter省略

}

```

#### 2.2.3 Thrift和Avro的序列化性能

Thrift和Avro是两种跨语言的序列化框架。它们的主要优点是支持多语言的序列化,并且在性能上有不错的表现。

- **跨语言支持**:支持多种编程语言,非常适用于微服务和分布式系统之间的通信。

- **紧凑的数据格式**:二进制编码能够减少序列化数据的大小。

- **模式定义**:两种框架都需要先定义数据模式(schema),然后根据该模式进行序列化和反序列化。

**Thrift示例代码**:

```thrift

namespace java com.example

struct Person {

1: required string name;

2: required i32 age;

}

```

**Avro示例代码**:

```json

{

"type": "record",

"name": "Person",

"fields": [

{"name": "name", "type": "string"},

{"name": "age", "type": "int"}

]

}

```

在比较不同序列化框架时,重要的是要了解每种框架的使用场景,以及它们在性能和适用性方面的权衡。

### 2.3 自定义序列化类的优势

#### 2.3.1 自定义序列化的必要性

自定义序列化类是解决特定序列化需求的有效手段。当使用Java原生序列化或Hadoop的Writables机制无法满足特定的性能需求或数据格式要求时,可以通过实现自定义序列化类来优化。

- **性能优化**:通过自定义序列化类,可以减少序列化数据的大小,减少网络I/O开销。

- **数据安全性**:可以对敏感数据进行加密或压缩,提高数据传输的安全性。

- **格式定制**:可以根据业务需要设计数据的序列化格式,更加灵活。

#### 2.3.2 实现自定义序列化类的步骤和技巧

实现自定义序列化类通常涉及以下步骤:

1. **定义数据类**:创建一个新的类,实现`Writable`接口。

2. **实现`write`和`readFields`方法**:这两个方法分别用于序列化和反序列化数据。

3. **测试序列化和反序列化过程**:确保数据可以被正确序列化和反序列化。

示例代码已在上述Writables的代码块中给出。需要注意的是,在实现自定义序列化类时,应当关注序列化数据的效率和安全性。效率可以通过减少序列化数据大小来实现,而安全性则可以通过加密序列化数据来保证。

通过本节的介绍,读者应理解序列化机制在MapReduce框架中的重要性,比较了常见的序列化框架,并强调了自定义序列

0

0