【Hadoop序列化优化秘籍】:提升性能与安全性的终极指南(2023年版)

发布时间: 2024-10-27 11:23:14 阅读量: 3 订阅数: 4

# 1. Hadoop序列化的基础概念

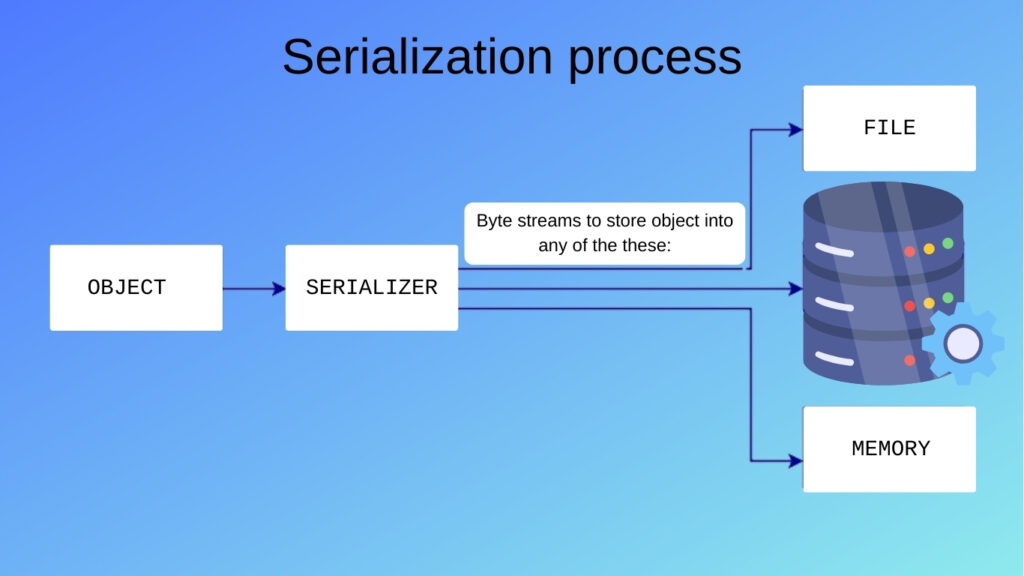

在信息技术的快速发展背景下,处理和传输数据成为了日常工作的核心。Hadoop作为大数据处理的领航者,其中的序列化机制成为了其性能和互操作性的关键要素。**Hadoop序列化**是将对象状态转换为一种适合在存储设备或网络上传输的格式的过程。本章将深入探讨序列化的基本概念、重要性以及其在Hadoop生态中的角色。

## 1.1 序列化的基本定义

在分布式计算环境中,如Hadoop平台,序列化允许复杂的数据结构(比如对象、类实例)被转换为字节流,以便在网络上传输或者在硬盘上存储。反序列化则是序列化过程的逆过程,它将字节流重构成原始数据结构。这一机制对于减少存储空间和提高网络传输效率至关重要。

## 1.2 Hadoop序列化与传统序列化的区别

Hadoop序列化与传统编程语言中使用的序列化机制(例如Java自带的序列化)有所不同。Hadoop序列化更加注重效率和性能,尤其是对于大规模数据集的操作。它倾向于使用紧凑的数据格式,并且通常会舍弃一些面向对象的特性来达到更高的压缩比和更快的序列化/反序列化速度。

为了进一步加深理解,下面是一个简单的Java类示例,并展示如何在Hadoop中进行序列化和反序列化操作:

```java

// 示例Java类

public class DataRecord implements Writable {

private int id;

private String name;

@Override

public void write(DataOutput out) throws IOException {

out.writeInt(id);

out.writeUTF(name);

}

@Override

public void readFields(DataInput in) throws IOException {

id = in.readInt();

name = in.readUTF();

}

}

```

通过以上示例代码块,我们了解到Hadoop中的`Writable`接口是实现自定义序列化的核心。`write()`方法负责将对象状态写入输出流,而`readFields()`方法则从输入流中恢复对象状态。这种机制极大地提升了数据传输的效率和存储的密度,是大数据应用中不可或缺的技术基础。在后续章节中,我们将深入分析Hadoop序列化机制的内部原理及其优化策略。

# 2. Hadoop序列化机制的内部原理

### 2.1 Hadoop序列化机制概述

Hadoop序列化机制是指在Hadoop分布式计算框架中,对数据进行编码以便在网络上进行传输,或者存储到磁盘上的一种机制。它不同于Java的序列化,主要目标是高效压缩和快速传输。序列化和反序列化(也称为编组和解组)在数据的读写过程中至关重要,因为它们涉及将对象转换为字节流和从字节流中重构对象。

在Hadoop中,数据通过MapReduce框架进行处理,其中节点间的通信以及节点与存储设备间的数据交换都需要序列化机制。效率低下或设计不当的序列化将严重影响整个系统的性能。因此,了解序列化的内部原理,对于优化Hadoop集群的性能和存储效率至关重要。

### 2.2 序列化与反序列化过程

在Hadoop中,序列化过程主要包括以下几个步骤:

1. **对象序列化**:将Java对象转换为字节流。这个过程涉及到对象的状态、数据类型以及数据结构等信息的编码。

2. **数据传输**:编码后的字节流在网络上传输。这个过程中会使用TCP/IP协议进行数据的封装与解封装。

3. **反序列化**:在接收端,字节流被重新构造为对象的过程称为反序列化。这涉及到字节流中信息的解码和对象的重建。

下面的伪代码展示了序列化和反序列化过程的基本逻辑:

```java

// 序列化过程

public static byte[] serialize(Object obj) {

ByteArrayOutputStream bos = new ByteArrayOutputStream();

ObjectOutputStream oos = new ObjectOutputStream(bos);

oos.writeObject(obj);

return bos.toByteArray();

}

// 反序列化过程

public static Object deserialize(byte[] bytes) {

ByteArrayInputStream bis = new ByteArrayInputStream(bytes);

ObjectInputStream ois = new ObjectInputStream(bis);

return ois.readObject();

}

```

在上述代码中,`ObjectOutputStream` 和 `ObjectInputStream` 是Java提供的序列化和反序列化工具类。虽然这些类可以用于Hadoop,但由于其开销较大,Hadoop通常使用更高效的序列化机制,例如Writables或自定义序列化接口。

### 2.3 Writable类及其扩展

为了优化性能,Hadoop引入了Writable接口。实现Writable接口的类可以被Hadoop序列化机制高效处理。Hadoop自带了多种Writable实现,如LongWritable、Text等,它们针对特定数据类型进行了优化。

下面是自定义Writable类的简单例子:

```java

import org.apache.hadoop.io.Writable;

import java.io.DataInput;

import java.io.DataOutput;

import java.io.IOException;

public class CustomWritable implements Writable {

private int number;

private String text;

public CustomWritable() {

}

public CustomWritable(int number, String text) {

this.number = number;

this.text = text;

}

@Override

public void write(DataOutput out) throws IOException {

out.writeInt(number);

out.writeUTF(text);

}

@Override

public void readFields(DataInput in) throws IOException {

number = in.readInt();

text = in.readUTF();

}

// Getters and Setters

}

```

自定义Writable类必须实现`write()`和`readFields()`方法,这些方法分别用于序列化和反序列化。通过实现Writable接口,开发者可以创建适用于特定场景的序列化类,以提高性能和减少存储开销。

### 2.4 序列化机制的性能考量

在Hadoop中,序列化机制的性能考量包括:

- **序列化和反序列化的速度**:处理大量数据时,需要快速编码和解码。

- **数据传输的大小**:网络传输的数据量越小,传输速度就越快,同时对带宽的要求也更低。

- **CPU使用率**:序列化和反序列化过程应当尽量少占用CPU资源,避免成为系统瓶颈。

- **内存占用**:应避免序列化过程创建大量临时对象导致的内存占用增加。

为了满足上述性能考量,Hadoop序列化机制进行了多方面的优化。例如:

- **紧凑的数据表示**:Hadoop通过使用紧凑的数据表示来减少数据的序列化大小。

- **自定义序列化协议**:Hadoop提供了一种灵活的自定义协议来满足不同数据类型的需求。

- **高效的序列化框架**:通过使用Avro、Thrift或Protocol Buffers等序列化框架,Hadoop在保证效率的同时,提供了更好的跨语言支持。

了解这些序列化机制的基本原理和实现方式,有助于我们深入理解如何在Hadoop上进行性能优化和安全加固。接下来的章节将探讨如何选择合适的序列化框架以及如何进行性能优化。

# 3. 提升Hadoop序列化性能的策略

在本章节中,我们将深入探讨如何通过一系列策略提升Hadoop序列化的性能。我们会从选择合适的序列化框架开始,逐步深入到序列化过程中的性能优化技巧,以及在分布式环境下的优化方法。这些内容旨在为已经具备一定Hadoop基础的IT从业者提供更高级的序列化优化思路。

## 选择合适的序列化框架

### 序列化框架对比分析

在Hadoop生态系统中,存在多种序列化框架,例如Avro、Thrift、Protocol Buffers等,每种框架都有其独特的优势和适用场景。以下是对这些框架的对比分析。

首先,Avro作为一种轻量级的远程过程调用和序列化框架,特别适合用于大规模数据交换,它支持动态类型语言和静态类型语言。其优势在于数据文件可以通过模式(Schema)进行读取,支持多语言,并且有较好的压缩效果。

接着,Thrift是Facebook开发的跨语言服务开发框架,它能够用于定义和创建跨语言的RPC服务。Thrift适合在分布式系统中用于服务之间的通信,支持多种编程语言,具有良好的可扩展性和高效性能。

最后,Protocol Buffers是Google开发的一种数据描述语言,用于序列化结构化数据,类似于XML或JSON,但它更小、更快、更简单。它在Google内部广泛使用,其优势在于高度的压缩和快速的序列化速度。

### 选择序列化框架的实践指南

在实际应用中,选择合适的序列化框架需要考虑以下几个关键因素:

1. **性能要求**:如果应用场景对数据序列化的速度和压缩比例有极高的要求,则应倾向于选择Protocol Buffers。反之,如果对多语言支持和易用性有更高的需求,则Avro可能是个不错的选择。

2. **数据的使用频率和大小**:对于频繁传输的小数据,Thrift可能是最佳选择,因为其在远程过程调用(RPC)方面有非常好的性能。对于大数据交换,Avro的动态模式演化能力能更好地应对需求变化。

3. **生态系统和社区支持**:考虑框架的流行度和社区的活跃程度,也是一项不可忽视的因素。一个活跃的社区意味着更好的文档支持、更丰富的工具生态和更快的问题解决速度。

4. **易用性和学习曲线**:根据团队的技能水平和经验,选择一个容易上手、学习曲线平滑的框架可以加快开发进程。

## 序列化过程中的性能优化技巧

### 数据压缩技术的应用

在数据传输和存储时采用压缩技术可以有效地减少所需带宽和存储空间,这对于大规模的Hadoop环境尤为重要。压缩技术不仅可以提升序列化速度,还能显著减少存储成本。

目前,常见的压缩算法有Snappy、LZ4和GZip等。Snappy和LZ4压缩速度快,适合需要快速读写的场景;而GZip则在压缩比上更占优势,适合存储和网络传输较少但对压缩率要求较高的应用。

### 缓冲技术和批量处理

在执行序列化操作时,合理利用缓冲技术和批量处理也是提升性能的有效手段。缓冲技术通过在内存中累积数据,减少了频繁的I/O操作,从而优化了I/O瓶颈问题。而批量处理则能够减少对资源的占用,并减少序列化和反序列化的开销。

在Hadoop中,可以使用如`DataOutputStream`和`DataInputStream`等带有缓冲的I/O流类。通过配置合适的缓冲大小,可以在内存中对数据进行高效的处理和传输。

## 分布式环境中序列化的优化

### 分布式缓存的作用与优化

在Hadoop MapReduce作业中,分布式缓存用于向数据节点分发依赖的文件,如jar包、本地库、配置文件等。在序列化过程中,合理使用分布式缓存,可以加快数据的序列化和反序列化速度。

优化分布式缓存的关键在于确保缓存文件的大小适中,避免过于庞大的文件导致缓存速度降低,同时要保证缓存文件的更新频率,避免因为缓存过时导致错误。

### 网络传输中的序列化效率

在分布式系统中,网络传输往往是性能瓶颈之一。为了优化序列化效率,可以采取以下措施:

1. **使用更高效的序列化框架**:选择适合分布式环境的序列化框架,如Protocol Buffers,它在传输效率上有着优异的表现。

2. **数据分区和负载均衡**:合理分配任务和数据分区,避免某些节点过载导致网络拥塞。

3. **减少网络往返次数**:通过批量处理和压缩技术,减少数据在网络中的往返次数,提升整体的网络传输效率。

通过上述策略的综合运用,可以在不同的层面优化Hadoop的序列化性能,从而显著提升整个大数据处理系统的效率。在下一章节中,我们将继续深入探讨Hadoop序列化的安全性提升。

# 4. Hadoop序列化的安全性提升

在大数据时代,数据的安全性已经成为人们最为关注的问题之一。Hadoop作为一个大数据处理平台,在处理大量的数据时,其安全性更显重要。本章节将深入探讨Hadoop序列化的安全性问题,并给出相应的提升措施。

## 4.1 序列化数据的安全性威胁

### 4.1.1 数据传输中的安全隐患

数据在传输过程中,如果未进行有效的加密处理,容易被恶意截获和篡改。Hadoop在数据传输过程中使用了RPC(远程过程调用)通信,如果传输过程中数据被截获,那么敏感信息就有可能泄露。

### 4.1.2 数据存储的安全隐患

在数据存储过程中,未经授权的用户可能会访问或修改存储的数据。Hadoop集群的NameNode和DataNode上存储了大量的数据信息,如果不采取措施,数据可能会面临被非法读取或修改的风险。

## 4.2 提升序列化数据安全性的措施

### 4.2.1 引入加密机制

为确保数据在传输和存储过程中的安全性,最直接有效的方式就是引入加密机制。Hadoop可以通过集成第三方的加密库来实现这一目的。比如,使用AES加密算法对数据进行加密,在数据传输和存储时都可以大大提升数据安全性。

### 4.2.2 序列化数据的访问控制

除了加密机制外,还需要有完善的访问控制策略来限制用户对数据的访问。Hadoop可以集成Kerberos认证机制,对用户的身份进行验证,并进行细粒度的访问控制。

## 4.3 安全机制的集成与实践

### 4.3.1 集成现有安全框架

Hadoop社区已经提供了多种安全解决方案,例如Hadoop的Kerberos认证和Apache Ranger等。在实践中,我们可以选择适合的方案集成到Hadoop集群中,以提高安全性。

### 4.3.2 实践中的安全最佳实践

安全最佳实践的遵循,对提升Hadoop集群安全性同样至关重要。例如,定期更新集群的安全补丁,使用HDFS的审计日志跟踪非法访问尝试,以及定期进行安全培训,强化员工的安全意识。

### 4.3.3 安全配置的代码示例

下面是一段代码示例,展示了如何在Hadoop集群中配置Kerberos认证:

```bash

# 编辑Hadoop的配置文件hadoop-site.xml,启用Kerberos认证

<configuration>

<property>

<name>hadoop.security.authentication</name>

<value>kerberos</value>

</property>

<!-- 其他安全配置 -->

</configuration>

# 使用kinit获取和缓存Kerberos Ticket

kinit -kt [principal].keytab [username]

# 启动Hadoop集群

start-dfs.sh

start-yarn.sh

```

在上述配置中,`hadoop.security.authentication`属性被设置为`kerberos`,意味着Hadoop会使用Kerberos机制进行用户认证。通过`kinit`命令获取的Ticket缓存用于在集群间进行认证。

通过以上措施,我们可以大幅度提升Hadoop序列化数据的安全性,减少数据泄露的风险。本章节所介绍的内容构成了Hadoop序列化安全性提升的基础框架,既包括了理论层面的分析,也提供了实践中的具体操作方法。在后续章节中,我们将继续探讨Hadoop序列化在大数据处理中的高级应用案例。

# 5. Hadoop序列化的高级应用案例

在Hadoop的世界中,序列化不仅仅是一个编程细节,它是一个强大的工具,能够影响整个系统的设计和性能。在本章中,我们将探讨高级序列化框架的使用,它们在大数据处理中的创新应用,以及企业级案例研究来分析如何优化性能和安全性。

## 5.1 高级序列化框架应用

### 5.1.1 Avro、Thrift和Protocol Buffers的对比

在Hadoop生态系统中,有多个序列化框架可供选择,其中最著名的包括Avro, Thrift和Protocol Buffers。每个框架都有其特定的优势和适用场景。

- **Avro** 是一个远程过程调用和数据序列化的框架,它支持动态类型语言和静态类型语言。Avro的一个优势在于它能够处理未标记的数据模式,这让它在数据版本之间具有较好的兼容性。

- **Thrift** 是一个由Facebook开发的框架,它提供了跨语言服务开发的平台。Thrift的主要特点是它能够定义数据类型和服务接口,从而允许开发者创建能够在多种编程语言之间共享的服务。

- **Protocol Buffers** 是Google开发的一种数据序列化格式,它比XML和JSON等文本格式更小、更快和更简单。Protocol Buffers 的数据格式是二进制的,这使得它在序列化过程中更快,但在可读性上不如文本格式。

在选择框架时,需要根据项目的具体需求来定。例如,如果需要高度的跨语言支持,Thrift可能是一个不错的选择。如果优先考虑数据的紧凑性和高效性,Protocol Buffers可能更适合。

### 5.1.2 框架选择与应用实例

选择合适的序列化框架不仅涉及理论知识,更需要实际的应用实践。假设我们有一个需要存储和处理用户数据的应用场景,我们可以分别使用Avro, Thrift和Protocol Buffers实现。

以Protocol Buffers为例,首先需要定义数据结构的`.proto`文件:

```protobuf

syntax = "proto3";

message User {

string name = 1;

int32 age = 2;

string email = 3;

}

```

然后使用protoc编译器生成不同语言的序列化代码。接着,就可以在程序中使用生成的代码来序列化和反序列化User对象了。

```java

User user = User.newBuilder()

.setName("Alice")

.setAge(30)

.setEmail("***")

.build();

byte[] data = user.toByteArray(); // 序列化

User newUser = User.parseFrom(data); // 反序列化

```

通过使用Protocol Buffers,数据在传输和存储中能够保持较小的体积,同时编码和解码操作速度也较快,这对于大数据场景尤为关键。

## 5.2 序列化在大数据处理中的创新应用

### 5.2.1 实时数据处理的序列化策略

在实时数据处理中,如何快速进行数据序列化和反序列化非常关键。实时数据流处理框架(如Apache Storm或Apache Flink)要求序列化框架能够提供低延迟和高吞吐量的序列化能力。

- 在这样的场景下,选择像Google的FlatBuffers这样的框架可能更为合适,它在保持高效内存访问的同时,提供了快速的序列化和反序列化功能。

- 另一个选择是使用压缩算法来减少网络传输的数据量,例如使用Snappy压缩库对Protocol Buffers序列化后的数据进行压缩。

### 5.2.2 大数据存储与序列化

大数据存储时,序列化的性能和效率同样重要。为了提高存储效率,可以在存储前对数据进行压缩,同时选择支持列式存储的序列化格式,比如Parquet或Avro。

使用Parquet格式存储数据时,可以有效利用其对复杂数据模式的支持,同时对于数据分析型的存储需求,可以利用其高效的列式存储特性减少读写过程中的IO操作。

## 5.3 案例研究:企业级Hadoop序列化优化实践

### 5.3.1 优化前的性能与安全评估

在实施优化前,企业需要对现有系统进行性能和安全性的全面评估。比如,通过分析数据传输日志,可以识别出序列化过程中的瓶颈,并进行针对性优化。

在安全性评估方面,需要分析现有的数据加密机制和访问控制策略是否满足企业需求。如果发现存在安全漏洞,需要在序列化过程中加入必要的安全控制措施。

### 5.3.2 优化后的效益分析

优化实施之后,需要进行效益分析来衡量优化措施带来的实际效果。

- 通过性能基准测试,可以观察到优化后的系统在序列化和反序列化操作上的性能提升。

- 安全性方面,通过模拟攻击和安全审计来验证加入的安全措施是否有效。

最终,企业将能够实现系统的性能优化与安全加固,并且在未来的数据处理中更加高效和安全。

0

0