重塑数据的秘密武器:reshape2包实践案例分析

发布时间: 2024-11-02 21:45:52 阅读量: 55 订阅数: 38

reshape:R包可灵活地重新排列,重塑和聚合数据

# 1. 数据重塑的基础概念

数据重塑是数据分析和处理过程中的一个基本技能,它涉及到将数据集从一种格式转换成另外一种格式,从而方便数据的展示、分析和挖掘。在不同的数据处理场景中,数据可能需要从宽格式(宽表)转换为长格式(长表),反之亦然。这种转换通常涉及改变数据的行和列,调整数据的结构以适应特定的分析需求。

在处理数据时,我们经常需要将多个数据集合并,或者对数据集进行拆分。数据重塑允许我们通过增加、删除或重排数据集中的行和列来达到这些目的。它还包括处理不同数据类型,比如日期、时间和分类数据,这些都可能在分析前需要转换或处理。

例如,假设我们有一个包含销售数据的宽格式数据集,我们可能需要将它转换为长格式以进行时间序列分析。另外,有时我们可能需要对数据进行分组和聚合以进行统计分析。理解并掌握这些基本概念,是深入学习和应用reshape2包等数据重塑工具的前提。

下面,我们将深入了解如何安装和使用reshape2包,并通过实例展示如何利用它进行数据重塑的实践。

# 2. reshape2包的安装和基本使用

## 2.1 安装reshape2包

### 2.1.1 通过CRAN安装

在R语言中,安装包的首选方式是通过CRAN(Comprehensive R Archive Network),这是一个由全球R社区维护的最大的R软件仓库。为了安装`reshape2`包,用户可以使用以下命令:

```R

install.packages("reshape2")

```

在执行该命令后,R会自动从CRAN下载`reshape2`包并安装到用户的R环境中。对于大多数操作系统,这个过程是自动的,并且R会处理所有必要的依赖关系。如果在安装过程中遇到任何错误,通常是因为网络连接问题或者是CRAN镜像选择不当。

安装完成后,用户可以通过`library`函数加载`reshape2`包,并开始使用其功能:

```R

library(reshape2)

```

### 2.1.2 通过GitHub安装

对于希望使用最新开发版本的用户,可以从GitHub仓库安装`reshape2`包。这通常意味着用户会得到最新的功能和错误修正,但相应的也可能会遇到不稳定的代码和不完整的文档。安装GitHub上的R包通常需要两个步骤:安装`devtools`包和使用`devtools`提供的`install_github`函数。

首先安装`devtools`包:

```R

install.packages("devtools")

```

安装好`devtools`后,就可以通过以下命令安装`reshape2`:

```R

devtools::install_github("hadley/reshape")

```

这里需要注意的是,`reshape`是`reshape2`的旧版本,但这里依旧可以用来示例。如果`reshape2`在GitHub上有更新的版本,需要将`reshape`替换为对应的GitHub仓库地址。安装完成后,同样使用`library`函数加载包:

```R

library(reshape2)

```

## 2.2 reshape2包的核心功能

### 2.2.1 melt函数的介绍和用法

`melt`函数是`reshape2`包的核心函数之一,它的主要作用是将数据框(data frame)从宽格式(wide format)转换为长格式(long format)。这种转换在数据处理和分析中非常常见,尤其是在需要对数据进行重塑以便于统计分析时。

例如,考虑一个宽格式的数据框,其中每一列代表一个变量,而每行代表一个观测值。通过`melt`函数,我们可以将该数据框转换为长格式,其中一列存储变量名,另一列存储对应的值,第三列则记录每个观测值的标识(如果有的话)。

使用`melt`的基本语法如下:

```R

melt(data, id.vars, measure.vars, ..., na.rm = FALSE, value.name = "value")

```

- `data` 是待转换的数据框。

- `id.vars` 是标识变量,表示在转换过程中保持不变的列。

- `measure.vars` 是度量变量,表示需要被转换的列。

- `na.rm` 参数用于指定是否移除`NA`值。

- `value.name` 用于指定输出数据框中值列的名称。

下面是一个使用`melt`函数的简单例子:

```R

# 创建一个简单的数据框

df <- data.frame(

time = rep(c(1, 2, 3), each = 4),

var1 = c(1, 2, 3, 4),

var2 = c(5, 6, 7, 8),

var3 = c(9, 10, 11, 12)

)

# 使用melt函数转换数据框

melted_df <- melt(df, id.vars = "time")

```

在这个例子中,`time`变量被指定为`id.vars`,因为它是不变的标识列,而`var1`、`var2`和`var3`则被转换为长格式。

### 2.2.2 dcast函数的介绍和用法

与`melt`相反,`dcast`函数的功能是从长格式数据转换为宽格式。这在将处理后的数据整理成适合特定分析形式时非常有用。

`dcast`的基本语法为:

```R

dcast(data, formula, fun.aggregate = NULL, ..., value.var = "value")

```

- `data` 是原始数据框。

- `formula` 是一个公式,指示如何将长格式数据拆分并重塑成宽格式。

- `fun.aggregate` 是一个函数,用于在转换过程中对数据进行聚合。

- `value.var` 是一个字符串,指定需要转换的值变量。

这里是一个使用`dcast`函数将数据框转换为宽格式的例子:

```R

# 创建长格式数据框

long_df <- data.frame(

time = c(1, 1, 2, 2),

item = c("A", "B", "A", "B"),

value = c(10, 20, 30, 40)

)

# 使用dcast函数转换为宽格式

wide_df <- dcast(long_df, time ~ item)

```

在这个例子中,`time`变量作为行标识,`item`变量的值被用来生成新的列头,从而将数据从长格式转换为宽格式。

## 2.3 基本数据重塑操作实例

### 2.3.1 单变量数据重塑

单变量数据重塑是指只涉及一个变量的数据转换操作。通常,这种转换是将数据从宽格式转换为长格式,以便于进行时间序列分析、函数绘图等。

这里以一个简单的单变量数据框作为例子:

```R

# 单变量数据框

single_var_df <- data.frame(

year = 2010:2015,

sales = c(100, 200, 150, 250, 300, 400)

)

```

要使用`reshape2`包将这个数据框转换为长格式,我们可以这样做:

```R

# 将单变量数据框转换为长格式

long_format <- melt(single_var_df, id.vars = "year")

```

在这个例子中,我们使用`melt`函数将`sales`列转换为值列,而`year`列作为`id.vars`保持不变。

### 2.3.2 多变量数据重塑

多变量数据重塑比单变量数据重塑复杂,涉及多个度量变量。这种转换通常用于数据集中的多个度量变量需要被整合成一种格式进行分析的情况。

以以下多变量数据框为例:

```R

# 多变量数据框

multi_var_df <- data.frame(

id = 1:4,

year1 = c(100, 200, 300, 400),

year2 = c(150, 250, 350, 450),

year3 = c(200, 300, 400, 500)

)

```

我们希望将这个数据框转换成一个每个年份对应一个列的格式。这可以通过`melt`和`dcast`组合来实现:

```R

# 使用melt函数将数据框转换为长格式

long_multi_var <- melt(multi_var_df, id.vars = "id")

# 使用dcast函数将数据框转换为宽格式

wide_multi_var <- dcast(long_multi_var, id ~ variable)

```

在这个过程中,`melt`函数首先将`multi_var_df`转换为长格式,然后`dcast`函数将其重塑为宽格式,每个年份都是一个单独的列。在使用`dcast`时,`id ~ variable`的公式指明了转换的方向和方式。

# 3. reshape2包高级数据处理技巧

在深入掌握reshape2包的基本功能和数据重塑操作之后,我们接下来将探索一些高级数据处理技巧。这些技巧将进一步提升我们的数据处理能力,让数据操作变得更加灵活和高效。

## 3.1 数据的分组聚合

### 3.1.1 使用dcast进行数据分组

数据分组聚合是数据分析中的常见需求,dcast函数可以很好地实现这一需求。它允许我们按照一个或多个分组变量将数据集分解成子集,并对每个子集进行聚合操作。

```R

# 示例代码

library(reshape2)

df <- data.frame(

Country = c("USA", "USA", "France", "France"),

Year = c(2010, 2011, 2010, 2011),

Value = c(2000, 3000, 1500, 1800)

)

df_wide <- dcast(df, Country ~ Year, value.var = "Value")

df_wide

```

逻辑分析:

1. 首先,我们加载了reshape2包,以便使用dcast函数。

2. 之后,创建了一个数据框`df`,它包含国家、年份和对应的值。

3. dcast函数使用公式`Country ~ Year`指定了行标识(Country)和列标识(Year)。

4. `value.var`参数指定了需要进行聚合的列,即“Value”列。

5. 执行该代码块后,我们得到了一个宽格式的数据框`df_wide`,其中每个国家对应一行,每一年份对应一个列。

### 3.1.2 使用melt进行数据聚合

与dcast函数相对的是melt函数,它将宽格式数据框转置成长格式,适合进行不同级别的聚合操作。

```R

# 示例代码

df_melted <- melt(df_wide, id.vars = "Country", measure.vars = c("2010", "2011"))

df_melted

```

逻辑分析:

1. `melt`函数接收`df_wide`作为输入,准备将其转换为长格式。

2. `id.vars`参数指定了在转换过程中保持不变的列,在这里是“Country”列。

3. `measure.vars`参数指定了需要被合并的列名列表,这里是2010年和2011年的数据列。

4. 执行代码后,我们得到了一个长格式的数据框`df_melted`,其中包含国家、年份和值三个变量。

## 3.2 特殊数据类型处理

### 3.2.1 处理日期和时间数据

在处理数据集时,经常遇到日期和时间数据。reshape2包中没有直接处理日期和时间的函数,但我们可以使用基础R或额外的包(如lubridate)来处理这些数据类型。

```R

# 示例代码

library(lubridate)

df$Date <- dmy(paste(df$Year, 1, 1)) # 将年份转换为日期

df

```

逻辑分析:

1. 首先,我们加载了lubridate包,该包提供了方便的日期和时间解析功能。

2. `paste`函数被用来创建一个格式为“年月日”的字符串。

3. `dmy`函数将这个字符串转换为日期对象。

4. 最后,我们得到了一个扩展的数据框`df`,其中包含了日期信息。

### 3.2.2 处理因子类型数据

因子是R中用来表示分类数据的数据类型。在使用reshape2进行数据重塑时,可能会需要转换因子变量,确保数据的准确性。

```R

# 示例代码

df$Country <- as.factor(df$Country) # 将国家变量转换为因子类型

df

```

逻辑分析:

1. 在处理数据前,使用`as.factor`函数将国家名称转换为因子类型,这有助于数据的后续处理和分析。

2. 此转换确保在使用reshape2函数时,因子类型的变量能正确地处理。

## 3.3 错误处理和数据清洗

### 3.3.1 处理缺失值和异常值

处理数据中的缺失值和异常值是数据清洗的一个重要环节。在使用reshape2进行数据重塑前,需要先清理这些数据问题。

```R

# 示例代码

df[is.na(df)] <- median(df, na.rm = TRUE) # 用中位数替换缺失值

df <- df[abs(df$Value - median(df$Value)) <= 3 * mad(df$Value), ] # 用MAD方法处理异常值

df

```

逻辑分析:

1. 首先,我们用中位数替换df数据框中的所有缺失值。

2. 然后,使用MAD方法(中位数绝对偏差)识别和处理异常值。

3. 这确保了在进行数据重塑之前,数据集的质量已经得到了提升。

### 3.3.2 数据合并与转换技巧

在某些情况下,我们需要将来自不同来源的数据集合并,然后进行重塑。这可以通过基础R函数或reshape2包中的函数来完成。

```R

# 示例代码

df2 <- data.frame(

Country = c("USA", "France", "Germany"),

Value2012 = c(3500, 2000, 2500)

)

df_combined <- merge(df, df2, by = "Country") # 按国家合并数据框

df_combined_wide <- dcast(df_combined, Country ~ Year, value.var = c("Value", "Value2012"))

df_combined_wide

```

逻辑分析:

1. 创建了一个新的数据框`df2`,它包含额外的国家和2012年的数据。

2. 使用`merge`函数将`df`和`df2`按照“Country”列合并成`df_combined`。

3. 最后,使用`dcast`函数将合并后的数据框转换成宽格式,包括了所有年份的数据。

通过这些高级技巧,我们可以更加深入地理解和应用reshape2包进行数据处理。随着数据集复杂度的增加,掌握这些高级技术对于数据分析师来说是必不可少的。接下来的章节将深入分析reshape2包的实践案例,并探索其在R生态系统中的未来和替代方案。

# 4. reshape2包的实践案例分析

## 4.1 行列转换的实际应用

### 4.1.1 统计数据的行列转换

在处理统计数据时,行列转换是一个常见需求,尤其是当我们希望以更直观的方式来展示数据时。使用reshape2包中的`dcast()`函数,可以轻松实现这样的转换。例如,我们有一个关于投票数据的数据框(data frame),它包含了不同的投票区、候选人以及对应的票数。我们需要将这个数据框从长格式转换为宽格式,以便每个投票区的候选人得票数都在一个单独的列中显示。

#### 示例代码:

```r

# 载入reshape2包

library(reshape2)

# 假设有一个名为vote_data的数据框,包含投票区(District)、候选人(Candidate)和票数(Votes)

vote_data <- data.frame(

District = c("A", "A", "B", "B"),

Candidate = c("Alice", "Bob", "Alice", "Bob"),

Votes = c(450, 300, 550, 250)

)

# 使用dcast函数将数据从长格式转换为宽格式

wide_vote_data <- dcast(vote_data, District ~ Candidate, value.var = "Votes")

# 查看转换后的数据框

print(wide_vote_data)

```

#### 执行逻辑说明:

在上述代码中,`dcast()`函数接受三个参数:第一个是原始数据框`vote_data`,第二个参数`District ~ Candidate`定义了数据框中的行和列变量,最后`value.var`指定了用于填充表格值的列,即`Votes`。该函数将`District`作为行变量,`Candidate`作为列变量,将每个`Candidate`在每个`District`的`Votes`值填充到相应的位置。

#### 参数说明:

- `District ~ Candidate`:这个公式指定了行和列的变量。在这个例子中,`~`左边的是行变量,右边的是列变量。

- `value.var`:这个参数指定了用于填充新数据框中单元格值的原始数据框的列名。

### 4.1.2 时间序列数据的重塑

时间序列数据的重塑通常涉及将数据从长格式变为宽格式,以使每个时间点的数据都可在单独的列中查看。这种转换对于数据分析和可视化尤为重要,因为它允许我们更容易地对时间序列数据进行比较和分析。

#### 示例代码:

```r

# 假设有一个名为time_series_data的数据框,包含时间(Date)、变量(Variable)和值(Value)

time_series_data <- data.frame(

Date = as.Date(c("2021-01-01", "2021-01-01", "2021-02-01", "2021-02-01")),

Variable = c("Temperature", "Precipitation", "Temperature", "Precipitation"),

Value = c(21, 0.5, 23, 0.3)

)

# 使用dcast函数将时间序列数据从长格式转换为宽格式

wide_time_series <- dcast(time_series_data, Date ~ Variable, value.var = "Value")

# 查看转换后的数据框

print(wide_time_series)

```

#### 执行逻辑说明:

此代码示例展示了如何使用`dcast()`函数将包含时间序列信息的数据框转换为宽格式。在这个例子中,我们定义了时间`Date`作为行变量,而不同的变量(如温度和降水)则转换为列。`Value`列的值被用来填充新数据框的相应单元格。

#### 参数说明:

- `Date ~ Variable`:与上一个例子类似,我们指定了`Date`作为行变量,`Variable`作为列变量。

- `value.var`:继续使用`Value`作为需要填充的值。

## 4.2 数据重塑在复杂数据集中的应用

### 4.2.1 大数据集的处理策略

大数据集的处理需要特别的策略,因为大规模的数据会导致性能下降和内存溢出问题。在数据重塑的上下文中,我们可以采取几种策略来应对大数据集的挑战。

#### 示例代码:

```r

# 假设有一个名为large_data的大数据框,包含千万级别的行数

# 这里我们使用data.table来模拟大数据框

library(data.table)

set.seed(123)

large_data <- data.table(

id = sample(1:1000000, 1000000, replace = TRUE),

category = sample(c("A", "B", "C"), 1000000, replace = TRUE),

value = rnorm(1000000)

)

```

#### 大数据处理策略:

1. **使用data.table包**:data.table是R中用于处理大型数据集的流行包,它提供了比传统data frame更高效的内存使用和处理速度。

2. **分块处理**:将大型数据框分成更小的块,并对每个块分别进行处理,然后再将它们合并起来。

3. **并行计算**:利用R的并行计算能力,例如使用parallel包或者Rcpp包,可以在多个CPU核心上同时进行计算,显著提高性能。

### 4.2.2 多源数据的整合与重塑

整合来自不同源的数据集是数据处理中的一个重要环节。为了有效地整合和重塑这些数据,我们需要确保数据对齐,并使用合适的合并和转换方法。

#### 示例代码:

```r

# 假设我们有来自不同源的两个数据框:df1和df2

df1 <- data.frame(

id = c(1, 2, 3),

category = c("A", "B", "C"),

value1 = c(10, 20, 30)

)

df2 <- data.frame(

id = c(1, 2, 4),

category = c("A", "B", "D"),

value2 = c(100, 200, 400)

)

# 使用merge函数整合两个数据框

merged_data <- merge(df1, df2, by = c("id", "category"), all = TRUE)

# 使用reshape2进行数据重塑

reshaped_data <- dcast(merged_data, id ~ category, value.var = c("value1", "value2"))

```

#### 执行逻辑说明:

在上述代码中,`merge()`函数用于整合两个数据框。`by`参数指定了用于连接的共同列,而`all = TRUE`确保了执行全外连接(full outer join),即使某些id在其中一个数据框中没有对应的数据也可以。之后,`dcast()`函数用于将整合后的数据框重塑为宽格式。

#### 参数说明:

- `by = c("id", "category")`:`merge()`函数中的参数指定了两个数据框用于连接的共同列。

- `all = TRUE`:确保即使某些id在两个数据框中不匹配也能包含在最终数据框中。

- `value.var = c("value1", "value2")`:在`dcast()`函数中,指定了将用于填充新数据框中不同列的原始数据框中的多个列名。

## 4.3 与其他R包结合使用

### 4.3.1 ggplot2包的结合使用

ggplot2是R中用于数据可视化的一个强大包,与reshape2结合使用,可以实现复杂数据的优雅可视化。

#### 示例代码:

```r

# 载入ggplot2包

library(ggplot2)

# 假设我们有使用reshape2重塑好的数据框wide_vote_data

# 使用ggplot2绘制柱状图

ggplot(wide_vote_data, aes(x = District)) +

geom_bar(aes(y = Alice, fill = "Alice"), stat = "identity", alpha = 0.7) +

geom_bar(aes(y = Bob, fill = "Bob"), stat = "identity", alpha = 0.7) +

labs(title = "Election Results by District",

x = "District", y = "Votes",

fill = "Candidate")

```

#### 执行逻辑说明:

上述代码使用ggplot2绘制了一个柱状图,展示了两个候选人在不同投票区的得票情况。`aes()`函数用于指定x轴和y轴的变量以及柱状图的颜色填充。`geom_bar()`函数用于创建柱状图,`stat = "identity"`告诉ggplot2使用提供的数据作为柱子的高度。

### 4.3.2 dplyr包的结合使用

dplyr是R中用于数据操作的另一个流行包,它提供了流畅的API来处理数据框。

#### 示例代码:

```r

# 载入dplyr包

library(dplyr)

# 假设我们有数据框vote_data

# 使用dplyr进行数据操作

processed_data <- vote_data %>%

group_by(District) %>%

summarise(Total_Votes = sum(Votes)) %>%

mutate(Vote_Percentage = Total_Votes / sum(Total_Votes))

# 查看处理后的数据框

print(processed_data)

```

#### 执行逻辑说明:

代码使用了dplyr的管道操作符(`%>%`)来链式执行数据操作。首先,按`District`分组,然后计算每个区的总票数。接着,添加了一个新列`Vote_Percentage`来计算每个区的得票百分比。`summarise()`函数用于生成新的数据框,包含总票数,而`mutate()`函数用于添加新列。

#### 参数说明:

- `group_by(District)`:按`District`对数据进行分组。

- `summarise(Total_Votes = sum(Votes))`:计算每个组的`Votes`总和。

- `mutate(Vote_Percentage = Total_Votes / sum(Total_Votes))`:在现有数据框中添加一个新列`Vote_Percentage`,计算每个区域的得票百分比。

# 5. reshape2包的未来展望和替代方案

随着数据分析和数据科学领域的不断发展,数据重塑技术也在持续进步。R语言中数据重塑包的发展趋势反映了这一领域的活跃度。本章节将探讨R语言数据重塑包的发展方向、社区贡献以及现有的和潜在的替代品。

## 5.1 R语言中数据重塑包的发展趋势

### 5.1.1 未来的发展方向

随着大数据和复杂数据结构的日益增长,数据重塑包的未来发展方向主要集中在以下几个方面:

- **性能优化**:为了处理越来越庞大的数据集,性能优化成为一个关键领域。新的包可能会采用更加高效的数据处理算法和底层语言优化,比如C++。

- **多语言支持**:将数据重塑功能与其他编程语言集成,提高不同社区间的协作效率和工具的互操作性。

- **用户友好的接口**:为了降低使用门槛,更简洁直观的API设计将是一个重要趋势。通过简洁的命令和流程,让数据处理的复杂性对用户更加透明。

### 5.1.2 社区活跃度与贡献

社区活跃度是衡量一个包生命力的重要指标。社区通过提供反馈、报告错误、分享使用案例和编写文档等方式对包的发展做出贡献。活跃的社区能够快速推动包的进化,提供更为多样化的解决方案。

## 5.2 探索reshape2的替代品

### 5.2.1 data.table包的对比分析

`data.table`是一个高性能的包,用于数据表的操作和数据的快速分组。与`reshape2`相比,`data.table`在处理大数据集时具有显著的性能优势。以下是使用`data.table`的一个基本例子:

```r

library(data.table)

# 将data.frame转换为data.table对象

DT <- data.table(df)

# 使用data.table的语法进行数据的转换

DT_melted <- melt(DT, id.vars = "Time", variable.name = "Variable", value.name = "Value")

```

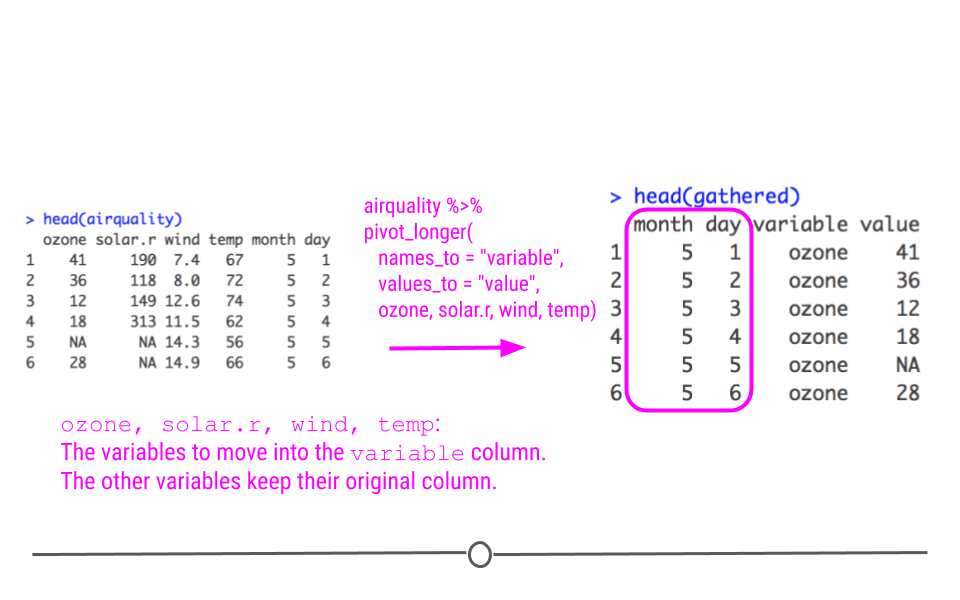

### 5.2.2 tidyr包的新功能与优势

`tidyr`包是一个数据整理工具,提供了`pivot_longer`和`pivot_wider`函数用于替代`melt`和`dcast`。`tidyr`的优势在于它和`dplyr`、`ggplot2`等tidyverse包的紧密集成,形成了一个强大的数据处理工作流。

```r

library(tidyr)

# 将宽格式数据转换为长格式

long_data <- pivot_longer(df, cols = -Time)

# 将长格式数据转换为宽格式

wide_data <- pivot_wider(df, names_from = Variable, values_from = Value)

```

## 5.3 高级数据重塑技术的展望

### 5.3.1 基于reshape2的高级技术研究

尽管`reshape2`已经不再是R语言中数据重塑的首选包,但是围绕其进行的高级技术研究依然具有参考价值。例如,针对特定类型数据的优化算法,或者结合机器学习模型以自动化数据重塑过程。

### 5.3.2 与其他编程语言的数据重塑对比

其他编程语言如Python也在数据重塑方面有着强大的库,例如Pandas。通过对比不同语言中的数据重塑技术,可以发现R语言中的包在某些方面可能更加灵活,但在性能上可能不如Python。这种跨语言的比较有助于我们更好地理解每种语言的优势和局限性。

```python

import pandas as pd

# Python中Pandas库的数据重塑示例

df = pd.DataFrame({'Time': ['2021-01-01']*3, 'VarA': [1, 2, 3], 'VarB': [4, 5, 6]})

long_data = df.melt(id_vars=['Time'], var_name='Variable', value_name='Value')

```

R语言的用户可以从中学习到更多关于数据处理的跨语言最佳实践,同时Python的用户也可能从R社区的创新中获益。

0

0