数据预处理的艺术:如何通过清洗和特征工程提高预测质量

发布时间: 2024-11-24 23:24:57 阅读量: 5 订阅数: 4

# 1. 数据预处理概论

在面对大数据的时代,数据预处理成为数据分析和机器学习工作流程中不可或缺的环节。数据预处理是数据科学的基础,它涉及到一系列的数据处理步骤,以确保后续分析的准确性和模型的有效性。预处理包括数据清洗、特征工程、数据转换等多个方面,旨在改善数据质量,提升模型性能。

## 1.1 数据预处理的重要性

数据预处理的重要之处在于它为数据分析奠定了坚实的基础。未经过预处理的数据可能存在噪声、不一致性、错误和缺失值,这些问题如果不加以解决,将会严重影响到分析结果的准确性。预处理的任务是将原始数据转换为适合分析的格式,并确保数据的质量。

## 1.2 数据预处理的主要内容

数据预处理主要包括以下几个方面:

- 数据清洗:识别并处理数据集中的错误和不一致性。

- 数据集成:合并来自不同源的数据,以统一格式呈现。

- 数据转换:利用数学转换改变数据格式,使其更适合模型训练。

- 数据规约:减少数据量,但尽可能保留数据的完整性。

在接下来的章节中,我们将深入探讨这些主题,并提供实用的技巧和工具,帮助读者有效进行数据预处理工作。

# 2. 数据清洗的方法论

## 2.1 数据清洗的理论基础

### 2.1.1 数据清洗的重要性

在任何数据驱动的项目中,数据质量是决定成功的关键因素之一。数据清洗则是提高数据质量的一个重要环节。数据不准确、不一致或不完整会导致分析结果的偏差,从而影响决策的准确性。数据清洗的目的在于纠正或删除数据中的错误,确保数据集的准确性和一致性,为后续的数据分析和模型训练打下坚实的基础。

### 2.1.2 数据清洗流程概述

数据清洗流程通常包括以下几个步骤:

1. 数据探索:初步了解数据集的结构,识别数据类型和基本统计特征。

2. 缺失值处理:对缺失数据进行适当处理,如删除、填充等。

3. 异常值处理:识别并处理异常值,以减少其对分析结果的影响。

4. 数据去重:去除重复的记录,确保数据集中的每一行都是唯一的。

5. 格式标准化:对数据进行格式化处理,如日期格式统一、文本标准化等。

6. 数据验证:确保清洗后的数据符合业务需求和数据完整性要求。

## 2.2 数据清洗的实践技巧

### 2.2.1 缺失值处理

缺失值处理是数据清洗中常见的问题。处理缺失值的方法有多种,包括删除含有缺失值的行或列、使用均值或中位数填充、以及利用预测模型估算缺失值等。

以 Python 中的 pandas 库为例,删除含有缺失值的行可以通过以下代码实现:

```python

import pandas as pd

# 假设df是一个pandas DataFrame

df_clean = df.dropna() # 删除含有缺失值的行

```

此外,使用均值填充缺失值可以通过 `fillna` 方法实现:

```python

df_filled = df.fillna(df.mean()) # 使用列均值填充缺失值

```

选择何种方法取决于数据的特性和分析的需求。在某些情况下,如缺失值过多,可能需要删除该列;而在其他情况下,删除含有缺失值的行可能会造成大量数据的浪费。

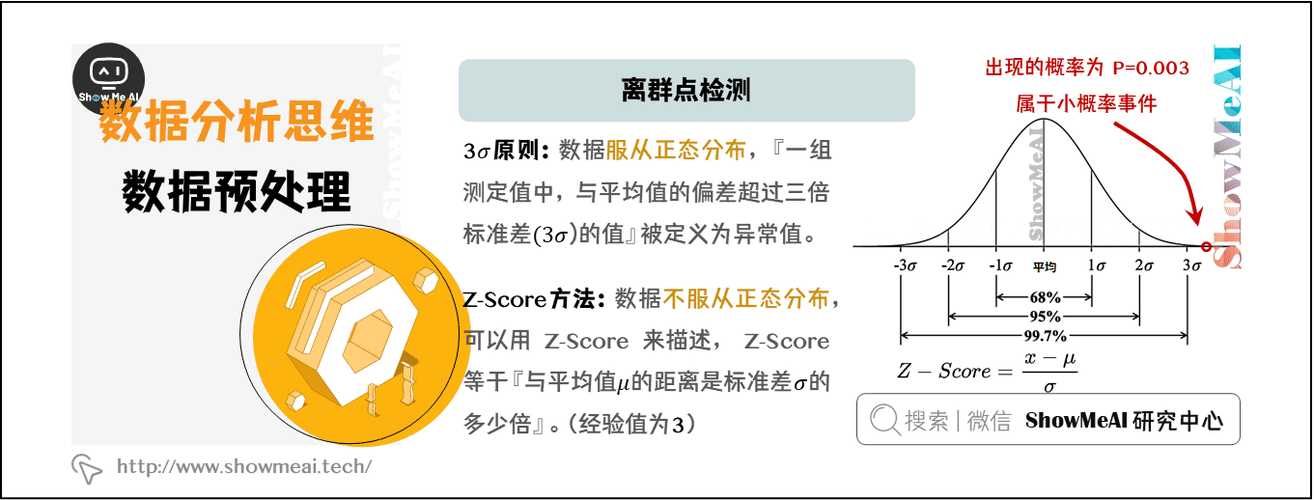

### 2.2.2 异常值处理

异常值指的是那些与大多数数据显著不同的观测值。异常值可能是由数据录入错误、测量误差或真实的极端值造成的。异常值的处理方法包括删除、缩放或转换。

在统计学中,Z分数是判断异常值的一种常见方法。Z分数表示数据点与均值的偏差,以标准差的单位表示。一般认为,Z分数大于3或小于-3的数据点可能为异常值。

在 Python 中,可以使用以下代码计算并移除异常值:

```python

from scipy import stats

z_scores = stats.zscore(df['column_name'])

df_no_outliers = df[(z_scores < 3) & (z_scores > -3)]

```

### 2.2.3 数据去重和格式标准化

数据去重是清洗过程中的重要一步,目的是删除数据集中的重复记录。在 pandas 中,可以使用 `duplicated()` 方法来检测重复项,并用 `drop_duplicates()` 方法进行删除:

```python

df_unique = df.drop_duplicates()

```

格式标准化是指将数据转换为一致的格式。例如,日期和时间数据常常需要转换为标准格式以方便分析:

```python

df['date_column'] = pd.to_datetime(df['date_column'], format='%Y-%m-%d')

```

## 2.3 数据清洗工具和案例分析

### 2.3.1 常用数据清洗工具对比

当前市面上有多种数据清洗工具可供选择,包括开源工具和商业软件。常见的开源工具包括 pandas、OpenRefine 和 Apache NiFi。商业软件如 Tableau Prep、Trifacta Wrangler 和 Alteryx Designer 提供了更加图形化的操作界面和更多的数据处理功能。

例如,pandas 是 Python 中一个非常流行的库,它提供了大量用于数据清洗的函数和方法。与其他工具相比,pandas 的优势在于灵活性高,可以无缝集成到数据科学工作流中。

### 2.3.2 实际案例应用解析

为了更具体地了解数据清洗的应用,下面展示一个简单的数据清洗流程的实际案例。假设有一个销售数据集,需要进行清洗以便进行销售分析。

首先,需要导入必要的库并加载数据集:

```python

import pandas as pd

# 加载数据集

df_sales = pd.read_csv('sales_data.csv')

```

然后,进行数据探索:

```python

# 查看数据集的基本信息

df_sales.info()

# 查看数据集的前几行数据

df_sales.head()

```

接下来,进行缺失值处理:

```python

# 使用均值填充数值型特征的缺失值

df_sales.fillna(df_sales.mean(), inplace=True)

# 删除含有缺失值的文本型特征的行

df_sales.dropna(subset=['text_feature'], inplace=True)

```

处理异常值:

```python

# 使用Z分数检测并移除异常值

z_scores = stats.zscore(df_sales['sales_amount'])

df_sales = df_sales[(z_scores < 3) & (z_scores > -3)]

```

最后,进行数据去重和格式标准化:

```python

# 删除重复记录

df_sales.drop_duplicates(inplace=True)

# 格式化日期列

df_sales['date'] = pd.to_datetime(df_sales['date'], format='%d/%m/%Y')

```

完成以上步骤后,数据集就变得干净且一致,适合进行后续分析和模型训练。以上案例展示了数据清洗的基本流程,实际应用中可能需要更加复杂和细致的处理步骤。

# 3. 特征工程的实战策略

## 3.1 特征工程基本概念

### 3.1.1 特征工程的意义与作用

在机器学习流程中,特征工程占据着至关重要的地位。它不仅仅是一个技术动作,更是将原始数据转化为可被机器学习算法有效利用的形式的过程。良好的特征工程可以提高模型的预测能力,而低效的特征工程则可能导致模型性能低下,甚至无法准确预测。

特征工程通过选择、构造、转换特征来改善模型性能。这种转换包括但不限于缩放数值特征、编码类别特征、提取时间特征、聚合特征等。这些工作可以提高数据的可解释性,简化模型结构,降低过拟合风险,并且使得模型训练更加高效。

### 3.1.2 特征类型及其转换方法

特征工程涉及到特征的类型包括数值特征、类别特征、序数特征以及时间序列特征等。不同类型特征的处理方法也不尽相同,下面是常见特征类型及其转换方法:

- 数值特征:通常包括整型和浮点型数据。对于数值特征,常见的处理方法包括标准化、归一化、对数转换、平方根转换等。

- 类别特征:通常包括字符串、枚举等。处理类别特征通常使用独热编码、标签编码、哈希编码等方法。

- 序数特征:这类特征表示有序关系,如教育水平、评级等。常见的处理方法包括序数编码和多项式编码。

- 时间序列特征:这类特征与时间相关,常见的处理方法包括时间窗口统计、趋势特征提取、周期特征提取等。

## 3.2 特征选择与提取

### 3.2.1 过滤法、包裹法和嵌入法

特征选择的目的是减少特征的维度,消除无关特征,并提高模型性能。不同的特征选择方法适用于不同的数据和模型需求,主要的三种方法包括过滤法、包裹法和嵌入法。

- 过滤法:通过统计测试对每个特征进行评分,然后选择分数最高的N个特征。这种无监督的方法适用于大数据集,但可能会忽略特征之间的关联。

- 包裹法:使用一个学习算法作为评估标准,尝试不同的特征子集,并以最优的特征子集来训练模型。这种方法通常准确度高,但计算代价较大。

- 嵌入法:结合过滤法和包裹法的特点,在模型训练过程中进行特征选择。L1正则化、基于树的方法等都是常见的嵌入法特征选择技术。

### 3.2.2 主成分分析(PCA)与线性判别分析(LDA)

PCA(主成分分析)和LDA(线性判别分析)是两种常用的特征提取方法,它们通过降维技术来提取最重要特征。

- PCA:是一种无监督的降维方法,其目的是找到数据中方差最大的方向,并保留这些方向上的特征。PCA通过正交变换将数据转换到新的坐标系统中,使得新的坐标轴与数据的方差方向一致。

- LDA:是一种监督的降维方法,它试图找到能够区分不同类别的特征。LDA不仅仅是降低特征的维度,而且还希望在降维的同时保持数据的类别区分性。

## 3.3 特征构造与优化

### 3.3.1 基于领域知识的特征构造

基于领域知识的特征构造是特征工程中一个强大的策略,它要求领域专家根据专业知识来提取或构造相关特征。这些特征往往具有明确的物理或业务意义,能显著提升模型的预测能力。例如,在金融领域,利用客户的交易记录和历史信用评分来构造特征;在医疗领域,利用病人的基因数据和历史健康记录来构造新特征。

### 3.3.2 高级特征构造技术,如特征交叉

特征交叉是特征工程中的一个高级技术,尤其在深度学习模型中被广泛应用。特征交叉指的是将两个或多个特征组合起来创建新的特征。这可以捕捉到原始特征之间的相互作用,这对于模型理解复杂的数据关系非常有用。

以表格形式总结特征构造技术:

| 特征构造技术 | 描述 | 优点 | 缺点 |

|----------------|------------------------------------------------------------|------------------------------------------------------------|------------------------------------------------------------|

| 基于领域知识的构造 | 利用专家知识提取特征 | 特征具有明确意义,能有效提升模型性能 | 需要专业知识,且耗时较长 |

| 特征交叉 | 结合多个特征生成新特征 | 能捕捉特征间的相互作用,适用于深度学习模型 | 可能导致特征维度爆炸,需谨慎使用 |

| 统计方法 | 利用统计测试(如卡方检验、互信息)选择相关性高的特征 | 可以自动化进行,不需要太多专业知识 | 可能会忽略非线性关系和复杂的特征结构 |

| 聚合特征 | 使用聚合函数(如均值、中位数、最大值)对数据集进行降维操作 | 简化数据结构,去除噪声,提升模型训练速度 | 可能丢失重要信息,需要结合领域知识来决定聚合的粒度和方式 |

| 降维技术 | 如PCA、LDA等,用于特征维数的降低 | 减少过拟合风险,提高模型泛化能力,简化模型结构 | 可能会丢失有用信息,尤其当数据集本身就是低维时可能导致性能下降 |

| 深度特征 | 使用深度学习模型,如自动编码器进行特征学习 | 能够捕捉复杂的非线性关系,适用于高维、非结构化数据 | 需要大量数据进行训练,计算成本高,且难以解释模型内部特征是如何被学习的 |

以代码块演示PCA的应用实例:

```python

from sklearn.decomposition import PCA

from sklearn.preprocessing import StandardScaler

# 假设X为特征矩阵,其中每一行表示一个样本,每一列表示一个特征

X = ... # 特征矩阵,维度为 (n_samples, n_features)

# 标准化数据

scaler = StandardScaler()

X_scaled = scaler.fit_transform(X)

# 应用PCA,假设我们想将特征降至3维

pca = PCA(n_components=3)

X_pca = pca.fit_transform(X_scaled)

# 输出降维后的特征

print(X_pca)

```

在此代码块中,我们首先使用`StandardScaler`进行数据标准化处理,这是PCA处理前的重要步骤。然后,我们实例化了`PCA`类并设置我们希望降至的维度`n_components=3`,最后通过`fit_transform`方法将数据降至3维,并输出结果。通过PCA的降维,我们不仅降低了数据的维度,还保留了数据最主要的变化信息。

# 4. 预测模型的质量提升

### 4.1 数据集划分与模型评估

在构建和优化预测模型的过程中,数据集的合理划分是至关重要的一步,它能直接影响到模型的泛化能力和评估结果的可靠性。通常,数据集会被划分为训练集、验证集和测试集。

#### 4.1.1 训练集、验证集与测试集的划分

训练集用于模型的学习过程,是模型参数调整的主要依据。验证集则用来监控模型训练过程中的性能,以便进行超参数调整和避免过拟合。最后,测试集用于评估模型的最终性能。

划分数据集通常采用“训练集/验证集/测试集”的比例分配方式,如70%/15%/15%或80%/10%/10%。更复杂的方法如交叉验证能够更充分地利用有限的数据。

```python

from sklearn.model_selection import train_test_split

# 假定 X 是特征数据,y 是标签数据

X_train, X_temp, y_train, y_temp = train_test_split(X, y, test_size=0.3, random_state=42)

X_val, X_test, y_val, y_test = train_test_split(X_temp, y_temp, test_size=0.5, random_state=42)

# 输出划分后各数据集的形状

print(X_train.shape, X_val.shape, X_test.shape, y_train.shape, y_val.shape, y_test.shape)

```

在上述代码中,我们使用了`train_test_split`函数来自`sklearn.model_selection`模块对数据进行划分,验证集和测试集的划分比例均为15%。

#### 4.1.2 模型性能评估指标

模型的性能评估通常依赖于各种指标,其中分类问题常用的指标包括准确度(Accuracy)、精确度(Precision)、召回率(Recall)、F1分数(F1-score)等。回归问题则更多使用均方误差(MSE)、均方根误差(RMSE)、R平方分数(R^2)等。

准确度是预测正确的样本数占总样本数的比例,计算公式为:

```

准确度 = (TP + TN) / (TP + FP + TN + FN)

```

其中,TP代表真正的正例数,TN代表真正的负例数,FP代表假正例数,FN代表假负例数。

```python

from sklearn.metrics import accuracy_score, precision_score, recall_score, f1_score

# 假定 y_true 是真实标签,y_pred 是模型预测标签

accuracy = accuracy_score(y_true, y_pred)

precision = precision_score(y_true, y_pred, average='macro')

recall = recall_score(y_true, y_pred, average='macro')

f1 = f1_score(y_true, y_pred, average='macro')

# 打印性能评估指标

print(f"Accuracy: {accuracy}")

print(f"Precision: {precision}")

print(f"Recall: {recall}")

print(f"F1 Score: {f1}")

```

在上述代码中,`accuracy_score`, `precision_score`, `recall_score`, `f1_score`函数分别用于计算模型的准确度、精确度、召回率和F1分数。参数`average='macro'`表示对各类别指标求算术平均值,适用于多类别分类问题。

### 4.2 特征工程与模型性能的关联分析

特征工程是构建优秀预测模型的核心步骤之一。合理选择和构造特征能够显著提升模型的预测性能。

#### 4.2.1 特征选择对模型预测的影响

特征选择的目的是选出最有助于预测的特征子集。这可以减少过拟合的风险,提高模型的泛化能力,并减少训练时间。

一种常见的特征选择方法是递归特征消除(Recursive Feature Elimination, RFE),它通过递归地构建模型,并在每次迭代后消除性能最差的特征,直至达到预期的特征数量。

```python

from sklearn.feature_selection import RFE

from sklearn.linear_model import LogisticRegression

# 假定 X 是特征数据,y 是标签数据

model = LogisticRegression()

rfe = RFE(model, n_features_to_select=5)

rfe.fit(X_train, y_train)

# 输出被选中的特征索引

selected_features = X.columns[rfe.support_]

print(selected_features)

```

在此代码中,我们使用了`RFE`类对特征进行选择,并且选择了5个最重要的特征。

#### 4.2.2 特征缩放与正则化技术

特征缩放是将特征的值按比例缩放,以便所有的特征在相同的比例下进行比较和计算。常见的缩放方法包括标准化(Standardization)和归一化(Normalization)。

正则化是一种防止过拟合的手段,它通过在模型的损失函数中增加一个惩罚项来限制模型复杂度。L1正则化和L2正则化是最常用的两种正则化技术,它们分别在损失函数中加入了权重的绝对值和平方值。

```python

from sklearn.preprocessing import StandardScaler

from sklearn.linear_model import Ridge

# 假定 X 是特征数据

scaler = StandardScaler()

X_scaled = scaler.fit_transform(X)

# 使用Ridge回归模型实现L2正则化

ridge = Ridge(alpha=1.0)

ridge.fit(X_scaled, y_train)

# 训练模型并输出权重

weights = ridge.coef_

print(weights)

```

在上述代码中,我们使用`StandardScaler`类对特征进行标准化处理,然后用`Ridge`类实现了L2正则化。

### 4.3 高级数据预处理技术

在构建复杂的预测模型时,高级的数据预处理技术能进一步提升模型的性能和准确性。

#### 4.3.1 非线性转换与多项式特征

非线性转换是处理特征之间非线性关系的一种技术,而多项式特征是将原始特征转换为特征空间的高维表示,这在处理非线性关系的模型中尤其有用,如多项式回归和支持向量机。

```python

from sklearn.preprocessing import PolynomialFeatures

# 假定 X 是特征数据

poly = PolynomialFeatures(degree=2, include_bias=False)

X_poly = poly.fit_transform(X)

# 查看多项式转换后的特征

print(X_poly)

```

在上述代码中,我们使用`PolynomialFeatures`类生成了多项式特征,并设置了多项式的阶数为2。

#### 4.3.2 集成学习中的特征预处理策略

集成学习通过组合多个学习器来提升预测性能。在集成学习模型中,对特征进行适当的预处理可以显著提升模型的整体性能。特征预处理策略应考虑模型的特性及其相互间的协同效应。

```python

from sklearn.ensemble import RandomForestClassifier

# 假定 X 是特征数据,y 是标签数据

rf = RandomForestClassifier()

rf.fit(X_train, y_train)

# 输出特征重要性评分

importances = rf.feature_importances_

print(importances)

```

在上述代码中,我们使用了`RandomForestClassifier`类进行集成学习,通过随机森林模型的`feature_importances_`属性,我们可以得到每种特征在模型中的重要性评分。

通过本章节的介绍,我们深入了解了数据集划分与模型评估、特征工程与模型性能的关联分析以及高级数据预处理技术。这些技术为构建和优化预测模型提供了强大的工具,可以帮助我们在面对实际问题时做出更准确的预测。

# 5. 数据预处理的前沿动态

## 5.1 自动化特征工程工具的进展

数据科学中,特征工程一直是一项耗时且需要专业知识的任务。近年来,随着机器学习技术的进步,自动化特征工程工具得到了快速发展,它们可以自动识别和构造特征,从而提高模型的性能和效率。本章节将介绍当前领先的自动化特征工程工具,并提供应用案例分析。

### 5.1.1 自动特征选择与提取工具介绍

**特征选择工具:**

- **Featuretools**:这是一个用于自动化特征工程的库,特别擅长处理时间序列数据。它基于“实体集”概念构建深度特征,可以自动识别出相关特征。

- **TPOT**:这是一个基于遗传编程的自动化机器学习工具,可以尝试不同的特征选择方法,并通过交叉验证来评估特征选择的有效性。

- **Auto-Sklearn**:它是基于scikit-learn的AutoML工具,自动优化特征选择和模型参数。

**特征提取工具:**

- **Umap**:一个可扩展的统一近似映射技术,用于降维。它特别适合于高维数据的特征提取。

- **T-SNE**:一种用于高维数据可视化和特征提取的流行技术,尤其在可视化领域得到广泛应用。

### 5.1.2 工具应用案例分析

以下是使用Featuretools进行自动化特征工程的一个实例代码块:

```python

import featuretools as ft

# 加载数据集

es = ft.demo.load_mock_customer(return_entityset=True)

# 定义特征

agg_primitives = ['sum', 'mean', 'count', 'std', 'min', 'max']

trans_primitives = ['day', 'month', 'year']

# 特征生成

feature_defs = ft.dfs(entityset=es,

target_entity="customers",

agg_primitives=agg_primitives,

trans_primitives=trans_primitives,

max_depth=2)

# 查看生成的特征

print(feature_defs)

```

上面的代码加载了一个内置的顾客数据集,并生成了目标实体“customers”的一系列特征。这简化了复杂数据集的特征工程步骤,并为模型训练提供了丰富的特征输入。

## 5.2 数据预处理在特定领域中的应用

数据预处理技术的发展和应用不断深化到各种特定领域中,例如生物信息学和金融领域,对数据预处理的需求也日益复杂和严格。

### 5.2.1 生物信息学中的数据预处理

在生物信息学中,数据预处理通常涉及对高通量测序数据的处理,如基因表达数据的标准化、批次效应校正和缺失值处理。工具如`DESeq2`和`edgeR`等用于基因表达分析,它们不仅处理数据,还能够在预处理过程中进行差异表达分析。

### 5.2.2 金融领域的数据预处理需求

金融领域是另一个对数据预处理要求极高的领域。准确的信用评分、欺诈检测和市场预测都依赖于高质量的数据。金融数据预处理涉及数据的整合、清洗、以及对时间序列的处理。处理方法包括异常值处理、标准化、以及使用机器学习方法进行模式识别和预测。

## 5.3 未来趋势与挑战

数据预处理作为数据科学和机器学习的重要环节,其未来的发展趋势和面临的挑战是多方面的。

### 5.3.1 数据科学中的预处理趋势

随着自动化的推进,数据预处理正在变得更加智能化和自动化。趋势表明,未来的预处理工具将更加集成化、用户友好,并且能够处理更多类型的数据。此外,它们还将提供更多的定制化选项,以适应不同的业务需求。

### 5.3.2 解决数据不平衡、隐私保护的预处理方法

数据不平衡和隐私问题是当前数据预处理领域的两大挑战。通过研究如合成少数类过采样技术(SMOTE)来解决不平衡问题,以及探索基于联邦学习和差分隐私的数据预处理方法,来保护个人隐私,是未来发展的方向。

通过上述各节的内容,我们可以看到数据预处理领域的迅速进展以及面临的挑战,并且了解了自动化工具的应用前景。随着技术的持续创新,这些预处理方法和工具将会成为数据科学领域的基石。

0

0