模型评估指标全解析:科学评价预测效果的黄金标准

发布时间: 2024-11-25 00:36:15 阅读量: 555 订阅数: 25

YOLOv8 模型测试与评估全流程解析:精准度量模型性能

# 1. 模型评估指标概述

在机器学习和数据科学领域,模型评估指标是衡量模型性能的关键。这些指标帮助我们理解模型在预测、分类或聚类任务中的准确度、可靠性和适用性。一个合适的评估指标能够提供模型性能的直观表示,为模型优化指明方向,并辅助决策者做出基于数据的决策。

## 1.1 模型评估的重要性

模型评估不仅告诉我们模型的预测能力如何,还能够揭示模型可能存在的问题,例如过拟合或欠拟合。通过比较不同模型的性能指标,我们可以选择最适合特定任务的模型。此外,评估指标还是模型迭代优化和比较不同算法效果的基础。

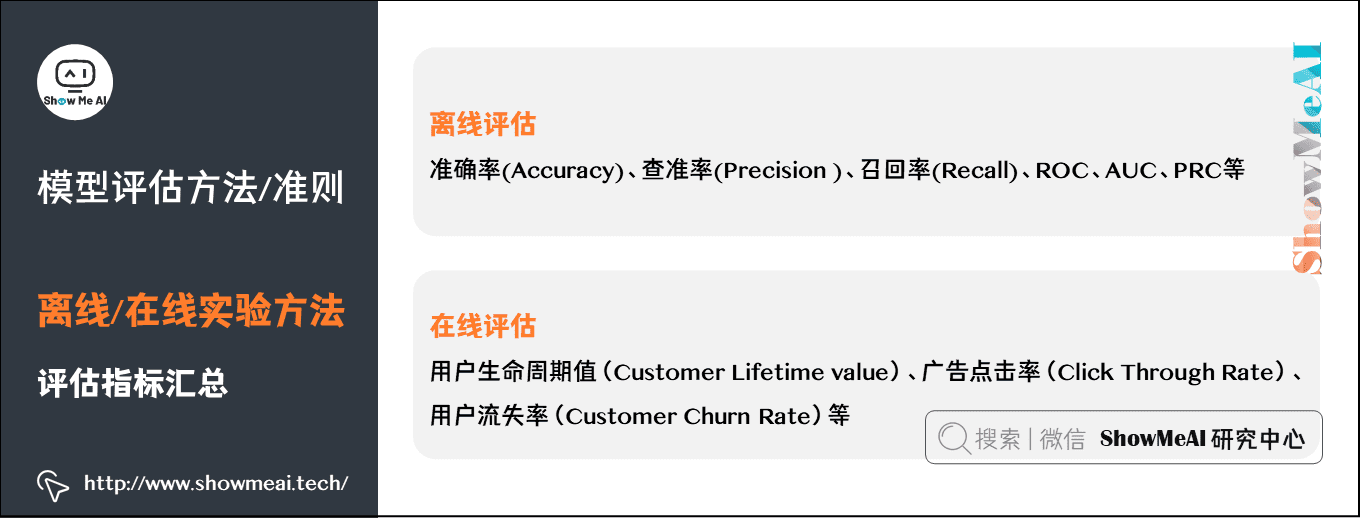

## 1.2 模型评估指标的分类

评估指标可以分为几类,对应不同类型的问题:

- 分类问题:准确率、精确率、召回率、F1分数等。

- 回归问题:均方误差、均方根误差、平均绝对误差、决定系数等。

- 聚类问题:轮廓系数、Calinski-Harabasz指数、Davies-Bouldin指数等。

- 深度学习问题:损失函数、正确率、精确率、召回率等。

这些指标从不同角度评价模型性能,因此理解它们的计算方法和应用场景至关重要。

## 1.3 本章内容概览

本章将概览常见的模型评估指标,为后续章节详细介绍各类指标奠定基础。我们将探讨每个指标的计算方法、应用场景以及如何通过这些指标优化模型。通过本章的学习,读者将能够选择合适的评估指标,为后续的模型改进提供理论支持和实践指导。

# 2. 分类模型的评估指标

### 2.1 准确性和错误率

在分类问题中,准确性和错误率是最直接和基础的评估指标。准确率衡量的是模型正确分类的比例,它直观地反映了模型的总体表现。

#### 2.1.1 准确性的计算和应用场景

准确性(Accuracy)的计算公式非常简单,它是正确预测的数量除以总样本数量:

```

Accuracy = (True Positives + True Negatives) / Total Samples

```

准确性在一些类别不平衡的场景下可能会有误导性,比如在一个数据集中,有95%的数据属于类别A,而只有5%的数据属于类别B。一个简单预测所有样本都属于类别A的模型的准确性也可以达到95%。但是这个模型并没有很好地学习区分类别A和B。因此,在类别不平衡时,准确性就不是最优的评估指标。

准确率更适用于类别平衡的数据集。比如在医疗图像诊断中,正常和异常样本比例接近1:1时,准确性就能较好地评估模型性能。

#### 2.1.2 错误率的影响因素和优化策略

错误率(Error Rate)是准确率的对立面,它表示模型分类错误的比例。在二分类问题中,错误率的计算公式如下:

```

Error Rate = (False Positives + False Negatives) / Total Samples

```

模型的错误率受到样本分布、模型复杂度、特征选择等多个因素的影响。为了降低错误率,可以采取以下优化策略:

- 数据增强:通过旋转、缩放、裁剪等手段增加数据集的多样性,提高模型泛化能力。

- 特征工程:选择和构造更有利于模型学习的特征。

- 模型正则化:引入L1或L2正则项防止过拟合。

- 选择合适的模型复杂度:太复杂的模型可能会导致过拟合,而太简单的模型又可能欠拟合,平衡两者是降低错误率的关键。

### 2.2 精确度、召回率与F1分数

#### 2.2.1 精确度与召回率的定义和关系

精确度(Precision)和召回率(Recall)是在不平衡分类问题中更为重要的评估指标。精确度是模型正确预测为正的样本占所有预测为正样本的比例,而召回率则是模型正确预测为正的样本占实际所有正样本的比例。

```

Precision = True Positives / (True Positives + False Positives)

Recall = True Positives / (True Positives + False Negatives)

```

精确度和召回率之间存在一种权衡关系。在很多情况下,提高一个指标往往会导致另一个指标的下降。比如,在一个电子邮件垃圾过滤系统中,如果提高精确度(即减少误判为垃圾邮件的正常邮件数量),则可能漏掉一些真正的垃圾邮件(降低召回率)。

#### 2.2.2 F1分数的原理及其对平衡的影响

F1分数是精确度和召回率的调和平均值,它为两个指标提供了一个平衡的单一指标,特别适用于二分类问题。其计算公式如下:

```

F1 Score = 2 * (Precision * Recall) / (Precision + Recall)

```

F1分数提供了一种单一指标来平衡精确度和召回率的权衡。在需要同时考虑精确度和召回率的场景下,F1分数是一个很好的选择。比如,在疾病诊断中,模型需要同时对疾病的识别有很高的精确度(避免误诊)和很高的召回率(避免漏诊)。

### 2.3 ROC曲线和AUC值

#### 2.3.1 ROC曲线的构建和解读

接收者操作特征曲线(Receiver Operating Characteristic Curve,简称ROC曲线)是一种非常有用的评估分类模型性能的工具。ROC曲线以真正的率(True Positive Rate,即召回率)为纵坐标,假正率(False Positive Rate)为横坐标,展示不同阈值设置下模型的性能。

ROC曲线的构建过程如下:

1. 在每个可能的决策阈值下,计算出对应的真正率(TPR)和假正率(FPR)。

2. 在坐标图上标记出这些点。

3. 连接这些点形成曲线。

一条好的ROC曲线应该尽可能地向左上角靠近,这意味着模型能够在较低的FPR下得到较高的TPR。反之,一条靠近对角线的ROC曲线表明模型的分类效果与随机猜测差不多。

#### 2.3.2 AUC值的意义和应用场景

曲线下面积(Area Under the Curve,简称AUC)是ROC曲线下的面积大小,它提供了一个衡量模型整体性能的数值指标。AUC值的范围从0.5到1.0,其中:

- AUC = 0.5,模型性能等同于随机猜测。

- AUC = 1.0,模型完美地将所有正例和负例区分开。

AUC值的计算通常可以通过梯形法则近似计算,或者利用数学积分的数值方法。AUC值常用于数据不平衡或成本敏感的分类问题中,因为AUC与类别分布无关,能更全面地评价模型性能。

```mermaid

graph LR

A[ROC空间] -->|计算TPR和FPR| B[绘制ROC曲线]

B --> C[计算AUC值]

C --> D[评估模型性能]

```

通过ROC曲线和AUC值的分析,我们可以更好地选择和调整分类模型以满足实际需求。在模型比较时,AUC值可以提供一个不依赖特定阈值的性能度量,因此被广泛用于学术研究和实际应用中。

# 3. 回归模型的评估指标

回归分析是机器学习领域中用于预测连续值输出的重要方法。准确地评估回归模型的好坏,是确保模型能够有效预测的重要步骤。本章将重点介绍几种关键的回归模型评估指标,包括均方误差(MSE)和均方根误差(RMSE)、平均绝对误差(MAE)、以及决定系数(R²)。这些指标各有其特点和适用场景,理解这些评估指标对于提升模型性能至关重要。

## 3.1 均方误差(MSE)和均方根误差(RMSE)

### 3.1.1 均方误差的计算和优缺点

均方误差(Mean Squared Error,MSE)是回归模型中最常用的性能度量之一。MSE通过计算预测值与实际值之差的平方和,然后求平均值得到。公式如下:

\[ MSE = \frac{1}{n} \sum_{i=1}^{n} (y_i - \hat{y}_i)^2 \]

其中 \( n \) 是样本数量,\( y_i \) 是第 \( i \) 个样本的真实值,\( \hat{y}_i \) 是对应的预测值。

MSE的优点在于它对异常值较为敏感,因为较大的预测误差会对总误差贡献更大的平方值。这一点使得MSE对于异常值的检测尤其有效,同时它也是优化算法中常用的损失函数。

然而,MSE的缺点也很明显。由于MSE是误差的平方,所以它不再具有和原始数据相同的度量单位。此外,MSE对误差的放大作用可能导致模型在预测时对较大误差过分“惩罚”,因此在一些情况下可能不是最优的性能度量。

### 3.1.2 均方根误差的特点和适用范围

为了克服MSE的缺点,均方根误差(Root Mean Squared Error,RMSE)被提出。RMSE是MSE的平方根,因此它具有和原始数据相同的单位,使得结果更容易解释。

\[ RMSE = \sqrt{\frac{1}{n} \sum_{i=1}^{n} (y_i - \hat{y}_i)^2} \]

RMSE保留了MSE的优点,即对大误差的高敏感性,同时也消除了单位不一致的问题,使得结果更加直观。因此,RMSE非常适合用于不同量级或单位的数据集上,它能够提供一个更加公平的比较标准。

不过,和MSE一样,RMSE同样对异常值敏感,这可能在某些场景下并不是我们所期望的。在实际应用中,选择MSE还是RMSE往往取决于具体问题的需求以及数据的特性。

#### 代码块展示和分析

```python

from sklearn.metrics import mean_squared_error

from sklearn.metrics import mean_absolute_error

import numpy as np

# 假设 y 实际值和 y_pred 预测值为以下数组

y_true = np.array([3, -0.5, 2, 7])

y_pred = np.array([2.5, 0.0, 2, 8])

# 计算均方误差 (MSE)

mse = mean_squared_error(y_true, y_pred)

print(f"均方误差 (MSE): {mse}")

# 计算均方根误差 (RMSE)

rmse = np.sqrt(

```

0

0