HDFS数据压缩技术:减少存储空间与提高I_O效率的实践指南

发布时间: 2024-10-25 16:46:49 订阅数: 6

# 1. HDFS数据压缩技术概述

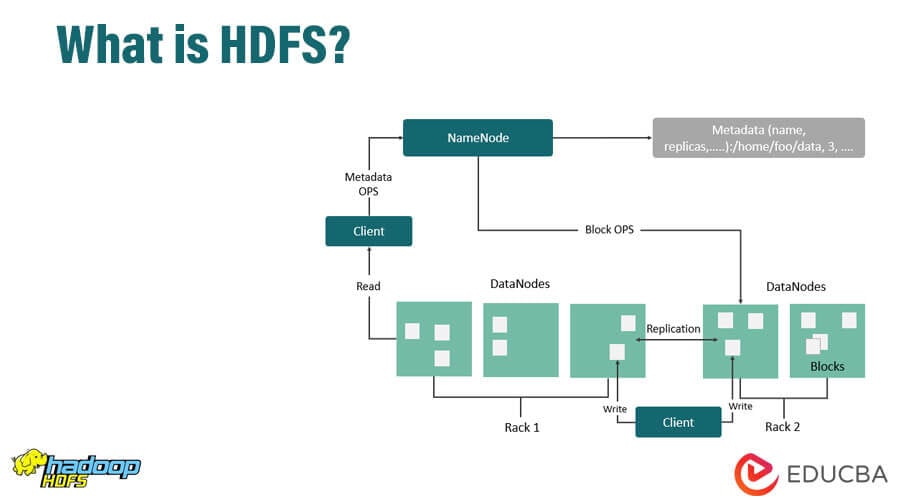

在大数据存储和处理领域,数据压缩技术发挥着关键作用。Hadoop分布式文件系统(HDFS)作为大数据技术栈中不可或缺的一部分,其数据压缩技术在提高存储效率、减少网络传输开销以及降低I/O负载方面具有显著影响。数据压缩不仅有助于节省成本,还能提升计算性能,因此对HDFS环境下的数据压缩技术进行分析和优化变得尤为重要。接下来的章节中,我们将深入探讨数据压缩的理论基础,对不同压缩格式进行比较,并讨论在HDFS中的具体实践和应用案例。这将为读者提供一个全面了解和高效应用HDFS数据压缩技术的框架。

# 2. 数据压缩理论基础

数据压缩是计算机科学中的一个重要领域,它通过算法减小数据集的大小,节省存储空间,提高数据传输的效率。本章将深入探讨数据压缩的理论基础,涵盖压缩的原理、不同压缩格式的比较以及压缩对存储和I/O的影响。

## 2.1 数据压缩的原理

### 2.1.1 信息熵和压缩率

信息熵是衡量数据无序度的一个量度,它表示了一个数据源的平均信息量。在数据压缩的语境中,信息熵越高,数据的可压缩性越好。信息熵可以用来解释数据压缩时能够达到的极限压缩率。

```mathematica

H(X) = -Σ p(x) * log2(p(x))

```

其中,`H(X)`表示信息熵,`p(x)`表示字符`x`出现的概率。通过对数据进行统计和概率分布的建模,可以优化压缩算法以达到更高的压缩率。

### 2.1.2 压缩算法的分类

压缩算法大致可以分为无损压缩和有损压缩两大类。无损压缩确保数据完整性,常用于文本和程序代码;有损压缩常用于图像、音频和视频,其压缩率更高,但以牺牲一部分信息为代价。

无损压缩算法如Huffman编码、Lempel-Ziv-Welch (LZW)编码通过创建数据的短代码替换原始数据来实现压缩,而有损压缩算法如JPEG和MP3则通过舍弃一些不重要的数据部分来实现更高的压缩率。

## 2.2 压缩格式的比较

### 2.2.1 常见压缩格式特性

不同的压缩格式有不同的特性,包括压缩率、速度、内存消耗和兼容性等。例如,GZIP是一种广泛使用的压缩工具,它基于DEFLATE压缩算法,提供了很好的压缩率和速度平衡;而BZIP2提供了更高的压缩率,但压缩和解压的速度较慢。

压缩格式的选择往往取决于具体的应用场景。例如,在存储成本高昂的环境中,可能更倾向于选择压缩率更高的算法;而在对性能要求较高的实时数据处理场景中,则可能需要选择速度快的压缩算法。

### 2.2.2 压缩效率与应用场景分析

压缩效率是评估压缩算法性能的重要指标,通常通过压缩前后的数据大小比来衡量。不同的压缩格式适应不同的应用场景:

- **文本文件**:适合使用如GZIP或者BZIP2这样无损压缩格式。

- **多媒体文件**:图片、音频和视频文件通常采用有损压缩格式,如JPEG、PNG、MP3、AAC等。

- **大型数据集**:大数据场景下,可能会使用专为Hadoop环境优化的压缩格式,如Snappy,它平衡了压缩/解压速度和压缩率。

## 2.3 数据压缩对存储和I/O的影响

### 2.3.1 压缩与存储空间的关系

数据压缩直接减少了存储空间的需求。在存储成本高昂的数据中心,使用压缩技术可以显著减少存储设备的购买和维护成本。例如,一个1TB的HDD大约需要$50,而1TB的SSD需要$150以上,压缩数据可以减少对高性能存储设备的需求。

此外,数据压缩还可以在备份和归档过程中发挥重要作用。压缩备份数据可以减少传输时间,节省网络带宽,并且能够更快地进行数据恢复。

### 2.3.2 压缩对I/O性能的作用

I/O性能是影响存储系统整体性能的关键因素之一。通过数据压缩,可以减少磁盘I/O操作的次数,降低I/O负载。尤其是在读写密集型的应用场景中,压缩可以提高磁盘的吞吐量,减少延迟,提升系统的响应速度。

然而,压缩过程需要额外的CPU资源,特别是在进行压缩时,CPU的负载会增加。因此,需要仔细权衡压缩带来的存储和I/O性能收益与CPU资源消耗之间的关系。

```mermaid

graph LR

A[存储未压缩数据] --> B[压缩数据]

B --> C[减少磁盘I/O操作]

C --> D[提升I/O性能]

```

在实际应用中,管理员需要监控系统的I/O性能指标,并根据业务需求调整压缩策略,确保系统性能最优化。下一章将探讨HDFS压缩技术的实践应用,包括配置压缩选项、集成MapReduce作业以及不同数据类型中的应用案例。

# 3. HDFS压缩技术实践

## 3.1 HDFS压缩技术设置

### 3.1.1 Hadoop配置文件中的压缩选项

在Hadoop的配置文件`core-site.xml`和`hdfs-site.xml`中,可以设置与HDFS压缩相关的参数。例如,在`hdfs-site.xml`中设置默认的压缩编码器,可以指定数据在写入HDFS时使用的压缩格式。

```xml

<configuration>

<property>

<name>dfs.namenode.name.dir</name>

<value>***${hadoop.tmp.dir}/dfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>***${hadoop.tmp.dir}/dfs/data</value>

</property>

<property>

<name>***pression.codecs</name>

<value>***press.DefaultCodec,

***press.GzipCodec,

***press.BZip2Codec,

***press.DeflateCodec,

***press.SnappyCodec</value>

</property>

<property>

<name>***pression.default.filecodec</name>

<value>***press.DefaultCodec</value>

</property>

<property>

<name>dfs.replication</name>

<value>3</value>

</property>

</configuration>

```

### 3.1.2 压缩编码器的选择与配置

选择合适的压缩编码器是实现高效数据压缩的关键。Hadoop支持多种编码器,包括但不限于`DefaultCodec`, `GzipCodec`, `BZip2Codec`, `DeflateCodec`, 和 `SnappyCodec`。在实际应用中,需要根据数据类型和应用场景选择合适的编码器。例如,`SnappyCodec`提供了较快的压缩和解压缩速度,适合流处理;而`GzipCodec`提供了较高的压缩比,适合存储密集型的应用。

```java

Configuration conf = new Configura

```

0

0