Storm与Hadoop对比分析:实时数据处理框架的终极选择

发布时间: 2024-10-25 21:28:34 阅读量: 40 订阅数: 39

基于hadoop框架的大数据处理与分析系统.pdf

# 1. 实时数据处理的概述

在如今信息爆炸的时代,数据处理的速度和效率至关重要,尤其是在处理大规模、高速产生的数据流时。实时数据处理就是在数据生成的那一刻开始对其进行处理和分析,从而能够快速做出决策和响应。这一技术在金融交易、网络监控、物联网等多个领域发挥着关键作用。

实时数据处理之所以重要,是因为它解决了传统批处理方法无法即时提供结果的局限性。它通过即时处理和分析数据流,能够实时地监控系统状态,从而在诸多领域实现自动化决策和智能响应。

在本章中,我们将探讨实时数据处理的基本概念,并理解其在现代数据处理体系中的重要性。通过对实时处理的深入理解,读者将能够为后续章节中深入分析Storm和Hadoop等具体框架打下坚实的基础。

# 2. Storm框架深度剖析

## 2.1 Storm的基本概念和架构

### 2.1.1 Storm的流处理模型

Storm是一个开源的、分布式的、容错的实时计算系统。Storm的流处理模型与传统的批处理模型截然不同,它将数据处理为无止境的流,并且实时地处理这些流。在Storm中,数据不是存储起来等待批处理,而是一旦生成,就被立即处理并发送到下一个处理节点。

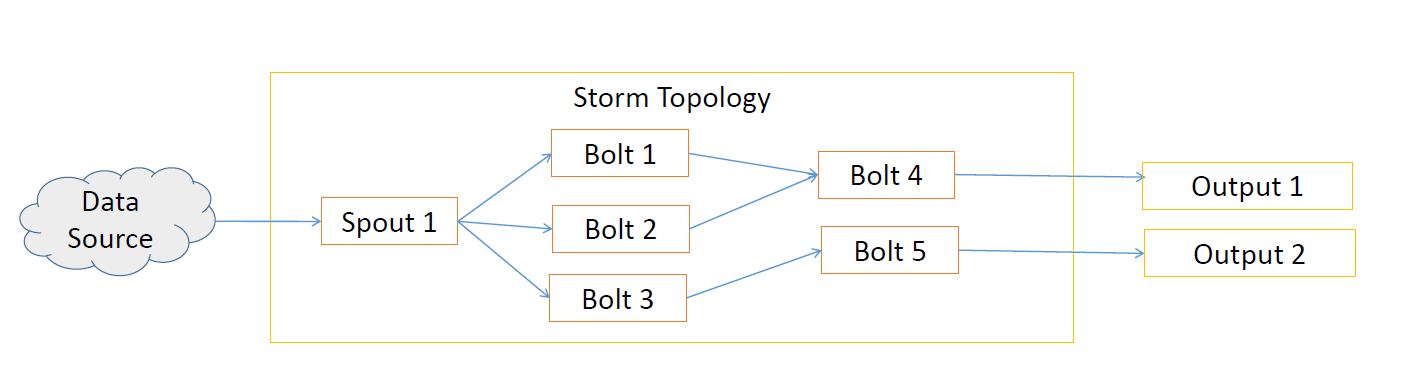

流处理模型的核心组件是Spout和Bolt。Spout负责从数据源获取数据流并发出数据元组。数据元组可以是来自外部系统的消息,比如Kafka消息或Twitter API。Bolt负责接收来自Spout或其他Bolt的输入元组,执行数据处理(如过滤、聚合、连接等),然后输出处理后的数据元组。

为了更好地理解Storm的流处理模型,我们来看一个简单的例子:实时单词计数。在这个场景中,Spout从消息队列中读取句子,然后Bolt将句子拆分成单词,并计算每个单词出现的次数。每当一个新句子到达时,单词计数就会实时更新。

```java

// 示例:一个简单的Spout

Spout spout = new SentenceSpout();

// 示例:一个简单的Bolt,用于单词计数

Bolt bolt = new WordCountBolt();

// 构建拓扑

TopologyBuilder builder = new TopologyBuilder();

builder.setSpout("sentence", spout);

builder.setBolt("count", bolt).shuffleGrouping("sentence");

// 提交拓扑到Storm集群

StormSubmitter.submitTopology("word-count", conf, builder.createTopology());

```

在这个例子中,`SentenceSpout`将不断读取新的句子,并通过Storm提供的接口将它们作为元组发送到拓扑中。`WordCountBolt`则接收句子元组,进行拆分和计数,并输出单词计数的结果。

### 2.1.2 Storm的主要组件解析

Storm的架构由多个主要组件构成,它们协作完成流处理的任务。核心组件包括:

- **Nimbus**: 负责资源分配和任务调度。它类似于Hadoop的JobTracker,但比JobTracker轻量级得多,它运行在主节点上。

- **Supervisor**: 每个工作节点上运行的守护进程,负责监听分配给它的任务,并启动或终止工作进程。

- **Zookeeper**: 虽然不是Storm的核心组件,但却是Storm协调和状态管理的必要组件。Zookeeper用于存储集群的状态信息,并作为Nimbus和Supervisor之间的通信中介。

- **Topology**: Storm中的计算图,由Spout和Bolt构成的网络图。它是一个实时的、持续运行的数据处理流程。

- **Task**: 在Topology中,Spouts和Bolts中的每一个实例化对象被称为一个Task。一个Spout或Bolt的实例可能包含多个Task。

从这些组件中,我们可以看到Storm是如何在集群中分布和管理任务的。Nimbus通过Zookeeper分发任务给Supervisor,Supervisor再根据任务类型创建Spout或Bolt的Task来处理数据。这种动态的分布式计算模式使得Storm非常灵活和可扩展。

```java

// 示例:在Nimbus端定义并提交一个拓扑

public class WordCountTopology {

public static void main(String[] args) throws Exception {

// 定义Topology

TopologyBuilder builder = new TopologyBuilder();

builder.setSpout("word-reader", new RandomSentenceSpout(), 5);

builder.setBolt("split-bolt", new SplitSentenceBolt(), 8)

.setNumTasks(8).shuffleGrouping("word-reader");

builder.setBolt("count-bolt", new WordCountBolt(), 12)

.setNumTasks(12).fieldsGrouping("split-bolt", new Fields("word"));

// 提交拓扑

Config config = new Config();

StormSubmitter.submitTopology("word-count", config, builder.createTopology());

}

}

```

在这个代码片段中,我们定义了一个WordCountTopology类,其中设置了一个Spout和两个Bolts,并且指定了它们的并行度和任务组。这样的定义可以让Storm有效地在集群上分布计算资源。

## 2.2 Storm的关键特性和优势

### 2.2.1 高容错性和分布式处理

Storm通过其分布式的设计,确保了高容错性。Storm保证了每个元组至少被完全处理一次,即使在一些节点失败的情况下。容错主要通过以下机制实现:

- **消息确认机制**: Storm的Spout和Bolt之间有消息确认机制。Spout只有在收到Bolt的确认消息后,才会认为该消息已经被成功处理。

- **消息重发**: 当一个Task失败时,Nimbus会重新调度这个Task到其他的Supervisor上,并重新发送该消息给新的Task实例。

- **状态备份**: Storm利用Zookeeper来备份重要的状态信息,包括正在运行的拓扑和节点的配置信息。

```java

// 示例:配置Spout以启用消息确认和故障处理

SentenceSpout spout = new SentenceSpout();

spout.setNumTasks(5);

// 启用消息确认

spout.setShouldAck(true);

// 启用失败处理

spout.setFailWhenDisabled(false);

TopologyBuilder builder = new TopologyBuilder();

// 其余拓扑构建代码省略...

```

在上述代码示例中,我们为一个Spout启用了消息确认和故障处理。这意味着即使在Task失败的情况下,消息也不会丢失,并且Spout可以自动处理这些失败的情况。

### 2.2.2 支持多种编程语言

Storm从一开始就被设计成可以支持多种编程语言。尽管它原生支持Java,但Storm社区也为其提供了对Clojure、Python、Ruby甚至C#的支持。这种多语言支持,为开发者提供了选择的灵活性,并且可以利用每种语言的特长来编写拓扑。

- **Clojure**: Clojure通过Storm的CLI接口与Storm集群进行交互,能够以声明式的方式定义拓扑。

- **Python**: 使用Python编写的Storm组件需要借助py4j库来实现与Java的桥接。

- **Ruby**: Rubystorm是一个为Ruby开发者提供的Storm接口。

- **C#**: 通过Thrift协议的转译,C#开发者可以通过语言绑定与Storm集群交互。

在实际开发中,由于语言特性和生态的差异,Java和Clojure是最常见的选择。Java因其性能和稳定性被广泛使用,而Clojure则因其简洁的语法和强大的并发处理能力被数据科学领域的开发者所青睐。

### 2.2.3 可扩展性和水平扩展能力

Storm的设计哲学是易于扩展。它允许开发者动态地增加或减少处理资源,而无需停止正在运行的拓扑。这种扩展性对于处理不确定的、高并发的实时数据流至关重要。Storm通过以下方式支持水平扩展:

- **增加Spouts/Bolts的并行度**: 开发者可以根据需要动态地增加Spout或Bolt的并行度来提高处理能力。

- **动态资源分配**: Storm可以动态地在集群中分配和回收资源,以适应不同的负载需求。

- **灵活的任务调度**: Storm允许运行时任务调度,可以根据任务的执行情况和集群状态进行优化。

```java

// 示例:动态调整拓扑的并行度

// 假设我们有一个已运行的拓扑名为"my-topology"

StormSubmitter.updateTopology("my-topology", conf, topology);

```

在这个例子中,我们通过调用`updateTopology`方法来动态调整拓扑配置。这允许我们在不中断服务的情况下,调整拓扑的资源分配和并行度。

## 2.3 Storm的实践案例分析

### 2.3.1 实时数据流分析

实时数据流分析是指对实时产生的数据流进行分析,并提取有价值信息的过程。在金融交易、社交网络、物联网等领域中,这样的实时数据流处理至关重要。

以一个股票交易分析系

0

0