【时间序列数据预处理】:关键技术和应用案例深度剖析

发布时间: 2024-09-07 18:34:08 阅读量: 181 订阅数: 56

cole_02_0507.pdf

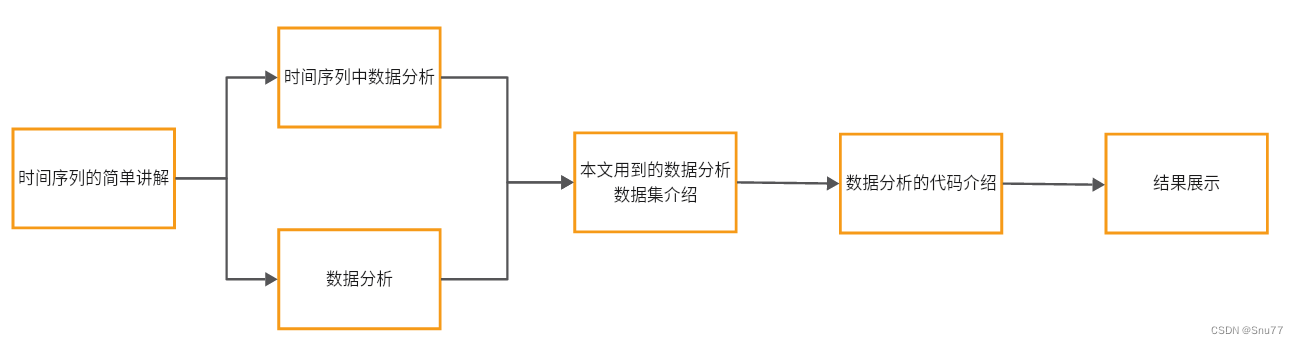

# 1. 时间序列数据预处理概述

时间序列数据预处理是数据分析中的关键步骤,它涉及从原始数据中消除噪声和错误,以便于后续的数据建模和分析。在处理时间序列数据时,我们不仅要关注数据本身的质量,还要理解数据所代表的现象。通过预处理,我们能确保数据的准确性和可比性,为后续分析提供坚实的基础。接下来的章节将深入探讨时间序列数据的理论基础、关键技术以及在不同领域的实际应用案例,使读者能够全面了解并掌握时间序列数据预处理的核心内容。

# 2. 时间序列数据的理论基础

时间序列数据作为预测分析的核心,其理论基础是构建有效模型的前提。本章将深入探讨时间序列数据的特点、类型、应用以及其统计特征,为后续的数据预处理技术和应用案例分析奠定坚实的理论基础。

## 2.1 时间序列数据的特点

时间序列数据是指按时间顺序排列的一系列数据点,这些数据点通常是每隔一定时间间隔记录的,如每秒、每天或每月等。了解时间序列数据的特点对于后续的数据分析和建模至关重要。

### 2.1.1 数据的时序性与频率

时序性是时间序列数据最重要的特征之一,它表示数据点是按照时间的顺序排列。时间的流逝是单向的,并且数据点之间通常存在时间间隔,我们称之为时间序列的频率。例如,股票价格通常是按照每分钟、每小时或每天记录的,而气候数据可能是按每月或每季度记录的。时间序列的频率直接影响到我们分析数据时可以使用的统计方法和模型的选择。

### 2.1.2 时间序列的平稳性与非平稳性

平稳性是时间序列分析中的另一个重要概念。平稳时间序列的特点是其统计特性,如均值、方差和自协方差等,不随时间的变化而改变。在实际情况中,很少有时间序列是完美平稳的,因此我们通常需要对数据进行转换以获得平稳性,这对于模型的构建尤为重要。

非平稳时间序列的数据特征随时间变化,常见的变化包括趋势和季节性。趋势是指数据的长期上升或下降走势,而季节性是指周期性的波动。非平稳时间序列可能需要通过差分、季节性分解或其他技术进行处理以满足模型要求。

## 2.2 时间序列数据的类型及应用

根据不同的标准,时间序列数据可以被分类为不同类型的序列,这些分类对于预处理方法的选择有着直接的影响。

### 2.2.1 按时间间隔分类

按时间间隔分类,时间序列可以分为高频数据、日度数据、月度数据和年度数据等。不同类型的数据适合不同的分析方法。例如,高频数据可能需要更复杂的去噪技术,而年度数据可能需要更多的关注季节性因素。

### 2.2.2 按数据性质分类

时间序列数据还可以根据其性质被分为以下几类:

- 流量数据:这类数据随时间的累积而增加,例如,累积的销售量或网站的访问量。

- 库存数据:这类数据描述了在特定时间点上的量,例如,银行账户中的余额。

- 替换数据:这类数据在更新时会重置,如每天的最高温度或最低温度。

不同的数据性质意味着数据可能具有不同的分布特征和模式,这将影响预处理和建模的过程。

## 2.3 时间序列数据的统计特征

时间序列数据的统计特征提供了对数据集本质的理解,是进行任何预测分析的必要步骤。

### 2.3.1 基本统计量的计算

基本统计量包括均值、中位数、众数、方差、标准差和偏度与峰度等。这些统计量可以帮助我们了解数据的集中趋势、离散程度和分布形态。例如,偏度反映了数据分布的对称性,而峰度则描述了数据分布的尖峭或扁平程度。

### 2.3.2 趋势、季节性和周期性分析

时间序列分析的三个主要成分是趋势、季节性和周期性。趋势指的是数据随时间的长期变化趋势,季节性是指按固定的时间间隔重复出现的周期性波动,而周期性则是指非固定时间间隔的周期性波动。识别和量化这些成分对于时间序列预测至关重要。

- 趋势分析通常涉及确定时间序列中的上升或下降趋势,并用线性或非线性模型来描述这些趋势。

- 季节性分析则需要识别数据中的周期性模式,并将其从非季节性成分中分离出来。

- 周期性分析则更为复杂,因为它涉及到识别不同长度周期的模式,并尝试解释其成因。

在进行趋势、季节性和周期性分析时,我们通常会用到如自回归移动平均模型(ARIMA)等经典的统计模型来提取并分析这些成分。

为了更好地展示本章内容的深度和连贯性,接下来将针对每个子章节提供更丰富的细节和分析,确保内容的丰富性和逻辑性,为读者提供实质性的理解和应用价值。

# 3. 时间序列数据预处理的关键技术

时间序列数据预处理是在进行实际分析和预测之前,保证数据质量的重要步骤。本章节将深入探讨时间序列数据预处理的关键技术,包括数据清洗、数据转换和数据重构技术。

## 3.1 数据清洗技术

数据清洗是预处理的基础,直接影响后续分析的质量。本节将重点介绍缺失值处理和异常值检测与处理。

### 3.1.1 缺失值处理

在时间序列数据中,由于各种原因可能会出现缺失值,包括设备故障、数据传输错误、记录缺失等。处理缺失值的方法有多种,比如删除含有缺失值的记录、填充缺失值(使用均值、中位数、众数或者基于预测模型的值填充)等。

**示例代码:**

```python

import pandas as pd

from sklearn.impute import SimpleImputer

# 假设df是一个时间序列数据集

imputer = SimpleImputer(missing_values=np.nan, strategy='mean')

df_imputed = pd.DataFrame(imputer.fit_transform(df), columns=df.columns)

```

**逻辑分析与参数说明:**

上述代码中,`SimpleImputer`类用于填充缺失值,其中`missing_values=np.nan`指定缺失值为NaN(Not a Number),`strategy='mean'`指定用均值填充缺失值。`fit_transform`方法先拟合数据,计算出均值,然后填充缺失值,并返回一个新的DataFrame对象`df_imputed`。

### 3.1.2 异常值检测与处理

异常值可能是由测量错误或数据录入错误引起的,也可能代表了数据的真实变异性。异常值的检测方法有基于统计的方法、基于模型的方法和基于聚类的方法等。

**示例代码:**

```python

# 使用IQR方法检测异常值

Q1 = df.quantile(0.25)

Q3 = df.quantile(0.75)

IQR = Q3 - Q1

df_filtered = df[~((df < (Q1 - 1.5 * IQR)) | (df > (Q3 + 1.5 * IQR))).any(axis=1)]

```

**逻辑分析与参数说明:**

在上述代码中,我们首先计算第一四分位数(Q1)和第三四分位数(Q3),然后计算四分位距(IQR)。使用IQR乘以1.5作为阈值来确定异常值的范围。`df_filtered`将包含所有非异常值的行。

## 3.2 数据转换技术

数据转换是将数据调整为适合分析的形式,通常包括规范化和去噪平滑等步骤。

### 3.2.1 数据规范化

数据规范化是将数据缩放到一个特定的范围,比如0到1之间,常用于多种算法处理,特别是那些对数据范围敏感的算法。

**示例代码:**

```python

from sklearn.preprocessing import MinMaxScaler

scaler = MinMaxScaler(feature_range=(0, 1))

df_normalized = pd.DataFrame(scaler.fit_transform(df), columns=df.colum

```

0

0