【处理数据不平衡】:预处理中的挑战与解决方法详述

发布时间: 2024-09-07 18:16:23 阅读量: 35 订阅数: 44

果壳处理器研究小组(Topic基于RISCV64果核处理器的卷积神经网络加速器研究)详细文档+全部资料+优秀项目+源码.zip

# 1. 数据不平衡问题概述

在机器学习和数据挖掘领域,数据不平衡是常见的问题之一,它指的是分类问题中不同类别的数据分布不均匀,常见于信用卡欺诈检测、疾病诊断等场景。不平衡数据会导致机器学习模型在分类时偏向多数类,造成少数类的识别率低下,最终影响模型的泛化能力和决策效果。

**数据不平衡带来的挑战**:

- **分类性能下降**:由于模型偏向于多数类,导致少数类的预测性能不佳。

- **决策困难**:在实际应用中,对少数类(如欺诈交易)的检测尤为关键,数据不平衡会使得这种检测变得困难。

接下来,我们将深入探讨数据不平衡对模型的具体影响,并介绍缓解这一问题的预处理技术和算法层面的解决方案。通过系统的分析与应用,我们可以有效地提高模型在不平衡数据集上的表现,进而提升模型的实用性和准确性。

# 2. 理解数据不平衡对模型的影响

数据不平衡是指在分类问题中,各类别的样本数量存在显著差异,这种差异可能来自数据采集偏差或数据本身的不均衡分布。不平衡的数据会导致机器学习模型的性能下降,影响其在现实世界中的应用效果。

### 数据不平衡现象的成因与分类

#### 数据采集偏差

数据采集偏差是指在收集数据时,由于样本选择、数据收集方法等因素导致的数据不均等现象。例如,在垃圾邮件过滤问题中,非垃圾邮件的数量通常远多于垃圾邮件,因为人们更倾向于正常通信,而不是发送垃圾邮件。

#### 数据本身的不均衡分布

数据本身的不均衡分布是由于问题固有的特性决定的。以信用卡欺诈检测为例,欺诈行为本身的发生频率就远低于正常交易,因此在数据集中,正常交易的样本量远大于欺诈交易。

### 数据不平衡对模型性能的影响

#### 分类准确率的误导

当数据集不平衡时,即使模型简单地将所有样本分类为多数类,也可能获得看似较高的准确率。例如,如果在一个数据集中,99%的样本都属于多数类,即使模型不做任何预测,它也能达到99%的准确率。这种情况下,分类准确率成为一个具有误导性的指标。

#### 模型泛化能力的下降

不平衡数据会导致模型偏向于多数类,从而忽略了少数类的重要性。模型在训练集上可能表现良好,但在面对新的、更为平衡的数据分布时,模型的泛化能力会显著下降。

在不平衡数据的影响下,模型可能会出现以下几种表现:

- **高偏度的模型决策边界**:模型会过度适应多数类,导致决策边界偏向多数类。

- **误分类少数类样本**:少数类样本可能被错误地分类为多数类。

- **过度敏感于多数类特征**:模型可能会过度拟合多数类的特征,而忽略少数类的特征。

为了更深入理解数据不平衡对模型性能的影响,需要在模型训练和评估过程中采用更为合适的策略。这包括但不限于使用适当的预处理技术来平衡数据集,使用成本敏感学习和集成学习方法来调整模型训练过程,以及使用更为精确的评估指标来衡量模型性能。接下来的章节将详细介绍这些方法和技术。

# 3. 预处理技术应对不平衡数据

不平衡数据是机器学习和数据分析中常见的问题,指的是在分类问题中各类样本的数量差异很大。这种情况可能导致机器学习模型在预测时偏向于数量较多的类别,从而影响模型的准确性。为了解决这个问题,研究人员提出了多种预处理技术,旨在平衡各类别样本的数量,使得模型能够更好地进行学习。

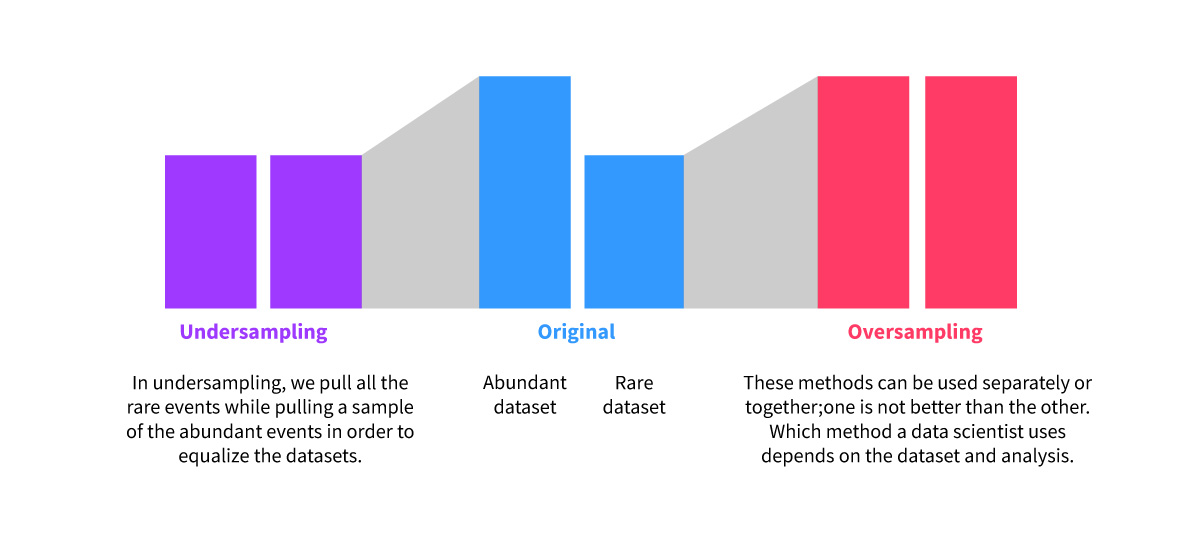

## 3.1 重采样技术

重采样技术是解决数据不平衡问题的一种基本方法。它涉及在训练过程中增加少数类的样本或减少多数类的样本,以此来平衡数据集。

### 3.1.1 过采样方法

过采样技术通过增加少数类别的样本数量来平衡数据集。其核心思想是使少数类别的样本数量接近多数类别的样本数量。最简单的过采样方法是对少数类别的样本进行随机重复,但这种方法可能会导致过拟合。

#### SMOTE算法

SMOTE(Synthetic Minority Over-sampling Technique)是一种流行的过采样算法,通过合成新的少数类样本而非简单重复已有样本。SMOTE算法的基本思想是在少数类的样本之间进行插值来生成新的样本。具体操作是在少数类样本中随机选取两个样本,然后在这两个样本之间线性插值生成新的样本。

```python

from imblearn.over_sampling import SMOTE

from sklearn.datasets import make_classification

from collections import Counter

import matplotlib.pyplot as plt

from sklearn.neighbors import NearestNeighbors

# 生成不平衡数据集

X, y = make_classification(n_classes=2, class_sep=2, weights=[0.1, 0.9], n_informative=3, n_redundant=1, flip_y=0, n_features=20, n_clusters_per_class=1, n_samples=1000, random_state=10)

# 进行过采样

sm = SMOTE(random_state=42)

X_sm, y_sm = sm.fit_resample(X, y)

# 绘制采样后的数据集

plt.figure(figsize=(10,6))

plt.scatter(X_sm[:,0], X_sm[:,1], c=y_sm)

plt.show()

print(Counter(y_sm))

```

该代码块首先创建了一个不平衡的数据集,然后应用SMOTE算法进行过采样,并绘制了结果。输出的数据点分布情况可以帮助我们了解SMOTE算法对数据集的影响。

### 3.1.2 欠采样方法

与过采样相对的是欠采样技术,通过减少多数类别的样本数量来平衡数据集。在某些情况下,由于资源有限或处理成本的考虑,可能更倾向于使用欠采样。

### 3.1.3 组合采样策略

在实践中,我们可以将过采样与欠采样结合使用,以期获得更好的平衡效果。组合采样策略可以针对不同情况进行调整,比如首先对少数类进行过采样,然后对多数类进行适当欠采样,以此来减少过拟合的风险。

## 3.2 合成数据生成方法

合成数据生成方法可以创建新的数据点,而不是仅仅复制现有数据。SMOTE是最著名的合成数据生成方法之一,但还有其他算法也在致力于解决不平衡数据的问题。

### 3.2.1 SMOTE算法原理

如前所述,SMOTE通过在少数类样本之间插值来生成新的样本点,从而增加少数类的样本量。

### 3.2.2 SMOTE变体及应用

除了基本的

0

0