【数据类型理解】:为数据预处理做好准备,不可忽视的五大关键点

发布时间: 2024-09-07 18:07:35 阅读量: 97 订阅数: 57

# 1. 数据预处理的重要性

数据预处理是数据科学项目成功的关键步骤之一,它确保了数据的质量和可靠性,从而直接影响后续分析和模型的准确性。在机器学习和统计分析中,数据往往存在不一致性、噪声、缺失值或异常值等问题。若不进行适当的预处理,这些问题将导致模型无法正确学习或过度拟合数据,降低模型的泛化能力。

数据预处理涉及数据清洗、数据转换、数据规约和数据离散化等步骤,每一步都是为了提高数据的可用性和效率。正确的数据预处理不仅能改进模型性能,还能节省资源,例如减少训练时间,甚至可能揭示数据中的新见解。例如,通过数据标准化和规范化,可以将数据转换到一个统一的尺度上,使不同量级和量纲的特征可以相互比较和组合,为机器学习算法提供平等的输入基础。

数据预处理的重要性不容忽视,它为数据分析的后续步骤铺平了道路,为探索数据背后的故事提供了可靠的平台。理解并掌握数据预处理的方法和技巧,对于每一个数据从业者来说,都是必不可少的基本功。

# 2. 数据类型的基本概念

### 2.1 数值型数据的理解

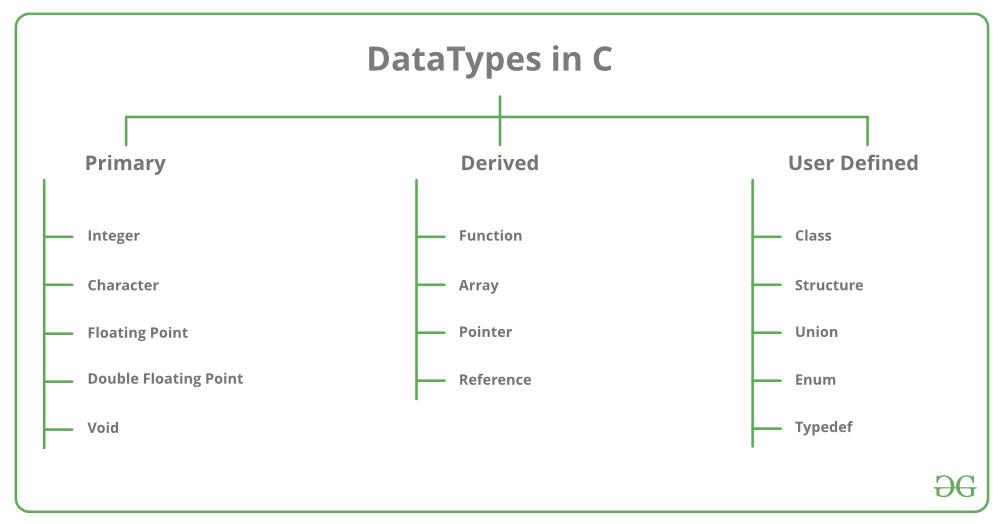

#### 2.1.1 整型与浮点型的区别

在数据分析和机器学习中,数值型数据是最常见的一类数据类型,其主要分为整型和浮点型。

整型数据表示整数,通常用于计数。例如,在数据库中记录员工数量、产品数量等。在Python中,整型数据可以通过int()函数创建。

浮点型数据表示带小数点的数,用于表示有小数的数值。例如,在计算物理问题的数值解时,结果往往会是浮点型。在Python中,浮点型数据可以通过float()函数创建。

需要注意的是,虽然整型和浮点型都属于数值型数据,但在内存中的存储方式和范围是不同的。浮点型由于要存储小数部分,因此其所能表示的数值范围比整型大。然而,浮点型数据也有其局限,例如由于计算机采用二进制表示浮点数,因此无法精确表示某些十进制小数。

#### 2.1.2 数值型数据的表示和范围

数值型数据在计算机中的表示遵循特定的标准,如Python中的int类型和float类型。下面,让我们详细解读这两种类型在Python中的表示和范围。

- `int`类型:Python中的`int`类型没有固定的大小限制,能够根据实际需要自动扩展。这意味着`int`类型的数值范围只受限于计算机内存的大小。

- `float`类型:Python中的`float`类型通常遵循IEEE 754标准的双精度浮点数。它由符号位、指数位和尾数位组成,能够表示极大的范围的数,但同样也受到精度的限制。例如,有些十进制小数无法被精确表示,例如0.1在转换为二进制浮点数时只能得到一个近似值。

在具体应用中,选择适当的数据类型是十分关键的。例如,如果数据集中大部分数值都在一个较小的范围内,使用整型可以提高存储效率和计算速度。反之,如果数据集包括非常大或非常小的数值,甚至小数点后有很多位数,那么浮点型将更加适用。

### 2.2 分类数据的处理

#### 2.2.1 名义型数据的编码方式

分类数据是另一种常见的数据类型,包括名义型数据和有序型数据。名义型数据是没有顺序关系的类别数据,例如性别、民族等。为了能在数据处理和模型训练中使用这些数据,我们需要将它们编码为数值型数据。

名义型数据的编码方式有多种,最简单的是标签编码(Label Encoding),即将每个类别映射为一个唯一的整数。例如,在性别数据中,可以将“男”编码为1,“女”编码为0。另一种常用的方法是独热编码(One-Hot Encoding),它为每个类别创建一个新变量,并使用二进制形式表示每个类别的存在与否。独热编码可以解决标签编码可能带来的顺序问题,例如将“高级”、“中级”、“初级”编码为0、1、2,这可能会给模型带来不必要的顺序信息。

下面是Python中的一个独热编码示例代码:

```python

import pandas as pd

from sklearn.preprocessing import OneHotEncoder

# 示例数据集

data = {'category': ['A', 'B', 'C', 'A', 'B']}

df = pd.DataFrame(data)

# 创建独热编码器

encoder = OneHotEncoder(sparse=False)

# 对category列进行独热编码

category_encoded = encoder.fit_transform(df[['category']])

# 转换为DataFrame格式查看结果

category_encoded_df = pd.DataFrame(category_encoded, columns=encoder.get_feature_names(['category']))

```

输出结果是:

```

category_A category_B category_C

***.***.***.*

***.***.***.*

***.***.***.*

***.***.***.*

***.***.***.*

```

#### 2.2.2 有序型数据的处理技巧

与名义型数据不同,有序型数据(Ordinal Data)表示的是具有自然排序顺序的类别。例如教育程度中的“小学”、“中学”、“高中”、“大学”、“研究生”等,它们之间具有明确的大小关系。在处理有序型数据时,保留这种顺序信息是至关重要的。

一种处理有序型数据的常见方法是使用标签编码,并且由于类别之间具有顺序,这样做不会引入额外的不相关的信息。例如,教育程度可以编码为1到5,以此来反映其在有序序列中的位置。

在编码后,有序型数据可以被用于大多数数值型数据的处理和模型训练中。不过在某些特定场景下,如决策树或梯度提升模型,原始的类别形式可能更为合适,因为这些模型可以很好地处理类别特征。

总之,对于有序型数据,关键是在编码时保持类别之间的顺序关系,同时要根据使用的模型和算法选择最合适的编码方法。在实践中,我们可能还需要对数据进行规范化或标准化等预处理步骤,以进一步优化模型的性能。

### 2.3 时间序列数据的特性

#### 2.3.1 时间戳的转换和处理

时间序列数据在数据分析和预测中扮演着重要角色。时间戳是时间序列数据中的一个基本元素,它通常表示一个具体的时间点。在数据预处理阶段,将时间戳转换为可分析的格式是关键步骤之一。

时间戳的转换和处理依赖于具体应用场景。一般来说,时间戳可以转换为年、月、日、时、分、秒等更易处理的形式。例如,在Python中,可以使用pandas库中的`to_datetime`函数来实现时间戳的转换。

```python

import pandas as pd

# 假设我们有一个时间序列数据集

data = ['2023-01-01', '2023-01-02', '2023-01-03']

series = pd.to_datetime(data)

# 将时间序列转换为更详细的格式

series = series.strftime('%Y-%m-%d %H:%M:%S')

```

处理时间戳的一个常见需求是时间差的计算,例如计算相邻两个时间点之间的间隔。Pandas库提供了`diff`函数,可以用来计算时间序列中两个连续时间点的时间差。

时间戳转换不仅仅是格式的转换,更重要的是通过这些转换,我们可以提取出对分析有用的时间信息,如时间周期性特征。利用这些特征,可以帮助我们更好地理解数据的季节性规律或趋势,这对于后续的分析和预测至关重要。

#### 2.3.2 时间周期性数据的分析

时间序列数据经常展现出周期性的特征,这通常与时间段(如星期几、哪个月份等)有关。分析这些周期性数据可以帮助我们发现潜在的模式和趋势,从而提高预测的准确性。

周期性分析的第一步是识别周期性特征,例如,一周内的每日销售数据可能会显示出工作日和周末的模式。为了捕捉这种模式,我们可以引入时间周期性的特征向量。

在Python中,可以利用pandas库中的周期性功能(如`resample`和`groupby`)来帮助我们从时间序列数据中提取周期性特征。

```python

import pandas as pd

# 假设我们有一个按小时记录的数据集

data = pd.read_csv('hourly_data.csv')

# 将数据集按小时转换为日数据

daily_data = data.resample('D', on='timestamp_column').sum()

```

通过这种转换,我们可以分析每日的总销售额,并将其与日周期性模式相关联。例如,我们可能会发现销售量在周末比工作日高,或者特定

0

0