深度学习实战:神经网络、卷积神经网络与自然语言处理,掌握3大深度学习技术

发布时间: 2024-08-12 04:06:55 阅读量: 33 订阅数: 25

# 1. 深度学习基础

深度学习是一种机器学习技术,它使用多层神经网络来学习数据中的复杂模式。与传统机器学习方法不同,深度学习模型不需要手动特征工程,而是从数据中自动学习特征。

深度学习模型通常由以下组件组成:

- **人工神经元:**神经网络的基本单元,它接收输入,应用激活函数,并产生输出。

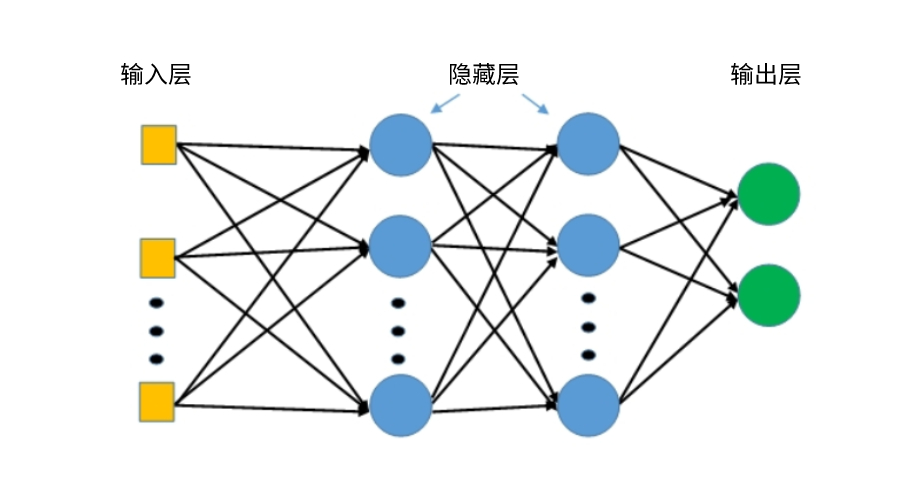

- **网络结构:**神经元按层组织,形成输入层、隐藏层和输出层。隐藏层允许模型学习复杂特征。

# 2. 神经网络

### 2.1 神经网络的基本原理

#### 2.1.1 人工神经元

人工神经元是神经网络的基本单元,它模拟了生物神经元的行为。它接收一组输入信号,并通过一个非线性激活函数产生一个输出信号。

```python

import numpy as np

class Neuron:

def __init__(self, weights, bias):

self.weights = weights

self.bias = bias

def forward(self, inputs):

# 计算加权和

weighted_sum = np.dot(self.weights, inputs) + self.bias

# 应用激活函数

output = self.activation_function(weighted_sum)

return output

def activation_function(self, x):

# 使用 ReLU 激活函数

return np.maximum(0, x)

```

**参数说明:**

* `weights`: 神经元的权重,是一个数组

* `bias`: 神经元的偏置,是一个标量

* `inputs`: 神经元的输入,是一个数组

**代码逻辑分析:**

* `forward` 方法计算加权和,并应用激活函数产生输出。

* `activation_function` 方法使用 ReLU 激活函数,它将输入小于 0 的部分设置为 0。

#### 2.1.2 网络结构

神经网络由多层神经元组成,这些神经元以特定方式连接。最常见的网络结构是前馈神经网络,其中信息从输入层流向输出层,中间没有循环。

```python

class NeuralNetwork:

def __init__(self, layers):

self.layers = layers

def forward(self, inputs):

# 逐层传播输入

for layer in self.layers:

inputs = layer.forward(inputs)

return inputs

```

**参数说明:**

* `layers`: 神经网络的层列表,每个层都是一个 `Neuron` 对象

**代码逻辑分析:**

* `forward` 方法逐层传播输入,调用每层的 `forward` 方法。

### 2.2 神经网络的训练与优化

#### 2.2.1 损失函数和优化算法

训练神经网络需要一个损失函数来衡量模型的性能。常用的损失函数包括均方误差和交叉熵。优化算法用于最小化损失函数,从而调整网络的权重和偏置。常见的优化算法包括梯度下降和动量法。

```python

import tensorflow as tf

# 定义损失函数

loss_function = tf.keras.losses.MeanSquaredError()

# 定义优化算法

optimizer = tf.keras.optimizers.SGD(learning_rate=0.01)

```

**参数说明:**

* `loss_function`: 损失函数,是一个 `tf.keras.losses` 对象

* `optimizer`: 优化算法,是一个 `tf.keras.optimizers` 对象

* `learning_rate`: 学习率,控制权重更新的步长

**

0

0