OpenCV情绪识别实战:构建自己的情绪识别系统,解决5大难题

发布时间: 2024-08-12 03:24:45 阅读量: 161 订阅数: 25

# 1. 情绪识别概述和OpenCV简介

**1.1 情绪识别的重要性**

情绪识别是理解人类情感和行为的关键。它在人际交往、客户服务和医疗保健等领域有着广泛的应用。

**1.2 OpenCV简介**

OpenCV(Open Source Computer Vision Library)是一个开源计算机视觉库,提供了丰富的图像处理和机器学习算法。它广泛用于情绪识别等计算机视觉应用中。

# 2. OpenCV情绪识别理论基础

### 2.1 情绪识别模型和算法

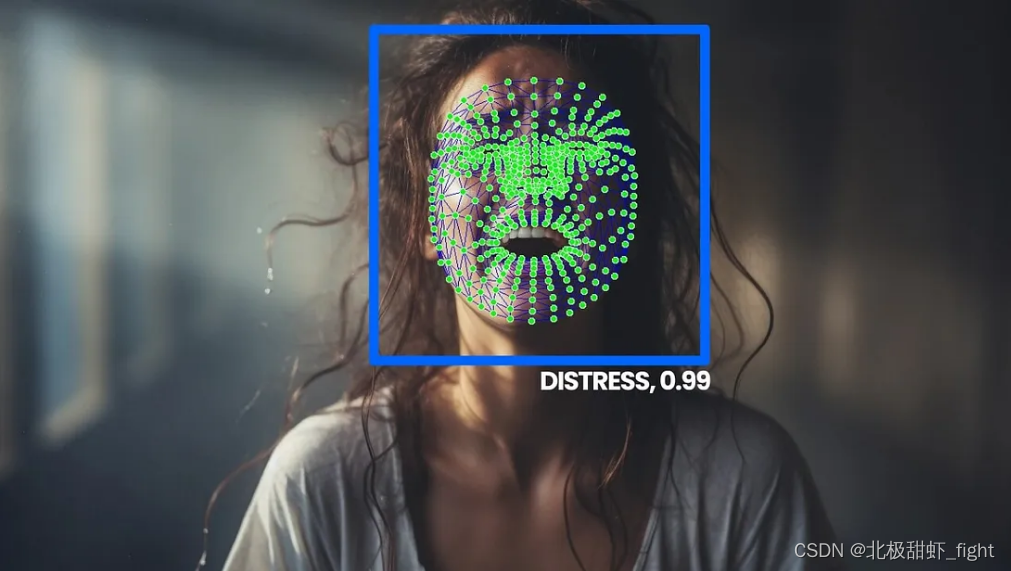

#### 2.1.1 面部表情识别

**模型:**

* **主动形状模型(ASM):**通过搜索图像中与预定义面部模型相匹配的特征点来定位面部。

* **局部二值模式(LBP):**将图像划分为小块,计算每个块中像素的二进制模式,形成特征向量。

* **深度卷积神经网络(CNN):**使用卷积层和池化层提取面部特征,并通过全连接层进行分类。

**算法:**

* **Viola-Jones算法:**使用Haar级联分类器检测面部,通过一系列特征筛选器逐级排除非面部区域。

* **AdaBoost算法:**通过加权训练多个弱分类器,生成一个强分类器,用于面部表情识别。

* **支持向量机(SVM):**将面部特征映射到高维空间,并通过超平面进行分类。

#### 2.1.2 语音语调识别

**模型:**

* **隐马尔可夫模型(HMM):**假设语音信号是一个由隐状态序列生成的观测序列,通过训练确定隐状态的转移概率和观测概率。

* **高斯混合模型(GMM):**将语音信号建模为多个高斯分布的混合,每个分布对应一种音素。

* **深度神经网络(DNN):**使用多层神经网络提取语音特征,并通过全连接层进行分类。

**算法:**

* **梅尔频率倒谱系数(MFCC):**将语音信号转换为梅尔频率谱,并提取倒谱系数,作为语音特征。

* **动态时间规整(DTW):**将两个语音序列的时间轴进行非线性对齐,计算其相似度。

* **条件随机场(CRF):**将语音序列建模为一个图结构,通过条件概率分布预测每个音素的标签。

### 2.2 OpenCV图像处理技术

#### 2.2.1 图像预处理

**步骤:**

* **灰度转换:**将彩色图像转换为灰度图像,减少计算量。

* **图像平滑:**使用高斯滤波器或中值滤波器去除图像噪声。

* **直方图均衡化:**增强图像对比度,改善特征提取效果。

**代码块:**

```python

import cv2

# 灰度转换

gray_image = cv2.cvtColor(image, cv2.COLOR_BGR2GRAY)

# 高斯滤波

blurred_image = cv2.GaussianBlur(gray_image, (5, 5), 0)

# 直方图均衡化

equ_image = cv2.equalizeHist(blurred_image)

```

**逻辑分析:**

* `cv2.cvtColor()`函数将图像从BGR(蓝色、绿色、红色)空间转换为灰度空间。

* `cv2.GaussianBlur()`函数使用高斯核对图像进行卷积,平滑图像。

* `cv2.equalizeHist()`函数重新分布图像的像素值,增强对比度。

#### 2.2.2 特征提取

**方法:**

* **主成分分析(PCA):**将高维特征投影到低维空间,保留主要信息。

* **线性判别分析(LDA):**将特征投影到一个新的空间,最大化类间差异。

* **局部二值模式(LBP):**计算图像中每个像素及其周围像素的二进制模式,形成特征向量。

**代码块:**

```python

import cv2

# PCA特征提取

pca = cv2.PCA(data, maxComponents=10)

pca_features = pca.project(data)

# LDA特征提取

lda = cv2.LDA(data, labels)

lda_features = lda.project(data)

# LBP特征提取

lbp = cv2.xfeatures2d.LBP(radius=1, npoints=8, mapping=cv2.xfeatures2d.LBP_MAPPING_DEFAULT)

lbp_features = lbp.compute(image)

```

**逻辑分析:**

* `cv2.PCA()`函数将数据投影到一个由主成分定义的低维空间。

* `cv2.LDA()`函数将数据投影到一个由类标签定义的低维空间。

* `cv2.xfeatures2d.LBP()`函数计算图像中每个像素的LBP模式,形成特征向量。

#### 2.2.3 分类器训练

**算法:**

* **支持向量机(SVM):**将特征映射到高维空间,并通过超平面进行分类。

* **决策树:**通过递归地分割特征空间,构建一个树形结构,对数据进行分类。

* **随机森林:**通过训练多个决策树,并对它们的预测结果进行投票,提高分类准确性。

**代码块:**

```python

import cv2

# SVM分类器训练

svm = cv2.ml.SVM_create()

svm.train(train_features, cv2.ml.ROW_SAMPLE, train_labels)

# 决策树分类器训练

dt = cv2.ml.DecisionTree_create()

dt.train(train_features, cv2.ml.ROW_SAMPLE, train_labels)

# 随机森林分类器训练

rf = cv2.ml.RTrees_create()

rf.train(train_features, cv2.ml.ROW_SAMPLE, train_labels)

```

**逻辑分析:**

* `cv2.ml.SVM_create()`函数创建了一个SVM分类器对象。

* `cv2.ml.DecisionTree_create()`函数创建了一个决策树分类器对象。

* `cv2.ml.RTrees_create()`函数创建了一个随机森林分类器对象。

# 3.1 人脸检测与表情识别

人脸检测与表情识别是情绪识别中至关重要的步骤,OpenCV提供了多种方法来实现这些功能。

#### 3.1.1 Haar级联分类器

Haar级联分类器是一种基于Haar特征的机器学习算法,用于检测图像中的特定对象。它通过训练一个分类器来识别图像中特定模式,从而检测目标对象。在人脸检测中,Haar级联分类器可以检测人脸的特征,例如眼睛、鼻子和嘴巴,并将其与背景区分开来。

```python

import cv2

# 加载Haar级联分类器

face_cascade = cv2.CascadeClassifier('haarcascade_frontalface_default.xml')

# 读取图像

image = cv2.imread('image.jpg')

# 转换为灰度图像

gray = cv2.cvtColor(image, cv2.COLOR_BGR2GRAY)

# 检测人脸

faces = face_cascade.detectMultiScale(gray, 1.1, 4)

# 绘制人脸边界框

for (x, y, w, h) in faces:

cv2.rectangle(image, (x, y), (x+w, y+h), (0, 255, 0), 2)

# 显示图像

cv2.imshow('Faces', image)

cv2.waitKey(0)

cv2.destroyAllWindows()

```

**代码逻辑分析:**

1. 加载Haar级联分类器,用于检测人脸。

2. 读取图像并转换为灰度图像,以提高检测准确性。

3. 使用Haar级联分类器检测人脸,返回边界框坐标。

4. 在原图像上绘制人脸边界框。

5. 显示检测结果。

**参数说明:**

* `face_cascade`: Haar级联分类器对象。

* `image`: 输入图像。

* `gray`: 灰度图像。

* `faces`: 检测到的人脸边界框坐标列表。

* `(x, y, w, h)`: 人脸边界框的左上角坐标和宽高。

#### 3.1.2 深度学习模型

深度学习模型,如卷积神经网络(CNN),在人脸检测和表情识别方面取得了显著的进步。这些模型能够学习图像中的复杂模式,并识别细微的差异。

```python

import cv2

import tensorflow as tf

# 加载预训练的深度学习模型

model = tf.keras.models.load_model('emotion_recognition_model.h5')

# 读取图像

image = cv2.imread('image.jpg')

# 预处理图像

image = cv2.resize(image, (48, 48))

image = image.astype('float32') / 255.0

# 预测表情

prediction = model.predict(np.expand_dims(image, axis=0))

# 获取表情标签

emotion_label = ['Angry', 'Disgust', 'Fear', 'Happy', 'Neutral', 'Sad', 'Surprise']

emotion = emotion_label[np.argmax(prediction)]

# 显示结果

print('Predicted emotion:', emotion)

```

**代码逻辑分析:**

1. 加载预训练的深度学习模型。

2. 读取图像并预处理,包括调整大小和归一化。

3. 使用模型预测图像中的表情。

4. 获取预测的表情标签。

5. 显示预测结果。

**参数说明:**

* `model`: 预训练的深度学习模型。

* `image`: 输入图像。

* `prediction`: 模型预测结果。

* `emotion_label`: 表情标签列表。

* `emotion`: 预测的表情标签。

# 4. OpenCV情绪识别系统构建

### 4.1 系统架构设计

#### 4.1.1 数据采集与预处理

**数据采集**

* **人脸表情数据:**从人脸表情数据集(如FER-2013)中收集人脸图像,包含不同表情类别。

* **语音语调数据:**从语音语调数据集(如RAVDESS)中收集语音样本,包含不同情绪类别。

**数据预处理**

* **人脸表情数据:**

* 调整图像大小和灰度化

* 裁剪人脸区域并对齐

* 应用面部特征点检测器进行特征提取

* **语音语调数据:**

* 提取声学特征,如梅尔频率倒谱系数(MFCC)和零交叉率(ZCR)

* 对音频进行分段并提取每个分段的特征

### 4.1.2 模型训练与评估

**模型训练**

* **人脸表情识别:**使用卷积神经网络(CNN)或支持向量机(SVM)等分类器训练模型。

* **语音语调识别:**使用高斯混合模型(GMM)或隐马尔可夫模型(HMM)等分类器训练模型。

**模型评估**

* **人脸表情识别:**使用准确率、召回率、F1分数等指标评估模型性能。

* **语音语调识别:**使用准确率、混淆矩阵等指标评估模型性能。

### 4.2 系统实现与部署

#### 4.2.1 OpenCV库集成

* 集成OpenCV库,提供图像处理、特征提取和分类功能。

* **代码块:**

```python

import cv2

# 加载预训练的人脸表情识别模型

model = cv2.face.LBPHFaceRecognizer_create()

model.read("model.xml")

# 加载人脸图像

image = cv2.imread("face.jpg")

# 预测表情

prediction = model.predict(image)

```

**逻辑分析:**

此代码块使用OpenCV库加载预训练的人脸表情识别模型,加载人脸图像,并使用模型预测图像中的人脸表情。

#### 4.2.2 Web服务部署

* **架构:**

* **客户端:**Web应用程序或移动应用程序,负责收集用户数据并发送到服务器。

* **服务器:**运行OpenCV情绪识别系统的服务器,负责处理数据、进行预测并返回结果。

* **部署:**

* 使用Flask或Django等Web框架部署服务器。

* 配置服务器以处理客户端请求并返回响应。

# 5.1 数据集获取与标注

### 5.1.1 数据集收集

构建一个高质量的情绪识别数据集对于训练准确可靠的模型至关重要。以下是一些常用的数据集收集方法:

- **公开数据集:** Kaggle、Google AI Platform 等平台提供各种情绪识别数据集,涵盖不同的人口统计数据、表情和语音样本。

- **定制数据集:** 根据特定应用场景和目标人群收集定制数据集,以确保数据的相关性和代表性。

- **网络爬取:** 从社交媒体、视频共享平台和在线论坛等来源爬取数据,但需要注意版权和隐私问题。

### 5.1.2 数据标注方法

数据标注是将情绪标签分配给数据集中的样本的过程。常见的标注方法包括:

- **手动标注:** 人工标注员根据预定义的标签对数据进行标注,确保准确性,但成本较高。

- **半自动标注:** 利用机器学习算法对数据进行预标注,然后由人工标注员进行验证和纠正,提高效率。

- **主动学习:** 模型在训练过程中选择最不确定的样本进行标注,有效利用标注资源。

## 5.2 模型选择与优化

### 5.2.1 模型选择原则

选择合适的模型对于情绪识别系统的性能至关重要。以下是一些模型选择原则:

- **任务类型:** 考虑情绪识别的具体任务,如面部表情识别、语音语调分析等,选择针对特定任务设计的模型。

- **数据特征:** 分析数据集的特征,如图像分辨率、语音长度等,选择与数据特征相匹配的模型。

- **计算资源:** 考虑模型的计算复杂度和可用资源,选择在给定资源限制下性能最佳的模型。

### 5.2.2 超参数调优

超参数调优是调整模型的超参数(如学习率、正则化系数等)以优化性能的过程。以下是一些常用的超参数调优方法:

- **网格搜索:** 在预定义的超参数范围内进行穷举搜索,找到最佳组合。

- **贝叶斯优化:** 利用贝叶斯统计方法探索超参数空间,高效找到最优值。

- **进化算法:** 使用进化算法(如遗传算法)模拟自然选择,优化超参数。

# 6. OpenCV情绪识别系统应用场景与展望

OpenCV情绪识别系统在实际应用中具有广泛的场景,并有着广阔的发展前景。

### 6.1 人机交互优化

**6.1.1 情绪化虚拟助手**

OpenCV情绪识别系统可以集成到虚拟助手应用程序中,为用户提供更个性化和情感化的交互体验。虚拟助手可以通过识别用户的实时情绪,调整其响应和建议,从而提高用户满意度和参与度。

**6.1.2 智能家居控制**

OpenCV情绪识别系统还可以用于智能家居控制。通过识别用户的实时情绪,智能家居设备可以自动调整灯光、温度和音乐等设置,营造更舒适和宜人的环境。

### 6.2 市场前景与发展趋势

**6.2.1 行业应用**

OpenCV情绪识别系统在医疗保健、教育、零售和客户服务等行业具有广泛的应用前景。在医疗保健领域,它可以帮助诊断心理健康状况和改善患者治疗。在教育领域,它可以用于个性化教学和评估学生的情绪状态。在零售领域,它可以用于优化客户体验和提高销售转化率。在客户服务领域,它可以帮助座席人员识别和应对客户的情绪,提高客户满意度。

**6.2.2 技术创新**

OpenCV情绪识别系统仍处于快速发展阶段,不断有新的技术创新涌现。例如,深度学习模型的进步提高了情绪识别精度,而边缘计算技术的兴起使实时情绪识别成为可能。未来,随着人工智能和计算机视觉技术的不断发展,OpenCV情绪识别系统将变得更加强大和广泛适用。

0

0