Python DB库批量操作:数据处理速度提升的绝招

发布时间: 2024-10-17 18:24:21 阅读量: 31 订阅数: 27

Python数据分析与应用:从数据获取到可视化

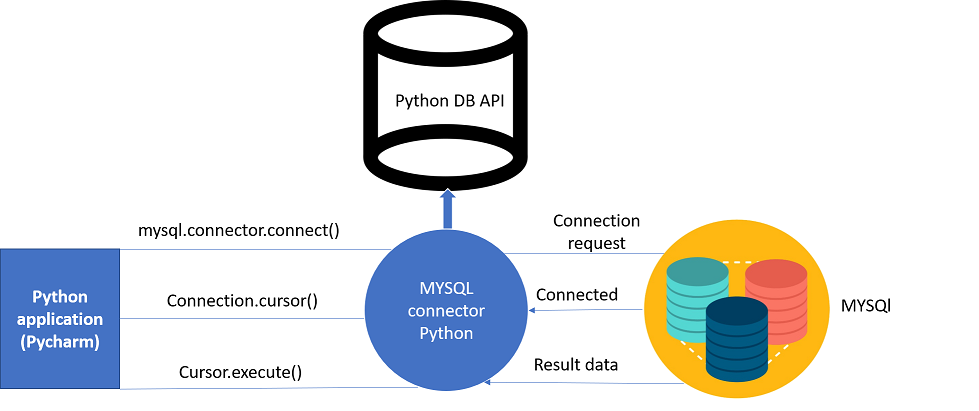

# 1. 数据库操作与Python DB库

数据库是现代IT应用中不可或缺的组成部分,它负责存储、管理以及检索数据,是许多应用程序背后的强大后盾。Python DB库,作为Python编程语言与数据库交互的一个桥梁,提供了丰富的数据库操作接口,使得开发者能够高效地执行SQL语句、管理数据库连接以及处理查询结果集。

在这一章中,我们将介绍Python DB库的基本使用方法,包括如何进行基本的数据库连接、执行查询以及处理结果集。我们将通过实例代码,逐步了解如何使用Python DB库来进行基础的增删改查(CRUD)操作,以此为后续深入探讨批量操作打好基础。这将帮助您在日常的数据库交互中,实现高效且稳定的数据处理流程。

## 1.1 连接数据库

建立数据库连接是使用Python DB库进行数据库操作的第一步。以Python DB库之一的`sqlite3`为例,我们可以使用如下代码建立到SQLite数据库的连接:

```python

import sqlite3

conn = sqlite3.connect('example.db')

```

这段代码首先导入`sqlite3`模块,然后通过`connect`方法打开一个名为`example.db`的SQLite数据库文件,并将数据库连接对象赋值给`conn`变量。

## 1.2 执行SQL语句

连接数据库之后,我们可以使用`cursor`对象来执行SQL语句。以下是一个执行SQL查询的示例:

```python

c = conn.cursor()

c.execute("SELECT * FROM users WHERE age > ?", (18,))

```

这里我们创建了一个游标对象`c`,然后使用`execute`方法执行了一个查询所有年龄大于18岁的用户的SQL语句。注意,这里的`?`是一个占位符,用于防止SQL注入攻击,并且它将被传递的元组`(18,)`中的值所替换。

## 1.3 处理查询结果

查询执行完毕后,可以通过遍历游标对象来获取结果集。例如:

```python

for row in c.fetchall():

print(row)

```

`fetchall`方法返回所有匹配查询的结果集,其中`row`变量包含了每一行的数据。

通过以上基础操作的介绍,我们可以看到Python DB库是如何简化数据库操作的。接下来,我们将深入探讨Python DB库中的批量操作机制,以进一步优化性能。

# 2. 深入理解Python DB库的批量操作机制

## 2.1 批量操作的理论基础

### 2.1.1 批量操作与单条记录操作的对比

在数据库操作中,批量操作通常指一次性对多条记录进行插入、更新或删除,而单条记录操作则是对一条记录进行的操作。与单条记录操作相比,批量操作在多个方面具有明显优势。

1. **减少网络往返次数**:批量操作通过减少与数据库的交互次数,从而显著降低网络延迟的影响。

2. **减少数据库负载**:单条记录操作可能会导致数据库频繁加锁和解锁,而批量操作通过减少操作次数,可降低数据库的负载压力。

3. **提高效率和吞吐量**:在处理大量数据时,批量操作能够显著提高数据处理的效率和系统的吞吐量。

### 2.1.2 优化数据库操作的必要性

随着业务量的增长,数据库操作的效率成为了影响系统性能的关键因素之一。为了优化数据库操作,开发者需要关注以下几个方面:

1. **减少I/O操作**:尽量减少不必要的磁盘读写操作,可以显著提高性能。

2. **内存使用效率**:合理利用内存缓存数据,减少物理内存与磁盘之间的数据交换。

3. **并发处理**:合理安排并发处理策略,平衡系统资源,提高数据库处理能力。

4. **事务管理**:适当管理事务的大小和范围,既保证了数据一致性,又减少锁竞争。

## 2.2 Python DB库批量操作的技术细节

### 2.2.1 预编译语句与批量执行

预编译语句是一种优化数据库操作的方法。它允许数据库编译SQL语句一次,并多次执行相同的语句,这样可以避免在每次执行时重新解析SQL语句,从而提高效率。

在Python DB库中,使用预编译语句进行批量操作通常涉及以下步骤:

```python

import sqlite3

# 创建数据库连接

conn = sqlite3.connect('example.db')

cursor = conn.cursor()

# 预编译SQL语句

cursor.execute("CREATE TABLE IF NOT EXISTS items (id INTEGER PRIMARY KEY, name TEXT)")

# 准备批量插入的数据

data = [(1, 'Item1'), (2, 'Item2'), (3, 'Item3')]

# 执行批量插入

cursor.executemany("INSERT INTO items VALUES (?, ?)", data)

# 提交事务

***mit()

# 关闭数据库连接

conn.close()

```

在上述代码中,`executemany`方法用于执行批量插入操作。它不仅提高了代码的执行效率,还降低了SQL注入的风险。

### 2.2.2 利用事务控制提升操作效率

事务控制是数据库管理系统(DBMS)提供的一种确保数据一致性的机制。在Python DB库中,可以通过显式地控制事务来提升批量操作的效率。

例如,当执行一系列插入、更新或删除操作时,可以将这些操作放在一个事务中,只在操作完成后进行提交,这样可以减少数据库的I/O操作和日志记录,提高效率。

```python

import psycopg2

# 连接到PostgreSQL数据库

conn = psycopg2.connect(

dbname="testdb",

user="testuser",

password="testpass",

host="***.*.*.*",

port="5432",

)

# 创建一个游标对象

cur = conn.cursor()

# 开始一个事务

conn.autocommit = False

try:

# 执行多个SQL语句

cur.execute("INSERT INTO mytable VALUES (1, 'test')")

cur.execute("UPDATE mytable SET column = 'newvalue' WHERE id = 1")

cur.execute("DELETE FROM mytable WHERE id = 2")

# 提交事务

***mit()

except Exception as e:

# 发生错误时回滚事务

conn.rollback()

print(f"Error: {e}")

# 关闭游标和连接

cur.close()

conn.close()

```

在该示例中,我们通过将`autocommit`设置为`False`来手动管理事务,所有操作都在一个事务中进行,这样可以确保数据的一致性,并提高操作效率。

### 2.2.3 批量操作中的内存管理

在进行大规模的批量操作时,内存管理是一个重要的考虑因素。如果操作不当,可能会导致内存溢出或者程序崩溃。Python DB库提供了一些机制来帮助开发者更好地管理内存。

一些最佳实践包括:

- **分批处理数据**:当处理的数据量非常大时,应将数据分批次进行处理,避免一次性加载过多数据到内存中。

- **使用生成器**:使用生成器可以创建惰性迭代器,逐个处理数据,减少内存消耗。

- **及时释放资源**:操作完成后,应及时关闭游标和连接,释放数据库资源。

```python

import psycopg2

# 创建数据库连接

conn = psycopg2.connect(

dbname="testdb",

user="testuser",

password="testpass",

host="***.*.*.*",

port="5432",

)

# 创建一个游标对象,使用服务器端游标减少内存消耗

cur = conn.cursor('server_cursor')

# 执行SQL查询

cur.execute("SELECT * FROM mytable")

# 使用生成器逐行获取数据

for row in cur:

print(row)

# 关闭游标和连接

cur.close()

conn.close()

```

在上述代码中,使用了名为`server_cursor`的服务器端游标,它可以减少客户端内存的使用。此外,通过生成器逐行获取数据,可以有效控制内存使用,即使面对大型数据集也能保持良好的性能。

通过本章节的介绍,我们可以看到Python DB库在批量操作方面的强大功能。这些技术细节不仅有助于提高数据库操作的效率,还能在处理大量数据时,保持系统的稳定性和响应速度。接下来的章节,我们将深入实践,探索批量操作的具体技巧和方法。

# 3. 批量操作实践技巧

在前一章节中,我们深入探讨了批量操作的基础知识和理论细节。现在,我们将把目光投向实际应用,探索批量操作的实践技巧。这一章节将重点关注在Python DB库中实现批量操作的有效方法,并提供针对不同操作(如插入、更新和删除)的具体技巧。我们将讨论如何优化性能,处理异常,并管理批量操作中的事务。

## 3.1 批量插入的技巧与方法

在数据密集型应用中,有效地将大量数据插入数据库是经常遇到的需求。这一子章节将提供批量插入的实用技巧,帮助开发者提高数据插入效率。

### 3.1.1 使用executemany进行批量插入

Python DB库提供了一个`executemany`方法,允许一次执行一条SQL语句多次,适用于批量插入数据。与逐条插入数据相比,这种

0

0