模糊C均值聚类算法的变体与改进:探索算法的无限可能

发布时间: 2024-08-22 00:04:47 阅读量: 22 订阅数: 28

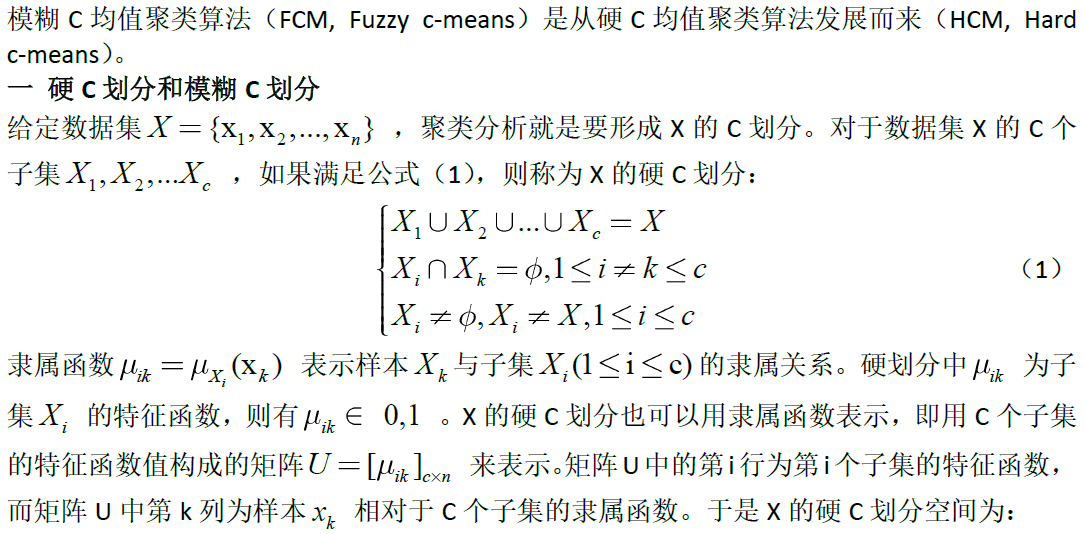

# 1. 模糊C均值聚类算法简介

模糊C均值聚类算法(FCM)是一种基于模糊集合理论的聚类算法,它允许数据点属于多个簇,并通过一个隶属度值来表示其对每个簇的归属程度。FCM算法的目标是找到一组簇中心,使得数据点到其最近簇中心的距离加权和最小。

FCM算法的优点包括:

- 能够处理数据点之间的模糊关系

- 可以自动确定簇的数量

- 对噪声和异常值具有鲁棒性

# 2. 模糊C均值聚类算法的变体

### 2.1 加权模糊C均值聚类算法

加权模糊C均值聚类算法(WFCM)在FCM算法的基础上引入了权重因子,使得不同的数据点对聚类结果的影响程度不同。权重因子可以根据数据点的密度、重要性或其他特定标准来确定。

#### 2.1.1 权重的确定方法

权重的确定方法有多种,常见的方法包括:

* **基于密度:**根据数据点的密度分配权重,密度较高的数据点权重较大。

* **基于重要性:**根据数据点的属性或标签分配权重,重要性较高的数据点权重较大。

* **基于距离:**根据数据点到聚类中心的距离分配权重,距离较近的数据点权重较大。

#### 2.1.2 算法的优缺点

WFCM算法具有以下优点:

* 能够处理具有不同重要性或密度的复杂数据集。

* 提高了聚类结果的准确性和鲁棒性。

* 允许用户根据特定需求定制聚类过程。

然而,WFCM算法也存在一些缺点:

* 权重的确定可能比较主观,需要根据具体问题进行调整。

* 算法的计算复杂度比FCM算法更高。

**代码块:**

```python

import numpy as np

def wfcm(data, c, m, weights):

"""

加权模糊C均值聚类算法

参数:

data: 数据集

c: 聚类数

m: 模糊指数

weights: 数据点权重

返回:

聚类中心、隶属度矩阵

"""

# 初始化聚类中心

centers = np.random.rand(c, data.shape[1])

# 迭代更新聚类中心和隶属度矩阵

for i in range(100):

# 计算隶属度矩阵

u = np.zeros((data.shape[0], c))

for j in range(c):

for k in range(data.shape[0]):

u[k, j] = 1 / np.sum((np.linalg.norm(data[k] - centers[j]) / np.linalg.norm(data[k] - centers))**(2/(m-1)))

# 计算聚类中心

for j in range(c):

centers[j] = np.sum(weights * u[:, j].reshape(-1, 1) * data, axis=0) / np.sum(weights * u[:, j])

return centers, u

```

**逻辑分析:**

该代码块实现了WFCM算法。首先,它初始化聚类中心。然后,它迭代更新聚类中心和隶属度矩阵,直到达到收敛条件。在每个迭代中,它计算隶属度矩阵,然后使用加权平均值更新聚类中心。

### 2.2 核模糊C均值聚类算法

核模糊C均值聚类算法(KFCM)在FCM算法的基础上引入了核函数,使得数据点的相似度不仅取决于欧氏距离,还取决于核函数的相似度。核函数可以是高斯核、多项式核或其他相似性度量。

#### 2.2.1 核函数的选择

核函数的选择对KFCM算法的性能有很大影响。常见的选择包括:

* **高斯核:**高斯核是一种常用的核函数,它可以有效地捕捉数据点之间的局部相似性。

* **多项式核:**多项式核是一种非线性核函数,它可以捕捉数据点之间的非线性关系。

* **径向基核:**径向基核是一种局部核函数,它可以有效地捕捉数据点之间的局部相似性。

#### 2.2.2 算法的适用范围

KFCM算法特别适用于处理高维、非线性或具有复杂结构的数据集。它可以有效地发现数据点之间的非线性关系,并产生更准确的聚类结果。

**代码块:**

```python

import numpy as np

def kfcm(data, c, m, kernel):

"""

核模糊C均值聚类算法

参数:

data: 数据集

c: 聚类数

m: 模糊指数

kernel: 核函数

返回:

聚类中心、隶属度矩阵

"""

# 初始化聚类中心

centers = np.random.rand(c, data.shape[1])

# 迭代更新聚类中心和隶属度矩阵

for i in range(100):

# 计算隶属度矩阵

u = np.zeros((data.shape[0], c))

for j in range(c):

for k in range(data.shape[0]):

u[k, j] = 1 / np.sum((np.linalg.norm(data[k] - centers[j]) / np.linalg.norm(data[k] - centers))**(2/(m-1))) * kernel(data[k], centers[j]))

# 计算聚类中心

for j in range(c):

centers[j] = np.sum(u[:, j].reshape(-1, 1) * data, axis=0) / np.sum(u[:, j])

return centers, u

```

**逻辑分析:*

0

0