Python库文件调试:解决调试中的内存管理问题

发布时间: 2024-10-13 05:32:56 阅读量: 21 订阅数: 20

# 1. Python库文件调试概述

## 1.1 Python调试的重要性

在Python开发过程中,库文件的调试是一个不可或缺的环节。它不仅能够帮助开发者理解库文件的工作机制,还能在遇到问题时迅速定位和解决问题。调试过程中的内存管理尤为重要,因为它直接影响到程序的性能和稳定性。

## 1.2 调试与内存管理的关系

调试库文件时,内存管理的优化往往能够提升程序的运行效率。通过合理的内存分配和回收,可以减少内存泄漏的发生,避免程序运行过程中出现的性能下降和崩溃问题。

## 1.3 调试工具的选择

选择合适的调试工具对于提高调试效率至关重要。在Python中,pdb模块是最常用的内置调试工具之一。此外,还有一些第三方工具,如memory_profiler和objgraph,它们可以帮助开发者更深入地分析内存使用情况,并进行优化。

# 2. 内存管理基础

内存管理是每个编程语言都需要面对的一个核心问题,尤其是在Python这样的高级语言中,合理的内存管理对于程序的性能和稳定性至关重要。本章将深入探讨Python的内存分配与回收机制,阐述内存泄漏的概念及其影响,并介绍内存调试的工具和方法。

## 2.1 内存分配与回收机制

在了解Python的内存管理之前,我们需要先了解其内存分配方式以及垃圾回收机制的工作原理。

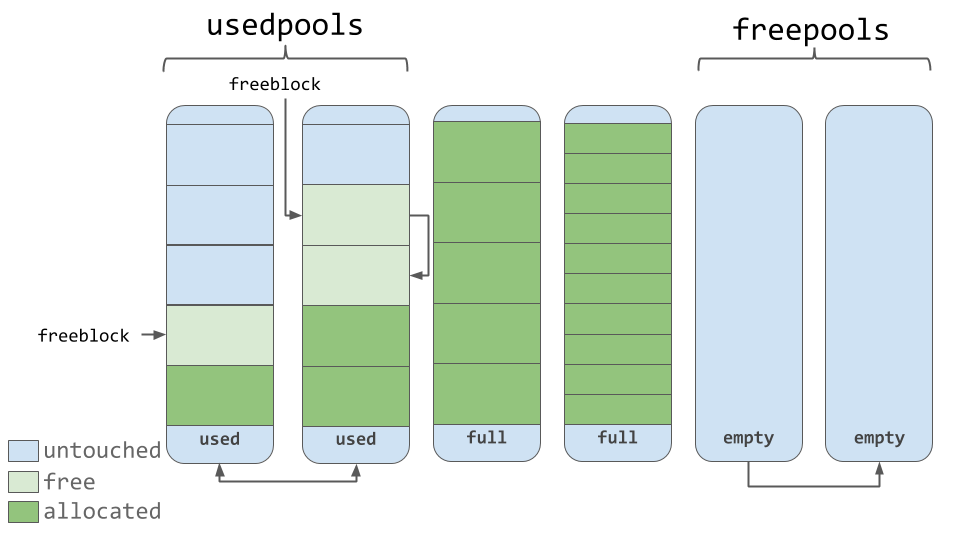

### 2.1.1 Python中的内存分配方式

Python作为一个高级语言,为开发者提供了便捷的内存管理机制。在Python中,内存分配主要分为以下几个步骤:

1. **对象创建**:当Python代码执行到对象创建语句时,例如`x = 10`,Python会首先在堆上为对象分配内存。

2. **引用计数**:每个Python对象都有一个引用计数属性,用于记录有多少引用指向该对象。当对象被创建时,它的引用计数初始化为1。

3. **内存释放**:当一个对象的引用计数降到0时,意味着没有任何变量或数据结构指向该对象,Python的垃圾回收器会回收其占用的内存。

### 2.1.2 垃圾回收机制的工作原理

Python的垃圾回收机制主要依赖于引用计数来管理内存。当一个对象的引用计数变为0时,Python会自动释放该对象所占用的内存。然而,引用计数机制并不能解决循环引用的问题,因此Python还引入了分代垃圾回收机制来处理循环引用。

**分代垃圾回收机制**:

- **代**:在Python中,新创建的对象被视为第0代对象。如果一个对象在一次垃圾回收中存活下来,它会被移动到下一代中,目前Python只有三代。

- **阈值**:每一代都有自己的阈值,当一代中对象的数量超过这个阈值时,就会触发该代的垃圾回收。

- **垃圾回收**:垃圾回收器会遍历对象图,查找并回收无法访问的对象。

```python

import gc

# 创建对象

x = [1, 2, 3]

y = [x, x]

# 设置x的引用计数为0

x = None

# 强制进行垃圾回收

gc.collect()

# 输出当前垃圾回收的状态

print(gc.garbage)

```

在上述代码中,我们创建了一个列表`x`并将其引用赋值给另一个变量`y`。之后我们将`x`的引用设置为`None`,此时`x`的引用计数变为1。当调用`gc.collect()`执行垃圾回收时,如果`x`没有其他引用,它将被回收。

## 2.2 内存泄漏的概念及其影响

内存泄漏是指程序在申请到内存后,未能及时释放不再使用的内存,导致内存资源的浪费。

### 2.2.1 内存泄漏的定义

内存泄漏通常发生在以下几种情况:

- **循环引用**:两个或多个对象相互引用,形成闭环,导致引用计数无法降至0,无法回收。

- **未关闭的资源**:如文件、数据库连接、网络套接字等未正确关闭,导致内存资源无法释放。

- **第三方库**:某些第三方库可能在使用过程中产生内存泄漏。

### 2.2.2 内存泄漏对程序性能的影响

内存泄漏对程序的影响主要体现在以下几个方面:

- **性能下降**:随着时间的推移,内存泄漏会逐渐消耗更多的内存资源,可能导致程序响应变慢。

- **系统崩溃**:当可用内存被耗尽时,操作系统可能会被迫终止进程,导致程序崩溃。

- **资源竞争**:内存泄漏可能导致其他应用程序可用内存减少,引发资源竞争问题。

## 2.3 内存调试的工具和方法

为了避免内存泄漏,我们需要使用各种工具和方法来检测和调试内存问题。

### 2.3.1 使用内置调试工具检测内存问题

Python提供了一些内置工具来帮助我们检测内存问题,例如`gc`模块:

```python

import gc

# 设置追踪垃圾回收的回调函数

def trace_func(type, value, traceback):

if type == 'collect':

print("正在回收内存")

gc.set_debug(gc.DEBUG_SAVEALL)

```

在这个例子中,我们设置了`gc`模块的调试标志,这样当垃圾回收发生时,我们可以看到相关的调试信息。

### 2.3.2 第三方工具在内存调试中的应用

除了内置工具外,还有一些第三方库可以用来调试内存问题,例如`objgraph`:

```python

import objgraph

# 创建一些对象

x = [1, 2, 3]

y = [x, x]

# 绘制对象引用图

objgraph.show_backrefs([x], filename='backrefs.png', refcounts=True)

```

上述代码使用`objgraph`库生成了一个对象引用图,该图显示了对象之间的引用关系,有助于我们发现循环引用等问题。

以上就是本章节的内容,通过本章节的介绍,我们了解了Python的内存分配和回收机制,包括引用计数和分代垃圾回收的工作原理。同时,我们也探讨了内存泄漏的概念、影响以及如何使用内置和第三方工具来检测和调试内存问题。在下一章节中,我们将进一步探讨内存调试实践,包括使用pdb模块进行调试,以及分析内存泄漏案例。

# 3. Python调试实践

## 3.1 使用pdb模块进行调试

Python Debugger(pdb)是Python自带的一个包,它为Python脚本提供了交互式的源代码调试功能。pdb允许开发者在代码中的指定点设置断点,然后逐行执行代码,观察变量的变化,以此来调试程序。

### 3.1.1 pdb的基本使用方法

pdb的基本使用方法包括启动调试模式、设置断点、单步执行、继续执行、查看变量值以及打印调用栈等。

- 启动调试模式:在命令行中,可以使用`python -m pdb script.py`命令启动pdb调试模式。

- 设置断点:使用`b(reak)`命令,例如`b 20`在第20行设置断点。

- 单步执行:使用`n(ext)`命令,执行当前行代码,并停在下一行。

- 继续执行:使用`c(ontinue)`命令,直到遇到下一个断点。

- 查看变量值:使用`p(print)`命令,例如`p variable_name`打印变量的值。

- 打印调用栈:使用`w(here)`命令查看当前调用栈。

### 3.1.2 调试过程中的内存检查技巧

在pdb调试过程中,可以利用`memory_profiler`这个第三方库来检查内存使用情况。首先需要安装`memory_profiler`,然后在代码中使用`@profile`装饰器标记需要检查内存使用情况的函数。

以下是一个简单的内存检查示例:

```python

from memory_profiler import profile

@profile

def test():

a = [1] * (10**6)

b = [2] * (2*10**6)

c = [3] * (3*10**6)

test()

```

然后在命令行中运行以下命令:

```bash

python -m memory_profiler script.py

```

运行后,`memory_profiler`将输出每行代码的内存使用情况,帮助开发者定位内存使用高峰。

### 3.1.3 代码逻辑解读

```python

from memory_profiler import profile

@profile

def test():

a = [1] * (10**6) # 创建一个包含100万个元素的列表,消耗内存

b = [2] * (2*10**6) # 创建一个包含200万个元素的列表,消耗更多内存

c = [3] * (3*10**6) # 创建一个包含300万个元素的列表,消耗最多内存

```

这段代码中,我们定义了一个名为`test`的函数,该函数创建了三个不同大小的列表,分别消耗不同的内存。使用`@profile`装饰器后,运行`memory_profiler`将能够展示这个函数每一行代码的内存使用情况。

## 3.2 内存泄漏案例分析

内存泄漏是指程序在申请内存后,无法在适当的时候释放,导致内存使用量不断增加,最终可能耗尽系统内存。以下是一个典型的内存泄漏案例及其调试过程。

### 3.2.1 典型内存泄漏案例的调试过程

假设我们有一个简单的缓存类,使用字典存储对象,但由于设计不当导致了内存泄漏。

```python

class Cache:

def __init__(self):

self.cache = {}

def set(self, key, value):

self.cache[key] = value

def get(self, key):

return self.cache.get(key)

```

这个`Cache`类中,`set`方法用于添加缓存项,`get`方法用于获取缓存项。问题在于,如果`set`方法不断被调用,而没有适当的方法清除旧的缓存项,那么内存使用量将不断增加。

### 3.2.2 内存泄漏问题的解决方案和预防措施

为了解决这个问题,我们可以实现一个清除旧缓存项的方法,并设置一个最大缓存项数量。

```python

class Cache:

def __init__(self, max_items=1000):

self.cache = {}

self.max_items = max_items

def set(self, key, value):

i

```

0

0