隐私保护学习揭秘:联邦学习原理与实践指南

发布时间: 2024-08-20 01:26:25 阅读量: 21 订阅数: 48

基于联邦学习和区块链技术的智能驾驶隐私保护训练系统设计源码

# 1. 联邦学习概述**

联邦学习是一种分布式机器学习技术,它允许多个参与者在不共享原始数据的情况下协作训练模型。它通过保护数据隐私,同时利用来自不同来源的大量数据来提高模型性能。

联邦学习的主要优势在于它消除了数据共享的需要,这对于保护敏感信息至关重要。它还允许参与者在保持数据本地化的同时进行协作,从而降低了数据泄露的风险。

联邦学习在医疗保健、金融和制造业等各个行业都有广泛的应用。它使组织能够利用分散的数据集来训练更准确和可靠的模型,从而改善决策制定和服务交付。

# 2. 联邦学习原理

联邦学习是一种分布式机器学习技术,它允许参与者在不共享原始数据的情况下协作训练模型。这种方法对于保护数据隐私和敏感信息至关重要。

### 2.1 数据隐私保护技术

为了确保联邦学习中的数据隐私,采用了以下几种技术:

#### 2.1.1 差分隐私

差分隐私是一种数学技术,它通过添加随机噪声来保护数据隐私。它确保即使攻击者可以访问部分数据,也无法从模型中推断出任何特定个体的敏感信息。

#### 2.1.2 同态加密

同态加密是一种加密技术,它允许在加密数据上执行计算。这意味着参与者可以在不解密数据的情况下协作训练模型,从而保护数据隐私。

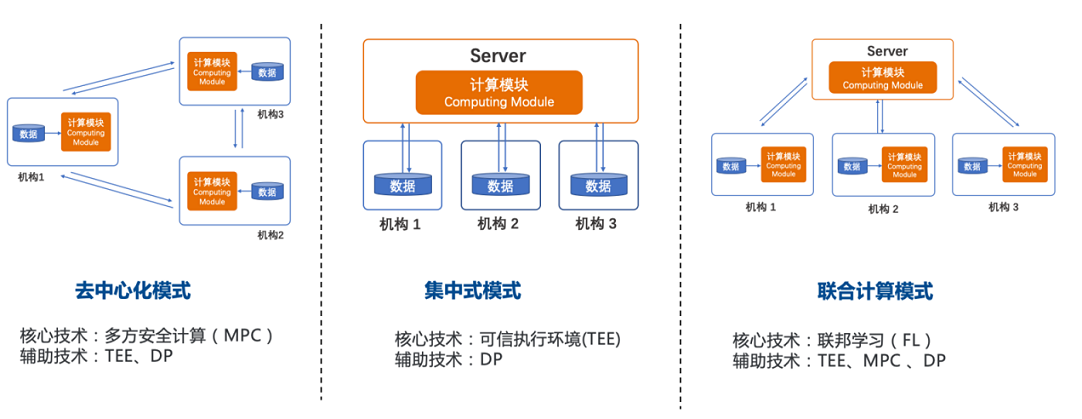

#### 2.1.3 安全多方计算

安全多方计算是一种协议,它允许参与者在不共享原始数据的情况下共同计算一个函数。这使得参与者能够协作训练模型,而无需向其他参与者透露其原始数据。

### 2.2 联邦学习算法

联邦学习算法是专门设计用于在分布式数据上训练模型的算法。这些算法使用迭代过程,其中参与者在本地训练模型,然后将更新的模型参数聚合到中央服务器。

#### 2.2.1 梯度下降法

梯度下降法是一种优化算法,它通过迭代更新模型参数来最小化损失函数。在联邦学习中,梯度下降法用于训练本地模型,然后将梯度聚合到中央服务器。

#### 2.2.2 随机梯度下降法

随机梯度下降法是梯度下降法的变体,它使用随机抽样的数据子集来更新模型参数。这使得联邦学习算法能够在数据量较大时高效地训练模型。

#### 2.2.3 联邦平均算法

联邦平均算法是一种联邦学习算法,它通过对参与者本地模型的更新参数进行加权平均来聚合模型。这种算法简单高效,适用于各种联邦学习场景。

# 3.1 联邦学习平台

#### 3.1.1 TensorFlow Federated

TensorFlow Federated (TFF) 是 Google 开发的一个开源联邦学习框架。它提供了一组用于构建和部署联邦学习模型的工具和 API。TFF 的主要优点包括:

- **易用性:**TFF 提供了一个直观的 API,使开发人员可以轻松地构建和部署联邦学习模型。

- **可扩展性:**TFF 可用于训练大规模联邦学习模型,即使这些模型涉及多个参与者。

- **安全性:**TFF 实现了各种安全措施,以保护参与者的数据隐私。

#### 代码块:

```python

import tensorflow as tf

import tensorflow_federated as tff

# 定义联邦数据集

federated_train_data = [

tf.data.Dataset.from_tensor_slices(x_train[i]).batch(32),

tf.data.Dataset.from_tensor_slices(x_train[i]).batch(32),

]

# 定义联邦模型

federated_model = tff.learning.build_federated_averaging_model(

input_spec=x_train[0].element_spec,

hidden_units=[128, 64],

num_classes=10,

)

# 训练联邦模型

federated_train_state = tff.learning.framework.create_federated_av

```

0

0