联邦学习中的数据安全与隐私保护:权威指南

发布时间: 2024-08-20 01:36:19 阅读量: 73 订阅数: 38

# 1. 联邦学习简介

联邦学习是一种分布式机器学习范式,允许在不共享原始数据的情况下,在多个参与方之间协作训练机器学习模型。它通过将模型参数在参与方之间共享和聚合,实现跨多个数据集的协作学习。联邦学习在保护数据隐私和安全方面具有显著优势,使其在医疗保健、金融和制造等领域具有广泛的应用。

# 2. 联邦学习中的数据安全与隐私挑战

### 2.1 数据泄露风险

联邦学习涉及多个参与方在不共享原始数据的情况下协作训练模型。然而,这种分布式架构也带来了数据泄露的风险。

**攻击方式:**

* **外部攻击:**恶意攻击者可能通过网络攻击或社会工程手段,窃取参与方存储的中间结果或模型参数。

* **内部攻击:**参与方内部人员可能有意或无意地泄露敏感数据,例如通过未经授权的访问或数据备份。

**影响:**

数据泄露可能导致:

* 敏感信息的暴露,如个人身份信息、医疗记录或商业机密。

* 模型性能下降,因为攻击者可以利用泄露的数据来操纵模型训练。

* 监管处罚和声誉损害。

### 2.2 模型窃取威胁

模型窃取是指攻击者在未经授权的情况下获取联邦学习模型的知识。这可能通过以下方式实现:

**攻击方式:**

* **模型反向工程:**攻击者可以分析中间结果或模型参数,以推断出原始模型。

* **数据提取:**攻击者可以利用模型对输入数据的预测,来推断出原始数据中包含的信息。

**影响:**

模型窃取可能导致:

* 知识产权盗窃,因为攻击者可以窃取有价值的模型。

* 模型滥用,因为攻击者可以利用窃取的模型进行恶意活动,如欺诈或网络攻击。

* 竞争优势丧失,因为攻击者可以利用窃取的模型来获得市场优势。

### 2.3 隐私泄露问题

联邦学习旨在保护参与方数据的隐私,但仍存在隐私泄露的风险。

**攻击方式:**

* **关联攻击:**攻击者可以将联邦学习模型的输出与其他来源的数据关联起来,以识别参与方或推断出敏感信息。

* **推理攻击:**攻击者可以利用模型的预测,来推断出参与方数据中的敏感属性,如健康状况或政治观点。

**影响:**

隐私泄露可能导致:

* 个人隐私侵犯,因为攻击者可以获取有关参与方的敏感信息。

* 歧视和偏见,因为攻击者可以利用泄露的信息来针对特定群体。

* 法律责任,因为隐私泄露可能违反数据保护法规。

# 3.1 数据加密技术

数据加密技术是联邦学习中保护数据安全与隐私的重要手段,其主要思想是将原始数据转换为密文,使得未经授权的用户无法访问或理解数据内容。常用的数据加密技术包括同态加密和秘密共享。

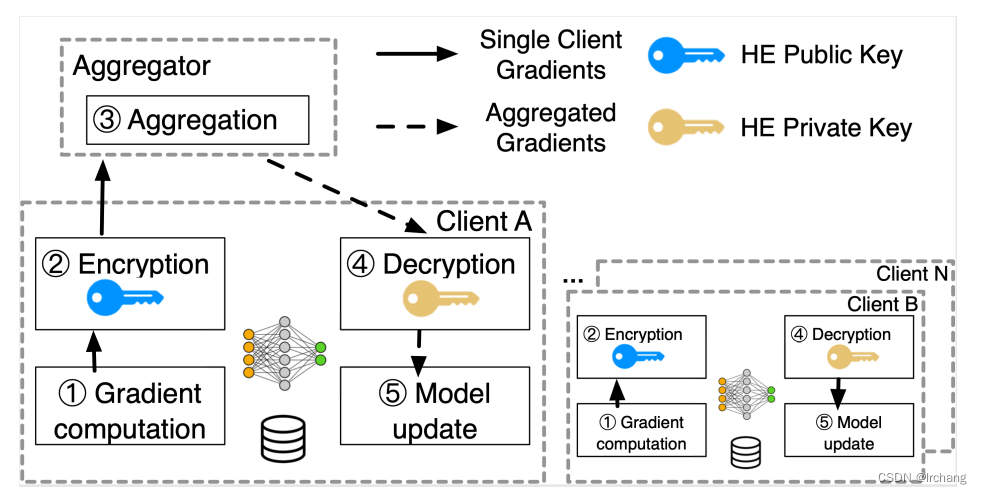

#### 3.1.1 同态加密

同态加密是一种特殊的加密技术,它允许对密文进行计算,而无需先解密。这意味着,参与联邦学习的各方可以在不泄露原始数据的情况下,对密文数据进行联合计算。同态加密的优势在于:

- **数据保密性:**即使攻击者获得了密文,也无法推断出原始数据。

- **可计算性:**可以在密文上进行加法、乘法等操作,支持复杂的联合计算。

- **效率性:**同态加密算法的计算效率不断提高,满足联邦学习的性能要求。

**代码示例:**

```python

import homomorphic_encryption as he

# 生成公钥和私钥

public_key, private_key = he.generate_key_pair()

# 加密数据

encrypted_data = he.encrypt(public_key, "Hello, world!")

# 在密文上进行加法操作

encry

```

0

0