MapReduce高效排序实践:案例研究与性能提升策略

发布时间: 2024-10-31 18:59:55 阅读量: 56 订阅数: 36

MapReduce高阶实现

# 1. MapReduce框架概述

MapReduce是一个为了处理大规模数据集的编程模型和相关的实现,最早由Google提出,并在Hadoop项目中得到广泛应用。它允许开发者通过编写Map(映射)函数和Reduce(归约)函数来处理大量数据。Map函数处理输入数据,生成一系列中间键值对;Reduce函数则对这些中间数据进行合并处理。

本章将简要介绍MapReduce框架的基本概念和工作原理,为后续章节关于排序机制、实践案例、性能优化以及大数据应用的深入讨论打下基础。我们将从MapReduce框架的主要组成部分、核心流程以及在大数据处理中的优势和局限性等方面展开。通过本章内容,读者可以对MapReduce有一个全面的初步认识,并理解为何其排序机制在处理大数据时至关重要。

# 2. MapReduce排序机制的理论基础

在第二章中,我们将深入了解MapReduce排序机制的理论基础。排序在分布式计算中扮演着至关重要的角色,特别是在数据处理和分析中,能够决定数据处理的效率和最终结果的质量。我们将从排序的基本原理和流程入手,进而探讨MapReduce中的排序算法应用。

## 2.1 MapReduce排序原理解析

MapReduce排序机制是大数据处理中不可或缺的一部分,它涉及数据的整合与整理,为后续的数据分析和处理提供准备。

### 2.1.1 MapReduce排序的流程

排序流程主要发生在Map阶段和Reduce阶段之间,具体步骤如下:

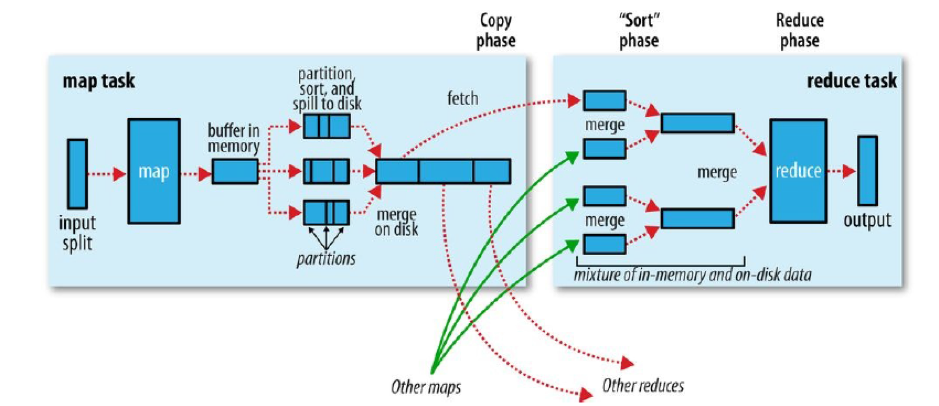

1. **Shuffle阶段**:Map任务完成后,系统会自动对Map的输出进行排序,按照key值进行分组,为之后的Reduce任务做好准备。

2. **Sort阶段**:Shuffle之后,数据会被送往Reduce阶段,此时数据已经是局部有序的。Reduce任务开始后,它会对接收到的数据进行合并排序,最终得到全局有序的输出。

### 2.1.2 MapReduce排序的内部机制

MapReduce内部排序机制的核心在于它如何处理key的比较和排序,这个过程涉及到了一系列比较操作:

- **分区**:在Map阶段结束时,系统会根据key值对数据进行分区,确保相同key的数据被发送到同一个Reducer。

- **排序**:每个Reducer接收到数据后,会按照key进行排序,通常使用快速排序或归并排序等高效算法。

## 2.2 排序算法在MapReduce中的应用

在MapReduce框架中,排序算法是构建整个数据处理流程的基础。基本排序算法和高级排序算法在MapReduce中的实现各有特点。

### 2.2.1 基本排序算法的MapReduce实现

基本排序算法,如冒泡排序、选择排序和插入排序等,虽然在处理大量数据时效率不高,但在理解排序过程和MapReduce机制上具有教育意义。

- **冒泡排序**:通过相邻元素的比较和交换,逐步将最大的元素“冒泡”到列表的末尾。在MapReduce中实现冒泡排序需要特别设计Reducer来处理这种逐个元素比较的逻辑。

- **选择排序**:通过选择剩余部分最小(或最大)的元素,并与未排序部分的第一个元素交换。MapReduce实现中,Map阶段负责输出所有元素,而Reduce阶段则负责逐个选择并输出排序后的结果。

### 2.2.2 高级排序算法的MapReduce实现

高级排序算法如快速排序、归并排序、堆排序等,在MapReduce中的应用更为广泛,因为它们在处理大量数据时具有更好的性能。

- **快速排序**:快速排序是一种分而治之的排序算法,它通过选取一个基准元素将数据分为两部分,一边都是小于基准的元素,另一边都是大于基准的元素,然后递归地对这两部分继续进行排序。在MapReduce中,Map阶段负责将数据按照某种规则分成不同的部分,并将这些部分发送到不同的Reducer,然后每个Reducer应用快速排序算法,最后汇总排序结果。

- **归并排序**:归并排序是将两个(或多个)有序表合并成一个新的有序表。在MapReduce框架中,Map阶段可以将数据分片,每片内部进行局部排序,然后Reducer负责合并这些有序片段,形成最终的全局有序结果。

为了更直观地理解MapReduce排序的机制和应用,我们可以参考以下的流程图展示:

```mermaid

graph LR

A[开始] --> B[Map阶段]

B --> C{Shuffle阶段}

C --> D[Reduce阶段]

D --> E[结束]

```

## 代码块实例及说明

下面是一个简单的MapReduce排序过程的伪代码示例:

```java

// Map函数

map(String key, String value):

for each word w in value:

emitIntermediate(w, 1)

// Shuffle和Sort过程由框架自动完成

// Reduce函数

reduce(String key, Iterator partialValues):

result = 0

for each value v in partialValues:

result += v

emit(key, result)

```

**代码逻辑解读:**

- **Map阶段**:每个Map任务读取输入数据,对每行文本进行分词,并为每个单词输出一个键值对,键是单词本身,值是计数1。

- **Shuffle和Sort过程**:框架自动将Map输出的键值对按照键(即单词)进行排序,并且将相同键的所有值传递给同一个Reduce任务。

- **Reduce阶段**:每个Reduce任务接收到一系列具有相同键的值,然后对它们进行累加,最后输出该键和对应的总和。

通过上述的代码段和逻辑分析,我们可以看到MapReduce排序机制是如何在键值对的处理中实现的。在实际开发中,开发者需要根据具体需求编写Map和Reduce函数,而排序过程则可以依赖框架的默认实现。

在本章节中,我们详细探讨了MapReduce排序的理论基础,并通过实际的代码示例和逻辑分析,揭示了MapReduce排序流程和内部机制的工作原理。下一章节,我们将进入MapReduce排序实践案例的探讨,通过具体案例来进一步理解和掌握排序机制的应用。

# 3. MapReduce排序实践案例

#### 3.1 环境搭建与测试数据准备

##### 3.1.1 Hadoop集群的配置和部署

在开始我们的MapReduce排序实践案例之前,首先需要确保有一个可以运行的Hadoop集群环境。对于初学者来说,可以从单机伪分布式模式开始,逐步过渡到多节点集群。本案例假定已经搭建好了一个标准的Hadoop环境。

1. **安装Java环境**:因为Hadoop是用Java编写的,所以首先需要在所有节点上安装Java JDK。

2. **下载并配置Hadoop**:从Apache官网下载Hadoop包,并解压到所有节点的同一目录下。配置`hadoop-env.sh`文件,设置JAVA_HOME为安装的JDK路径。

3. **配置Hadoop环境变量**:在每个节点的`.bashrc`或`.bash_profile`文件中添加Hadoop的环境变量设置。

4. **格式化Hadoop文件系统**:运行`hdfs namenode -format`来格式化文件系统。

5. **启动Hadoop集群**:使用`start-dfs.sh`和`start-yarn.sh`脚本来启动集群的各个服务。

6. **验证集群状态**:通过`jps`命令验证所有守护进程是否正常运行,通过访问`***`来查看Hadoop NameNode的Web界面,确认集群健康状态。

##### 3.1.2 测试数据集的创建和分布

创建和分布测试数据是进行MapReduce排序实践的第二步。我们将创建一个简单的文本文件,然后使用Hadoop的分布式文件系统(HDFS)将数据分布到集群中。

```bash

# 创建本地文件作为测试数据

echo -e "appl

```

0

0