MapReduce排序机制详解:map端与reduce端协同工作的秘籍

发布时间: 2024-10-31 19:34:31 阅读量: 32 订阅数: 20

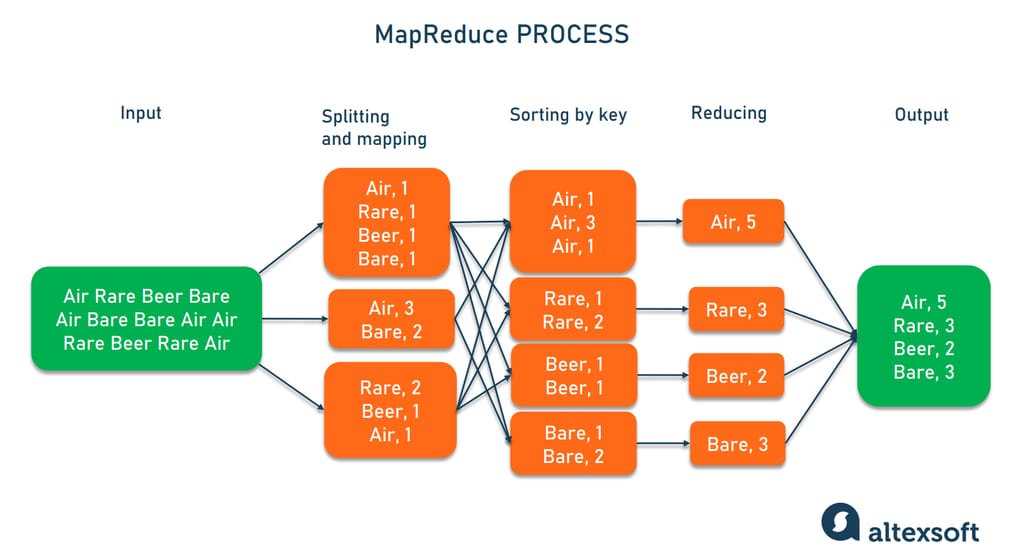

# 1. MapReduce排序机制概述

在大数据处理领域,MapReduce作为一项成熟的并行处理技术,其核心优势之一在于强大的排序能力。本章将为读者提供对MapReduce排序机制的概括性介绍,为深入理解后续章节内容打下基础。

MapReduce排序机制不仅包括Map端和Reduce端的排序处理,还涵盖了两者之间的协同工作。理解其排序机制对于优化大数据处理流程、提升整体执行效率至关重要。读者将了解到排序在MapReduce中的作用、排序的关键步骤,以及这些步骤如何影响最终数据处理的性能。

通过本章的阅读,您将:

- 掌握MapReduce排序机制的基本概念和流程。

- 明确排序在数据处理过程中的重要性。

- 为深入学习Map端和Reduce端的排序处理奠定坚实的基础。

让我们从第一章开始,逐步揭开MapReduce排序机制的神秘面纱。

# 2. Map端的排序处理

### 2.1 Map端排序的理论基础

MapReduce模型中,Map端排序是整个排序机制的重要组成部分,它为后续的Reduce端排序奠定了基础。Map端排序主要包括两个阶段:Map任务的输入数据划分和Map任务的输出数据排序。

#### 2.1.1 Map任务的输入数据划分

在Map端的排序处理开始之前,需要对输入数据进行划分。Hadoop框架下,Map任务的输入数据通常是从HDFS上读取的,这些数据被切分成固定大小的“块”,每个块作为Map任务的一个输入分片。输入数据分片的目的是为了提高数据处理的并行度,加快整个MapReduce作业的处理速度。

数据分片的大小是通过HDFS的块大小来设置的,默认为128MB。用户可以根据自己的需求调整块大小,但是要注意,块大小越大,单个Map任务处理的数据量就越大,相应地,Map任务的内存要求也越高。块大小太小会增加NameNode的负担,因为NameNode需要维护更多的文件块信息。

```mermaid

flowchart LR

A[HDFS] -->|读取| B[数据块1]

A -->|读取| C[数据块2]

A -->|读取| D[数据块3]

B --> E[Map任务1]

C --> F[Map任务2]

D --> G[Map任务3]

```

#### 2.1.2 Map任务的输出数据排序

每个Map任务会对其处理的输入数据进行排序,该过程在Map任务的输出之前完成。Map端的排序通常是使用快速排序或者归并排序算法完成的。这一阶段的排序是为了确保输出的键值对(key-value pairs)是有序的,便于后续的Shuffle过程。Map端排序完成之后,每个Map任务会输出一系列有序的键值对,这些键值对会根据键的字典顺序排列。

### 2.2 Map端的排序实践

Map端排序实践涉及了Map输出的键值对管理、内存管理与溢写以及性能优化等关键步骤。

#### 2.2.1 Map输出的键值对管理

Map输出的键值对管理是Map端排序实践中的一个核心环节。首先,Map函数的输出需要临时存储在一个内存缓冲区中。Hadoop使用一个环形缓冲区来存储这些键值对,当缓冲区达到一定的阈值(默认为0.8)时,开始溢写到磁盘。溢写过程中,会进行二次排序,并且使用二进制格式来存储数据,以减少I/O开销和提高存储效率。

#### 2.2.2 Map端的内存管理与溢写

Map端的内存管理与溢写是保证Map端排序高效进行的关键步骤。Hadoop允许用户配置Map任务使用的内存大小,这个配置项通常在配置文件`mapred-site.xml`中进行设置。合理配置这个参数,可以有效避免内存溢出问题,同时提高排序效率。

内存管理策略包括对缓冲区大小的动态调整和缓存数据的溢写机制。在内存使用即将达到最大限制时,系统会启动溢写操作,将内存中的数据写入磁盘。溢写操作会先对数据进行分区,每个分区内的数据通过比较器进行排序,最后以二进制格式顺序写入磁盘文件。

```java

// 示例代码块:Map端溢写操作

public void spill() {

// 首先,按照分区规则对数据进行分区

List<KVPair> partitionedData = partition(bufferedData);

// 排序

sort(partitionedData);

// 写入磁盘

write(partitionedData, disk);

// 清空内存缓冲区

clearBuffer();

}

```

上述代码段展示了溢写操作的主要步骤:分区、排序、写入磁盘和清空内存。每个步骤都有相应的逻辑来保证操作的顺利进行,比如分区操作会根据输出键的哈希值将数据分配到不同的分区中。

#### 2.2.3 Map端排序的性能优化

Map端排序的性能优化主要涉及几个关键参数,包括Map任务内存大小、数据溢写阈值和内存中缓冲区的大小。通过适当调整这些参数,可以优化Map端的排序性能,减少不必要的磁盘I/O操作,提高Map任务处理速度。

除了参数调优,还可以通过算法优化来提升性能。例如,选择更加高效的排序算法或者优化比较器的实现,以减少每次比较的时间开销。此外,Map任务的输出数据量过大时,可以通过压缩技术来减少磁盘I/O的压力,提高排序效率。

以上章节的内容从Map端排序处理的理论基础到具体的实践应用,详细介绍了Map端排序机制中的关键步骤,如Map任务的输入数据划分、Map任务输出数据排序以及内存管理与溢写等。通过理论和实践的结合,本章节向读者展示了如何通过细致的配置和优化来提升Map端排序的性能。

# 3. ```

# 第三章:Reduce端的排序处理

在MapReduce的排序机制中,Reduce端的排序处理是核心环节之一。一旦Map阶段的数据处理完毕,接下来就是将有序的数据进行分组并汇总在Reduce端。本章节将深入探讨Reduce端排序处理的理论基础和实践应用,阐明数据从Map端到Reduce端的传输过程,以及Reduce端是如何进行有效的数据排序的。

## 3.1 Reduce端排序的理论基础

### 3.1.1 Shuffle过程的数据传输

Shuffle过程负责在Map端和Reduce端之间传输数据,这是大数据处理的一个关键步骤。对于排序而言,Shuffle的作用在于将相同键值的数据归拢到一起,发送到同一个Reduce任务中去。为了实现这一点,系统需要进行如下操作:

1. **数据分区(Partitioning)**:确保具有相同键(Key)的数据落在同一个分区(Partition)中,这通常通过哈希函数来完成。

2. **排序(Sorting)**:在Map端输出的数据必须按键排序,以便于Shuffle过程能够将这些数据发送到正确的Reduce任务。

3. **数据传输(Transfer)**:数据通过网络传输到Reduce任务,过程中可能需要对数据进行压缩以优化网络带宽的使用。

### 3.1.2 Reduce任务的输入数据排序

Reduce任务接收到的数据已经根据键进行了初步的排序,这是由Shuffle过程中的排序操作保证的。在Reduce任务开始处理数据之前,需要进一步对这些数据进行排序,以保证键值相同的记录可以被连续处理。这一过程通常分为以下几个步骤:

1. **合并(Merging)**:将来自不同Map任务的数据流

```

0

0