Flume数据过滤与路由:高级技巧与应用实例解析

发布时间: 2024-10-25 23:31:25 阅读量: 38 订阅数: 48

flume-pg-sink:水槽-ng postgresql 数据库接收器

# 1. Flume基础与数据流架构

## Flume简介

Apache Flume是一个分布式、可靠且可用的系统,用于有效地收集、聚合和移动大量日志数据。它的设计哲学以简单性为核心,通过一个简单的、定义良好的模型来传输数据,从而简化了分布式系统中数据流的管理。

## 数据流架构

Flume采用代理(Agent)的概念来处理数据流。每个代理是一个JVM进程,它包括三个主要组件:源(Source)、通道(Channel)和接收器(Sink)。数据通过源进入代理,存储在通道中,然后由接收器转发到目的地。

## 基本工作流程

在Flume的工作流程中,一个事件(Event)是数据流的基本单位。事件包含字节负载和可选的头部信息,从源传输到接收器,并且必须通过通道。通道作为事件的暂存地,既可以是内存,也可以是持久化存储,以确保数据传输的可靠性。

```mermaid

graph LR

Source1[Source] -->|Event| Channel[Channel]

Source2[Source] -->|Event| Channel

Channel -->|Event| Sink[Sink]

```

### 示例代码块

下面是一个简单的Flume配置文件示例,用于设置一个代理,该代理拥有一个接收网络数据的源,一个内存通道,以及一个输出到控制台的接收器:

```properties

# 定义代理名称

agent1.name = Agent1

# 配置源

agent1.sources = Source1

agent1.sources.Source1.type = netcat

agent1.sources.Source1.bind = localhost

agent1.sources.Source1.port = 44444

# 配置通道

agent1.channels = Channel1

agent1.channels.Channel1.type = memory

agent1.channels.Channel1.capacity = 1000

agent1.channels.Channel1.transactionCapacity = 100

# 配置接收器

agent1.sinks = Sink1

agent1.sinks.Sink1.type = logger

# 绑定源、通道和接收器

agent1.sources.Source1.channels = Channel1

agent1.sinks.Sink1.channel = Channel1

```

以上内容为第一章的基础部分,接下来将深入探讨Flume数据过滤技术,为理解和应用Flume提供更加扎实的理论基础。

# 2. Flume数据过滤技术

在流数据处理中,数据过滤是确保数据质量的关键环节。Flume作为一个广泛应用于日志数据采集、聚合和传输的平台,提供了一套完善的数据过滤机制,允许用户根据实际业务需求精确控制数据流。在本章节中,我们将深入了解Flume的数据过滤技术,包括过滤器的类型与选择、高级应用,以及数据清洗实践。

## 2.1 过滤器的类型与选择

### 2.1.1 内置过滤器介绍

Flume提供了多种内置过滤器来简化过滤逻辑的实现,常见的内置过滤器包括:

- `TimestampFilter`:根据事件的时间戳进行过滤。

- `HostFilter`:根据事件来源主机名进行过滤。

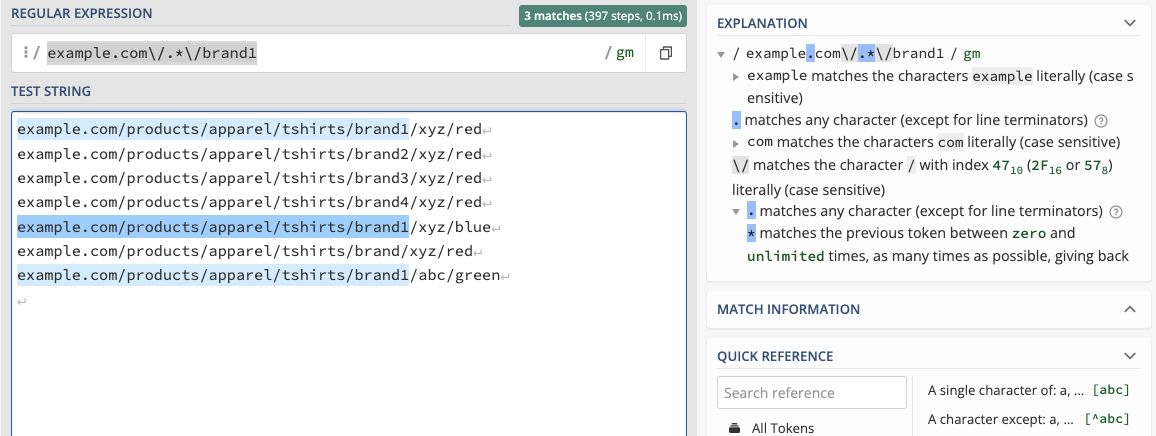

- `RegexFilter`:使用正则表达式对事件内容进行匹配和过滤。

- `MetricFilter`:根据统计指标来决定事件是否被过滤。

这些过滤器通过预设的规则对数据流中的事件进行筛选,使得数据流在传输前能够符合特定的业务逻辑。

### 2.1.2 自定义过滤器实现

对于内置过滤器无法覆盖的特定业务场景,Flume 允许用户通过实现自定义过滤器来扩展其过滤功能。自定义过滤器需要实现 `EventFilter` 接口并重写 `matches` 方法。以下是一个简单的自定义过滤器实现示例:

```java

public class CustomFilter implements EventFilter {

private String pattern;

public CustomFilter(String pattern) {

this.pattern = pattern;

}

@Override

public boolean matches(Event event) {

String body = new String(event.getBody());

return body.matches(pattern);

}

}

```

在上述代码中,我们创建了一个新的过滤器类 `CustomFilter`,它根据传入的正则表达式模式来过滤事件。只有当事件体匹配该模式时,`matches` 方法才会返回 `true`,否则返回 `false`。

## 2.2 过滤器的高级应用

### 2.2.1 复合过滤器链的配置

在复杂的业务场景下,往往需要根据多个条件同时对事件进行过滤。这时可以使用复合过滤器来组合多个过滤器。例如,我们想要同时根据时间戳和事件内容来过滤数据流:

```xml

agent.sources.source1.filter_chain =

a1_regex_filter a1_timestamp_filter a1_custom_filter

```

在这个配置中,`filter_chain` 通过空格分隔了多个过滤器名称,创建了一个过滤器链。事件会依次通过每个过滤器,只有所有过滤器均匹配时,事件才会被允许通过。

### 2.2.2 动态过滤器应用

为了使数据过滤更加灵活,Flume 支持动态过滤器。动态过滤器允许在运行时动态地添加、移除或修改过滤规则,而无需重启 Flume 服务。这为基于外部事件或条件改变的数据过滤策略提供了便利。

### 2.2.3 过滤器性能考量

在使用过滤器时,过滤规则的复杂度会对性能产生影响。特别是在高流量的场景下,复杂或数量众多的过滤器可能会成为性能瓶颈。因此,进行性能考量和优化是过滤器使用中的一个重要方面。

## 2.3 数据清洗实践

### 2.3.1 数据清洗的场景与策略

数据清洗是保证数据质量的重要环节,尤其是在日志数据或数据流中,错误或无关数据可能会影响后续的数据分析和决策。典型的清洗策略包括:

- 去除重复数据

- 修正格式错误

- 删除无用字段

- 识别并处理异常值

合理应用这些策略,能够显著提高数据流的准确性和可用性。

### 2.3.2 实践案例分析

假设我们正在处理一个电子商务平台的日志数据,我们可能对数据流中的以下情况感兴趣:

- 去除重复的用户访问日志

- 移除格式不正确的支付记录

- 筛选特定时间范围内的用户点击事件

通过实际案例分析,我们可以深入理解如何通过Flume的过滤技术应用这些数据清洗策略,从而在数据流中实现高度定制化的数据质量控制。

# 3. Flume数据路由机制

## 3.1 路由器的原理与功能

### 3.1.1 路由器组件概述

Flume的路由器组件负责将事件从源传输到目的地。它的主要作用是在数据流入Flume之后,根据预定义的规则决定事件应该被发送到哪个通道。这种机制允许系统设计者根据事件的内容、属性或者发生时间等信息来制定复杂的路由逻辑。

路由器是高度可定制的,因为开发者可以编写自定义路由器来满足特定的路由需求。Flume提供了一系列内置路由器,例如复制路由器(Replicating Router)和故障转移路由器(Failover Router)。

### 3.1.2 内置路由器使用方法

在Flume配置文件中,定义路由器是很直观的。复制路由器可以将事件复制到所有的目的地通道中,这对于需要在多个存储系统中保存数据的场景非常有用。而故障转移路由器则提供了一个备选的目的地列表,如果首选目的地失败,事件会被转发到下一个可用的目的地。

下面是一个简单的配置示例,展示了如何在Flume配置文件中使用复制路由器:

```properties

# 定义复制路由器

a1.sources.r1.channels = c1 c2

a1.sources.r1.selector.type = replicating

a1.sources.r1.selector.maxpenalty = 1000

```

在这个例子中,`maxpenalty`是一个可选参数,它定义了对于上一个目的地的惩罚时间,以毫秒为单位。如果一个目的地被发现是不可用的,那么它的惩罚时间会增加,这样可以减少失败目的地的轮询频率。

## 3.2 路由器的高级配置

### 3.2.1 复合路由器配置策略

复合路由器是通过将多个路由器按特定顺序组合来实现更复杂的路由逻辑。配置复合路由器时,可以将多个路由器的类

0

0